风格迁移综述

风格迁移综述

1.传统非参数的图像风格迁移方法主要基于物理模型的绘制和纹理的合成。非参数的图像风格迁移方法只能提取图像的底层特征,而非高层抽象特征,在处理颜色和纹理较复杂的图像时,最终的图像合成效果较为粗糙,难以符合实际需求。

2.深度学习的图像风格迁移方法主要包括(1)基于图像迭代和(2)基于模型迭代两种。

(1)基于图像迭代:合成图像的质量高、可控性好,易于调参,无需训练数据。//计算时间较长,对预训练模型的依赖性大。

1基于最大均值差异:

*Gatys L A, Ecker A S, Bethge M. A neural algorithm of artistic style [J].arXiv preprint arXiv: 1508. 06576, 2015(第一篇)

*Gatys L A, Bethge M, Hertzmann A, et al. Preserving color in neuralartistic style transfer [J]. arXiv preprint arXiv: 1606. 05897, 2016.

*Novak R, Nikulin Y. Improving the neural algorithm of artistic style [J].arXiv preprint arXiv: 1605. 04603, 2016 (提出了一些改进途径)

*Risser E, Wilmot P, Barnes C. Stable and controllable neural texturesynthesis and style transfer using histogram losses (引入直方图loss稳定纹理生成)

*Yin Rujie. Content aware neural style transfer [J]. arXiv preprint arXiv:1601. 04568, 2016(基于内容感知)

2基于马尔科夫随机场:非参数图像合成的经典框架

*Li Chuan, Wand M. Combining Markov random fields and convolutional neural networks for image synthesis [C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition, Piscataway, NJ: IEEE Press,2016: 2479-2486(提出了Markov+CNN,Markov描述了具有同类特征信息的集合,因此将CNN图像特征映射分割成许多区域块并进行匹配,以提高合成图像在视觉上的合理性)

*Champandard A J. Semantic style transfer and turning two-bit doodles into fine artworks [J]. arXiv preprint arXiv: 1603. 01768, 2016.(手工添加图像语义映射,增强了对合成结果的控制)

3基于深度图像类比:

*Liao Jing, Yao Yuan, Yuan Lu, et al. Visual attribute transfer through deep image analogy [J]. arXiv preprint arXiv: 1705. 01088, 2017(主要是颜色迁移)

(2)基于模型迭代:计算速度快,可用于视频快速风格化,目前工业应用软件的主流技术。图像生成质量有待进一步提高,需要大量的训练数据。

1基于生成模型:

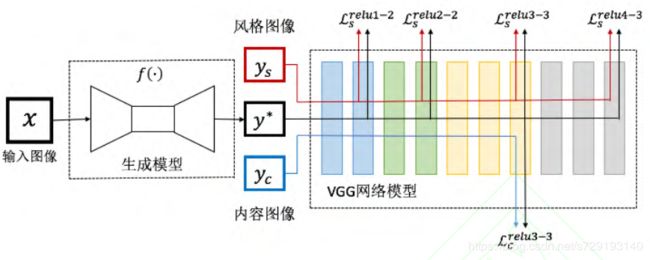

*Johnson J, Alahi A, Li Feifei. Perceptual losses for real-time style transfer and super-resolution [C]// Proc of European Conference on Computer Vision. [S. I. ] : Springer Press, 2016: 694-711(为某种特定风格生成模型-基于Gatys 的文章-感知损失=内容+风格+平滑)

*Huang Haozhi, Wang Hao, Luo Wenhan, et al. Real-time neural style transfer for videos [C]// Proc of IEEE Conference on Computer Vision and Pattern Recognition. Piscataway, NJ: IEEE Press, 2017: 7044-7052.(自适应实例归一化)

*Wang Xin, Oxholm G, Zhang Da, et al. Multimodal transfer: a hierarchical deep convolutional neural network for fast artistic style transfer [J]. arXiv preprint arXiv: 1612. 01895, 2016(多尺度风格迁移颜色亮度生成高清图片)

*Ulyanov D, Lebedev V, Vedaldi A, et al. Texture networks: feed-forward synthesis of textures and stylized images [J]. arXiv preprint arXiv: 1603.03417, 2016.

*Ulyanov D, Vedaldi A, Lempitsky V. Instance normalization: the missing ingredient for fast stylization [J]. arXiv preprint arXiv: 1607. 08022, 2016(使用实例归一化代替批量归一化)

*Zhang Hang, Dana K. Multi-style generative network for real-time transfer[J]. arXiv preprint arXiv: 1703. 06953, 2017(多风格模型)

GAN:CycleGAN 基于循环一致性,DiscoGAN 和 DualGAN 基于机器翻译的对偶学习思想.这些优秀的对抗训练模型突破了训练数据需要成对的限制,成功实现了无监督的迁移学习.

目前的生成对抗网络在模型训练方面相当不稳定,而判别模型的设定使得指向明确的图像风格迁移方法实现起来变得困难。此外,生成对抗网络是根据图像散度分布的迭代优化来进行对抗训练,而不是根据图像的内容、纹理和颜色,因此,使用生成对抗网络进行图像风格迁移的过程显得难以控制。

*Zhang Lvmin, Ji Yi, Lin Xin. Style transfer for anime sketches with enhanced residual u-net and auxiliary classifier GAN [J]. arXiv preprintarXiv: 1706. 03319, 2017(漫画草图着色)

*Castillo C, De S, Han X, et al. Son of Zorn's Lemma: targeted style transfer using instance-aware semantic segmentation [J]. arXiv preprint arXiv: 1701. 02357, 2017(使用语义分割对特定对象风格迁移)

2基于图像重构解码器:有效地避免参数调整

*Li Yijun, Fang Chen, Yang Jimei, et al. Universal style transfer via feature transforms [J]. arXiv preprint arXiv: 1705. 08086, 2017

*Li Yijun, Liu Mingyu, Li Xueting, et al. A closed-form solution to photorealistic image stylization [J]. arXiv preprint arXiv: 1802. 06474,2018.