http://mp.ofweek.com/vr/a745673021206

周四晚上11点,万众瞩目的世界杯终于开踢了,虽然意大利、荷兰、智利、中国(手动滑稽)等强队没能进入本届世界杯,但C罗梅西谁主沉浮、桑巴足球可否复仇、冰岛国足能走多远依旧看点十足。比起能在家门口看球的毛子和有闲钱闲功夫飞赴球场的球迷,大多数人还是只能囿于屏幕前。再加上顾及会遇到正面刚无敌的战斗民族,英国人还是坐在家中看球比较稳妥。

可若是在家吃着烧烤,喝着啤酒,换了大屏幕甚至改用投影仪,看球还不爽怎么办?新系统来帮你忙,给予你真·上帝视角的体验。

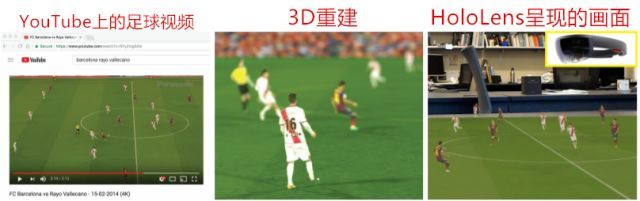

想象一下,如果可以在桌子地板上观看足球比赛的3D全息图,还能四处走动从不同视角观看球员,那该有多炫酷。想要获得此种体验的一种方法便是在球场各个方位布置多台同步摄像机,然后利用多视图几何技术重建场地和球员的3D模型。然而多摄像机的布置降低了它的适用性。今天要说的另一种方法则是利用单目视频完成对球场和球员的3D重建。在前一段时间,我们也提到过两个单目动捕方案:Vnect和MonoPertCap,就基本原理来说,三者也有着一些异曲同工之妙。

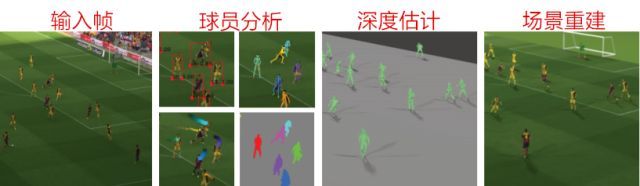

导入YouTube视频后,研究人员使用字段线来恢复相机参数,通过提取边界框、姿势和运动轨迹(跨多个帧)分割出球员轮廓。然后使用训练有素的深层网络在场中重建每个球员的深度图并在3D查看器或AR设备上渲染这些深度图。

于是识别球员的重任就落在了深度学习网络上,而它的训练方法又显得十分巧妙。有别于传统的训练方式,此系统选择了FIFA游戏作为训练素材。倘若使用普通2D足球视频,很难从干巴巴的平面中提取出训练所需的深度数据信息,而本身基于大量数据编辑而成的FIFA则可以提供更加详细的数据集。

研究人员使用RenderDoc (RenderDoc是一款功能强大的开源图形调试器,除了可以用于图形开发,还可以用来分析各游戏大作的渲染流程)来拦截游戏引擎和GPU之间的调用。与大多数游戏类似,FIFA在游戏过程中使用延迟着色,因此可以很方便地捕获每帧的深度和颜色缓冲区。一旦给定帧的深度和颜色被捕获,研究人员就将处理它以提取球员。提取的颜色缓冲区即是游戏的RGB屏幕截图。接下来用OpenGL相机矩阵来将缓冲区转化为坐标系中的三维点从而得到点云,再用DBSCAN聚类算法将球员分开,最后将每个球员的3D集群投影到图像上,并使用度量深度重新计算深度缓冲区。简单来说,利用FIFA,不光有图,还有现成的数据作参考,岂不美哉。

可是球场上的激烈角逐免不了身体碰撞,再加上摄像机机位的角度问题,很容易就造成画面内的球员相互遮挡。在有遮挡的情况下,深度学习网络的计算是混乱的。尽管有训练样本带有遮挡,但还是不足以让网络计算出一名球员的深度。出于这个原因,研究人员通过提供一个分割掩模来帮助深度网络计算,其中被追踪的球员是前景,场地、体育场和其他球员是背景。

完成了深度学习网络的计算,接下来就是对于场景的重建了。首先自然是对于摄像机参数的把握。由于需要令重建的场景为用户提供可旋转拉伸的视角,因此研究者们取球场上的边线、中线、底线等作为特征坐标以便定位。在完成了对于球员身体关键点(骨架)的捕捉后,就要生成网格了。

因为深度学习网络输出是每个像素量化的符号距离、球员的表面和虚拟平面之间的距离,所以为了获得度量深度图,要将球员的边界框提升为3D,创建一个平面(假设玩家的底部像素位于地面上)。然后,我们将网络输出的距离偏移应用到3D平面上,以获得所需的深度图。然后辅以相机参数将深度图投影到坐标中,从而以3D形式生成玩家的点云。每个像素对应一个3D点,连接像素建立面部,再对网格进行纹理贴图。根据应用的不同,还可以通过抽取部分网格来进一步简化网格结构,以节省设备中的储存空间。

当然就目前来看,该系统还有着很多不完善的地方,比如无法模拟球员跳跃、无法获得全方位令人满意的观看体验、无法实时重构、无法高效数据压缩、足球总是闪烁不定等。

总的来说,游戏的发展似乎为深度学习网络提供了丰富的素材,由此也侧面推动了AR VR技术的进步。这也为直男提供了一个新思路:等下次再有妹子问你什么是越位的时候,你就可以一帧一帧得和她讲解了。