Python爬虫进阶必备 | X薯中文网加密分析

这次来分析某个小说网站。

aHR0cHM6Ly9nLmhvbmdzaHUuY29tL2NvbnRlbnQvOTM0MTYvMTM4Nzc5MTIuaHRtbA==

分析请求

先来看看页面的请求【图1-1】

图1-1

经过查看请求,并没有请求的加密参数,但是响应的内容却不正常,许多文字在响应中都变成了 span 标签【图1-2】

图1-2

这样的反爬虫措施,如何分析?

定位加密

既然这里替换的内容都是 span 那就从它开始入手吧。

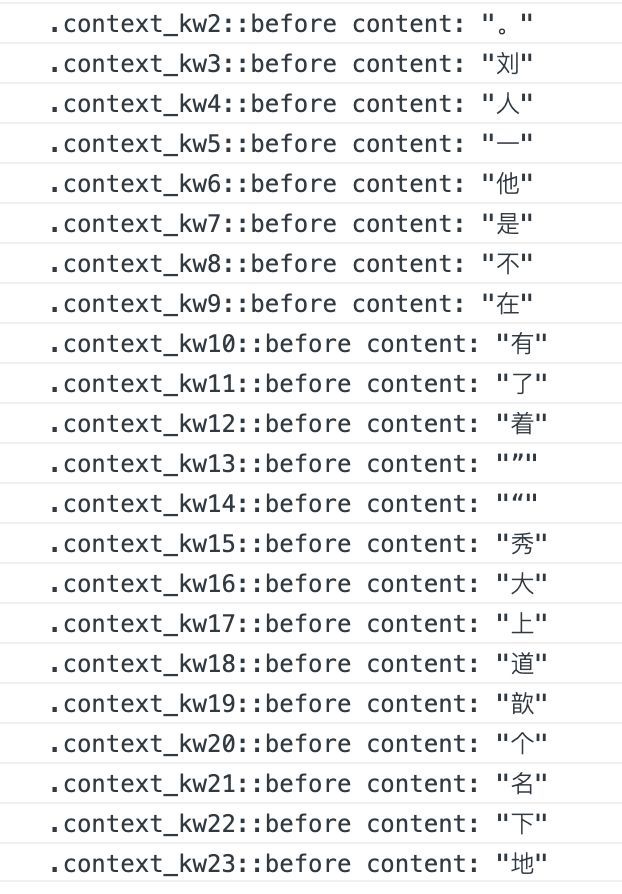

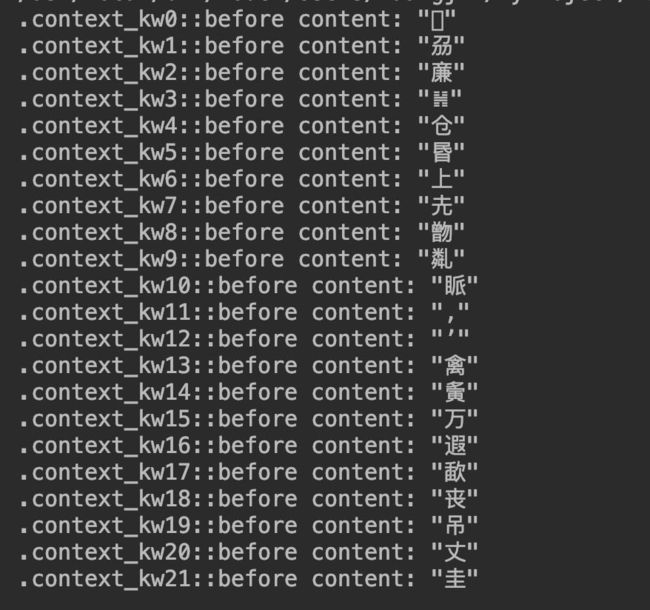

可以看到应该显示在正文的内容显示在 CSS 的 content 中【图2-1】。

图2-1

这个是什么操作?容我百度一下。

CSS中,::before 创建一个伪元素,其将成为匹配选中的元素的第一个子元素。常通过

content属性来为一个元素添加修饰性的内容。此元素默认为行内元素。

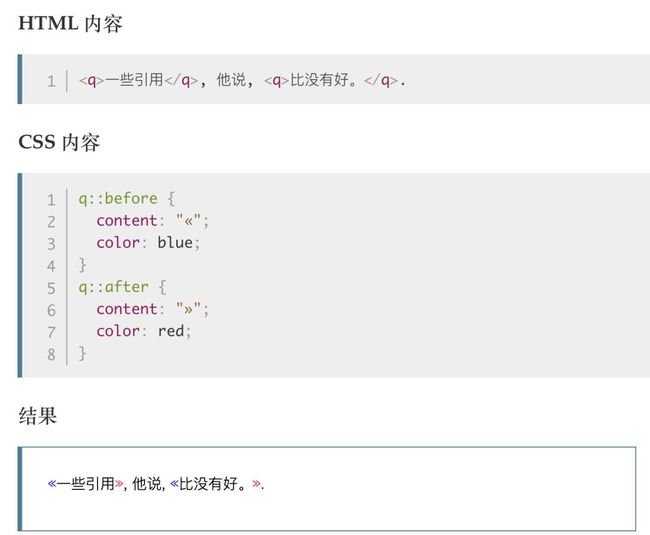

这里附带一个语法示例【图2-2】,加深理解:

图2-2

现在通过上面的实例描述,我们大致清楚原来它是一种 CSS 的隐式写法。

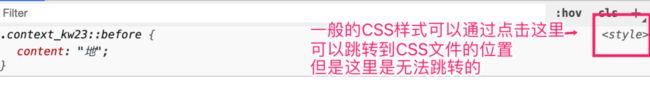

一般 CSS 样式我们可以通过点击右上角的链接跳转到相应的文件位置,但是这里是无法跳转的【图2-3】

图2-3

我们照着之前的思路,搜索一波看看能不能找到一些蛛丝马迹。

先试试搜索类名【图2-4】,找到的是请求页面的响应内容,并没有找到有用的信息。

图2-4

继续搜索::before,这次找到的同样是请求页面的响应内容但是::before在文件的位置值得我们打开看看。【图2-5】

图2-5

点开文件再次搜索,在这里就定位到了疑似加密的地方【图2-6】,对!只是疑似加密。

图2-6

你不能因为代码长得丑、难理解就怀疑它是加密。![]()

其实这里也可以全局搜索.context_kw可以找到操作 DOM 的代码,可以找到操作 DOM 的加密位置,搜索方法大同小异。

这里就不细说了,我们只要找到加密逻辑的整体位置就行,不妨碍我们分析。

ps : 怕自己找错可以多试几次,相关文件都打开看看。

分析与改写

既然找到一个疑似加密的位置,我们肯定是要分析一波看看是不是我们要找的。

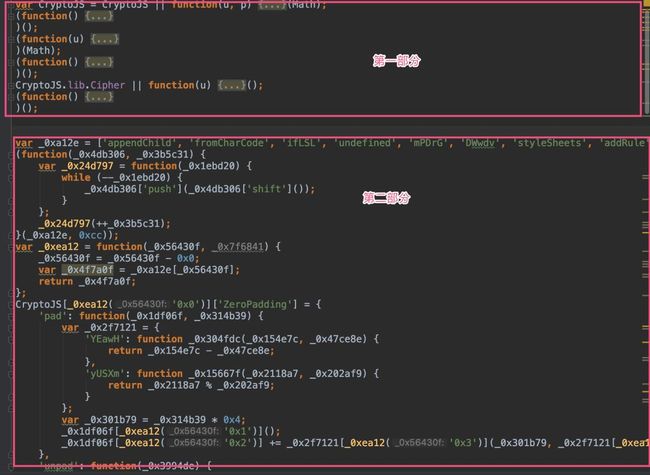

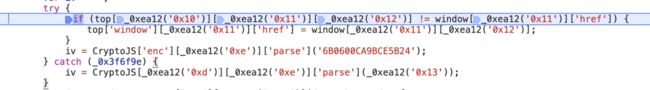

通过大概的梳理,可以看到整个 JS 分为两个部分,第一部分 JS 是CryptoJS的加解密的内容,第二部分是经过混淆的内容,根据部分 JS 可以猜测第二部分的 JS 操作了 DOM ,完成了 CSS 相关的解密。【图3-1】

关于第一部分的CryptoJS没啥好改的,照着用就好了。

第二部分值得研究一下,因为是混淆过的内容,照着还原回原来的代码意义不大且费时费力,需要做的就是不停调试你看不明白的代码,争取能明白这个代码的意思,能理解的代码越多,去改写越简单。

图3-1

简单说下代码的逻辑:

1. 先取出 _0xa12e这个数组里面一个加密过的元素,取出后用 AES解密

var _0xa12e = ['appendChild', 'fromCharCode', 'ifLSL', 'undefined', 'mPDrG', 'DWwdv', 'styleSheets', 'addRule', '::before', '.context_kw', '::before{content:\x20\x22', 'cssRules', 'pad', 'clamp', 'sigBytes', 'YEawH', 'yUSXm', 'PwMPi', 'pLCFG', 'ErKUI', 'OtZki', 'prototype', 'endWith', 'test', '8RHz0u9wbbrXYJjUcstWoRU1SmEIvQZQJtdHeU9/KpK/nBtFWIzLveG63e81APFLLiBBbevCCbRPdingQfzOAFPNPBw4UJCsqrDmVXFe6+LK2CSp26aUL4S+AgWjtrByjZqnYm9H3XEWW+gLx763OGfifuNUB8AgXB7/pnNTwoLjeKDrLKzomC+pXHMGYgQJegLVezvshTGgyVrDXfw4eGSVDa3c/FpDtban34QpS3I=', 'enc', 'Latin1', 'parse', 'window', 'location', 'href', '146385F634C9CB00', 'decrypt', 'ZeroPadding', 'toString', 'split', 'length', 'style', 'type', 'setAttribute', 'async', 'getElementsByTagName', 'NOyra', 'fgQCW', 'nCjZv', 'parentNode', 'insertBefore', 'head'];

2. 解密后的值放入到secWords中,对secWords中的值遍历并做了一堆骚操作,将处理过后的值放入到words当中,注意这里words就已经是文字了。

3. 最后在 JS 的最后操作 DOM 进行替换

部分解析

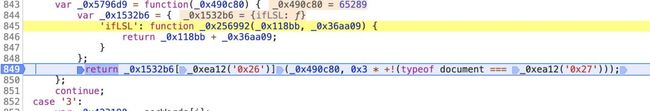

这个 JS 不是很难,从网页复制的 JS 加上两个打印直接就可以使用,但是在 node 中直接运行发现输出的字符和实际页面展现的并不相同。

正确的字符是这样的【图3-2】

图3-2

在 node 中运行输出的结果是这样的【图3-3】

图3-3

很明显 node 环境下输出的结果不是我们要的,而且字符数也少了两个,同一份代码环境不同,可以大致猜到可能是代码里做了一些对环境属性的判断。

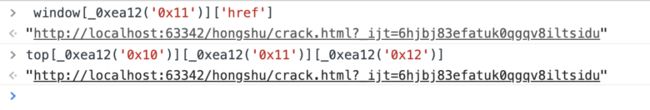

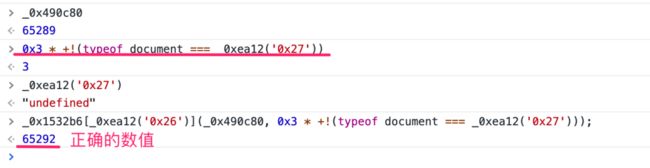

这个时候理解代码的好处就来了,可以很快定位到下面这行代码【图3-4】:

图3-4

这里检测的是当前的 URL ,在浏览器中这个判断条件是不成立的【图3-5】,所以不执行判断中代码。

图3-5

到了 node 环境下是没有浏览器的window属性的,所以执行这句会出现异常,执行的是异常处理中的代码,所以我们直接把这段if代码注释掉。

继续向下,找找还有没有相关的代码,只要是判断浏览器相关属性的都需要注意一下。

很快看到【图3-6】这一行的代码也进行了相关的判断。

图3-6

在浏览器环境下代码的结果是这样的【图3-7】

图3-7

但是在 node 环境下是这样的,计算结果也相应的出现了错误【图3-8】

图3-8

所以这里需要做相应的修改,让结果能够计算正确。

例如:

_0x1532b6[_0xea12('0x26')](_0x490c80, 0x3 * +!('object' === _0xea12('0x27')))

这样 node 环境下的计算结果就正常了。

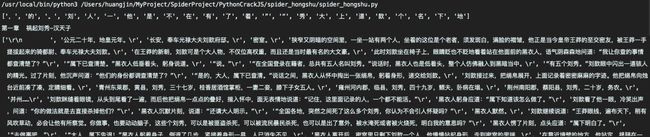

将经过处理后的 JS 运用到 Python 爬虫中,就可以看到正确的内容了【图3-9】

图3-9

总结

这个网站的加密不是很难,不过加密的方法很典型,前段时间有不少读者朋友在群里讨论研究,非常值得学习一下。

不过既然是小说网站,这里也涉及到相关的版权问题,所以希望大家不要搞事,以学习的态度和目的阅读本文。

Peace~

鱼说闲话

咸鱼从初一就开始看网络小说了,可以算是个老书虫,当时用攒了好几个月的生活费买了部 MP4 ,拜托家里有电脑的同学帮忙下载小说,就这样开始了我的追更之旅。

当我看小说的设备不断更新直到今天的智能手机,那些年躲在被窝里看小说的日子留下的只剩下那些年追更的回忆,还有残存不多的小说.txt文件。

谨以此文,纪念过去追更的日子。

EOF