Python学会这一招让你穷游全世界(驴友必备)

前言:

穷游,是一种时尚的旅游方式。在自由旅行的同时,最大限度地省钱,花最少的钱享受最大的快乐。不是为穷而穷,而是一种不同以往的行走方式。和“有钱”“没钱”无关,只是想要用最经济的方式去“穷”尽天下美景。今天小编就给大家分享一下如何利用Python网络爬虫获取属于你的穷游攻略秘籍~~~

一、项目背景

穷游网提供原创实用的出境游旅行指南、攻略,旅行社区和问答交流平台,以及智能的旅行规划解决方案,同时提供签证、保险、机票、酒店预订、租车等在线增值服务。穷游“鼓励和帮助中国旅行者以自己的视角和方式体验世界”。

今天教大家获取穷游网的城市信息,使用Python将数据写入csv文档。

二、项目目标

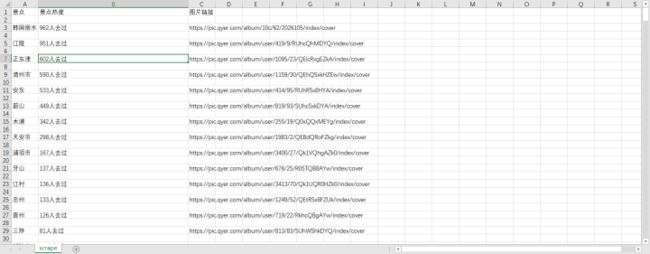

实现将获取对应的城市、图片链接、热点、批量下载 保存csv文档。

三、涉及的库和网站

1、网址如下:

https://place.qyer.com/south-korea/citylist-0-0-{}2、涉及的库:requests、lxml、fake_useragent、time、csv

四、项目分析

首先需要解决如何对下一页的网址进行请求的问题。可以点击下一页的按钮,观察到网站的变化分别如下所示:

- https://place.qyer.com/south-korea/citylist-0-0-1

- https://place.qyer.com/south-korea/citylist-0-0-2

- https://place.qyer.com/south-korea/citylist-0-0-3观察到只有citylist-0-0-{}/变化,变化的部分用{}代替,再用for循环遍历这网址,实现多个网址请求。

五、项目实施

1、我们定义一个class类继承object,然后定义init方法继承self,再定义一个主函数main继承self。准备url地址。

import requests,os

from lxml import etree

import random

import time

from fake_useragent import UserAgent

class Travel(object):

def __init__(self):

self.url = "https://place.qyer.com/south-korea/citylist-0-0-{}/"

def main(self):

pass

if __name__ == '__main__':

spider= Travel()

spider.main()2、随机产生UserAgent。

self.film_list = []

ua = UserAgent(verify_ssl=False)

for i in range(1, 50):

self.film_list.append(ua.chrome)

self.Hostreferer = {

'User-Agent': random.choice(self.film_list)

}3、多页请求。

startPage = int(input("起始页:"))

endPage = int(input("终止页:"))

for page in range(startPage, endPage + 1):

url = self.url.format(page)4、定义get_page方法,进行数据请求。

'''数据请求'''

def get_page(self, url):

html = requests.get(url=url, headers=self.Hostreferer).content.decode("utf-8")

self.page_page(html)

# print(html)//网页

# print(self.headers)//构造头5、定义page_page,xpath解析数据, for循环遍历数组。

在谷歌浏览器上,右键选择开发者工具或者按F12。右键检查,xpath找到对应信息的字段。如下图所示。

parse_html = etree.HTML(html)

image_src_list = parse_html.xpath('//ul[@class="plcCitylist"]/li')

for i in image_src_list:

b = i.xpath('.//h3//a/text()')[0].strip()

c = i.xpath('.//p[@class="beento"]//text()')[0].strip()

d = i.xpath('.//p[@class="pics"]//img//@src')[0].strip()6、定义csv文件保存数据,写入文档。

# 创建csv文件进行写入

csv_file = open('scrape.csv', 'a', encoding='gbk')

csv_writer = csv.writer(csv_file)

csv_writer.writerow([b, c, d])

csv_file.close(7、在main方法调用。

def main(self):

for i1 in range(1, 25):

url = self.url.format(i1)

# print(url)

html = self.get_page(url)

time.sleep(2)

print("第%d页" % i1)8、time模块,设置时间延迟。

time.sleep(2)六、效果展示

1、点击运行,输入起始页,终止页。

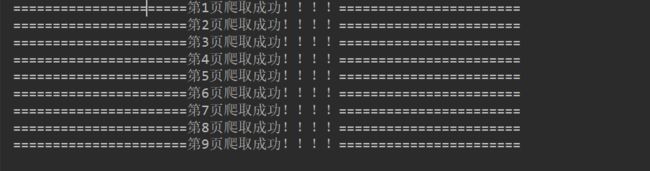

2、将下载成功信息显示在控制台。

3、保存csv文档。

最后总结:

1、不建议抓取太多数据,容易对服务器造成负载,浅尝辄止即可。

2、希望通过这个项目,能够帮助大家对csv文档处理有进一步的了解。

3、本文基于Python网络爬虫,利用爬虫库,实现穷游网的获取。实现的时候,总会有各种各样的问题,切勿眼高手低,勤动手,才可以理解的更加深刻。

4、可以根据自己的需要选择自己的喜欢的城市获取自己想要的有效信息 。

5、欢迎大家点赞,留言,转发,感谢大家的相伴与支持,需要本文源码可以关注公众号:【Python的进阶之旅】有惊喜哦!觉得不错,记得给个Star噢~

喜欢旅游的伙伴快去行动起来吧~~~