入门篇:从零到一搭建大数据开发平台(四)搭建Hadoop HDFS完全分布式集群(学生版)

环境:

宿主机:windows10

虚拟机:VMware15.5

系统:CentOS 6.9

JDK1.8

Hadoop-2.6.0-cdh5.14.0【获取编译后安装包 提取码: awh4 】

废话不多说开始安装

安装步骤:

一:上传压缩包并解压

二:上传完毕开始解压到指定目录 servers

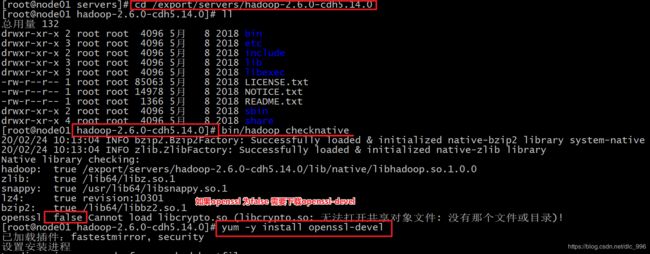

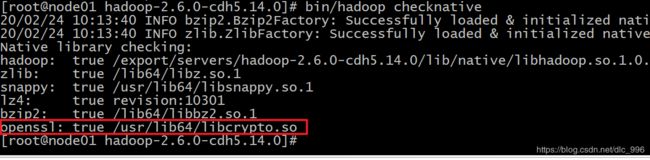

操作命令: tar -zxvf hadoop-2.6.0-cdh5.14.0-编译后的版本.tar.gz -C ../servers/三:查看Hadoop支持的压缩方式以及本地库

进入到hadoop-2.6.0-cdh5.14.0目录 输入命令: bin/hadoop checknative 下载命令:yum -y install openssl-devel

四:修改配置文件

# 修改core-site.xml

进入到配置目录:cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

编辑配置文件: vim core-site.xml

添加以下内容

fs.defaultFS

hdfs://node01:8020

hadoop.tmp.dir

/export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/tempDatas

io.file.buffer.size

4096

fs.trash.interval

10080

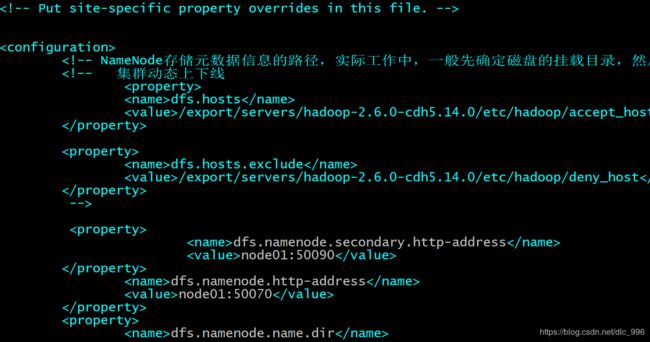

# 修改hdfs-site.xml

进入到配置目录:cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

编辑配置文件:vim hdfs-site.xml

添加以下内容

dfs.namenode.secondary.http-address

node01:50090

dfs.namenode.http-address

node01:50070

dfs.namenode.name.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/namenodeDatas

dfs.datanode.data.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/datanodeDatas

dfs.namenode.edits.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/edits

dfs.namenode.checkpoint.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/snn/name

dfs.namenode.checkpoint.edits.dir

file:///export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/snn/edits

dfs.replication

2

dfs.permissions

false

dfs.blocksize

134217728

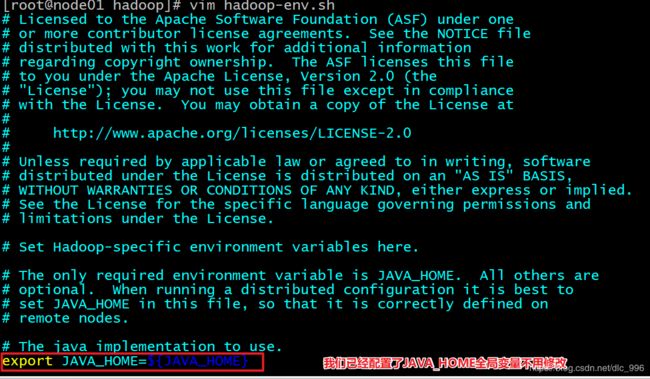

# 修改Hadoop-env.sh

进入到配置目录:cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

编辑配置文件:vim Hadoop-env.sh 不用修改直接退出即可

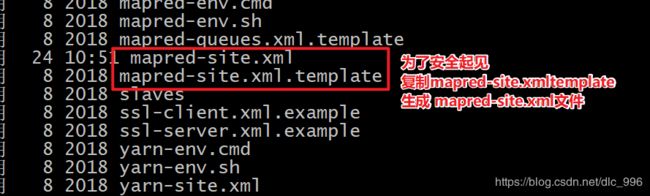

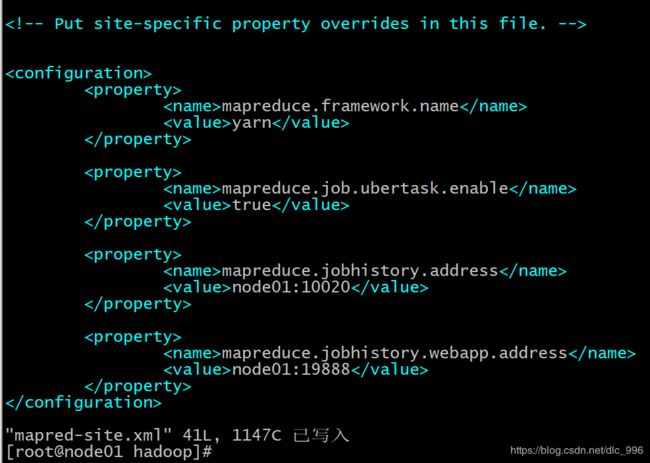

# 修改mapred-site.xml

进入到配置目录:cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

编辑配置文件:vim mapred-site.xml

cp mapred-site.xml.template mapred-site.xml

mapreduce.framework.name

yarn

mapreduce.job.ubertask.enable

true

mapreduce.jobhistory.address

node01:10020

mapreduce.jobhistory.webapp.address

node01:19888

# 修改yarn-site.xml

进入到配置目录:cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

编辑配置文件:vim yarn-site.xml

yarn.resourcemanager.hostname

node01

yarn.nodemanager.aux-services

mapreduce_shuffle

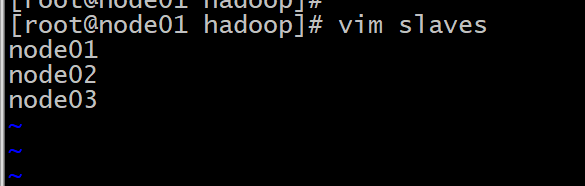

# 修改slaves文件

进入到配置目录:cd /export/servers/hadoop-2.6.0-cdh5.14.0/etc/hadoop

编辑配置文件:vim slaves文件

添加 主机名

node01

node02

node03

所有配置文件修改完毕

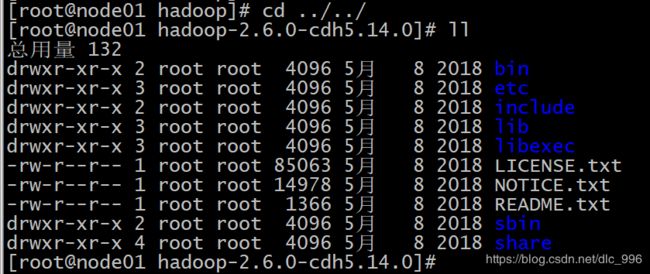

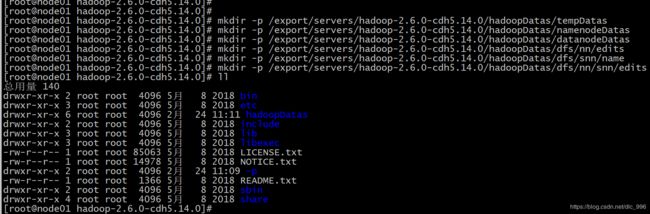

五: 创建文件存放目录

进入到hadoop安装目录

创建层级文件夹与配置文件hdfs-site.xml配置文件内的配置信息相对应(一定要看准自己的目录结构是否与配置文件一致)

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/tempDatas

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/namenodeDatas

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/datanodeDatas

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/edits

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/snn/name

mkdir -p /export/servers/hadoop-2.6.0-cdh5.14.0/hadoopDatas/dfs/nn/snn/edits

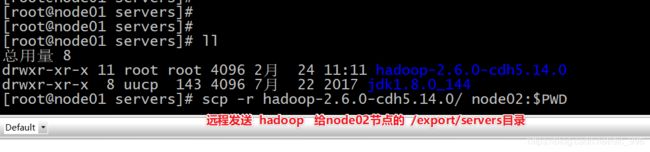

六:安装包的分发

进入到 /export/servers目录

执行命令:

scp -r hadoop-2.6.0-cdh5.14.0/ node02:$PWD

scp -r hadoop-2.6.0-cdh5.14.0/ node03:$PWD

七:配置环境变量:三台节点都需要配置环境变量

进入到配置环境变量目录: cd /etc/profile.d

编辑环境变量 vim hadoop.sh

export HADOOP_HOME=/export/servers/hadoop-2.6.0-cdh5.14.0

export PATH=$PATH:$HADOOP_HOME/bin三台节点配置完成之后 刷新生效(三台节点都需要刷新)

source /etc/profile

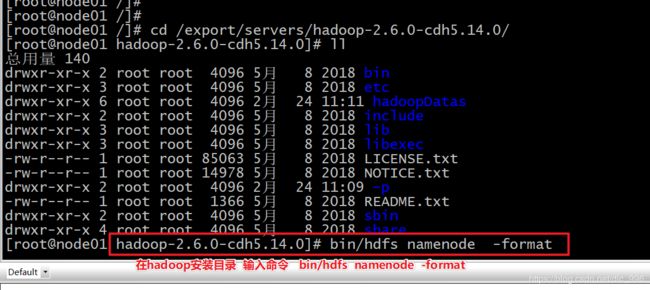

八:启动集群

要启动 Hadoop 集群,需要启动 HDFS 和 YARN 两个集群。

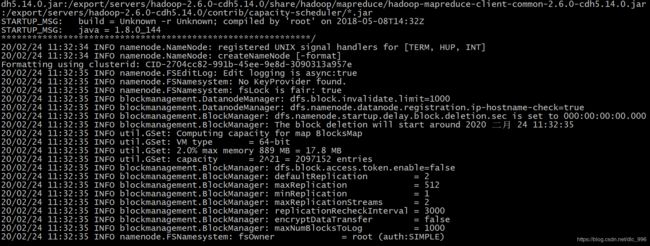

注意:首次启动HDFS时,必须对其进行格式化操作。本质上是一些清理和准备工作,因为此时的 HDFS 在物理上还是不存在的。

bin/hdfs namenode -format或者bin/Hadoop namenode –format

在主节点上使用以下命令启动 HDFS NameNode: Hadoop-daemon.sh start namenode

在每个从节点上使用以下命令启动 HDFS DataNode: Hadoop-daemon.sh start datanode

在主节点上使用以下命令启动 YARN ResourceManager: yarn-daemon.sh start resourcemanager

在每个从节点上使用以下命令启动 YARN nodemanager: yarn-daemon.sh start nodemanager

以上脚本位于$HADOOP_PREFIX/sbin/目录下。如果想要停止某个节点上某个角色,只需要把命令中的start 改为stop 即可。

# 脚本一键启动所有

sbin/start-all.sh

# 脚本一键关闭所有

sbin/stop-all.sh

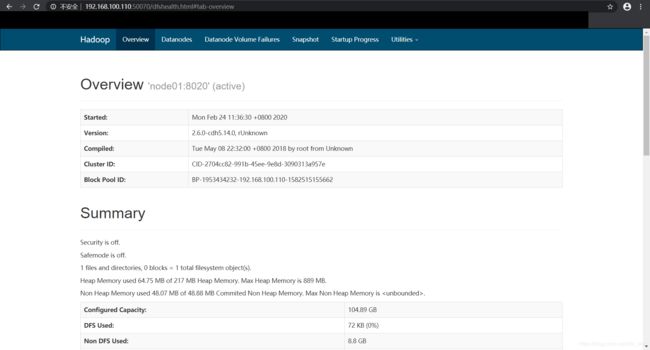

九:浏览器查看启动页面

hdfs集群访问地址: http://192.168.52.100:50070/dfshealth.html#tab-overview