Sequence Labeling Problem

目录

Hidden Markov Model (HMM)

HMM缺点

Conditional Random Field (CRF)

CRF v.s. HMM

Structured Perceptron/SVM

Towards Deep Learning

小结

链接:

http://speech.ee.ntu.edu.tw/~tlkagk/courses/MLDS_2015_2/Lecture/Sequence%20(v4).pdf

对于序列模型,我们其实使用之前学的RNN是可以解决的,但是在POS tagging问题中,RNN并不知道整个句子的信息,单靠查表是不够的。比如对于同一个单词“saw”,它在名词后是一个动词,冠词后是一个名词。所以,我们需要考虑整个句子的信息才能确定tag应该是什么。这里给出了几种解决时间序列问题的方法。

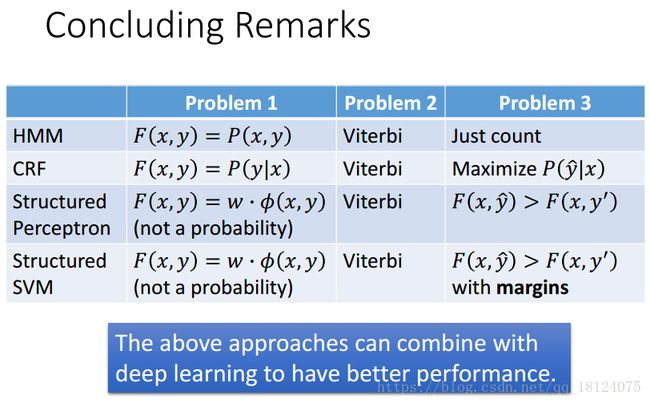

Hidden Markov Model (HMM)

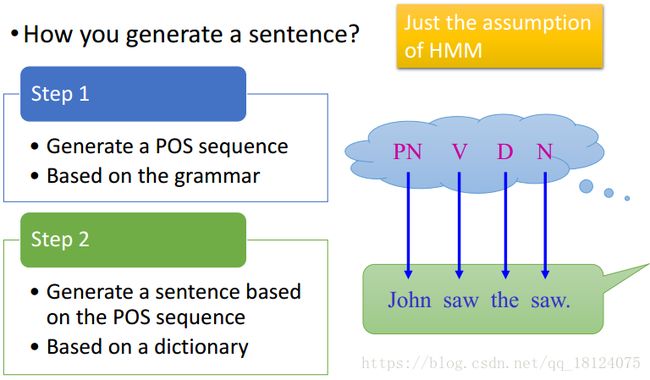

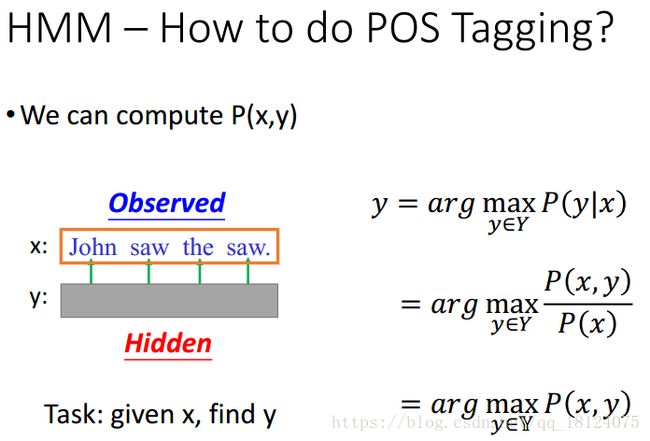

对于HMM,解决这类问题我们可以分为两步,第一步是基于语法知识产生一个POS序列;第二步是基于词典从中抽取对应语法的单词,从而实现将POS sequence向word sequence转换。

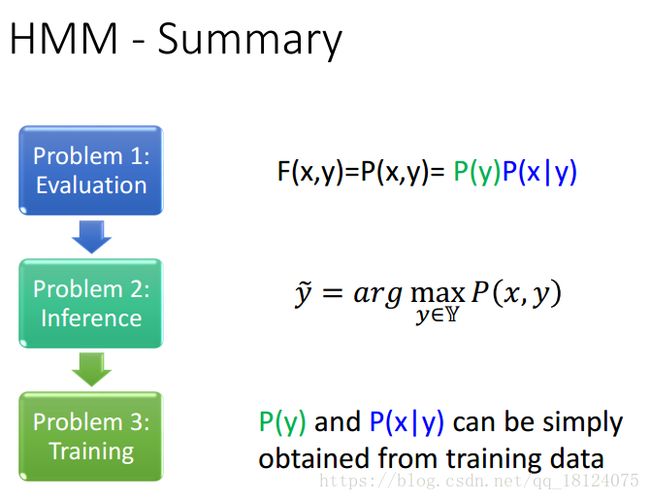

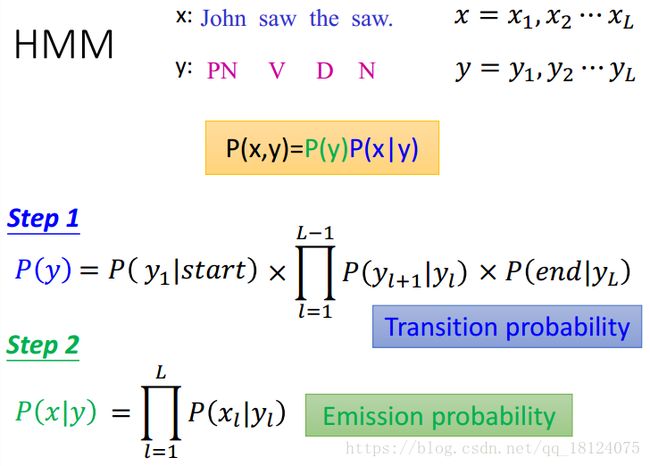

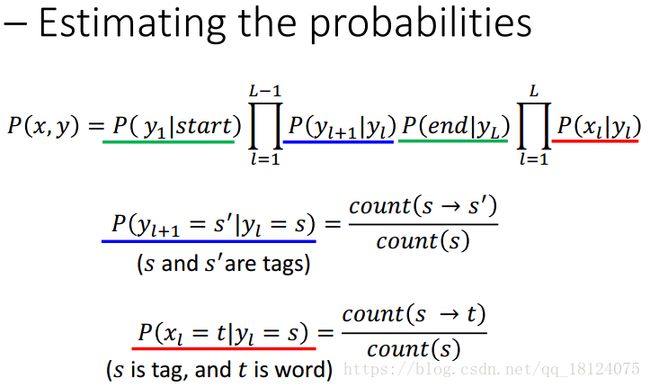

对于HMM的第一个问题Evaluation,我们可以用贝叶斯公式将其展开,再分别计算转移概率和发射概率。

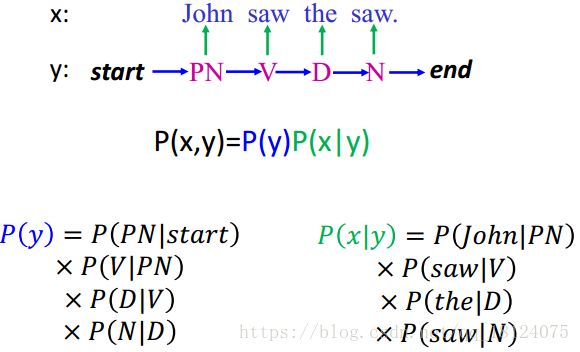

具体举一个栗子,参照上面的公式应该能够明白怎么回事。

对于HMM的第二个问题Inference,已知观测状态求隐状态,此时我们不需要穷举所有可能出现的状态,我们使用维特比算法去解决。

对于HMM的问题三Training,我们可以从训练数据里面获得P(y), P(x|y)的概率。类似于这种。

HMM缺点

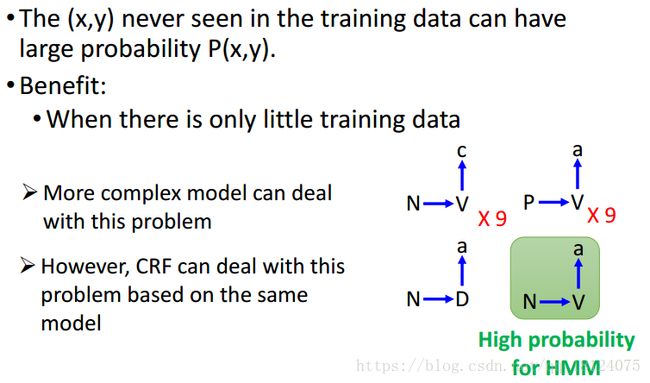

HMM转移概率和发射概率是相互独立的,特别爱浮想联翩,对于未出现的data不见得会给它一个比较低的概率,所有说当训练数据比较少的时候,效果可能会比较不错。但是一旦训练数据特别多的时候,这个效果就不会这么好了。所以说我们需要一个更复杂的模型,同时又跟HMM的模型很相似。

Conditional Random Field (CRF)

对于CRF,我们同样适用三个问题法来进行讨论。

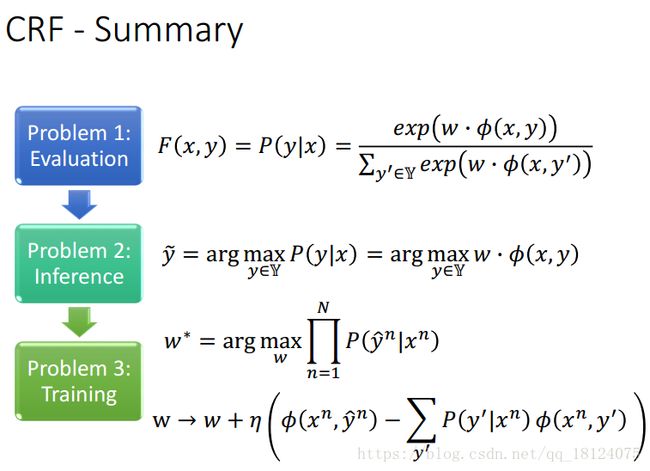

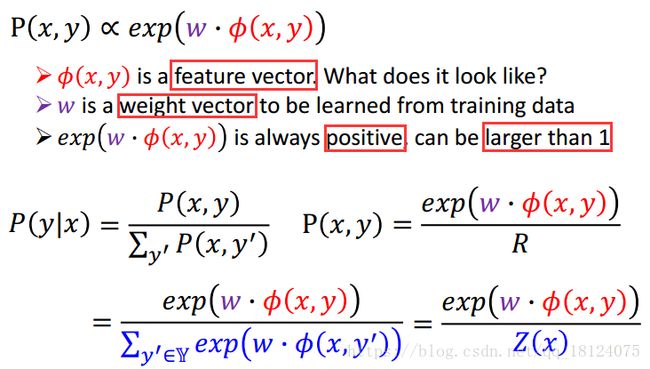

对于CRF的问题一:Evaluation。

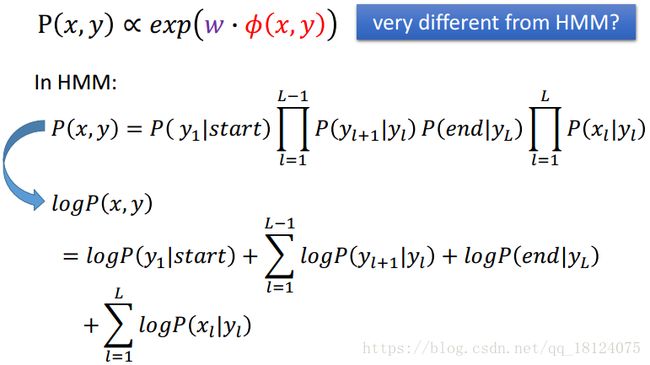

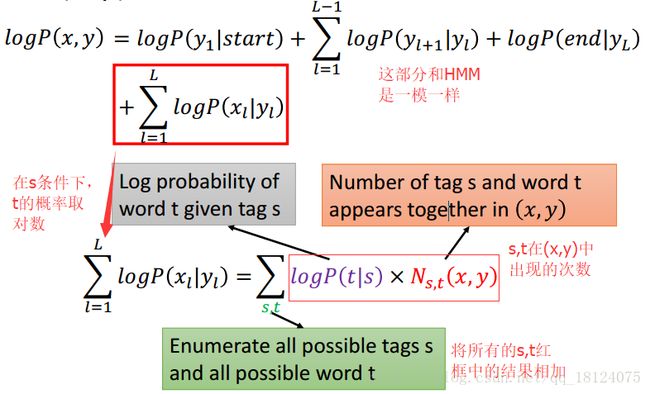

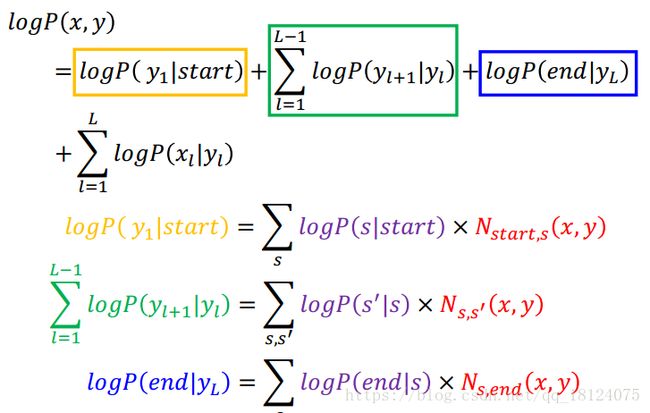

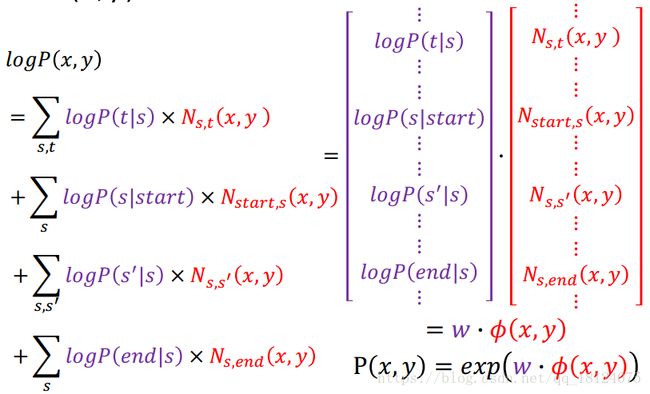

由公式可以知道P(x,y)与exp(w·o(x,y))是成正相关的。所以我们求得后面的公式即可。对于该公式的由来,我们可以从HMM开始推导。

该公式的三个式子可以表示为这三个。我们可以采用矩阵的乘法,变形就可以得到exp(w·o(x,y))。

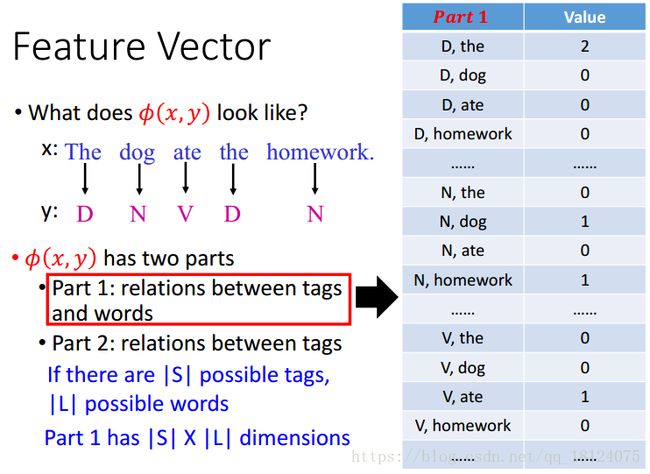

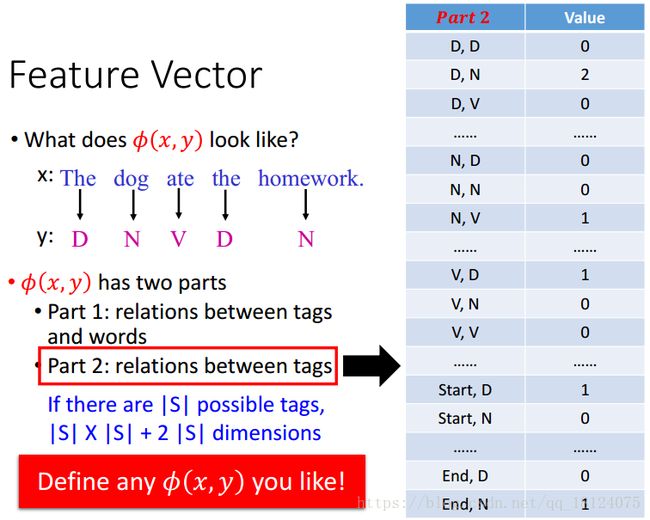

对于这里的特征向量,我们可以自己定义表去求解,此处主要是两部分:tagsàwords, tagsàtags。

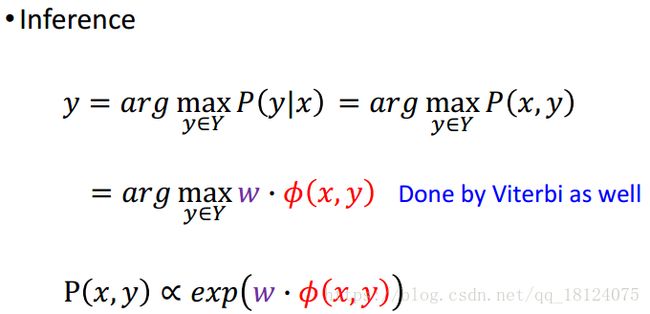

对于CRF的第二个问题Inference,我们依然可以采用维特比算法。

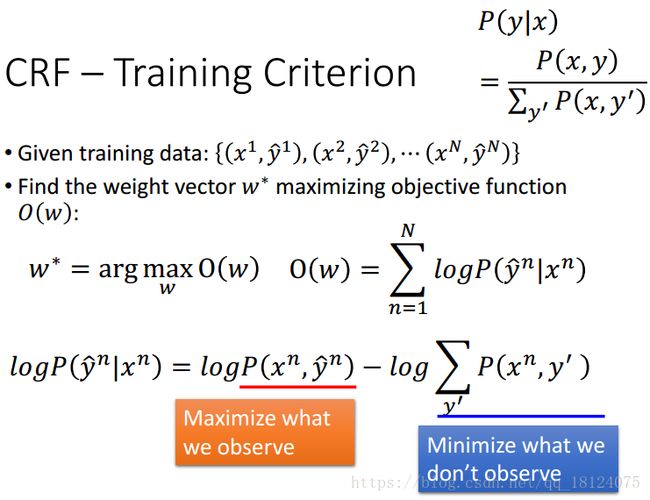

对于CRF的第三个问题Training,我们使用Gradient Ascent算法,对目标函数关于w求偏导,然后对其w进行更新。

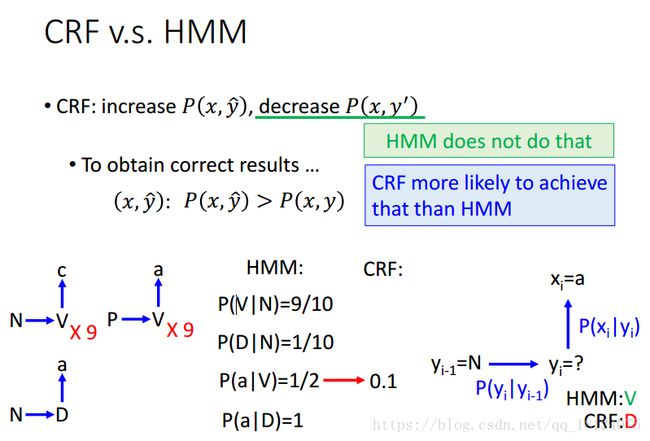

CRF v.s. HMM

HMM不能够做到让观测状态的概率上升的同时让隐含状态的概率下降。CRF能够完成HMM更多不能够完成的工作。

Structured Perceptron/SVM

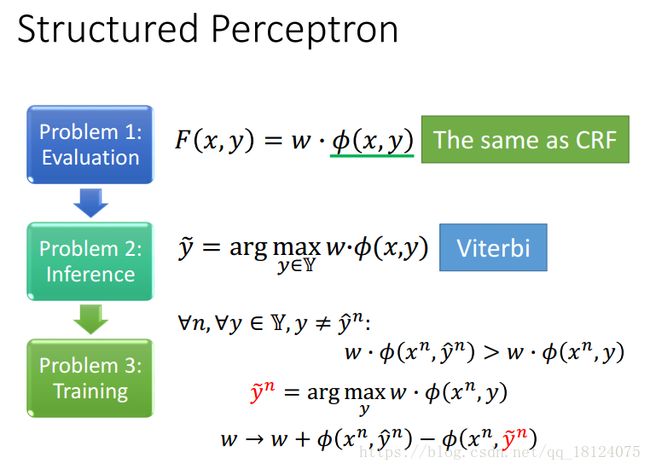

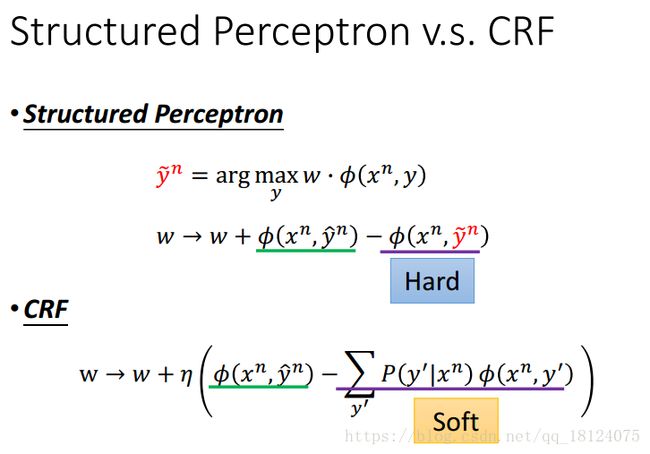

Structured Perceptron和CRF特别像,它们之间的不同就是再training这里。Structured Perceptron为hard,即减去最大可能出现的y(最大的错误概率的那个输出);CRF为soft,即减去所有y可能出现的概率都做sum。

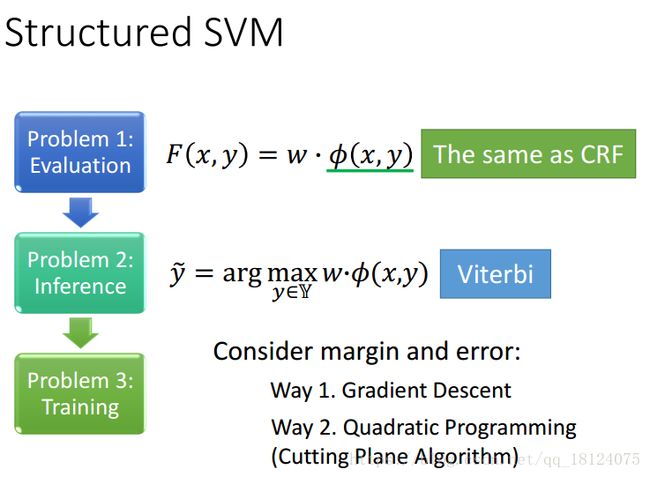

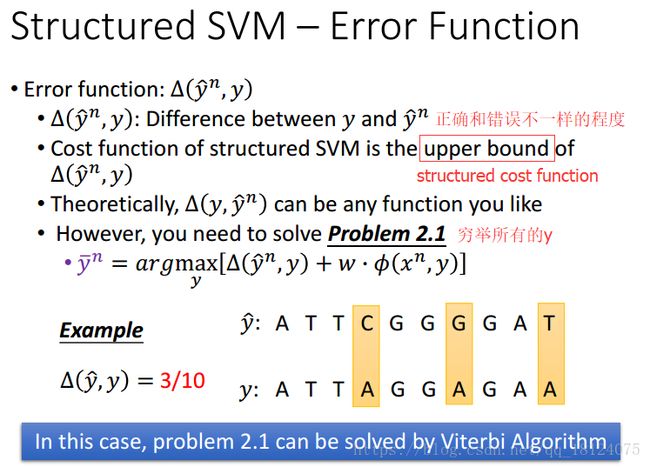

Structured SVM和Structured Perceptron不同之处在于需要考虑margin和error。

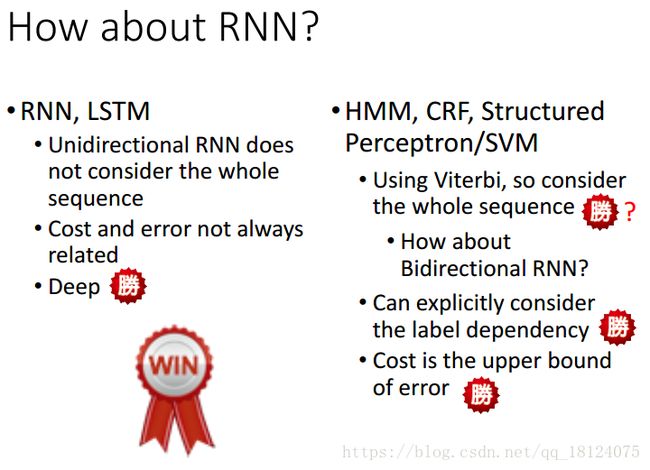

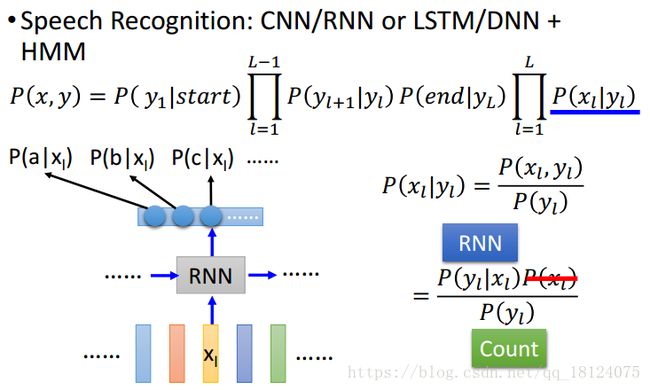

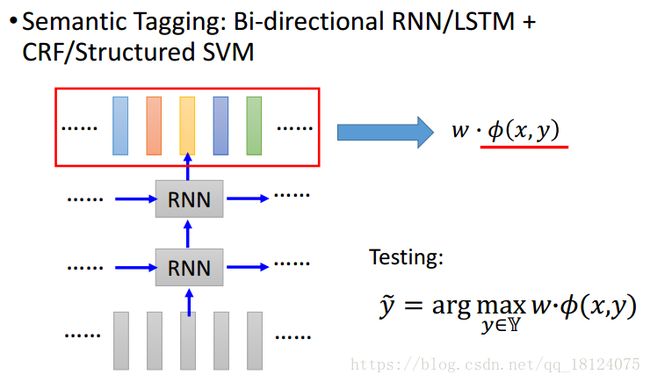

Towards Deep Learning

总体说来structured learning比RNN好,但是RNN能够特别深这是structured learning做不到的。所以我们一般是把两者结合起来使用。