VR的理想与现实

VR的理想与现实

- 前言

- 概念与产品

- 我们如何“看”世界

- 单眼成像

- 双眼聚散与深度

- 视野范围

- 人眼分辨率

- 视觉频率

- 为什么会晕

- 视体不同步问题

- 成像信息混乱问题

- 对VR\AR\MR的影响

- 理想与现实

- 数字影像

- 静态影像

- 动态影像

- 小结

- 现实捕捉

- SLAM

- VSLAM

- 小结

- 虚实合并

- 图像识别

- 实时拟真

- 小结

- 视觉成像

- 不透光的VR

- 透光的AR/MR

- 总结

- 人机“交互”

- 交互方式分析

- 3R交互小结

- 下一代终端

- 声音需求分析

- 图像需求分析

- 产品比较

- 结束语

前言

随着技术的进步,尤其是信息传播能力的提升,现今人类文明发展驶入了持续加速的快车道。科学共同体的模式已经将过去几千年知识技术的台阶式渐进发展变为陡坡式爬升,我们时时刻刻都在进步中。更多分享,更多协作,现在再NB的科学家如果闭门做学问,有个3-5年不与外界接触,就会被整个时代抛离。前不久看了《流浪地球》,不说情节设计,对背景设定有个最大感触,真到了太阳寿命快终结的时候,按照现在人类文明的发展速度,探究出宇宙真理不敢说,但银河系肯定早就迈出去了,亚光速飞行和聚变能源真不是啥太遥不可及的技术,有几百年肯定能搞定。

说的远了,回来讲本文的主题。现在VR\AR\MR\CR\XR各种R概念纷飞,让人眼花缭乱,作者希望通过从技术方面的整理分析,对未来5-10年个人终端设备VR\AR\MR的发展做一番展望。首先旗帜鲜明的表明作者个人观点,智能眼镜是一定会取代智能手机成为下一代个人终端的最主要形态,这个时间过程可能至少会是3-5年,但肯定不会超过10年,要相信当前技术发展的加速能力,具体在后文“下一代终端”章节中会有描述分析。

为了省事,本文中所有关系到VR/AR/MR三者全体的描述,都以3R表示,反正写此文纯粹是作者兴致喜好,不涉及凑字数算稿费的情况。本文的内容全部源自互联网公开资料,作者仅试图从自身视角出发,对相关技术内容进行逻辑整理和重组织输出,更方便同好者学习理解。

作者对所有内容来源的被引用者均致以最诚挚的谢意,因参考引用的源头太多与较为零散,且本文也非学术性文章,就不一一列出了。阅读者如果有更深入的学习意愿,也请自行就关键字去互联网检索,无需询问作者有哪些推荐阅读。另外本文适用于WTFPL license,如有读者希望引用转载本文中内容时请参考。

概念与产品

首先明确概念,目前被提到最多的VR\AR\MR\CR\XR几个,就个人理解,现阶段技术相对成熟,有可见工程产品的只有VR(虚拟现实)、AR(增强现实)和MR(混合现实)三类;CR(影像现实)仅是一个成像效果概念,跟产品没任何关系;XR则是个噱头,X代表啥都能装,这种就属于纯粹的概念炒作。

VR产品成熟度最高,作为全封闭影像系统,专注于视频和游戏领域,为用户打造一个脱离现实的环境,类似于网文中的魔幻玄幻历史架空类小说。业内知名产品如全球的HTC Vive、Sony PS VR、Facebook Oculus Rift、三星Gear VR,国内也有暴风、小米和华为等大量价格更亲民的VR产品。虽然仍有不少技术问题未能完美解决,但VR产业已经进入高速成长期,不影响大规模商用。那种用两块透镜看手机屏幕的特色“VR”不在本文讨论范围内。

AR和MR,都是将虚拟图像和现实图像结合在一起进行呈现,类似于网文中的现代都市异能类小说。二者目前概念说法很多,边界定位不够清晰,个人倾向于AR仅做数据图层叠加,MR会将虚拟图像与现实图像结合显示。产品形态上AR眼镜都不是封闭的,现实景象仍然依靠人眼直接捕捉;而MR现在虽然受困于技术,都是不封闭的,但未来发展方向一定是全封闭的,会通过摄像设备捕捉现实景象,然后与虚拟景象结合计算,再将融合结果在眼球前屏幕上成像。具体的分析请参考下文。

MR技术要求更高,目前主流市场上也仅有微软HoloLens和Magic Leap这两款不够成熟的非商用产品。AR相对简单,如Google Glass、EPSON BT系列、Meta AR等成熟产品很多,国内目前也有GLXSS Pro、0glass等应用于如医疗、工业制造等不同行业领域的产品,虽然使用场景严重受限,但价格也大都可以接受。

AR/MR面临的最大问题是应用,因为要跟现实相结合,就不能像VR那样在视频游戏领域天马行空的去创造内容。简单来说就是我们带着AR/MR设备能干啥是很受限的,如果只针对具体场景如行进指路、医疗手术、工程维修等,就太细碎了,花很多钱研发出来的场景应用,可能带不来多少使用效果提升,投入产出比不高,市场自然做不起来。

个人感觉AR更快速的普及发展方向应该是对个人办公系统的替代,通过网络和云桌面结合,能投影个Windows系统出来,随时随地干活儿,取代笔记本和台式机,便携性提升很多,同时不属于新增投资,也更有利于大众的接受。MR技术成本短期内很难有大的下降,且应用方向不清晰,短期内很难有普及性发展,但AR属于MR的过渡技术,终将被MR替代,当然受技术成熟速度和商业发展影响,估计至少要5-10年的长周期才行。

我们如何“看”世界

不管是哪个R,其核心技术都是视觉成像,所以先简单介绍下我们“看”东西的原理,这对后面理解当前3R的技术困境会有很大帮助。

单眼成像

我们看到的景物都是光源发出的光或者物体反射的光。人眼本身是一个可自我调整的精密光学系统,当景物通过晶状体在视网膜上成像,分布于视网膜上的各视觉系统得以感光并将其从辐射能转变为电脉冲,最终由大脑解码产生图像。

![]()

视网膜上的感光细胞分为两种:视锥细胞和视杆细胞,分别对应人眼的明视觉和暗视觉。视锥细胞又分为红色、绿色和蓝色感光细胞,其对照明的明暗条件敏感度较低,只有当光照强度达到一定条件时,锥细胞才能够起作用;视杆细胞对光照的敏感度较高,可以在光照条件很暗的情况下对景物成像,却不能感受颜色,这也解释了为什么在晚上的时候人仍然能够看到物体,却不能有效地分辨物体的颜色的现象。

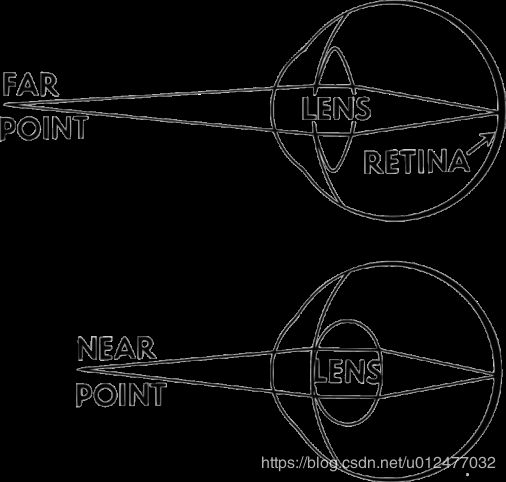

眼球中最主要的两个部件就是负责控制进光量的瞳孔虹膜和控制对焦的晶状体(水晶体),例如近视的主要原因就是总看近处的景物,导致晶状体长时间维持拉伸状态导致无法压缩(就像一直被拉开的弹簧会变得无法自动压缩回弹),远处的景物就无法在视网膜上形成对焦了。我们常说的看书看手机看电脑容易近视,就是因为长期视线聚焦在近处小范围物体上导致的,跟看啥东西其实关系不大。

正常晶状体变化图示

![]()

近视眼远景成像问题图示

双眼聚散与深度

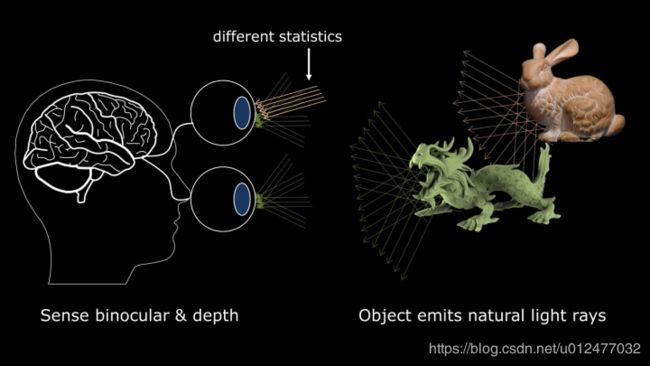

前面讲的是单个眼球成像的光学原理,在我们通过视觉系统判断景物的远近距离时,要依靠大脑通过双眼观察到的两幅不同图像进行合成计算。单眼观测图像虽然也能简单依据近大远小来判断距离,但往往不够准确。双眼观测这里有两个重要的计算因素,聚散和深度。我们都知道物体离眼睛越近,左右眼看到的差别就会越大,通过这些物体的光场观测区别,大脑在合成图像时,会给出物体距离更准确的判断。

当看近处物体时,我们称为汇聚,此时两只眼睛是朝内的,汇聚的目的是让你聚焦的地方变清晰。而看远处物体时,双眼朝外,我们叫做分散。大家小时候常玩的斗鸡眼其实就是聚散效果的体现,首先两只眼睛都朝着鼻子的方向看,然后慢慢朝远处望去,双眼汇聚的焦点越来越远,远到无穷远,这时双眼视线就近乎平行了。

另外我们通过瞳孔的进光量控制,可以对物体的深度进行判断。当我们看近处的物体时,瞳孔收缩,减少远处物体的进光量,使其变得模糊,从而给大脑一个深度的信息,用于位置距离的综合计算。

视野范围

视野也被称为视场,指人眼平视某一个点时的视觉范围,这个视觉范围分为三个级别依次降低:最大视野、正常视野和最佳视野。

最大视野指能看到的最大理论角度,包含单眼的范围极限,实际上对视觉成像影响不大,很多边缘区域信息在脑中合成时会被自然丢弃,只有部分经过特殊训练的情况下大脑才会做处理,例如某些桥段中情报人员用视线余光查看追踪对象这种。

正常视野在水平区域左右30-60度之间,垂直区域上30度下40度范围以内,具体都是因人而异的。根据这个数据,大家就可以自行计算,多大的屏幕放置在离眼睛多远的距离是最合适的观看效果了,对大家在挑选电视显示器大小和沙发桌椅高度时,有很大的参考意义。

因为视野范围是考虑到眼球的转动范围,那么就还有个最佳视野的概念,指实际最舒适的眼球转动范围,这个值一般是在更小的水平左右15度,垂直上25下30范围内。当然这也是3R智能眼镜产品应该满足的最低标准。

![]()

人眼分辨率

我们到底能看多清楚,实际上并没有啥定论,人眼分辨率流行的说法,从400万到5.76亿像素的说法都有,各有各的算法。以5.76亿为例,算法如下:

- 人眼分辨率最小细节0.59角分,按0.6角分计算;

- 一个线对2个像素,一个像素就是0.3角分;

- 水平横向视野120度,等于24000个0.3角分,就是24000个像素;

- 按照正方形视野框计算,就是24000*24000=5.76亿像素

算法很简单,但实际指导意义不大,人眼的分辨能力因人而异差别极大,除了感光、色彩、视野这些基本条件外,更重要的是大脑。有个开玩笑的说法,上帝作为人眼设计师,水平是很烂的,也就是个胶片照相机的水平,比现在的数码和光学相机设计差远了;但其作为大脑设计师真是超神级的,可以把人眼吸收到的乱七八糟图像各种组合优化。后期处理无敌,才让我们能清晰地“看”到这个精彩的世界。

因为实际上每个人视觉成像的感知条件相差甚远,所以这里也不对人眼分辨率做过多的剖析,个人比较赞同的观点是,考虑分辨率时成像距离更重要。下面举手机的例子计算。

- 假设我们在距离眼睛40cm(15.748英寸)看一个手机,则屏幕上1个英寸对应视野角度约为1.82*2=3.64度(直角三角形两条直角边1/2英寸和15.748英寸,得出短边对应角为1.82度);

- 按0.3角分1个像素,3.64度约738个像素,既屏幕分辨率能达到738PPI即可,更高的人眼也分辨不出来。

可以看到上述计算过程中的主要变量只有一个视距,之前苹果MAC曾提出300PPI最佳分辨率的说法,实际上就是将人眼到显示器屏幕的视距设置为1米,按照上述算法计算出来的。同理,如Gear VR和Oculus Rift等产品,屏幕距离眼睛约16cm(6.3英寸)左右,可以计算出分辨率能达到1800PPI即可满足人眼分辨能力。

Google和LG在2018年5月发布的最新VR屏幕已经可以达到1443PPI,随着硬件技术的进步,显示分辨率不会成为3R的关键瓶颈。

如果再考虑到水平120度、垂直上30下40度的正常视野范围,可以计算出16cm(6.3英寸)视距的VR产品,合适屏幕长宽为21.82*(3.6+5.3)英寸,理论上点对点分辨率约需达到39000*16000。但这只是个上限值,实际通过眼动追踪和双屏显示等技术,完全可以不必展示这么清晰的全景画幅出来,人眼也看不过来,要相信大脑的视觉合成与理解能力。

视觉频率

最后一个跟成像关联性较大的概念就是视觉频率了,对应的是屏幕显示技术中的帧率、刷新率等参数。前面提到眼睛成像主要依靠视锥细胞和视杆细胞感光,那么当光反复变化时,我们眼中就形成了连续的过程图像,在这个变化过程中,如果速度过快,会造成成像影响,既人眼只能识别出一定频率的变化,更高的内容会被忽略掉。例如999张黑图片和1张白图片按1ms每张速度变化,我们的眼睛根本看不到白色出现,这就是视觉频率极限。这个频率一般是个范围值,同样会因人而异,通常60hz(120fps)以上的变化大部分人就看不出来了,实际上屏幕显示技术都已经能达到此指标,所以帧率不是3R技术发展的瓶颈。注意,这里60Hz是个范围值,而不是说60Hz能看出来,61Hz就看不出了,各人的边界值会有较大差异,能分辨出144Hz的强人也是存在的。有种说法是本来自然界的光变频率没有多高,人眼也能力一般,但随着当今屏幕显示技术的进步,人眼的视觉频率也在逐渐增强进化,当然这还有待求证。

再补充一下,这里只是做了些基础介绍,视觉频率实际有着复杂的过程,视觉系统对于不同复杂程度的刺激物也有着不一样的极限。例如电影只要超过24Hz就能“欺骗”眼睛,告诉我们成像是连续的,而闪光灯哪怕1/1000频率亮起时,也会被捕捉到。如前所述,光感图像除了在视网膜上成像外,还有大脑在做着NB的后期,会根据图像复杂与刺激程度,决定哪些内容需要“告知”我们,哪些直接被裁剪掉即可。

为什么会晕

现在网上一提到智能眼镜,大家首先想到的就是看时间长了会晕,这也是目前3R产品普及过程中较大的拦路虎。想解决这个问题,就要先搞清楚为什么会晕。

人体是一整套复杂的器官组合,其中和外部世界交互的部分,可以简单概括为输入输出两类。那么去除掉人体自身发生的系统故障外,和外界交互过程中导致的头晕,大部分原因都是输入异常造成的。

本文所要讨论的跟3R相关头晕症状,可以依据输入异常的原因主要区分为两类:

- 视觉成像系统与身体其他输入系统输入信息不同步造成的混乱;

- 视觉成像系统自身信息输入混乱。

第一类比较第二类更容易解决,下面分开介绍。

视体不同步问题

人体的耳前庭器官(主要是半规管)是感受运动状态的重要器官,可以感知速度、重力等人体运动状态。因此当我们乘坐交通工具的时候,眼睛看到的结果告诉大脑,我们在快速运动,而耳前庭感受到的身体状态是相对静止或慢速运动,二者信息的不同步造成了大脑认知的迷惑,出于保护告警目的会通过头晕等症状提醒身体状态异常。所以我们会出现晕车、晕船、晕机等各种晕动症。

使用VR系统时,由于全封闭的视觉成像与外部环境脱离,更容易造成与人体运动状态认知的不同步,大脑多方采集的输入信号矛盾,进而导致头晕的产生。

此类晕动症相对好解决,因为人体有很强的自适应能力,绝大部分人通过多次乘坐交通工具,会训练身体学习适应此类状态,进而让大脑了解到此类视体不同步状态是正常的,将眼睛成像与体感状态区分开,减轻甚至不再产生头晕现象。VR同样可以在长期使用后训练适应,如通过模拟仓等一些技术手段帮助人体感受到运动状态变化,减轻初期的头晕症状。当然因人而异,肯定存在适应力极强和极差的个体,这里只对大部分平常人的状态进行讨论。

简单来说,使用VR产品时,视体不同步造成的头晕,多看看就能适应。

成像信息混乱问题

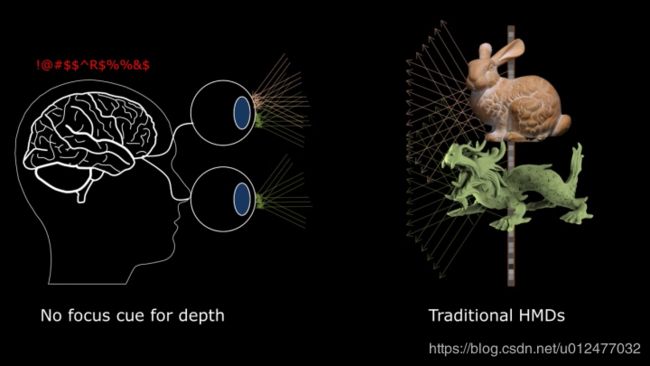

前面成像原理中提到双眼自然成像时,是通过聚散与深度来帮助大脑进行景物的远近判断。当我们使用VR等设备时,虽然可以通过3D技术,给双眼呈现不同图像,解决大脑合成图像时立体成像的问题,但全封闭眼镜提供的屏幕视距都是很近的,导致双眼根本无法进行聚散。同时,由于屏幕的平面显示过程中,自然成像的4维光场被缩减为2维光场,深度信息丢失,进一步给大脑造成了成像的混乱,对物体的远近无法进行准确判断。此时大脑就会自动反复调整瞳孔和晶状体等眼部器官部件进行对焦,最终造成视觉疲劳、眼压增加,甚至恶心头晕。

聚散混乱问题图示

深度丢失问题图示

聚散与深度造成的视觉成像头晕问题,其根本原因都是在于屏幕显示这种成像技术,目前还无法完美模拟出自然光场效果。

对VR\AR\MR的影响

视体不同步问题通过长期训练可以很大程度上缓解,但视觉成像信息混乱问题就不是那么好解决的了。

AR由于非封闭显示,大脑认知上可以清晰辨认出虚拟与现实区别,眼球也可以在不同远近的真实物体间变换,相对来说视觉压力要小很多。

VR产品虽然也面临视觉成像问题,但由于主要应用在视频和游戏场景中,是完全的虚拟景象,大脑就不会将其“当真”,再加上景象数据制作过程中,可以采用一些其他成像辅助技术调整聚散与景深效果,因此相对来说不适应症状没有那么强烈,更多的不适感还是由前面说的视体不同步造成。

而MR产品,因为其“以假乱真”的定位目标,则受此问题影响较为严重,也成为整个技术发展中最大拦路虎。想要彻底解决,目前能看到的只有Magic Leap的光纤投射技术,将4维光场直接投射到眼睛上,在视网膜成像,这样不存在信息丢失,跟我们自然视觉得到的景象在数学上是没有区别的,因此理论上我们使用此技术设备时,也将无法区别出虚拟与现实。Magic Leap也是依靠这个技术噱头,在7年没有推出产品的情况下,仍陆续吸引了近30亿美元的多轮融资,最高估值近百亿美元。而微软的HoloLens,也因为没有提出很好的解决方案,导致其虽然很早就做出了工程产品,但一直无法大规模商用。

至于网上所说清晰度、帧率和延迟这些问题,虽然也造成了一定的视觉成像影响,但通过硬件的升级,用更好的CPU\显卡\屏幕\网络就可以解决,都不是3R至晕的决定性根因。这里就不做深入探讨了。

理想与现实

从产品定位来说,MR是VR和AR的未来终极目标。在这个理想目标中,主要需要解决如下4个技术路线难关。数字影像->现实捕捉->虚实合并->视觉成像,成熟度由高到低,困难度由低到高。VR主要涉及数字影像和视觉成像两项,以数字影像为主;AR四项虽然都会涉及,但都是轻量级使用;MR的目标则需要将四条路线都发展极致。

![]()

下面分别来介绍下这四条技术路线的理想与现实差距。

数字影像

静态影像

数字影像技术发展到现在已经相对成熟,从静到动,从2D到3D,从2K到4K,概念很多。概括来说,其发展过程就是一个由少到多,由简单到复杂的图片组合过程。

最基础的数字图像就是一个带空间坐标的灰度函数,构成的二维矩阵。从分类发展看,经历了如下几个主要阶段:

- 二值图像:最简单,只有0/1黑白两种状态显示;

- 灰度图像:扩展到0(黑)到255(白),256级灰度表示;

- 彩色图像:三个256级灰度图像,组合而成的红绿蓝图像。真彩色指256256256=2^24种彩色组合,既24位。比其低的8位16位都是简化了部分灰度级别的伪彩色;

- 立体(三维)图像:通常是多张彩色(灰度)图像组合,形成多角度图像,给人以立体视觉,最终脑海里面可以合成三维图像。

总体上立体图像分为两大类技术手段:一是通过明暗虚实等光影效果造成立体感觉,来源于早期的绘画技巧,但实际能够呈现的内容非常有限,只能在一张平面图中对某几个重点物体进行立体感塑造,无法形成整体的立体图像;二是通过左右眼呈现不同的图像达到立体成像效果,此类方案更接近人眼成像原理,也是当前主流发展方向。

具体来说,第二类双眼区分成像技术还分为器械流和裸眼流两派,器械流通过如3D眼镜等外部设备,采用如红青互补色或偏振光等原理,让两只眼通过不同镜片过滤,收到不同的图片信息,进而在大脑中组合成立体图像。裸眼三维图像则是以光栅方案为主,通过在显示屏幕外侧增加一层光栅柱透镜的方式,使平面图像在向外发光的过程中,不同角度呈现不同图像,进而在两眼形成视差,构成立体效果。光栅方案对数字图像的成像要求较高,必须是同一物体多张不同特定角度的平面图像合成,加上必须采用增加了柱透镜的屏幕或特殊纸张等材质进行显示,技术上相对成熟度较低,没有器械流的3D眼镜应用广泛。

动态影像

刚刚说的都是静态数字影像的呈现,而我们知道这个世界,静止是相对的,运动才是绝对的。我们在“看”这个世界的过程中,运动也是不可避免的,即使外界景物不动,眼珠也是在时刻运动的,正是在这种“动”的过程中,大脑才能合成出立体的外部全景影像。

数字影像技术的关键也是要动起来,在运动的过程中呈现合理的图像变化,才能让大脑感觉到图像的拟真效果。这里仅介绍几个比较通俗易懂的关键技术点:形状、纹理、反射、透视、模糊。更多的技术作者能力有限,就不做深入探究了。

- 形状,点、线、面(形状)是我们理解世界的最基本图像元素,数字化图像也是要把所有的有型物体解构成这些基本的点线形状,再进行数字化创造。任何一个复杂物体的数字图像都是由成千上万个基础形状组成,物体的运动过程也是这成千上万个形状的运动过程。举个例子,当年《指环王》中的咕噜,眼睛里有25万个多边形,而最新《阿丽塔》中女主的虹膜就由830万个多边形构筑。

- 纹理,指物体表面的细节效果。因为实际中的立体物体其细节大都是不平滑的,因此当运动过程中转换观察角度时,呈现的纹理细节一定是不一致的,需要在采用软件创建3D物体图像的时候细致考虑。

- 反射,我们看到的图像都是物体发光或者反射光线到眼睛中的结果,那么当空间中的物体或我们运动到不同的相对位置时,观察到的反射结果也一定不同,尤其是存在多光源情况下,3D物体设计要考虑的光影反射复杂度也会成指数倍增。

- 透视,描述当空间中存在多个物体时,物体之间的相对成像关系。完全遮挡当然更简单,但实际上大部分物体都会存在透视的效果,尤其在运动过程中,透视效果会随多角度光源及多物体位置关系进行复杂变化。

- 模糊,人类经过几十万年的进化发展,大脑结合视觉成像结果,对物体运动已经形成了一套成型的识别算法。我们对运动速度较快的物体,运动过程中图像会有意的进行动态模糊,便于节省眼力和大脑成像的计算量。因此在数字成像过程中,也需要适配此能力,当然这种模糊也有助于成像过程中处理设备的计算量降低,属于多赢的方案。

小结

总体来说,数字影像技术的目的就是构造一个“以假乱真”的世界,但受限于计算能力限制,目前最多能到“仿真”的阶段,类似影视作品这种单向展示“想给你看的图像”场景,相对更成熟些,图像更“真”些。而游戏类作品这种需要双向互动的图像,基本上都还是“一眼假”的阶段,离欺骗视觉系统还相差较远。这也是目前VR视频发展远比VR游戏更普遍的原因。

好在数字影像的技术发展方向比较清晰,现阶段计算能力的限制,相信随着硬件的飞跃,数字影像不会成为3R的主要瓶颈。再以近期电影《阿丽塔》举例,女主的虚拟形象拥有13.2万根头发、2000根眉毛、480根睫毛外加50万根皮肤绒毛,这些毛发在不同光源下都会呈现不同的状态。为了达到这种近乎乱真的效果,WETA工作室用了3万台服务器,进行5.5亿小时的渲染处理,当年的《阿凡达》则是1.5亿小时。

当然,受主观意识影响,从我们带上3R设备的时刻起,无论看到的内容多么“真实”,大脑一定还会告诉你这是“假的”,不是现实。所以理论上想达到类似《黑客帝国》那种效果,只有依靠影响大脑神经信号才能实现,不单单是3R设备从视觉上所能解决的,因此也没有必要在“成真”这个结果上吹毛求疵。

现实捕捉

AR产品如GoogleGlass,EpsonBT300等都是镜片透光,让我们直接能看到现实场景,虽然也有摄像头可以拍摄实景,但功能简单,可以理解为就是在一张照片上做文章,例如道路上加个导航箭头,人物头顶加个名字红蓝条啥的。如果我们希望将整个现实环境捕捉下来,并在数字化环境中建模,进而实现互动,那么就需要SLAM这个关键技术的登场了。

SLAM

SLAM是同步定位与地图构建 (Simultaneous Localization And Mapping) 的缩写,上世纪90年代提出的概念,目前仍然处于最尖端的技术前沿,在自然导航AGV、扫地机器人、无人机、自动驾驶、自走机器人等方面都有广泛应用。

SLAM要解决的是“我在哪里?”和“我周围是什么?”两个问题,主要包括了感知、定位和建图三个部分。

感知,通过传感器获取周边环境信息的过程。这里的传感器以激光雷达和视觉摄像头两类为代表。激光雷达的特点是精度高、范围广、实时性强,缺点是贵,视觉摄像头则与之相反。考虑到应用场景,MR设备需要能够将现实场景成像,视觉摄像头就是必不可少的了,也就是VSLAM的范畴(基于视觉的SLAM),激光雷达更多在机器人之类对实景要求不高的场景下应用。

- 定位,获取自身位置姿态等状态信息,了解我们正处于一个什么样的位置、高度、角度、运动等状态下观察周围。可以配合GPS、陀螺仪等其他硬件设备,通过算法构筑自身与环境的相对关系。

- 建图,根据感知与定位结果,描绘出周围实景图像结果。这里的建图不是简单的在MR视觉中做图片合成,而是要形成有深度、有宽度、可交互的实体空间图景。建图全靠算法,计算量是对设备最大的挑战。

SLAM是多个学科多个算法的不同策略组合,它融合了图像处理、几何学、图理论、优化和概率估计等学科的知识,需要扎实的矩阵、微积分、数值计算知识,SLAM跟使用的传感器和硬件平台也有关系,研究者需要具备一定的硬件知识,了解所使用的传感器的硬件特性。所以,根据不同的应用场景,SLAM研究者和工程师必须处理从传感器模型构建到系统集成的各种实践问题。作者水平有限,这里就不做深究了。

从MR的应用场景来看,重点发展方向是视觉SLAM系统的轻量级和小型化,辅以多类传感器,如IMU(惯性测量单元)、陀螺仪、磁力计等,最终通过与摄像头拍摄的图像融合,将实景通过数字影像方式于MR设备中再现出来。

目前就SLAM技术成熟度而言,军用的现实捕捉技术精度更高,不论是雷达制导还是精准定位,跟民用的都不在一个数量级上。而民用技术需要综合考虑准确性与性价比问题,短时间内很难做出大的突破。MR场景产品如HoloLens和Magic Leap都只能数字化很小的范围,参考下图,Magic Leap水平40度,垂直30度,HoloLens更小,导致无法获取完整的视场,看不了大的物体。受限于计算和成像能力,没有个3-5年,SLAM很难实现大规模的商业化,近期内还将辅以透光方式的肉眼现实捕捉为主。

![]()

VSLAM

在MR场景中,主要使用了基于视觉的VSLAM技术,其前置条件就是通过摄像头去拍摄实景。摄影摄像技术自1839年第一台银版相机诞生已经发展了近两百年,经历了百万级像素的胶卷相机和千万级像素的数字相机两次革命性飞跃,目前的主流数字摄像技术简单概括就是光电转换的过程,将外部景物的光信号捕捉下来,转换成电信号保存到存储介质中。参考前文的光学成像原理,目前的单镜头在成像上已经很难有大的突破,下一代亿级/十亿级像素的阵列相机(也有叫光场相机)都是采用多镜头(多透镜)的方案加上超卓的计算能力进行图像合成,如Lytro illum。但现阶段,光场相机受限于每个镜头(透镜)的能力,普遍像素不高,而且在将每个镜头记录的二维光场通过数学计算模拟成四维光场的过程中,势必会丢失部分数据,损失分辨率。加上相机中能部署的计算能力有限,想要完整的摄取景物光场,只能牺牲拍摄时间。现在想拍个RAW照片出来,需要举着光场相机近一分钟才行,用户体验相当差劲。由此可见,将微镜头阵列应用到MR设备中去做图像捕捉,还有相当长的一段时间才能技术成熟应用。现有的MR设备都是通过多个摄像头配合各种传感器去做现实捕捉,再进行合成,例如HoloLens包含1个惯性测量单元、4个环境理解摄像头、4个麦克风、1个环境光线传感器。

小结

除了使用SLAM构建立体图景,在MR场景的现实捕捉中,追踪技术也比较重要,其中有三个关键应用场景,物体追踪、手势追踪与眼球追踪。物体追踪用于识别外部物体运动过程,便于下一步虚实合并时,能够让虚拟物体与现实物体保持同步的合理运动行为。手势追踪则主要用于人机交互,作为MR重要的输入手段,手势动作的识别是必不可少的,如HoloLens。眼球追踪则是通过识别人眼聚焦方位,减少成像计算量,是为便携式MR设备减负的关键。

上述现实捕捉的技术点,哪个拿出来都够展开一套大论文的,本文主旨做些体系性介绍,有兴趣的童鞋可以自行研究,深入进去是有很多有意思的东西可以学习的。

可能有看官会问,为啥我们一定要把现实世界完整的捕捉下来再做数字化影像显示呢?类似AR这种透光方式直接观看世界不是更加真实嘛,还增添了这么多的技术难题。这就跟我们想要的虚拟世界与现实世界结合程度密切相关了,既下面“虚实合并”章节要介绍的内容。捕捉下来的实体成像只是第一步,更关键的是对捕捉图像的识别和处理,只有知道了哪个是桌子,哪个是杯子,才能在虚实合并时对其进行合理的处置,把虚拟的美酒倒进杯子里,而不是洒在桌子上。

有追求才会有困难,有困难才能有进步。

虚实合并

通过数字影像技术,我们创造了虚拟的图像世界;通过现实捕捉技术,我们将真实世界数字化。接下来要做的就是将二者虚实合并,形成MR混合现实呈现。

数字影像生成的过程中就已经完成了对影像内容的定义,但现实捕捉的图像还需要进行识别才能知道其中实体代表的意义。二者都具备精准含义后,才能进一步进行合并。理想状态如下图中的桌上太阳系所示,虚拟的太阳与行星在运动过程中,桌面上能够有符合轨迹的光影出现,反光也会随着佩戴设备的观察者移动而随之变化,形成拟真的效果,就像桌子上真的有个太阳在发光一般。

当然这是理想中的虚实合并效果,目前现实中的实现都还比较初级。如游戏Pokemon GO,基于地理位置信息、摄像头照片与虚拟影像进行了简单的融合;再如在人像上加个猫耳朵,猪鼻子之类的照片处理APP,则是简单对面部进行了识别,然后再结合虚拟图像成像。这些都可以认为是最最基础的AR类虚实合并应用。

从技术上看,虚实合并阶段最关键的有两块内容,一是对捕捉下来的现实图像进行图像识别,二是对生成的虚拟图像进行实时拟真。

图像识别

首先说一下图像识别与SLAM的区别,空间告诉物体如何运动,SLAM是要构筑环境空间图景,以便后续的运动轨迹规划,如告诉我们前方1米处有个0.5米高的类正方体物体,便于后续动作中设计与其如何进行运动交互,至于这个物体到底是个桌子还是椅子啥的,就是图像识别要干的事情了。

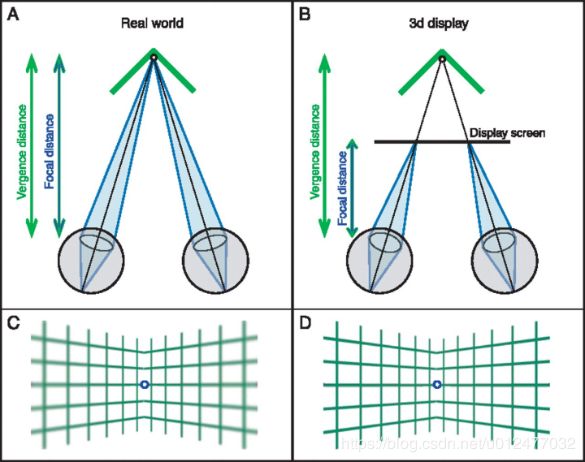

图像识别涉及了目前最火的大数据和AI等领域,人像识别也好,物体识别也罢,粗分下都是提取特征码、算法比对、模型训练、提升正确率这几步过程。目前特征库的训练还以手工为主,真正的机器自动学习只是在很少的特殊领域里面能有所应用。有一些三线城市和小县城的图像训练公司,业务就是甲方一次打包发过来的几万甚至几十万张图片,乙方从中对指定的人像和物体做标签标注,合下来标一张图片几分钱到几毛钱不等,一个熟练人员一天能赚到一两百。过程除了是使用电脑以外,感觉跟流水线上的操作一脉相承。

图像库的丰富程度决定了图像识别的程度,以ImageNet和PASCAL VOC两个知名项目举例,普林斯顿的ImageNET拥有约1000个对象类和1400万个图像,而欧盟各大学联合创建的PASCAL VOC(2012年结束,目前重启了PASCAL2项目)仅有20个对象类20000个图像。巨大的数据差会造成识别能力的差距,如下图所示,ImageNET可以识别出具体的犬类,而PASCAL只能认识出图像是狗。

![]()

图像识别的算法主要有以下几大流派:

- 统计法(StatisticMethod):以决策理论为基础,通过建立贝叶斯或马尔柯夫随机场等模型,以大量统计分析的方法,找出图像中的规律和提取特征进行识别。严格的数学论证使其具有最小的分类误差,但相对处理复杂结构类图像的能力较差。

- 句法识别法(Syntactic Recognition):统计法的补充,模仿语言学中句法的分层结构,将复杂图像分解为多个相对简单的子图像,令其空间结构关系信息更易理解。

- 神经网络方法(NeuralNetwork):通过神经网络算法进行图像识别,由大量简单的计算单元(神经元)组成,模拟人的认知过程,适合复杂多变环境下的模糊识别,但对局部图像的精确分类识别能力欠佳。

- 模板匹配法(TemplateMatching):通过已知模板对未知物体进行匹配,可以认为是统计法的特例。受限于已知模板的依赖性,仅用于精确物体的比对识别,一般来说图像变个角度就认不出来了。

- 几何变换法霍夫变换HT (Hough Transform):快速形状匹配的一种方法,通过将形状曲线上所有点变换到霍夫空间中,形成峰点,进而将未知与已知图像的图形匹配识别的过程,变成了峰点检测的数学过程。随后提出的几种改进算法,如快速霍夫变换(FHT)、自适应霍夫变换(AHT)及随机霍夫变换(RHT),都能够很好的节省内存空间与计算量,进而提升图像处理能力。可以说霍夫变换是目前应用最广泛的图像识别算法。

实时拟真

在虚实合并阶段,MR虚拟图像的拟真,相比较纯粹VR环境下生成数字影像,多了实时性的要求。假设现实捕捉可以在数字世界中营造出完全真实场景,而且已经拥有完美的图像识别能力,可以对场景中的所有景物进行准确识别。那么当我们将虚拟图像与其进行结合的时候,为了达到以假乱真的效果,还必须进行大量的计算处理。

首先在静态场景下,需要计算出虚拟图像与真实图像之间的影响关系,如前面举例的虚拟太阳在桌面的反光,还有如遮挡、压变、阴影等变化。

然后在动态场景下,随着观察者自身和场景中虚实景物的移动,上述虚实景物的相互影响都需要随时重新计算和进行合理变化。这种动态计算对实时性要求非常高,延迟必须在毫秒级别,才能让我们不会感知到虚拟图像的“假”。目前的HoloLens和Magic Leap虽然计算配置都很高,如Magic Leap ONE配置CPU:NVIDIA ParkerSOC;2个Denver 2.0 64位内核 + 4 个ARM Cortex A57 64位内核;GPU:NVIDIA Pascal™;256个CUDA内核。但实际上当前这些MR都还是站桩式产品,佩戴的人一动起来就各种图像混乱和马赛克了,根本没法带出室外使用。

小结

总体来说,在虚实合并阶段,图像识别仍是亟需攻克的技术壁垒,虽然我们在人像识别等特定景物处理上已经拥有一定进展,但在广泛意义的全景物识别上,能力构建仍然不足,距离商业应用还有很长的路要走,好在随着其前置技术AI机器学习的飞速进步,图像识别也将在3-5年内迎来能力的飞跃。而实时拟真方面,其前置技术在数字影像中基本都已点亮,目前主要受困于计算能力的提升,相信随着CPU/GPU演进速度和云端集中计算模式的推进,不会成为整个MR技术体系的发展瓶颈。但由于实时拟真是在现实捕捉和图像识别之后进行的动作,光自己快速成长也没什么大用,还得等着前面两个技术的成熟。

视觉成像

图像都准备好的情况下,回到如何让我们“看到”这些图像的基本光学问题。视觉成像也是当前3R技术发展的最大拦路虎,前面《我们如何“看”世界》和《为什么会晕》两个章节都是这部分内容的前置介绍。

总的来说,成像用的头盔眼镜类设备就分为透光和不透光两类,VR都是不透光的,AR都是透光的,MR受限于现实图景和实时成像技术发展,目前产品都是透光的,未来趋势也将是不透光的。

不透光的VR

先说不透光的VR类产品,成像重点是把那块发光的“屏”做好,因为技术聚焦且成熟度较高,显示效果比起需要透光的AR/MR来说那是杠杠的。屏幕显示技术两个最关键的点就是“光”和“屏”,技术发展上大体可分为三代。

第一代的阴极射线管CRT是通过阴极电子枪将电子打到荧光屏上,使荧光粉发光,电子枪快速移动,以逐行扫描形成全屏图像。早期一只电子枪只能通过光线强弱形成黑白图像,后来通过红绿蓝三只电子枪组成彩色图像。因为体积较大,CRT基本没有应用到头盔显示系统中,2000年以后逐渐被淘汰,目前大都只能在计算机发展的历史影像资料中见到了。

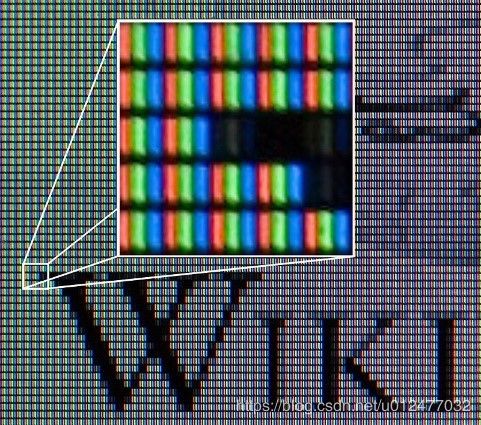

第二代,也是现在的主流技术液晶显示LCD。在屏幕中间的液晶层,通过电压对液晶分子的控制,将光源发出的白光做减法,从而实现256个层次的灰度,再通过每个像素点细分为红绿蓝三个子图元,配合前面的滤色片实现彩色显示。具体的技术细节太多,不深入解释了,可参考如下两张图理解。

![]()

这里有个容易被厂家宣传误导的知识点,我们常说的LED(发光二极管)显示屏,仍然属于LCD的范畴,只是使用白光LED取代上图中的冷阴极灯管CCFL作为光源,其他都不变,和第三代的OLED显示原理完全不同。

第二代显示屏中还曾有两个主力选手背投屏和等离子屏PDP,背投可以理解类似为投影仪加透光屏,等离子屏则类似CRT,通过电压使气体发生等离子效应产生紫外线,照射在荧光屏上产生三色可见光,通过发光时长变化来调整亮度。二者都因为体积无法缩小与移动时稳定性差的问题,逐步被淘汰,背投仅在2005年左右辉煌过几年,等离子屏则在2014年随着三星LG等最后几个厂家陆续宣布面板停产而落幕。

第三代,也就是下一代屏显技术的代表是OLED(有机发光二极管),目前随着技术的成熟,正在开始大量应用于手机和pad这种小型设备上,电视等大屏由于成本问题发展相对较慢。OLED也被称为小分子发光二极管,这个名称是相对PLED(高分子发光二极管)而言。PLED更适合做大屏幕显示,但寿命较短导致无法普及。相对LCD液晶屏来说,OLED主动发光的特点可以把屏幕做得更薄、拥有更广的视角和更快的反应速度,同时由于是全固态组件,抗震性更佳,能适用更多的环境。发光原理上,OLED更类似CRT,可以简单认为通过数字电路控制一个个小光源发光。OLED根据驱动方式不同,可以分为AMOLED(主动驱动OLED)和PMOLED(被动驱动OLED)两类,PMOLED单纯地以阴极、阳极构成矩阵状,以扫描方式点亮阵列中的像素,结构简单但驱动电压高,不适合高分辨率显示;AMOLED通过独立的薄膜层电晶体去控制每个像素,每个像素皆可以连续且独立的驱动发光,虽然成本更高,但驱动电压低,寿命也相对更长。目前市面上的OLED显示屏基本都是AMOLED,可以认为二者商业意义等同。

下一代技术中,另一个有潜力的选手是Micro LED,就是将三色LED灯泡做得足够小(1~10μm等级),再组成阵列,单独控制发光,从功耗和亮度都更有优势。Micro LED需要解决的最大难点是灯体之间的干扰问题,且灯体结构相比较OLED更加复杂,工艺制造成本也更高,量产困难。但苹果、Sony、三星等玩家均在积极布局,普遍看好其作为新的屏显技术,行业预测2019年就将有商用产品问世。通过下图可以更好的比较LCD\OLED\Micro LED三者的结构区别。

了解了屏显技术的发展,我们回来说VR到底需要什么样的屏。

- 轻:重了戴不长,对脑袋负担重。 小:便于携带,现在的头盔都太大了,只能固定场景用。

- 快:反应快,尤其是现在画面清晰度越来越高,屏幕反应慢了图像拖影现象会很明显。

- 清:前面算过智能眼镜类产品,屏幕到眼约15cm距离时,需要1800PPI。加拿大VueReal公司展示最新的Micro LED产品高达6000PPI,有助于拉近屏幕到眼的距离,进而也可以使VR眼镜设备体积进一步减小。

- 广:曲面屏显示可以提升视野范围,更接近人眼的自然视野。顺便吐个槽,目前手机的柔性屏纯粹是为了外形好看搞的噱头。按常识来说,凹面曲有助于扩大视野角度范围,如曲面显示器,但凸面曲对视觉效果提升能有个卵用,只会有负面影响。说白了就是手机屏幕基本发展到极限,厂商们为了竞争只能开始玩各种花活。

总的来说,OLED和Micro LED都能很好的满足VR屏幕的上述要求,会是后面VR发展的重点,技术虽有难点,但都在稳步解决中,相信在1-2年之内就会有更为成熟的产品面世。视觉成像技术不会是VR产业的最大绊脚石,数字影像的内容制作才是关键。

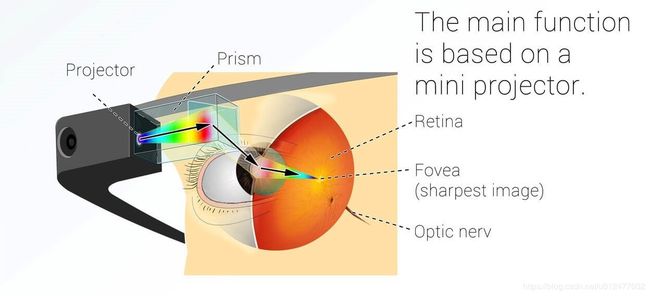

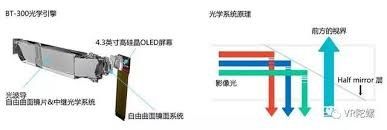

透光的AR/MR

AR/MR产品的根本需求就是虚拟图像与现实图像的叠加,前面说了视频捕捉等技术还不能完美的在虚拟世界实时展示现实图像。那么过渡的技术就是通过透射加反射原理,将现实自然图像与投射出的数字影像进行组合,再由大脑去自行识别内容。

基本原理很好理解,但技术实现起来也是困难重重的。技术大体上可以分为4类,细节上各有优劣。

- 离轴光学

早期是应用在飞行员头盔上的技术,具体的技术细节较复杂,就不细说了,优点是视场大(90度),缺点是体积大。现在的代表产品就是Meta2,基本快赶上VR头盔了。Meta2并不是最先推出市场的AR产品,只是离轴光学技术的发展较早,因此有时会被称为第一代AR成像技术。但因受离轴光学技术影响,此类产品有体积无法缩小的问题,在AR/MR市场的发展普遍不被看好。

![]()

- 棱镜(PBS偏振分光器)

PBS采用偏振分光膜实现光的过滤与组合,技术代表就是Google Glass了,也是市场上见到的最早AR眼镜产品。

我们可以看到棱镜技术眼镜的侧面会伸出一个玻璃块到眼睛前面的位置,用于把侧面的微显示器投影的信息通过偏振分光膜反射到人眼中,同时外界光线的一半 (分光棱镜通常会把自然光对半分开,一半反射、一半透射) 也会以同样的光路进入人眼,这样的话,只要显示信息的内容和位置恰当,就会有和真实世界的东西处在同一个空间位置的感觉,也就是通常所说的叠加感。

棱镜技术的特点是必须以立方体形式呈现,既眼镜的厚度需要与希望显示的图像画面长宽几乎相等,如想要显示2cm*2cm的画面时,则镜片厚度也需要达到2cm。同时由于偏振分光膜对光线角度的选择有较高要求,通常形成的视场角只有15度,造成视觉范围受限,再加上位置偏离正前方,看久了会形成单眼斜视,因此Google Glass的客户体验一直不佳,市场也没有能够有较大发展。

- 自由曲面棱镜

通过自由曲面技术,对立方体棱镜进行了进一步优化。此类产品在设计的过程中通过精密的计算,把原本的立方体表面做成弯曲的表面,甚至膜层也做成弯曲的,最大程度地利用每一个位置的分光效果,以及更好地利用分光膜层,既扩大显示的范围,又不产生体积上的增加,同时也能增大视场角的范围。

自由曲面的代表产品EPSON BT300,视场角达到23度,镜片厚度25mm,相比较Google Glass有了较大的视觉效果进步。但自由曲面棱镜从技术上讲还是对棱镜方案的修修补补,改进有限,并不能像最新的第四代技术那样形成视觉效果的突破。

- 波导技术

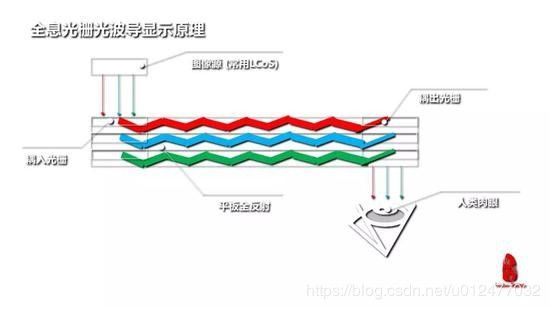

首先说这个波导跟“手机中的战斗机”没任何关系。波导技术的产生是为了解决光的横向传播问题,利用了光的全反射原理。简单地说,就是从玻璃或者塑料这些比空气折射率大的光密介质中,以一个比较大的角度打到内壁上的光线,全部会经过反射继续传播。就像是我们在潜到水下的时候,从某些角度去看水面时,看不到水面以上的物体。这种全反射的方式在平板内部通过“碰壁”方式传播的过程就叫波导传输,平板介质相当于一个传导波的工具,故名“波导”(waveguide)。通信工程中的光纤传输采用的也是相同原理。

目前的波导技术主要分为阵列光波导与全息光栅光波导两类,主要区别如下图所示。阵列光波导相对成熟些,在成像效果、镜片薄厚与透光度等方面占优;而全息光波导的成本是其最大的优势,可以直接使用玻璃或树脂加工制取。

![]()

阵列光波导的代表产品是Magic Leap,而全息光波导则是HoloLens,二者目前都不是很成熟的商用产品。光波导技术代表了AR/MR的短期未来,会在3-5年间有一定发展,但从长期来看,仍然是不透光的视频透视模式会取代这种光学透视模式,毕竟光学透视模式无法形成良好的现实捕捉和虚实合并效果,只能在有限的场景应用,如Pokemon GO这种。

总结

理想很丰满,现实很骨干。3R的技术发展还是任重而道远,拦路虎很多,可概括为硬软两类。“硬”的方面如对计算、存储、网络、体积、能耗这些性能上的限制,需要硬件设备能力的不断进步;“软”的方面如屏显透光、SLAM、图像识别这些,会涉及到光学、材料学、算法、机器学习等多个分支的科学进步,前进方向明确,但道路并不清晰,还有待探索。

再多说一个让人又爱又恨的四维光场投射技术,这是Magic Leap用来吸引了大家7年目光和海量投资的最大亮点,可惜在18年发布Magic Leap One产品的时候跳票了,产品仍然是采用的光波导技术。四维光场的视觉效果描述很诱人,但估计短期内小型产品化够呛。市场是第一位的,Magic Leap再出不来产品投资方就该不干了,但不可否认,他的努力也推动了整个AR的产业发展,衷心希望有一天能见到技术的成熟产品。

最后我们再来看看Magic Leap梦开始的地方,第一台原型机The Beast,由创始人Rony Abovitz在自家车库中搭建。

![]()

人机“交互”

所有的智能终端产品都是要拿给人使用的,人机交互是必须深入考虑的设计内容。将人体也视作一个交互个体,则我们与机器之间的交互手段无非是声光触三类,气味暂时还做不到信息编码的程度,也无法承载较多的信息内容,可以先不做考虑。

交互方式分析

- 先说声音,目前的3R产品在输出方面,声音都不是问题,镜腿组件离耳朵那么近,做个啥扬声器或者配合各种有线无线耳机,都能很好的适配各类使用场景。输入方面则还存在较大的难题,毕竟语音识别技术现在还没有成熟到能包打天下,声音指令的输入准确性有待提升,再加上无声环境和嘈杂环境下的场景干扰(想象一下公共场合下,一群人对着终端喊出各种指令的可怕场景),声音虽然可以作为人机交互的主要输入手段,但也只能成为之一,必须有更广适和更精确的输入手段配合使用。

- 再说光线,也就是图像交互,前文罗里罗嗦了半天,讲的主要都是3R终端在输出时,如何将图像更好的呈现给人体,这里就不再细说。而反向交互的手段,目前主要是通过动作识别,如眼动追踪和手动追踪等方式,来让机器能够了解人的意思。前面也提到过,图像识别是当前技术上的拦路虎,需要AI有较大的发展才能提升准确性。但更重要的目前人类的动作自身无法承载较多的信息元素,虽然有哑语可以表达出部分主要思维意识,但想用手势动作编排一套《长恨歌》基本是不可能的。因此图像交互还是只能限于特定的场景,如玩个游戏,搞搞虚拟训练啥的,很难普及出成熟的商用场景。

- 最后说下触觉,这个是人类当前向机器设备最主要的输出手段,短期内也看不到能有代替手段成熟。键盘、鼠标、手柄、触控板、滑屏等等,都可以认为是人通过物理碰触机器的特定位置形成电信号指令的过程,简单、准确、适用场景丰富。唯一的代价是需要人对碰触规则进行学习和训练,当然这个规则正在逐渐简化,而且广泛适应性也是人类能成长到今天必不可少的基本属性。看看能把微信玩得飞起的老年群体就可以知道,这点儿学习代价根本不是问题,只看个人意愿。

当然在触觉交互中还有些能玩出花儿的配套设备,如VR座舱和踏步场等,看过《头号玩家》或《憨豆特工3》电影的朋友肯定都印象深刻,没看过的现在去大城市的商场里面转转,也能随时体验到此类VR设施。但此类配套设备基本都无法移动,只能适配下VR游戏或电影场景,且真实感严重不足,初次玩玩可以,很少见有人能长期保持兴趣的。

现在的3R主流产品,输入手段都是以触控为主,如Magic Leap One的触控手柄和爱普生的触控主机板。

![]()

走的靠前的是微软的HoloLens,直接采用头瞄加手势识别替代了触控的输入方式,勇气可嘉,但精准度和可操作性市场已经给出了答案。

3R交互小结

小结一下3R产品的人机交互情况,短期内的主流技术发展方向如下:

- 人体输出/机器输入:触控、声音

- 人体输入/机器输出:图像、声音

随着3R产品的成熟,配套的触控输入设备也将成为新兴产业,就像电脑的键盘和鼠标配套产业一样,但短期内还是要看各个智能眼镜厂商自身的配套设计情况。

另外值得一提的是脑电波识别技术的发展,这个一点儿都不科幻,米国早有可以玩俄罗斯方块的商用产品销售了,无非是技术封锁国内搞不到。脑电波技术本质上仍然是信号的捕捉、识别、转译和编码。当然要发展到能配合智能眼镜产品取代触控的交互方式,应该还有很长的一段路要走,个人窃以为HoloLens搞啥手势识别还不如直接上脑电波识别更有前途。

下一代终端

3R的追求不是只做个娱乐设备或者特种装备,未来一定会取代智能Phone/PAD/Notebook/PC/TV等成为一统天下的个人终端。

个人智能终端虽然21世纪初始就出现了黑莓、多普达等厂商的设备,但真正的发展还是源自苹果IPhone系列的问世,更准确的说是自2008年7月发布的IPhone 3G开始,IPhone一代和IPhone2G就是起到个培育市场和试错的作用,IPhone 3G发布了3G数据网络与APP Store这两个大杀器,而高速网络与自由应用正是智能终端与前面那些“能跑些程序的手机”的根本区别。

经过了10年的高速发展,智能终端也进入了另一个趋同性瓶颈。有兴趣的朋友可以做个实验,把目前排名前十的手机厂商主力机型掩盖了商标混在一起,看能分辨出几个来。现在的智能机已经类似于90年代的PC市场,操作系统被苹果和安卓一统天下,手机厂商类似于DELL/HP/联想这些,都是以组装为主,有一定技术能力,但真的都不算啥核心技术。由此来看,在Google Project Ara和Moto Z此类模块化设计的智能机可能发展方向下,手机攒机这种特色行业的再现也不是完全没有可能。

下面我们从需求角度分析下终端设备的发展方向,个人终端的使用目的本质上就是图+音的交互,文字可以理解为一种特定编码图像,视频则是连续图像与声音的组合,因此对终端设备的能力需求也可以简单概括为如何更好的输入和输出声音与图像。

声音需求分析

在当前的声学科技树中,声音的输入输出已经不是问题,无非是怎么编码成更优质的数据和进行更精准的识别,90分到100分的区别。作为理科出身的作者一直对诸如“低音浑厚、和声饱满、音色通透”之类纯主观表述的声音评判方式无感,这种无法使用数学语言建立的结构,都不能纳入现代科学的体系,也终将被时代抛离。人听觉较灵敏的频率范围就是1000-8000Hz,可接受范围就是20-20000Hz(大于20000是超声,小于20为次声),整个听觉过程概括起来就是机械→电→化学→神经冲动→中枢信息处理的过程,除了最终步骤中的中枢合成原理现阶段还不清晰外(跟视觉中枢的影像合成原理不清相同,这也是造成当前美学评判只能纯主观出发的根本原因),前面几个步骤都已经可以很清晰的进行数字量化表述。作为个人终端设备的声音处理,只要能尽量保证采集(除噪、信号扩大等)、传输(编码、压缩等)、输出(解码、振动等)过程中,对原音的精准识别和还原即可。

图像需求分析

对于目前个人终端设备的图像输出来说,清晰度前面讲过已经不是啥问题,视距与像素点大小更关键,同样1920*1080的图像,在6寸和60寸的屏幕上显示,在30cm和300cm距离上观看,用户的最终感受会有很大影响,近小远大是基本的设计依据。Phone/PAD/PC/NOTEBOOK/PC/TV基本上也是随着屏幕的增大,视距也要越来越大。带来的结果就是观看者的身体自由度变化,当看电视时,只要保持身体在电视正面即可,同时可以观察到整个房间的环境;而看手机时,因视距太近,除了要占用人体的重要感知交互器官“手”来握持终端以外,受视线聚焦影响对周边环境的观察能力也基本为零,很容易与环境脱节,造成对人体的安全威胁。

个人终端的图像输入可以分为文字、图片和视频三类,图片和视频基本依赖于摄像头的能力,也是当前各个手机厂商主打的最大卖点。文字的输入则结合手指对设备的指定区域执行指定动作形成电信号,再依靠各种输入法软件识别为文字信息。语音输入转文字则仍困于识别率问题,精度和使用环境受限。手写这种在信息时代仅为照顾部分个体的落后输入方式势必会被淘汰。从习惯发展来看,键盘在可见的未来中仍然是最主要的输入方式,就算HoloLens硬上手势识别,也要在使用者视界中呈现一个虚拟键盘,再捕捉手指动作与虚拟键盘相对位置形成空击,最终完成文字内容的输入。

产品比较

如上所述在个人智能终端的组件中,用于图像输出的屏幕是最为重要的功能部件,同时也是制约着终端整体物理形态发展的最主要因素。但便携性与大屏两个根本需求无法调和,这也是为什么我们现在的生活中会有Phone/PAD/NOTEBOOK/PC/TV这么多块屏共存的根本原因,其实这些智能设备背后的冯诺依曼经典计算机结构都是相同的,软件应用层面也大多是互通的,其本质上的区别就在于屏的大小给人的感受不一,进而产生了不同的使用用途场景。

在可能的一些发展选项中,柔性屏和折叠屏会先被Pass掉。就算平时真能把屏团成团或者叠成豆腐块揣进兜里,但想看的时候还得让屏幕恢复成一个有较大平面面积的实体,那这个实体依然面临着当前智能手机终端使用时遇到的问题,需要用手举着或者找到个可以摆放的桌面。要知道便携性不止是指设备不用的时候,更重要的是在观看时候能拥有方便的放置方式。

另一个有些竞争力的选手是全息投影,场景在各科幻影视作品中大家都已经很熟悉了,空气中直接投放个三维的实体影像出来。技术上现在已经可以部分实现,但关键限制有二:一是空气投也要有类似“屏”的介质存在,不能完全的凭“空”投影,或者是含一定水分的气流墙,或者是含一定氮气与氧气的空气爆,至于要用到全息膜、旋转镜等固态实体的方案就更不提了,都会限制影像显示的位置;二是全息投影首先需要有个全息的影像数据,要采用专门的摄影方式将原始物体的全部三维光学信息采集下来,再做投影,这就限制了影像的数据来源广泛性。至少从目前技术发展来看,有这两个限制,全息投影真正想结合到个人终端中使用,还有漫长的路要走。

再介绍个奇葩的思路,将生活中所有的平面都变成玻璃面,所有的玻璃都成为屏,这样也不用考虑啥终端了,走到哪里都是智能屏幕。先不说导电的问题如何解决(前面介绍过所有的屏幕显示技术都是要靠电子激发发光的),仅是这种被全玻璃包围的生活环境,就能将作者这种更偏好木、皮与金属质感的个体逼疯。

综上所述,能够取代智能手机,与其他终端多屏合一的下一代个人智能终端,只有,也只能是3R为代表的智能眼镜了。关键优势有三:

- 便携性:头部固定,解放双手;

- 大屏:等效100寸屏显示效果;

- 安全性:透光视野,增强现实。

现在智能眼镜自身的计算存储能力还存在不足,很多产品如EPSON BT300、HoloLens、Magic Leap One这些都需要带着个主机,很影响携带性。但随着网络通信能力的提升,大带宽低延迟的5G网络普及,计算存储完全可以放在云端处理,现在如云PC和云游戏等云端应用模式已经开始大量出现。在不远的未来,云+5G+智能眼镜将会成为一统天下的个人智能生活模式。

虽然3R还有很多技术问题亟需解决,但方向正确最为重要。个人认为2019-2020年一定会有革命性的重量级产品面世。注意不是指革命性的技术,而是革命性的产品,类似当年的IPhone 3G。2025年之前百花齐放的各式智能眼镜就会把智能手机打得一败涂地,当然百分百全取代也不太可能,毕竟就是今天也还有在使用非智能手机的用户。

结束语

时代正在不断加速,落后者被抛离也就是一转眼的事情。诺基亚2010年二季度时还占据全球手机销售份额的35%,领先第二名20.8个百分点,而2013年底前就以71亿美元将手机业务打包卖给了微软,2016年微软又以3.5亿美元的价格卖给了富士康。

烈火烹油,鲜花着锦,爬到山顶后往往就剩下坡可走了,区别是要慢慢走下来积蓄力量爬下一个坡,还是认不清现实翻滚下来一蹶不振。十年轮回,智能手机的好日子也将开始倒数,谁会是下一个苹果?谁又会成为下一个诺基亚?