tensorflow学习5:使用tensorboard可视化loss,weight,biases

这一次的可视化任务和上一次的可视化差不多,只是增加了一些可视化项,不仅仅是网络结构。

我们还是在前面搭建的网络结构上进行修改,大家对这个也比较熟悉了。

第一步还是准备数据:

import tensorflow as tf

import numpy as np

#构造数据

x_data = np.linspace(-1,1,300, dtype=np.float32)[:, np.newaxis] #在-1 到 1之间生成300个数据,

noise = np.random.normal(0, 0.05, x_data.shape).astype(np.float32) #增加 noise项目,给数据增加一些波动

y_data = np.square(x_data) - 0.5 + noise #数据的

#采用占位符为变量预定义位置 None 代表后面无论输入多少特征都可以

with tf.name_scope("inputs"):

xs=tf.placeholder(tf.float32,[None , 1],name="x_input")

ys=tf.placeholder(tf.float32,[None , 1],name="y_input")第二步定义网络:

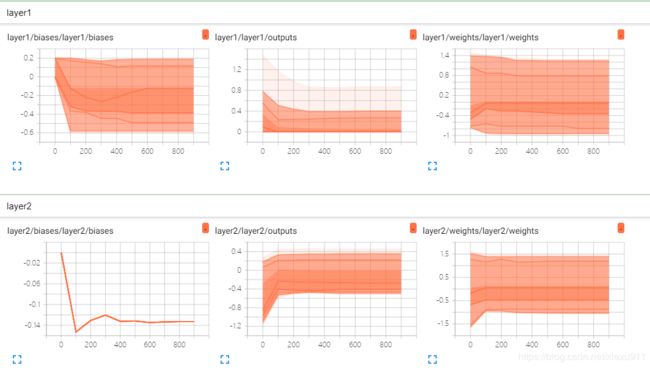

我们要绘制图表主要依赖的是tf.histogram_summary()方法,用来绘制图片, 第一个参数是图表的名称, 第二个参数是图表要记录的变量。在每一个要记录的变量下使用这个函数。

def add_layer(inputs , in_size, out_size,n_layer, activation_function=None):

## add one more layer and return the output of this layer

layer_name='layer%s'%n_layer

with tf.name_scope(layer_name):

with tf.name_scope('weights'):

Weights= tf.Variable(tf.random_normal([in_size, out_size]),name='W')

tf.summary.histogram(layer_name + '/weights', Weights) # tensorflow >= 0.12

with tf.name_scope('biases'):

biases = tf.Variable(tf.zeros([1,out_size])+0.1, name='b')

tf.summary.histogram(layer_name + '/biases', biases) # Tensorflow >= 0.12

with tf.name_scope('Wx_plus_b'):

Wx_plus_b = tf.add(tf.matmul(inputs,Weights), biases)

if activation_function is None:

outputs=Wx_plus_b

else:

outputs= activation_function(Wx_plus_b)

tf.summary.histogram(layer_name + '/outputs', outputs) # Tensorflow >= 0.12

return outputs第三步定义网络和loss可视化:

可视化loss使用的是和前面不同的方式tf.scalar_summary()

#build network

#构建一个输入层一个神经元,隐含层都是10个神经元,输出层1个神经元的神经网络

l1=add_layer(xs,1,10,n_layer=1,activation_function=tf.nn.relu)

prediction=add_layer(l1,10,1,n_layer=2)

#定义损失函数

with tf.name_scope("loss"):

loss = tf.reduce_mean(tf.reduce_sum(tf.square(ys - prediction),reduction_indices=[1]))

tf.summary.scalar("loss",loss)

#定义优化器

optimizer=tf.train.AdamOptimizer(0.1).minimize(loss)

#初始化变量

init=tf.global_variables_initializer()第四步就是运行网络,并合并各个图:

使用tf.summary.merge_all() 对不同的图进行合并,merge 也是必须要运行才会生效。我们每隔一百次就使用merge记录一下数据,如果不是不停的记录数据,最后也是没有图出来的。

#定义好各种运算操作后,放到Session中进行

with tf.Session() as sess:

sess.run(init) # 变量一定要进行初始化

merged = tf.summary.merge_all()

writer = tf.summary.FileWriter("loss_log/", sess.graph)

for i in range(1000):

sess.run(optimizer,feed_dict={xs:x_data,ys:y_data}) #训练对应的优化器

if i%100==0:

print(sess.run(loss, feed_dict={xs: x_data, ys: y_data}))

rs = sess.run(merged,feed_dict={xs:x_data,ys:y_data})

writer.add_summary(rs, i)

#每一百步打印一下对应的损失

效果:

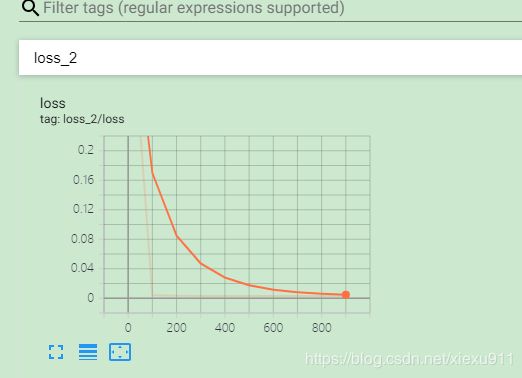

loss:

weight、biases:

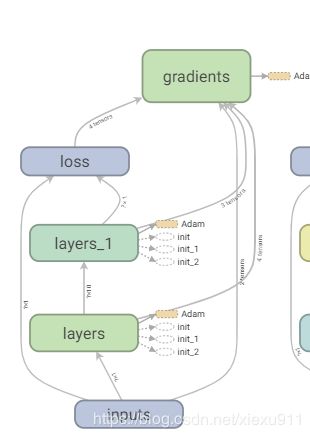

网络结构: