zookeeper

一.概述

1.概述

Zookeeper 是一个开源的分布式的,为分布式应用提供协调服务的 Apache 项目。

Zookeeper 从设计模式角度来理解:是一个基于观察者模式设计的分布式服务管理框架,

它负责存储和管理大家都关心的数据,然后接受观察者的注册,一旦这些数据的状态发生变

化,Zookeeper 就将负责通知已经在 Zookeeper 上注册的那些观察者做出相应的反应,从而

实现集群中类似 Master/Slave 管理模式

Zookeeper=文件系统+通知机制

2.特点

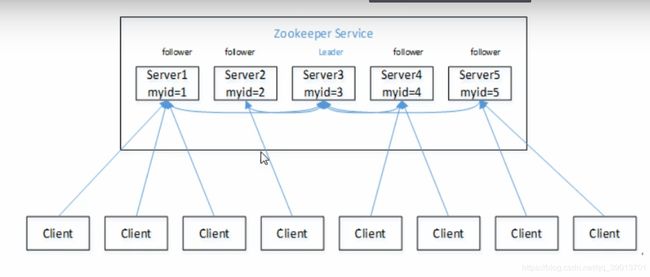

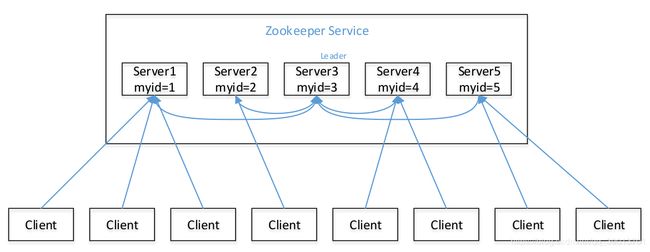

- Zookeeper:一个领导者(leader),多个跟随者(follower)组成的集群。

- Leader 负责进行投票的发起和决议,更新系统状态

- Follower 用于接收客户请求并向客户端返回结果,在选举 Leader 过程中参与投票

- 集群中只要有半数以上节点存活,Zookeeper 集群就能正常服务。

- 全局数据一致:每个 server 保存一份相同的数据副本,client 无论连接到哪个 server,数据都是一致的。

- 更新请求顺序进行,来自同一个 client 的更新请求按其发送顺序依次执行。

- 数据更新原子性,一次数据更新要么成功,要么失败。

- 实时性,在一定时间范围内,client 能读到最新数据。

3.数据结构

ZooKeeper 数据模型的结构与 Unix 文件系统很类似,整体上可以看作是一棵树,每个

节点称做一个 ZNode。

很显然 zookeeper 集群自身维护了一套数据结构。这个存储结构是一个树形结构,其上

的每一个节点,我们称之为"znode",每一个 znode 默认能够存储 1MB 的数据,每个 ZNode

都可以通过其路径唯一标识

4.应用场景

提供的服务包括:分布式消息同步和协调机制、服务器节点动态上下线、统一配置管理、

负载均衡、集群管理等。

二.Zookeeper 安装

2.1 本地模式安装部署

安装前准备:

(1)安装 jdk

(2)通过 filezilla 工具拷贝 zookeeper 到到 linux 系统下

(3)解压到指定目录

[atguigu@hadoop102 software]$ tar -zxvf zookeeper-3.4.10.tar.gz -C /opt/module/

配置修改

将/opt/module/zookeeper-3.4.10/conf 这个路径下的 zoo_sample.cfg 修改为 zoo.cfg;

进入 zoo.cfg 文件:vim zoo.cfg

修改 dataDir 路径为

dataDir=/opt/module/zookeeper-3.4.10/zkData

在/opt/module/zookeeper-3.4.10/这个目录上创建 zkData 文件夹

mkdir zkData

操作 zookeeper

(1)启动 zookeeper

[atguigu@hadoop102 zookeeper-3.4.10]$ bin/zkServer.sh start

(2)查看进程是否启动

[atguigu@hadoop102 zookeeper-3.4.10]$ jps

4020 Jps

4001 QuorumPeerMain

(3)查看状态:

[atguigu@hadoop102 zookeeper-3.4.10]$ bin/zkServer.sh status

ZooKeeper JMX enabled by default

Using config: /opt/module/zookeeper-3.4.10/bin/…/conf/zoo.cfg

Mode: standalone

(4)启动客户端:

[atguigu@hadoop102 zookeeper-3.4.10]$ bin/zkCli.sh

(5)退出客户端:

[zk: localhost:2181(CONNECTED) 0] quit

(6)停止 zookeeper

[atguigu@hadoop102 zookeeper-3.4.10]$ bin/zkServer.sh stop

2.2 配置参数解读

解读zoo.cfg 文件中参数含义

1)tickTime:通信心跳数,Zookeeper服务器心跳时间,单位毫秒

Zookeeper使用的基本时间,服务器之间或客户端与服务器之间维持心跳的时间间隔,

也就是每个tickTime时间就会发送一个心跳,时间单位为毫秒。

它用于心跳机制,并且设置最小的session超时时间为两倍心跳时间。(session的最小超

时时间是2*tickTime)

2)initLimit:LF初始通信时限

集群中的follower跟随者服务器(F)与leader领导者服务器(L)之间初始连接时能容忍的最

多心跳数(tickTime的数量),用它来限定集群中的Zookeeper服务器连接到Leader的时限。

投票选举新leader的初始化时间

Follower在启动过程中,会从Leader同步所有最新数据,然后确定自己能够对外服务的

起始状态。

Leader允许F在initLimit时间内完成这个工作。

3)syncLimit:LF 同步通信时限

集群中Leader与Follower之间的最大响应时间单位,假如响应超过syncLimit * tickTime,

Leader认为Follwer死掉,从服务器列表中删除Follwer。

在运行过程中,Leader负责与ZK集群中所有机器进行通信,例如通过一些心跳检测机

制,来检测机器的存活状态。

如果L发出心跳包在syncLimit之后,还没有从F那收到响应,那么就认为这个F已经不在

线了。

4)dataDir:数据文件目录+数据持久化路径

保存内存数据库快照信息的位置,如果没有其他说明,更新的事务日志也保存到数据

库。

5)clientPort:客户端连接端口

监听客户端连接的端口

三.Zookeeper 内部原理

3.1 选举机制

1)半数机制(Paxos 协议):集群中半数以上机器存活,集群可用。所以 zookeeper

适合装在奇数台机器上。

2)Zookeeper 虽然在配置文件中并没有指定 master 和 slave。但是,zookeeper 工作时,

是有一个节点为 leader,其他则为 follower,Leader 是通过内部的选举机制临时产生的

3)以一个简单的例子来说明整个选举的过程。

假设有五台服务器组成的 zookeeper 集群,它们的 id 从 1-5,同时它们都是最新启动的,

也就是没有历史数据,在存放数据量这一点上,都是一样的。假设这些服务器依序启动,来

看看会发生什么。

(1)服务器 1 启动,此时只有它一台服务器启动了,它发出去的报没有任何响应,所

以它的选举状态一直是 LOOKING 状态。

(2)服务器 2 启动,它与最开始启动的服务器 1 进行通信,互相交换自己的选举结果,

由于两者都没有历史数据,所以 id 值较大的服务器 2 胜出,但是由于没有达到超过半数以

上的服务器都同意选举它(这个例子中的半数以上是 3),所以服务器 1、2 还是继续保持

LOOKING 状态。

(3)服务器 3 启动,根据前面的理论分析,服务器 3 成为服务器 1、2、3 中的老大,

而与上面不同的是,此时有三台服务器选举了它,所以它成为了这次选举的 leader。

(4)服务器 4 启动,根据前面的分析,理论上服务器 4 应该是服务器 1、2、3、4 中最

大的,但是由于前面已经有半数以上的服务器选举了服务器 3,所以它只能接收当小弟的命

了。

(5)服务器 5 启动,同 4 一样当小弟。

3.2 节点类型

Znode 有两种类型:

- 短暂(ephemeral):客户端和服务器端断开连接后,创建的节点自己删除

- 持久(persistent):客户端和服务器端断开连接后,创建的节点不删除

Znode 有四种形式的目录节点(默认是 persistent )

- 持久化目录节点(PERSISTENT)

客户端与 zookeeper 断开连接后,该节点依旧存在 - 持久化顺序编号目录节点(PERSISTENT_SEQUENTIAL)

客户端与 zookeeper 断开连接后,该节点依旧存在,只是 Zookeeper 给该节点名称

进行顺序编号 - 临时目录节点(EPHEMERAL)

客户端与 zookeeper 断开连接后,该节点被删除 - 临时顺序编号目录节点(EPHEMERAL_SEQUENTIAL)

客户端与 zookeeper 断开连接后,该节点被删除,只是 Zookeeper 给该节点名称进

行顺序编号