阿里达摩院:超大规模图神经网络系统将赋予机器常识

https://www.toutiao.com/a6650053814835479053/

2019-01-24 21:25:21

看看你自己的生活,你的职业选择,你与配偶的邂逅,你被迫离开故土,你面临的背叛,你突然的致富或潦倒,这些事有多少是按照计划发生的。

——《黑天鹅》纳西姆·尼古拉斯·塔勒布人工智能的脉络

机器学习是人工智能的一个分支。

人工智能的研究历史有着一条从以“推理”为重点,到以“知识”为重点,再到以“学习”为重点的自然、清晰的脉络。

机器学习是实现人工智能的一个途径,即以机器学习为手段解决人工智能中的问题。

从学习方式来讲,机器学习包括监督式学习、非监督式学习、半监督式学习和强化学习。

以算法来分类,则有回归算法、基于实例的算法、正则化方法、决策树学习、贝叶斯方法、基于核的算法、聚类算法、关联规则学习、遗传算法、人工神经网络、深度学习、降低维度算法和集成算法。

因此,深度学习又是机器学习的分支。

深度学习是一种以人工神经网络为架构,对数据进行表征学习的算法。

如今,单纯的深度学习已经成熟,结合了深度学习的图神经网络将端到端学习与归纳推理相结合,有望解决深度学习无法处理的关系推理、可解释性等一系列问题。

强大的图神经网络将会类似于由神经元等节点所形成网络的人的大脑,机器有望成为具备常识,具有理解、认知能力的AI。

机器阅读和理解人类语言

比尔·盖茨曾经发表过对人工智能的一些看法,他认为人工智能会有惊人的影响,并且大多都是好的。

比如帮助学生,帮助查看分析图像,帮助我们了解发生了什么。

同时他也提出,人工智能还有一件事还不能实现,而一旦实现,将帮助人们解决更多的难题,这一点就是:阅读。

“所有相关的公司都在努力实现这一点,比如有一本生物学的书,人工智能会不会阅读它,然后通过考试或者操作一项实验。这是最后一个难题,目前视力问题解决了,语言能力也不错,甚至翻译也很好,现在我们都在攻克阅读问题。一旦有了阅读能力,就可以帮助科学发明,这将会非常了不起,可以更好地帮助人们解决问题。人工智能势头很猛,发展比我们预期的更快,像那场围棋比赛的结果,就是一个惊人的里程碑。”

是的,让机器正确理解人类知识和语言的技术比起图片和声音识别技术来说更加困难。

一是因为人类语言的“余地”,语言作为一种表达方式,是非常偏向于模糊和不确定的。

二是因为人类语言会因环境变化而变化,对它的理解多数是通过当时情境的作用,而这一点又让语言理解的复杂程度加倍,机器是难以标记和模拟相关环境的。

尽管互联网上已经包含了足够多的语言文字信息,我们还是无法以机器能够理解的形式将这些信息真正传递给它们。

因此,比尔·盖茨认为让机器学会阅读和理解人类语言是一个里程碑式事件,而微软、谷歌、Facebook和IBM等公司也在发力机器学习阅读理解能力。

从某种意义上来讲,我的理解是,机器阅读人类语言应该也是从弱人工智能到强人工智能跨越的标志之一。

机器理解和创造自己

随着越来越多的这类技术变得成熟,机器将会在各种各样的任务上超越人类。

那么,机器是否可以理解自己呢?甚至机器是否可以设计和编码自己本身呢?

可以想象一下,一旦机器做到这一步,那将会带来什么样的颠覆。

Google Brain团队在探索这个领域,他们称之为“自动机器学习”方向。

顶尖的人工智能专家们发现,设计机器学习系统本身这样一个他们最困难的工作之一,也有可能通过AI系统自动完成。

甚至在一些场景下,AI系统自己开发的AI系统已经赶上甚至超过了人类专家。

国外著名科技记者 Steven Levy 在他刊于 BackChannel 的文章《谷歌如何将自己重塑为一家“机器学习为先”的公司》中提到,谷歌大脑负责人 Jeff Dean 表示,如果现在让他改写谷歌的基础设施,大部分代码都不会由人编码,而将由机器学习自动生成。

学术界也有相关研究,伯克利的 Ke Li 和 Jitendra Malik 在他们日前提交的论文《Learning to Optimize》中提出了让算法自我优化的方法。

他们在论文摘要中写道,“算法设计是一个费力的过程,通常需要许多迭代的思想和验证。 在本文中,我们探讨自动化算法设计,并提出了一种方法学习自动优化算法”。

从强化学习的角度入手,Ke Li 和 Jitendra Malik 使用指导性策略搜索来让 AI 学习优化算法,并且证明了他们所设计的算法在收敛速度和/或最终目标值方面优于现有的手工编程开发的算法。

机器的元认知

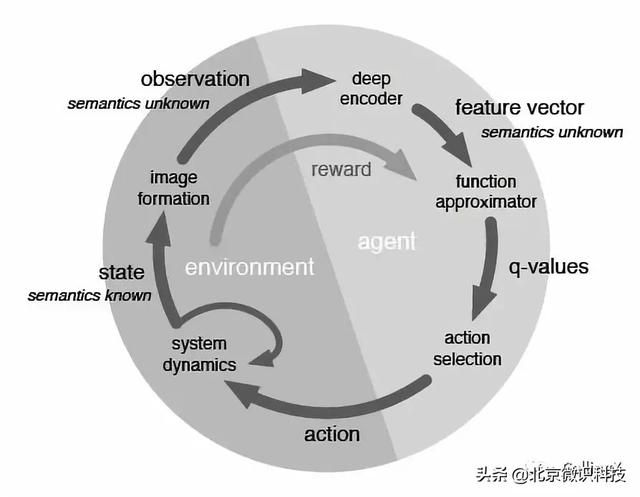

我们正在通过强化学习,打造能学习和推理的机器。

近年来,深加强学习(RL)系统已经在许多富有挑战性的任务领域中获得了超人的性能,这种应用的主要限制是它们对大量训练数据的需求。

因此,突破的关键在于开发可以快速适应新任务的DRL方法:在一个使用RL算法训练的系统中内置另一个完全独立的RL过程,这是一种独立的、习得的算法。

而RL其实就是一个连续决策的过程。

传统的机器学习的局限来自于我们自身,我们会对其给定一些标注数据,这些标注作为supervisor,学习一个好的函数,来对未知数据作出很好的决策,但是实际上更多的时候人们并不知道标注是什么,因为我们一开始不知道什么是“好”的结果。

相较于此,RL不是给定标注,而是给一个回报函数,这个回报函数决定当前状态得到什么样的结果(“好”还是“坏”), RL的数学本质是一个马尔科夫决策过程,心理学依据则是行为心理学,而它最终的目的是决策过程中整体的回报函数期望最优。

所以RL的过程带有一定的随机性,其决策的每一步的选择都不是确定的,而是在一个概率分布中采样出来的结果。

玩游戏

我们用玩游戏来说明我们是怎么让机器自己学会一件事情的。

人类玩游戏的过程:

- 游戏开始,初始设定。

- 游戏场景变化,眼睛捕捉到画面变化,将视觉信号回传到脑皮层。

- 脑皮层将视觉信号转化为语义信息,通过以往经验进行决策,将操作信号传递到手指动作。

- 操作结束,失败卡关或者游戏场景进入下一帧并得到回报。

- 循环,直至游戏结束。

以此再往下分解每一个步骤,并且给机器设置每一步骤动作,即可。

我认为,这里有两点比较关键。

首先,我们意识到原来人类在玩游戏或者日常决策中也并不总是处于awareness的状态,我们并不一定知道其内部的原理,只要知道下一步怎么做“是对的”,因此我们对机器的设置就变得并不那么困难的。

其次,我们在这样的决策过程中利用了回报函数而不是固定的值,这就需要我们容忍一定程度的错误概率,或者更准确地说是认识到自己的认知局限,改由比经验或者是“常理”更靠谱的决策机制,引用了马尔科夫决策过程来让机器“自己找到最优控制策略”。

行文至此忽然有一种感觉,我们真的是不遗余力地在改进着AI这个最贴近自身的创造物并对之倾注了满腔热情。

或许,这也是人类连接自己与世界的一种方式。

我们渴望与自身的神秘起源对话,渴望触及那些我们无法了解的真相和法则,并为此不断追寻。