liunx与大数据常用命令

hadoop常用命令

启动一个MR任务

bin/hadoop jar /home/chinahadoop/software/hadoop-2.7.4/share/hadoop/mapreduce/hadoop-mapreduce-examples-2.7.4.jar pi 2 10

Hadoop fs –ls

Hadoop fs –put 文件(某文件路径下的文件) 文件(某文件下的文件)

查询

hadoop job -list

hadoop job -kill job_1532599477759_0001

hadoop fs

查看Hadoop HDFS支持的所有命令

hadoop fs -ls /

列出目录及文件信息

hadoop fs -lsr /

循环列出目录、子目录及文件信息

hadoop fs -put test.txt /user/sunlightcs

将本地文件系统的test.txt复制到HDFS文件系统的/user/sunlightcs目录下

hadoop fs -get /user/sunlightcs/test.txt .

将HDFS中的test.txt复制到本地文件系统中,与-put命令相反

hadoop fs -cat /user/sunlightcs/test.txt

查看HDFS文件系统里test.txt的内容

hadoop fs -tail /user/sunlightcs/test.txt

查看最后1KB的内容

hadoop fs -rm /user/sunlightcs/test.txt

从HDFS文件系统删除test.txt文件,rm命令也可以删除空目录

hadoop fs -rmr /user/sunlightcs

删除/user/sunlightcs目录以及所有子目录

hadoop fs -copyFromLocal test.txt /user/sunlightcs/test.txt

从本地文件系统复制文件到HDFS文件系统,等同于put命令

hadoop fs -copyToLocal /user/sunlightcs/test.txt test.txt

从HDFS文件系统复制文件到本地文件系统,等同于get命令

hadoop fs -chgrp [-R] /user/sunlightcs

修改HDFS系统中/user/sunlightcs目录所属群组,选项-R递归执行,跟linux命令一样

hadoop fs -chown [-R] /user/sunlightcs

修改HDFS系统中/user/sunlightcs目录拥有者,选项-R递归执行

hadoop fs -chmod [-R] MODE /user/sunlightcs

修改HDFS系统中/user/sunlightcs目录权限,MODE可以为相应权限的3位数或+/-{rwx},选项-R递归执行

hadoop fs -count [-q] PATH

查看PATH目录下,子目录数、文件数、文件大小、文件名/目录名

hadoop fs -cp SRC [SRC …] DST

将文件从SRC复制到DST,如果指定了多个SRC,则DST必须为一个目录

hadoop fs -du PATH

显示该目录中每个文件或目录的大小

hadoop fs -dus PATH

类似于du,PATH为目录时,会显示该目录的总大小

hadoop fs -expunge

清空回收站,文件被删除时,它首先会移到临时目录.Trash/中,当超过延迟时间之后,文件才会被永久删除

hadoop fs -getmerge SRC [SRC …] LOCALDST [addnl]

获取由SRC指定的所有文件,将它们合并为单个文件,并写入本地文件系统中的LOCALDST,选项addnl将在每个文件的末尾处加上一个换行符

hadoop fs -touchz PATH

创建长度为0的空文件

hadoop fs -test -[ezd] PATH

对PATH进行如下类型的检查:

-e PATH是否存在,如果PATH存在,返回0,否则返回1

-z 文件是否为空,如果长度为0,返回0,否则返回1

-d 是否为目录,如果PATH为目录,返回0,否则返回1

hadoop fs -text PATH

显示文件的内容,当文件为文本文件时,等同于cat,文件为压缩格式(gzip以及hadoop的二进制序列文件格式)时,会先解压缩

hadoop fs -help ls

查看某个[ls]命令的帮助文档

Hadoop操作命令

通过hadoop bin包下 激活nn1节点

bin/hdfs haadmin -transitionToActive nn1

Linux 命令

ssh-keygen:linux环境生成秘钥

ssh-copy-id root(当前登录用户)@chinahadoop2(表示root要登录的环境

这里表示root @登录chinahadoop2 环境)

rsync chinahadoop@chinahadoop2:~/software/hadoop-2.7.4.tar softwart/

表示:

把 chinahadoop2 虚拟机上/home/chinahadoop/software/目录下的 hadoop-2.7.4.tar.gz 文件,拷贝到 chinahadoop1(这里表示当前环境的hostname中配置的名称也可以说当前机器)

虚拟机的/home/chinahadoop/software/目录下。

rsync -r hadoop software chinahadoop2(表示其他机器):~ (~表示其他机器的home目录 执行这条命令表示把当前的文件夹同步到其他机器上)

把目录 software 和 hadoop/ha 以及 hadoop 压缩包全部拷贝到其他机器上。

tar 命令解压

tar zxvf ***.tar.gz

关于linux 环境变量配置

/etc/profile设置的内容所有用户都会执行到,~/.bashrc只有当前用户才会用到

公用的设置在/etc/profile里,单个用户的设置在~/.bash_profile里

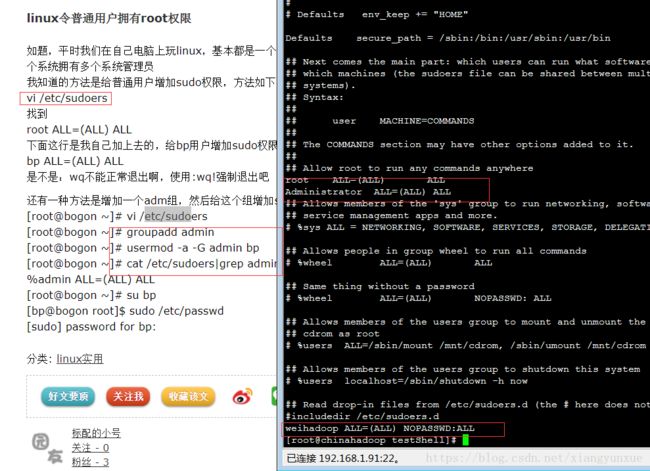

liunx 查看权限

只有管理员root可以查看/etc/shadow文件

root@ubuntu:/home/linlin/linlin# ls -l /etc/shadow

cat /etc/sysconfig/network

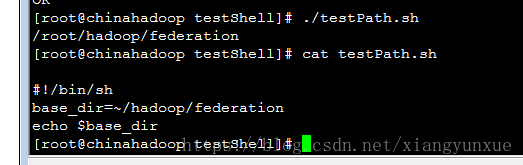

linux 对于~/hadoop是哪个目录

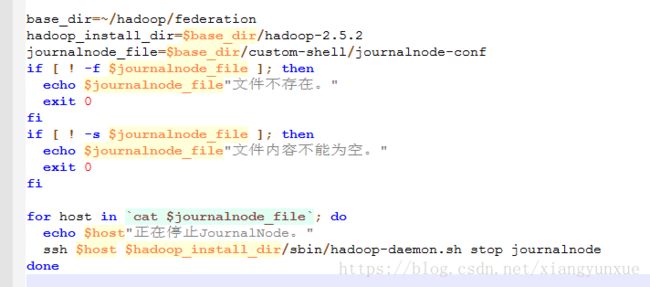

shell 基本写法

if ....; then

....

elif ....; then

....

else

....

fi

[ -f "somefile" ] :判断是否是一个文件

[ -x "/bin/ls" ] :判断/bin/ls是否存在并有可执行权限

[ -n "$var" ] :判断$var变量是否有值

[ "$a" = "$b" ] :判断$a和$b是否相等

-r file 用户可读为真

-w file 用户可写为真

-x file 用户可执行为真

-f file 文件为正规文件为真

-d file 文件为目录为真

-c file 文件为字符特殊文件为真

-b file 文件为块特殊文件为真

-s file 文件大小非0时为真

-t file 当文件描述符(默认为1)指定的设备为终端时为真

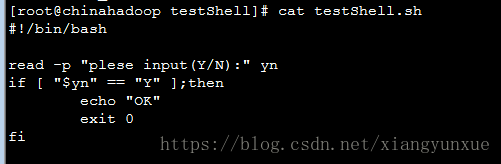

含条件选择的shell脚本 对于不含变量的任务简单shell脚本一般能胜任。但在执行一些决策任务时,就需要包含if/then的条件判断了。shell脚本编程支持此类运算,包括比较运算、判断文件是否存在等。

基本的if条件命令选项有: - eq —比较两个参数是否相等(例如,if [ 2 –eq 5 ])

-ne —比较两个参数是否不相等

-lt —参数1是否小于参数2

-le —参数1是否小于等于参数2

-gt —参数1是否大于参数2

-ge —参数1是否大于等于参数2

-f — 检查某文件是否存在(例如,if [ -f "filename" ])

-d — 检查目录是否存在

几乎所有的判断都可以用这些比较运算符实现。脚本中常用-f命令选项在执行某一文件之前检查它是否存在

echo: 表示输出

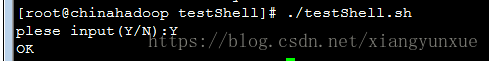

read -p "plese input(Y/N):" yn 表示输出打印

$yn 表示 键盘enter键