Win10+MySQL5.5+Hadoop2.7.1+hive2.1.1+JDK1.8大数据环境配置-小白指南

写在前面:(必看!!!)下载软件之前一定要查一下版本适配!!!特别是JDK,不要像我一样配置环境都花了四五天!!(我开始安装的是jdk12,倒腾了好久,一直报错。。。只能卸载重装)

1.准备工作:

JDK环境:jdk1.8.0_201

MySQL数据库:MySQL Server 5.5

Hadoop:hadoop-2.7.1

hive:apache-hive-2.1.1-bin

(最好不要用太高的版本的软件,不然报错了都找不到解决办法,只能反反复复卸载重装!!)

2.安装Java及环境变量

(教程自行百度,注意不要下载较高版本,后面报错很麻烦,可以参考我的版本)

3.安装MySQL

(教程自行百度,注意不要下载较高版本,后面报错很麻烦,可以参考我的版本)

4.安装Hadoop

(参考教程如下:解压的时候要以管理员身份运行WinRAR)

Win10不需要Cygwin搭建大数据测试环境(1)-Hadoop

(因为Hadoop本来是在Linux上运行的,这里需要下载一个winutil来模拟这个环境,连接如下:)

hadoop各版本hadoop.dll和winutils.exe下载

HDFS:Hadoop之HDFS上测试创建目录、上传、下载文件 - 小小码农 - CSDN博客

集群详解:Hadoop(四)HDFS集群详解 - jstarseven - 博客园

5.安装hive

(参考教程如下:)

hive2.1.1 + hadoop2.8.0 + windows7(不用cygwin)搭建Hive

Win10不需要Cygwin搭建大数据测试环境(4)---Hive

Hive安装-window - F7ANTY的专栏 - CSDN博客

6.hive操作简单教程

Hive学习之路

希望你安装顺利!!!!!

如果不顺利的话请看下面的能不能解决你的问题:

1、MySQL服务拒绝访问>>>>>>>报错:拒绝访问。发生系统错误 5。

解决办法:以管理员身份运行CMD!

2、在修改hive-site.xml文件中的数据库连接密码时,MySQL使用root用户,此时密码不可为空。

3、hive报错>>>com.mysql.cj.exceptions.InvalidConnectionAttributeException:The server time zone value...

Caused by: com.mysql.cj.exceptions.InvalidConnectionAttributeException: The server time zone value '???ú±ê×??±??' is unrecognized or represents more than one time zone.

解决办法:

jdbc:mysql://localhost:3306/hive?characterEncoding=UTF-8&serverTimezone=UTC

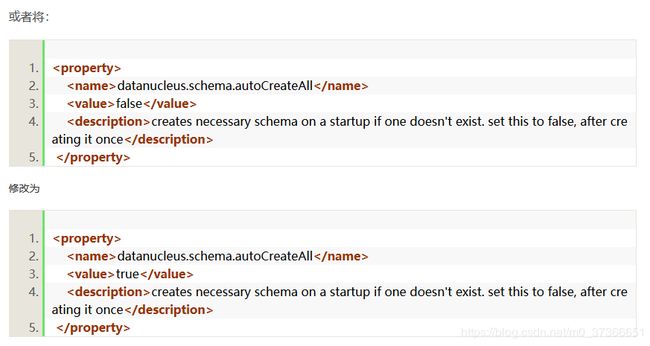

4、hive报错>>>>Required table missing : "`TBLS`" in Catalog "" Schema "". DataNucleus requires this table to perform its persistence operations. Either your MetaData is incorrect, or you need to enable "datanucleus.schema.autoCreateTables"

5、软件的版本相当重要,MySQL5和MySQL8的语法就可能不同,一直报错。

6、配置文件中的修改内容直接在源文件上修改而不要复制粘贴,需要将以前的配置信息删除。

7、hive报错: Specified key was too long; max key length is 767 bytes

hive报错: Specified key was too long; max key length is 767 bytes(详解!!!)

暂时写这么多了,纪念一下从4.4搭到现在才搭好的环境吧~ 大家有什么问题多多交流,一定注意下载的文件的版本!!!