Spark MLlib 环境搭建超详细教程

文章目录

- 1、系统及环境版本

- 2、环境下载

- 2.1 Spark 下载

- 2.2 hadooponwindos 下载

- 2.3 Hadoop 下载

- 2.4 JDK下载

- 2.5 IntelliJ IDEA

- 2.6 scala 下载

- 2.7 IntelliJ-scala plug 下载

- 3、环境配置

- 3.1 JAVA环境配置:

- 3.2 Hadoop环境配置

- 3.3 Spark环境配置

- 3.4 Scala环境配置

- 4、IDE的配置

- 4.1创建新项目

- 4.2 选择Project SDK

- 4.3 安装scala插件

- 4.4 重启IntelliJ

- 4.5 添加spark library

- 4.6 建一个Sparkdemo 的object

- 4.7 ctrl+shift+F10运行!

1、系统及环境版本

系统:Win7 旗舰版 64位 sp1

JDK:1.8.0

Spark:2.3.2

Hadoop:2.7

Scala:2.11.8

2、环境下载

2.1 Spark 下载

http://spark.apache.org/downloads.html

2.2 hadooponwindos 下载

https://github.com/sardetushar/hadooponwindows

2.3 Hadoop 下载

https://archive.apache.org/dist/hadoop/core/hadoop-2.7.1/

2.4 JDK下载

略

2.5 IntelliJ IDEA

http://www.jetbrains.com/idea/download/#section=windows

注意选择版本

2.6 scala 下载

https://www.scala-lang.org/download/2.11.8.html

2.7 IntelliJ-scala plug 下载

http://plugins.jetbrains.com/plugin/1347-scala

选择版本下载,下载完毕之后,应该有以下7个文件:

3、环境配置

安装ideaIC-2017.3.5.exe。

除了scala-intelliJ-bin-2017.3.15不需要解压外,其他能解压的都需要解压。

重要:配置之前,需要把2.2中的bin文件夹替换掉2.3中的bin文件夹

重要:配置之前,需要把2.2中的bin文件夹替换掉2.3中的bin文件夹

重要:配置之前,需要把2.2中的bin文件夹替换掉2.3中的bin文件夹

重要的事说三遍!

3.1 JAVA环境配置:

JAVA_HOME:java所在的目录,注意不是bin目录

PATH:%JAVA_HOME%\bin

ClassPath:%JAVA_HOME%\lib;%JAVA_HOME%\lib\tools.jar

3.2 Hadoop环境配置

HADOOP_HOME:hadoop解压的目录

Path:%HADOOP_HOME%\bin

3.3 Spark环境配置

SPARK_HOME:spark解压的目录

Path:%SPARK_HOME%\bin

3.4 Scala环境配置

SCALA_HOME:scala解压的目录

Path:%SCALA_HOME%\bin

4、IDE的配置

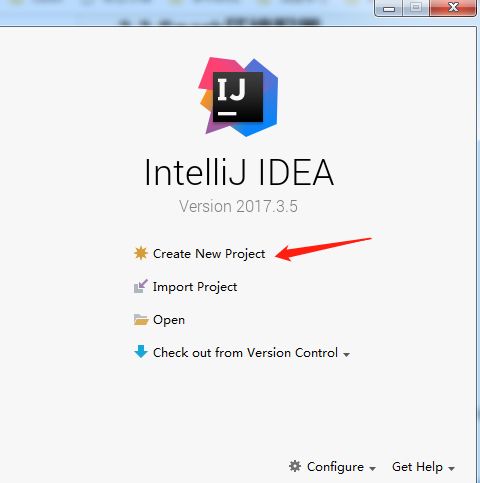

4.1创建新项目

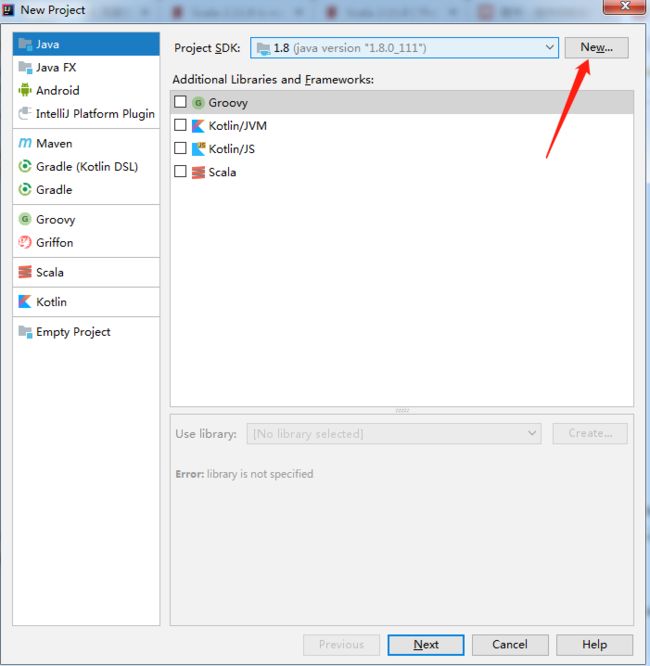

4.2 选择Project SDK

next>next>finesh!

此时可以看到 external library只有一个jdk1.8

4.3 安装scala插件

4.4 重启IntelliJ

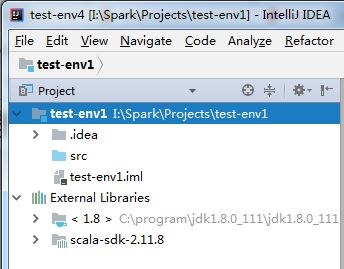

选择scala的解压的目录,我原来装过一个2.11.12版本的,所以,我这里会有两个版本,应该选择2.11.8版本。

4.5 添加spark library

此时,新建项目之后可以看到,external libraryes 出现了 jdk1.8 和scala sdk。

我们最后再添加spark library

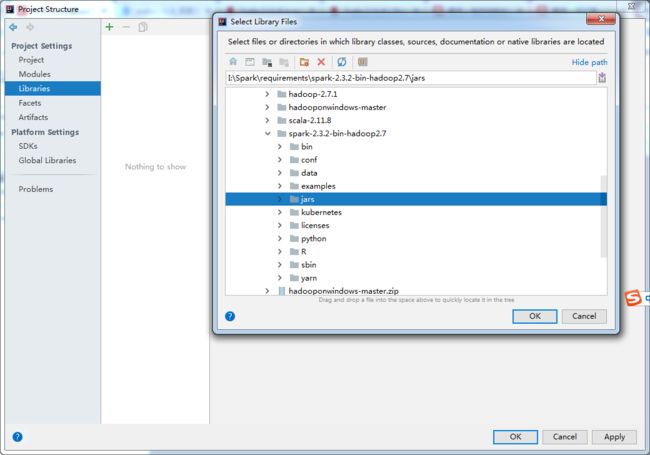

file>project structure

Libraries > +

之后添加解压后的spark下的jars

最终可以看到External Libraries出现了三个。

4.6 建一个Sparkdemo 的object

import org.apache.spark._

object SparkDemo {

def main(args: Array[String]): Unit = {

val masterUrl = "local[1]"

val conf = new SparkConf().setAppName("helenApp").setMaster(masterUrl)

val sc = new SparkContext(conf)

val rdd = sc.parallelize(List(1, 2, 3, 4, 5, 6)).map(_ * 3)

rdd.filter(_ > 10).collect().foreach(println)

println(rdd.reduce(_ + _))

println("hello world")

}

}

4.7 ctrl+shift+F10运行!

小白记录,大佬勿喷!

简书链接:https://www.jianshu.com/p/9f40fe1b6587

所有软件,打包下载,不用再去折腾版本之间的问题。

下载链接:

https://download.csdn.net/download/xxubing123/10922008

参考文章:

https://blog.csdn.net/weixin_42596381/article/details/81006544