Kubernetes集群二进制部署(一)——Etcd数据库群集功能部署、flannel网络组建

文章目录

- 节点环境规划

- 软件包

- 一、部署Etcd

- 1、制作证书

- ① 创建工作目录

- ② 安装制作证书的工具cfssl

- ③ 编辑etcd证书创建的脚本

- ④ 生成ca证书的配置文件,定义ca证书

- ⑤ 创建ca证书的签名证书

- ⑥ 生成证书(生成ca-key.pem密钥证书 ca.pem证书)

- ⑦ 指定etcd三个节点之间的通信验证(需要服务器签名证书 server-csr.json)

- 2、搭建etcd集群

- ① master节点部署etcd

- ② node节点加入ETCD集群(实现内部通信)

- ③ 检查群集状态

- ④ 问题

- 二、Docker引擎部署

- 三、flannel网络配置

- 1、写入分配的子网段到etcd,供flanneld使用

- 2、部署与配置flannel

- 3、配置Docker连接flannel网络

- 4、验证容器间flannel网络互通

节点环境规划

Master节点可以使用CPU:2+内存 :2+硬盘:20G

Node节点需要跑业务,可以使用CPU:4+内存:4+硬盘:20G

| 服务器 | IP | 安装软件 |

|---|---|---|

| Master | 192.168.11.11 | kube-apiserver、kube-controller-manager、kube-scheduler、etcd |

| Node01 | 192.168.11.16 | kubelet、kube-proxy、docker 、flannel 、etcd |

| Node02 | 192.168.11.17 | kubelet、kube-proxy、docker 、flannel 、etcd |

软件包

百度网盘链接:https://pan.baidu.com/s/1o8kgiC_9b2hO8FRNaDGC3Q

提取码:qz5v

一、部署Etcd

1、制作证书

① 创建工作目录

[root@master ~]# mkdir k8s

[root@master k8s]# cd k8s

② 安装制作证书的工具cfssl

编写cfssl.sh脚本,从官网下载制作证书的工具cfssl,直接放在/usr/local/bin目录下,方便系统识别,并加执行权限

[root@localhost k8s]# vim cfssl.sh

curl -L https://pkg.cfssl.org/R1.2/cfssl_linux-amd64 -o /usr/local/bin/cfssl

curl -L https://pkg.cfssl.org/R1.2/cfssljson_linux-amd64 -o /usr/local/bin/cfssljson

curl -L https://pkg.cfssl.org/R1.2/cfssl-certinfo_linux-amd64 -o /usr/local/bin/cfssl-certinfo

chmod +x /usr/local/bin/cfssl /usr/local/bin/cfssljson /usr/local/bin/cfssl-certinfo

[root@localhost k8s]# bash cfssl.sh #执行脚本等待安装下载软件

[root@localhost k8s]# ls /usr/local/bin/ #可以看到三个制作证书的工具

cfssl cfssl-certinfo cfssljson

#cfssl:生成证书工具

#cfssl-certinfo:查看证书信息

#cfssljson:通过传入json文件生成证书

③ 编辑etcd证书创建的脚本

Etcd之间的通讯都是需要安全认证的,安全认证又需要证书认证的

#创建证书目录

[root@master k8s]# mkdir etcd-cert

[root@master k8s]# cd etcd-cert

#编辑etcd证书创建的脚本

[root@master etcd-cert]# vim etcd-cert.sh

#创建生成ca证书的配置文件

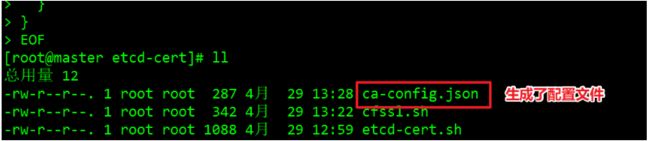

cat > ca-config.json < ca-csr.json < server-csr.json < ④ 生成ca证书的配置文件,定义ca证书

[root@master etcd-cert]# cat > ca-config.json < {

> "signing": {

> "default": {

> "expiry": "87600h"

> },

> "profiles": {

> "www": {

> "expiry": "87600h",

> "usages": [

> "signing",

> "key encipherment",

> "server auth",

> "client auth"

> ]

> }

> }

> }

> }

> EOF

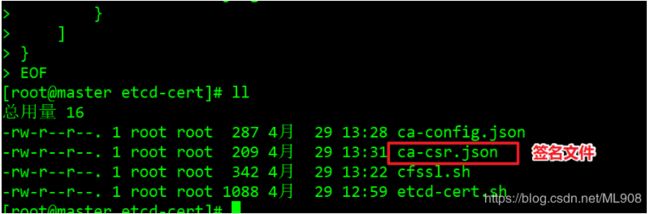

⑤ 创建ca证书的签名证书

[root@master etcd-cert]# cat > ca-csr.json < {

> "CN": "etcd CA",

> "key": {

> "algo": "rsa",

> "size": 2048

> },

> "names": [

> {

> "C": "CN",

> "L": "Beijing",

> "ST": "Beijing"

> }

> ]

> }

> EOF

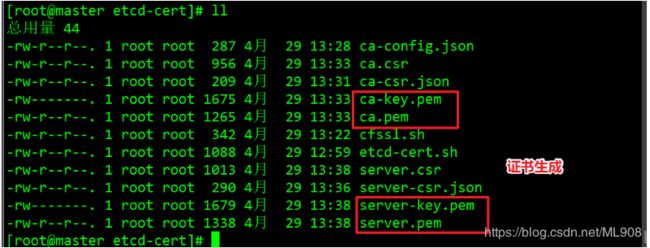

⑥ 生成证书(生成ca-key.pem密钥证书 ca.pem证书)

#cfssl、cfssljson:证书的创建工具。用ca签名证书生成ca证书,得到ca-key.pem ca.pem

[root@master etcd-cert]# cfssl gencert -initca ca-csr.json | cfssljson -bare ca -

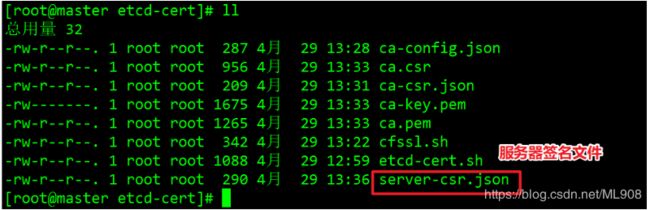

⑦ 指定etcd三个节点之间的通信验证(需要服务器签名证书 server-csr.json)

#用ca-key.pem、ca.pem、服务器签名证书 生成ETCD证书:server-key.pem、server.pem

cat > server-csr.json <

#用ca-key.pem、ca.pem、服务器签名证书 生成ETCD证书 ----server-key.pem、server.pem

[root@master etcd-cert]# cfssl gencert -ca=ca.pem -ca-key=ca-key.pem -config=ca-config.json -profile=www server-csr.json | cfssljson -bare server

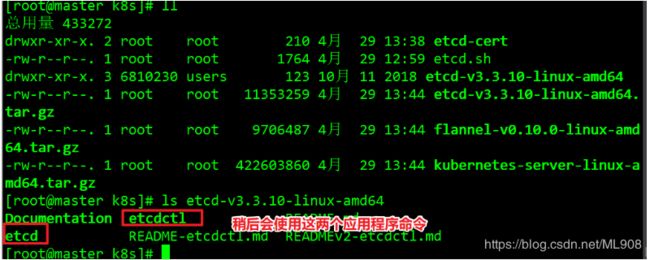

2、搭建etcd集群

① master节点部署etcd

上传软件包至k8s目录中

#解压etcd软件包至当前目录,再创建etcd集群的工作目录

[root@master k8s]# tar zxvf etcd-v3.3.10-linux-amd64.tar.gz

#创建etcd工作目录(创建三个目录,cfg配置文件目录,bin命令文件目录,ssl证书文件目录)

[root@master k8s]# mkdir -p /opt/etcd/{cfg,bin,ssl}

[root@master k8s]# ls /opt/etcd/

bin cfg ssl

#把etcd、etcdctl 执行文件放在/opt/etcd/bin/命令文件目录中

[root@master k8s]# mv etcd-v3.3.10-linux-amd64/etcd etcd-v3.3.10-linux-amd64/etcdctl /opt/etcd/bin/

[root@master k8s]# ls /opt/etcd/bin/

etcd etcdctl

#证书拷贝到/opt/etcd/ssl/证书文件目录中

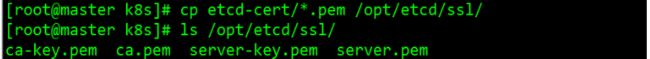

[root@master k8s]# [root@master k8s]# cp etcd-cert/*.pem /opt/etcd/ssl/

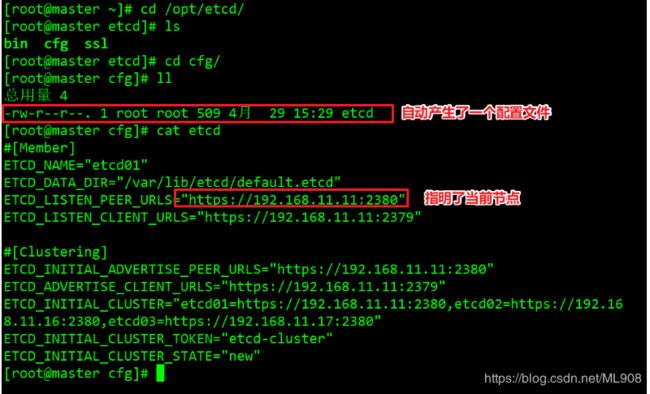

#执行 etcd.sh 脚本,产生etcd集群的配置脚本和服务启动脚本,进入卡住状态等待其他节点加入(这个状态会维持5分钟左右,超过5分钟会自动结束)

注意节点地址

[root@master k8s]# bash etcd.sh etcd01 192.168.11.11 etcd02=https://192.168.11.16:2380,etcd03=https://192.168.11.17:2380

2380是集群内部通讯的端口

2379是对外提供的端口

#使用另外一个会话窗口,会发现etcd进程己经开启

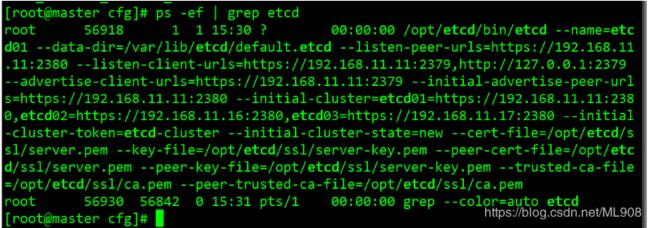

[root@master k8s]# ps -ef | grep etcd

#切换到/opt/etcd/cfg配置文件目录中查看,生成了配置文件

② node节点加入ETCD集群(实现内部通信)

#将master节点上的证书等文件拷贝至node节点

[root@master k8s]# scp -r /opt/etcd/ [email protected]:/opt/

[root@master k8s]# scp -r /opt/etcd/ [email protected]:/opt/

#将master节点上的启动脚本拷贝至node节点

[root@master k8s]# scp /usr/lib/systemd/system/etcd.service [email protected]:/usr/lib/systemd/system/

[root@master k8s]# scp /usr/lib/systemd/system/etcd.service [email protected]:/usr/lib/systemd/system/

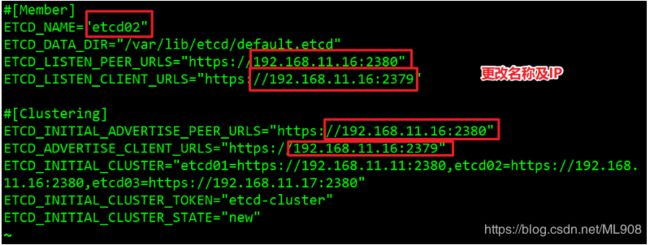

#在node01 节点上修改配置文件

[root@node01 ~]# vim /opt/etcd/cfg/etcd

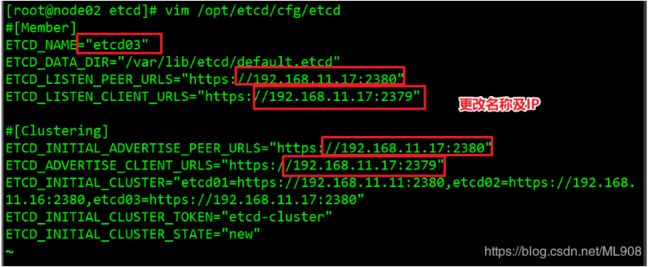

[root@node02 ~]# vim /opt/etcd/cfg/etcd

#在master节点执行 etcd.sh 脚本,等待node节点加入集群

[root@master k8s]# bash etcd.sh etcd01 192.168.11.11 etcd02=https://192.168.11.16:2380,etcd03=https://192.168.11.17:2380

#同时快速启动 node01、node02节点

[root@node1 ~]# systemctl start etcd

[root@node1 ~]# systemctl status etcd

[root@node2 ~]# systemctl start etcd

[root@node2 ~]# systemctl status etcd

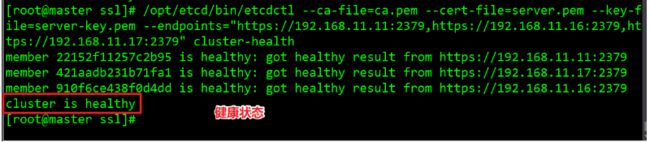

③ 检查群集状态

#在master上查看群集状态

注意:要在包含ca.pem证书文件的目录(/opt/etcd/ssl/)下执行该条命令

[root@master ~]# cd /opt/etcd/ssl/

[root@master ssl]# /opt/etcd/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://192.168.11.11:2379,https://192.168.11.16:2379,https://192.168.11.17:2379" cluster-health

此时,群集之间就可以通过安全性的通讯方式进行数据交换了

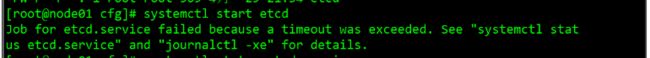

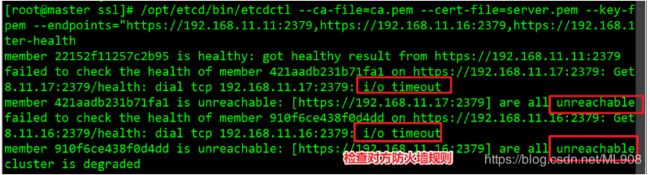

④ 问题

- node节点加入集群时失败,检查主节点防火墙规则

解决方法:配置好防火墙规则或直接清空

iptables -F #清空防火墙规则

setenforce 0 #关闭核心防护

二、Docker引擎部署

所有node节点部署docker引擎

详见:简单部署及基础操作

三、flannel网络配置

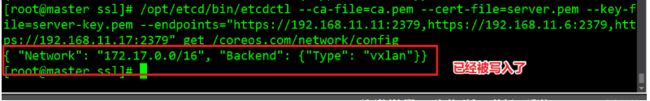

1、写入分配的子网段到etcd,供flanneld使用

#注意:需要使用ca证书,所以必须在证书存放的目录下执行此命令。

[root@master ssl]# /opt/etcd/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://192.168.11.11:2379,https://192.168.11.16:2379,https://192.168.11.17:2379" set /coreos.com/network/config '{ "Network": "172.17.0.0/16", "Backend": {"Type": "vxlan"}}'

#查看写入的信息

[root@master ssl]# /opt/etcd/bin/etcdctl --ca-file=ca.pem --cert-file=server.pem --key-file=server-key.pem --endpoints="https://192.168.11.11:2379,https://192.168.11.6:2379,https://192.168.11.17:2379" get /coreos.com/network/config

2、部署与配置flannel

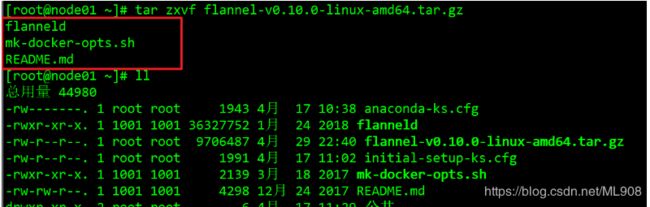

#将flannel-v0.10.0-linux-amd64.tar.gz包上传至所有node节点并进行解压

(flannel只需要安装在运行pod资源的节点上)

[root@node01 ~]# tar zxvf flannel-v0.10.0-linux-amd64.tar.gz

#在两个node节点创建k8s的工作目录

[root@node01 ~]# mkdir -p /opt/kubernetes/{cfg,bin,ssl}

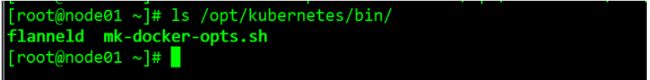

[root@node01 ~]# mv mk-docker-opts.sh flanneld /opt/kubernetes/bin/ #方便执行文件

[root@node01 ~]# ls /opt/kubernetes/bin/

#编写flannel.sh启动脚本(两个node节点均需要)

[root@node01 ~]# vim flannel.sh

#!/bin/bash

ETCD_ENDPOINTS=${1:-"http://127.0.0.1:2379"}

#创建配置文件

cat </opt/kubernetes/cfg/flanneld

FLANNEL_OPTIONS="--etcd-endpoints=${ETCD_ENDPOINTS} \

-etcd-cafile=/opt/etcd/ssl/ca.pem \

-etcd-certfile=/opt/etcd/ssl/server.pem \

-etcd-keyfile=/opt/etcd/ssl/server-key.pem"

EOF

#创建启动脚本

cat </usr/lib/systemd/system/flanneld.service

[Unit]

Description=Flanneld overlay address etcd agent

After=network-online.target network.target

Before=docker.service

[Service]

[Unit]

Description=Flanneld overlay address etcd agent

After=network-online.target network.target

Before=docker.service

[Service]

Type=notify

EnvironmentFile=/opt/kubernetes/cfg/flanneld

ExecStart=/opt/kubernetes/bin/flanneld --ip-masq \$FLANNEL_OPTIONS

ExecStartPost=/opt/kubernetes/bin/mk-docker-opts.sh -k DOCKER_NETWORK_OPTIONS -d /run/flannel/subnet.env

Restart=on-failure

[Install]

WantedBy=multi-user.target

EOF

systemctl daemon-reload

systemctl enable flanneld

systemctl restart flanneld

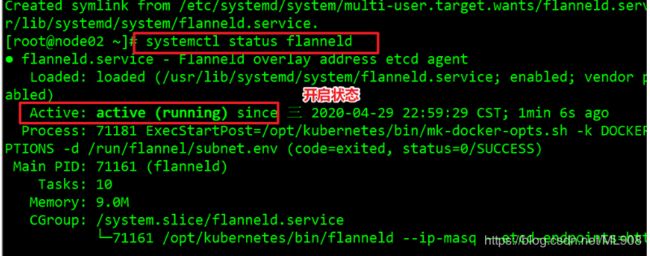

#开启flannel网络功能(两个node节点均需要开启)

[root@node01 ~]# bash flannel.sh https://192.168.11.11:2379,https://192.168.11.16:2379,https://192.168.11.17:2379

[root@node01 ~]# systemctl status flanneld

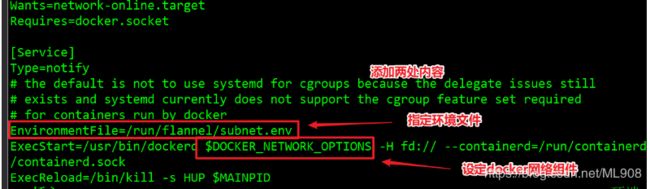

3、配置Docker连接flannel网络

#修改docker的配置文件(两个node节点均操作)

[root@node01 ~]# vim /usr/lib/systemd/system/docker.service

EnvironmentFile=/run/flannel/subnet.env

ExecStart=/usr/bin/dockerd $DOCKER_NETWORK_OPTIONS -H fd:// --containerd=/run/containerd/containerd.sock

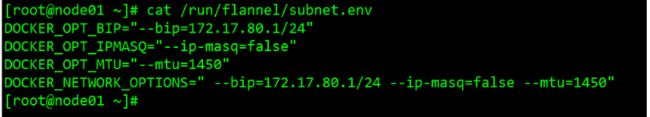

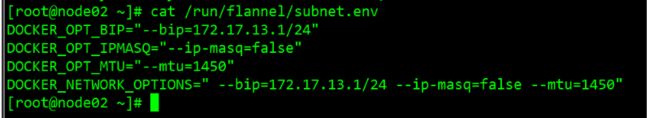

#查看 flannel网络分配的子网段

[root@node01 ~]# cat /run/flannel/subnet.env

可以看到node1节点分配的是172.17.80.0子网段,node2节点分配的是172.17.13.0子网段

#重启docker服务(两个node节点均需要操作)

[root@node01 ~]# systemctl daemon-reload

[root@node01 ~]# systemctl restart docker

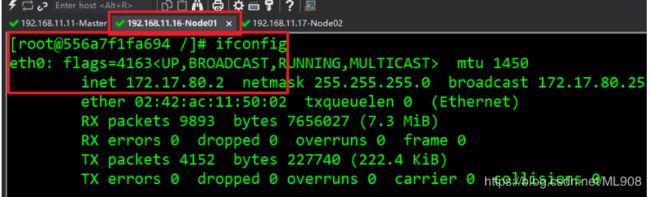

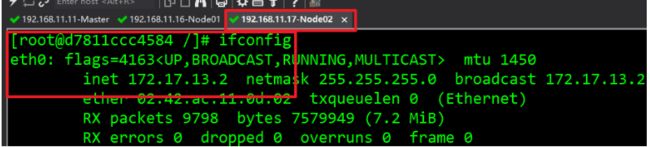

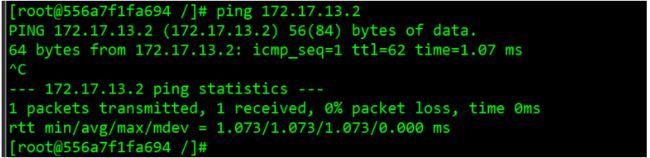

4、验证容器间flannel网络互通

测试ping同对方docker0网卡证明flannel起到路由作用

#两个node节点分别创建容器(两个节点操作)

[root@node01 ~]# docker run -it centos:7 /bin/bash

#安装工具(两个节点操作)

[root@556a7f1fa694 /]# yum install -y net-tools

可以ping通,这时flannel组件完成,两个节点上的容器可正常通讯