虚拟机网络配置、ssh免密配置、jdk和hadoop安装、Hadoop集群配置、格式化文件系统、关闭和启动集群、UI查看集群状态

一、虚拟机网络配置

二、SSH免密登录公能配置

二、安装jdk

三、安装Hadoop

四、Hadoop集群配置

五、格式化文件系统

六、关闭和启动Hadoop集群

七、通过UI界面查看Hadoop运行状态

1.虚拟机网络配置

mkdir -p /export/data

mkdir -p /export/servers

mkdir -p /export/software(后面我们安装软件需要这几个目录)

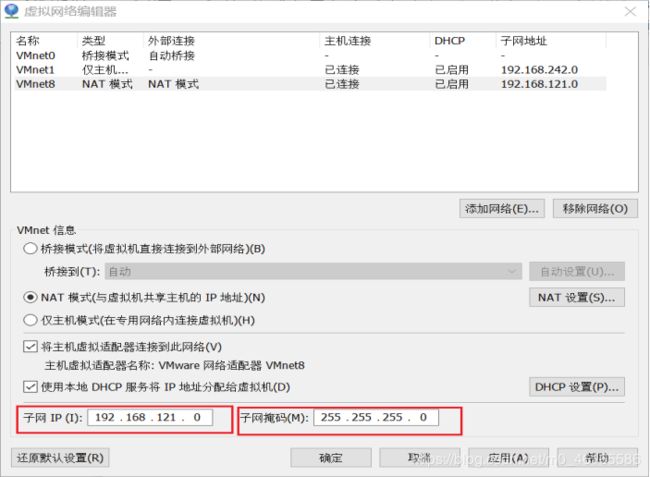

打开VMware点开编辑再打开虚拟网络编辑器

再window下找到更改适配器选项

再window下找到更改适配器选项

进入hadoop01进行vi编辑文档

进入hadoop01进行vi编辑文档

vi 按 i 开始编辑 ESC 按:wq保存退出

主机名:vi /etc/sysconfig/network

NETWORKING=yes

HOSTNAME=hadoop01

分别设置三台机器不同的主机名: hadoop01、hadoop02、hadoop03

映射:

vi /etc/hosts

192.168.121.134 hadoop01

192.168.121.135 hadoop02

192.168.121.136 hadoop03

每台机器都是一样的设置

vi /etc/udev/rules.d/78-persitent-net.rules

SUBSYSTEM=“net”,ACTION==“add”,DRIVERS=="?",ATTR{address}“00:0C:29:72:D0:C9”,ATTR{type}“1”,KERNEL=="eth",NAME=“eth0”

SUBSYSTEM=“net”,ACTION==“add”,DRIVERS=="?",ATTR{address}“00:0C:29:B7:0A:85”,ATTR{type}“2”,KERNEL=="eth",NAME=“eth0”

SUBSYSTEM=“net”,ACTION==“add”,DRIVERS=="?",ATTR{address}“00:0C:29:FD:AE:D2”,ATTR{type}“3”,KERNEL=="eth",NAME=“eth0”

每台机器设置分别设置不同的MAC地址,修改的是ATTR{address}==后面双引号里面的内容(创建的虚拟机单机右键选择设置找到网络适配器选择高级就会有MAC地址)

![]()

以下是每台机器分别配置不同的ip等信息

vi /etc/sysconfig/network-scripts/ifcfg-eth0

这是第一台

DEVICE=eth0

TYPE=Ethernet

UUID=1b7c5b0b-458c-4ffd-b81d-435bc4d82b3a

ONBOOT=yes

NM_CONTROLLED=yes

BOOTPROTO=static

HWADDR=00:0C:29:72:D0:C9

DEFROUTE=yes

PEERDNS=yes

PEERROUTES=yes

IPV4_ FAILURE_FATAL=yes

IPV6INIT=no

NAME=“System eth0”

IPADDR=192.168.121.134

NETMASK=255.255.255.0

GATEWAY=192.168.121.2

DNS1=8.8.8.8

这是第二台

DEVICE=eth0

TYPE=Ethernet

UUID=1b7c5b0b-458c-4ffd-b81d-435bc4d82b3a

ONBOOT=yes

NM_CONTROLLED=yes

BOOTPROTO=static

HWADDR=00:0C:29:B7:0A:85

DEFROUTE=yes

PEERDNS=yes

PEERROUTES=yes

IPV4_ FAILURE_FATAL=yes

IPV6INIT=no

NAME=“System eth0”

IPADDR=192.168.121.135

NETMASK=255.255.255.0

GATEWAY=192.168.121.2

DNS1=8.8.8.8

这是第三台

DEVICE=eth0

TYPE=Ethernet

UUID=1b7c5b0b-458c-4ffd-b81d-435bc4d82b3a

ONBOOT=yes

NM_CONTROLLED=yes

BOOTPROTO=static

HWADDR=00:0C:29:FD:AE:D2

DEFROUTE=yes

PEERDNS=yes

PEERROUTES=yes

IPV4_ FAILURE_FATAL=yes

IPV6INIT=no

NAME=“System eth0”

IPADDR=192.168.121.136

NETMASK=255.255.255.0

GATEWAY=192.168.121.2

DNS1=8.8.8.8

(HWADDR要与每台机器的MAC地址相同)

到此为止,三台机器ip地址都设置好了。接下来ping下百度网站以检查网络是否连接成功

到此为止,三台机器ip地址都设置好了。接下来ping下百度网站以检查网络是否连接成功

并用Ctrl+c结束ping命令。

(图片只是告诉怎么配置,三台虚拟机都要配置)

2.SSH免密登录公能配置

rpm -qa | grep ssh (查看是否已经安装了SSH服务)

ps -e | grep sshd (查看是否起启服务)

yum install openssh-server(如果没有安装就用此命令安装)

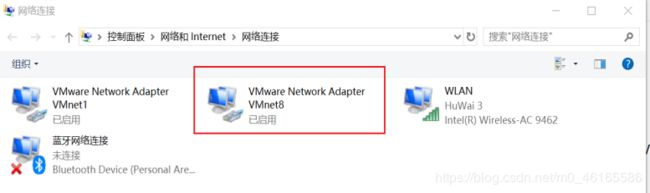

一、先生成自己的密钥 ssh-keygen -t rsa

连按4次Enter键

连按4次Enter键

二、都统一复制到hadoop01机器上去。包括第一台。ssh-copy-id hadoop01(分别再01到03执行这个命令)

三、复制到其他2台机器上去scp /root/.ssh/authorized_keys hadoop02:/root/.ssh

scp /root/.ssh/authorized_keys hadoop03:/root/.ssh

下载xshell等这类软件会很方便我们使用虚拟机

3.安装jdk

rpm -qa | grep jdk //查看当前所有已经安装的jdk包

返回如下

java-1.8.0-openjdk-headless-1.8.0.222.b03-1.el7.x86_64

java-1.7.0-openjdk-headless-1.7.0.221-2.6.18.1.el7.x86_64

copy-jdk-configs-3.3-10.el7_5.noarch

java-1.8.0-openjdk-1.8.0.222.b03-1.el7.x86_64

java-1.7.0-openjdk-1.7.0.221-2.6.18.1.el7.x86_6

执行下面命令,删除两个openjdk包

yum -y remove java-1.8.0-openjdk-headless-1.8.0.222.b03-1.el7.x86_64

yum -y remove java-1.7.0-openjdk-headless-1.7.0.221-2.6.18.1.el7.x86_64

上传jdk安装包(3种方法)

(1)使用rz

如果Linux中没有rz,先安装,执行指令(xshell自带rz命令,以后的学习中会很方便/安装到指定目录需cd进入这个目录中)

yum install lrzsz -y

输入rz,弹出对话框,选择相应的文件上传

(我是使用xshell上传的,xshell自带rz命令)

(2)使用sftp指令

SecureCRT上传,进入sftp方式,使用put命令

sftp> put G:\迅雷下载\jdk-8u161-linux-x64.tar.gz

(3)直接使用U盘拷贝

上传以后执行安装指令

tar -zxvf jdk-8u161-linux-x64.tar.gz -C /export/servers/ //解压缩安装JDK

mv jdk1.8.0_161 jdk //将安装的文件夹改成一个简短的名字jdk

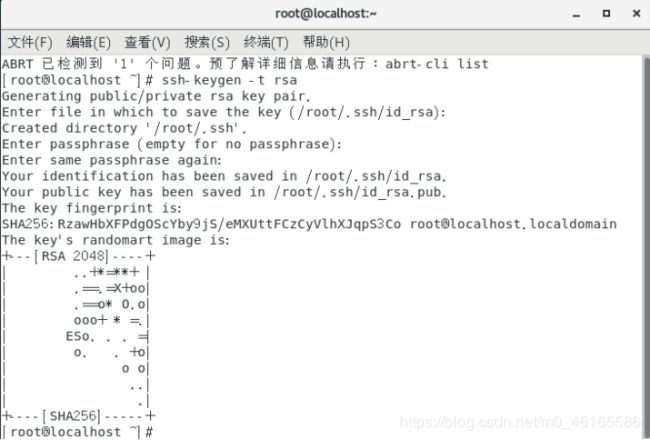

配置JDK环境变量,执行指令

vi /etc/profile

添加以下内容

export JAVA_HOME=/export/servers/jdk

export PATH= P A T H : PATH: PATH:JAVA_HOME/bin

export CLASSPATH=.: J A V A H O M E / l i b / d t . j a r : JAVA_HOME/lib/dt.jar: JAVAHOME/lib/dt.jar:JAVA_HOME/lib/tools.jar

使配置文件生效

使配置文件生效

source /etc/profile

检测JDK是否安装成功

java -versio

4.安装Hadoop

将安装包上传到/export/software目录下,三种方式,参见JDK的安装包上传

(同样cd进入/export/software)

解压Hadoop

tar -zxvf hadoop-2.7.4.tar.gz -C /export/servers

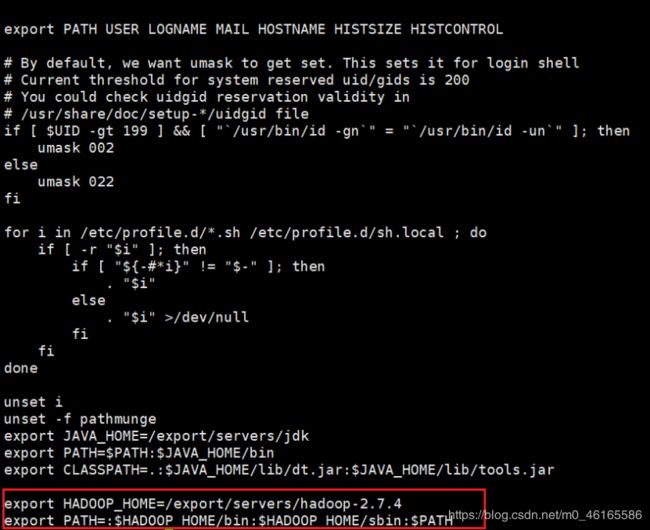

配置Hadoop环境变量,执行指令

vi /etc/profile

添加代码

export HADOOP_HOME=/export/servers/hadoop-2.7.4

export PATH= P A T H : PATH: PATH:HADOOP_HOME/bin:$HADOOP_HOME/sbin

使配置文件生效

使配置文件生效

source /etc/profile

执行命令验证hadoop的安装

hadoop version

五.Hadoop集群配置(因代码直接出现会出现乱码,代码都在图片中用红色框出来了)

配置文件所在的位置:/export/servers/hadoop-2.7.4/etc/hadoop

(cd进入这个目录)

(一)修改主机上的配置

1、修改hadoop-env.sh文件(使用vi或者vim命令)

export JAVA_HOME=/export/servers/jdk

2、修改core-site.xml文件

2、修改core-site.xml文件

3、修改hdfs-site.xml文件

3、修改hdfs-site.xml文件

4、修改mapred-site.xml文件(如果使用vi进入mapred-site.xml是空白,先用cp mapred-site.xml.template mapred-site.xml)

4、修改mapred-site.xml文件(如果使用vi进入mapred-site.xml是空白,先用cp mapred-site.xml.template mapred-site.xml)

5、修改yarn-site.xml文件

5、修改yarn-site.xml文件

6、修改slaves文件。

6、修改slaves文件。

打开该配置文件,先删除里面的内容(默认localhost),然后配置如下内容

hadoop01

hadoop02

hadoop03

(二)将主节点将主节点的配置文件分发到其他子节点

(二)将主节点将主节点的配置文件分发到其他子节点

scp /etc/profile hadoop02:/etc/profile

scp /etc/profile hadoop03:/etc/profile

scp -r /export/ hadoop02:/

scp -r /export/ hadoop03:/

完成以后在子节点机器上刷新配置文件

source /etc/profile

5.格式化文件系统

对主节点进行格式化处理

hdfs namenode -format(只进行一次格式化,后面不需要进行)

6.关闭和启动Hadoop集群

jps查看当前的进程

在hadoop01上

hadoop-daemon.sh start namenode

hadoop-daemon.sh start datanode

在其他虚拟机上

hadoop-daemon.sh start datanode

YARN的启动

yarn-daemon.sh start resourcemanager

yarn-daemon.sh start nodemanager

其他2台机器

yarn-daemon.sh start nodemanager

在hadoop02:

hadoop-daemon.sh start secondarynamenode

关闭只须把start改为stop

也可以一次性start-all.sh(建议是一个一个启动)

七.通过UI界面查看Hadoop运行状态

通过UI界面查看Hadoop运行状态

C:\Windows\System32\drivers\etc\hosts 修改增加主映射(没有hosts文件自己创建txt文件加入内容保存然后把txt后缀去掉)

192.168.121.134 hadoop01

192.168.121.135 hadoop02

192.168.121.136 hadoop03

关闭防火墙(三台机器都要关闭)active (running)

systemctl status firewalld.service(查看防火墙状态)

systemctl stop firewalld.service(关闭防火墙)

在Windows系统下,访问hadoop01:50070,查看HDFS集群状态。

在Windows系统下,访问hadoop01:8088,查看Yarn集群状态。

(配合前面发布的VWware与虚拟机的安装、克隆一起看可以配置好Hadoop集群)

(希望大家都能成功,我也是新手有错误请指出来,一起学习一起进步,不会可以私,共勉!)