第1143期AI100_机器学习日报(2017-11-04)

AI100_机器学习日报 2017-11-04

- Uber开源深度概率编程语言Pyro

- 宾州树库和CTB的Python预处理脚本

- (TextBlob)Twitter情感分析实战

- Capsule Networks详解

- Keras框架下学习车牌OCR

@好东西传送门 出品,由@AI100运营, 过往目录 见http://geek.ai100.com.cn

订阅:关注微信公众号 AI100(ID:rgznai100,扫二维码),回复“机器学习日报”,加你进日报群

![]()

本期话题有:

全部17 深度学习9 算法8 视觉6 自然语言处理5 应用3 会议活动2 公告板1 知识工程1 资源1

用日报搜索找到以前分享的内容: http://ml.memect.com/search/

今日焦点 (5)

【Uber开源深度概率编程语言Pyro】《Uber Open Sources Pyro, a Deep Probabilistic Programming Language》 http://t.cn/RlqksXa

hankcs 网页版 2017-11-04 15:45

hankcs 网页版 2017-11-04 15:45

Python

【宾州树库和CTB的Python预处理脚本】在写句法分析器之前,通常需要将PTB和CTB预处理为:一行一个句子,单文件;符合规范比例的训练集/开发集/测试集;去掉CTB中的xml标签,只保留句子,编码转换。这些步骤很麻烦,因为bracket… http://t.cn/RlcNhT8

自然语言处理 代码 情感分析

【(TextBlob)Twitter情感分析实战】《Sentiment Analysis of Twitter Timelines》by Dmitry Rastorguev @dmitryrastorguev/sentiment-analysis-of-twitter-timelines-61c73eeacedf”>http://t.cn/Rl52cMg

深度学习 Geoffrey Hinton Max Pechyonkin

【Capsule Networks详解】《Understanding Hinton’s Capsule Networks》by Max Pechyonkin Part I: Intuition @pechyonkin/understanding-hintons-capsule-networks-part-i-intuition-b4b559d1159b”>http://t.cn/Rl5v2jI

深度学习 视觉

【(Keras/Supervisely)15分钟搞定最新深度学习车牌OCR】《Latest Deep Learning OCR with Keras and Supervisely in 15 minutes》 http://t.cn/RlqsDU2 pdf: http://t.cn/RlqsDUL

最新动态

2017-11-04 (11)

wx:Harold Yue 网页版 2017-11-04 23:39

公告板 深度学习 视觉 算法 应用 自然语言处理 Brain Decoding Harold Yue SVM 分类 广告系统 机器翻译 神经科学 神经网络 王蓁 问题 语言学

「干货 | 用深度学习来解析梦境中出现的物体」AI科技评论按:本文作者Harold Yue,首发于知乎专栏神经科学和人工智能,AI科技评论获其授权转载。这篇文章主要的工作算是机器学习和神经科学的结合工作,需要读者在这两个方向有一定的基础。另有科普版本,结构更加清晰,不过删减了很多内容。科普版本如下:用深度学习来解析梦境中出现的物体 – 行为与认知神经科学( https://zhuanlan.zhihu.com/p/27948255)机器学习简介:机器学习算法是一类从数据中自动分析获得规律,并利用规律对未知数据进行预测的算法。最近大火的深度学习则是机器学习的一个分支,主要用基于人工神经网络的各种方法来实现目的,现在有很多变种,本文中使用的神经网络是一个卷积神经网络(Convolutional Neural Networks, CNN)。文章中神经科学实验部分主要使用的信号读取方法是功能磁共振( functional Magnetic Resonance Imaging,功能核磁共振),主要原理是通过监测脑区血流量的变化来间接测量脑区的活动程度,当一个脑区活动程度增强的时候,相应的血流量也会增加,为脑区输送更多的氧气,影响,以及排除废物。功能磁共振的空间分辨率很高,但其时间分辨率比较有限,只能采集到2s 左右时间内的平均活动程度,同时对于神经活动的检测有一定延时。前一周去开ASSC 的时候听到一个很有趣的工作,用深度学习来解析人类梦境中出现的物体类别。我见到的为数不多融合深度学习和神经科学的工作。回来之后翻了下相关文章,来在这分享下。本文介绍的总体思路:证明视知觉和梦境在视觉皮层上的神经活动有部分类似的激活模式。[1]以正常视知觉为训练集训练一个 Decoder,从被试的视觉皮层神经活动信号到最后的物体类别。这里是分成两部分,先从 fMRI 信号到特征空间,再从特征空间用相关性分析的办法推测物体类别。[2]用这个 Decoder 来预测梦境中的物体类别。[3]夹点私货,用里面的数据来说下视觉皮层和卷积神经网络底层的相似性,也算是解释了为什么用卷积神经网络的效果要更好。最后我个人从一个认知神经科学研究生和一个机器学习初学者的角度来分析下这个工作。前三点,对应了他们组发的三篇文章。我们从头开始说。先是13年的一个工作Neural Decoding of Visual Imagery During Sleep.实验部分实验过程中被试躺在核磁共振成像仪里面,在持续通过脑电图(electroencephalogram, EEG)来检测被试的睡眠状态的同时扫描大脑活动。在通过特定的脑电特征了解被试进入梦境状态之后,会叫醒被试并让其口头描述梦境内容。(如下图所示)结果部分在梦境实验之前,作者收集了被试们在看图片时候视觉皮层的Fmri信号,并基于此训练一个线性SVM(Support Vector Machine,支持向量机)分类器。并用此分类器尝试解码出被试在梦境状态下的看到的物体,这里作者使用的任务相对简单,是要在两个物体类别里面挑出正确的那一个。结果是预测准确率大于50%,高于随机水平,说明视知觉和梦境在视觉皮层有类似的信息表征机制。这个工作做的其实超前,在13年的时候大概是首次尝试解析梦境的工作,也是很早把机器学习和神经科学结合起来的工作,但是由于和今天的主题不是特别相关,所以只介绍了我需要的结果,至于具体用的思路和方法,在此略过,有兴趣的同学,可以自行查找原文。[1]接下来是重点,如何从被试看图片的 fMRI 信号中解出物体类别。实验部分作者在此主要做了两类实验,一类是正常看物体的图片,另一类是基于线索来想象物体的形象。在看物体实验中,被试会被呈现不同的图片,每张图片9秒钟。这里加了一个比较简单的小任务,当出现的图片和上一张出现的图片相同的时候,被试需要做按键反应。这里是为了让被试的注意维持在图片上。 第二类是想象实验,在线索阶段,会有1个目标词汇和49个干扰词出现,在听到‘滴’声之后,被试要闭上眼睛,想象目标词汇的形象。过了15s,听到‘滴’ 之后,睁眼,确认想象的形象是目标形象。 在实验进行的过程中,会采集被试视觉皮层的fMRI信号。从fMRI到物体类别接下来的数据分析工作,也就是从fMRI信号到物体类别是分两步走的,第一步是fMRI 信号到特征空间。作者在此用了一个8层预训练好的神经网络来做特征提取。在前七层中每层随机选1000个神经元,以及第八层的全部1000个神经元,把一张图片前向传播过网络后,这些神经元的输出作为特征。这样每张图片前向传播之后,可以获得一个 8层 * 1000 特征/层 的特征矩阵。之后是被试用被试的fMRI信号来训练一系列Decoder,从被试的fMRI信号来拟合不同层中不同特征的值。来实现从fMRI信号到特征空间的转换。第二步是从特征空间到物体的类别。这里作者首先做的是,计算各个物体类别的特征矩阵。他的做法是,每一个类别下面所有图片前向跑一遍网络,把生成的所有的特征矩阵平均,得到一个物体类别对应的特征矩阵。如果要计算上一步中,被试梦境中解码出来的特征矩阵具体对应着哪个类别的物体。这里做一个简单的相关,取相关系数最高的那个类别为预测类别。结 果这篇文章做出的结果不能说很好,但是确实为这个领域的应用提出了一个有趣的方向。这张图截取的是卷积神经网络部分预测准确率。可以看到,在被试真正看到图片的情况下,使用某些层的预测准确率可以到达很高,超过90%,在直接用这个网络迁移到想象情况下,也可以达到一个高于随机猜测的准确率。明显看出,现有模型对于想象图片的预测能力要差很多。其实想来有一定道理,第一就是,想象和直接看肯定有不同的底层视觉机制。第二就是模型是基于真正看图片的情况来训练的,迁移到另外一个相似却不完全相同的任务上表现表现自然会差一些。解梦的工作这篇文章是重点讲的。再重点也不会逐字翻译,我只会把整体的逻辑讲通。喜欢这篇文章的同学们欢迎去看原文。[3]这篇文章很巧妙的地方在于,他没做实验,用的是第一篇文章的数据和第二篇文章的模型。Single category feature decoding with averaged trials梦境中单物体类别的识别。这里用的是书的例子,被试在做梦的时候,可能会在多个梦境中都出现书这个物体,作者把这几个梦境对应的fMRI信号加起来做平均,然后通过文章2中训练处的Decoder 来预测出当前梦境的特征矩阵,之后和书这个类别的特征矩阵做相关。结果显示,高级脑区和神经网络的高层对于物体识别的效果比较好,当他们两结合在一起时候产生的效果最好。Multi-category feature decoding with individual trials当然,一个梦境里面只出现书也不现实,大家都有这样的经历,梦境更多是一整个场景,会出现多个物体,如上图,这个梦境中,除了书还有一个男人和食物。所以作者也做了这个实验,单个梦境里面多物体的识别。用的是单个梦境对应fMRI信号Decode出来的特征矩阵来和被试报告的所有类别的特征矩阵的平均矩阵做相关比较。这个预测结果更差了,但是从趋势上和上一个实验类似。高级脑区和网络的高层有更好的预测能力。最后一个实验,其实是重现了文章1中最后的实验,在两个物体类别中找到真正在梦境中出现的那个类别。用的方法也是特征矩阵的相关。准确率大大高于第一篇文章基于SVM(支持向量机)的结果。这里也可以看到的是,看到物体实验的结果在神经网络的中间层(4,5,6层)表现比较好,到最后层反倒有一个下降的趋势,这个趋势在想象的结果中也有体现。对于梦境这个实验,虽然预测效果同样大于随机猜测,但是在7层出现了一个下降而又在8层回升的现象,模式与看图片和想图片的模式不符。暗示梦境的神经机制和视知觉虽然有一定相似性,但是具体的机制还存在一定的差异。夹带私货。用这个文章的数据来简要讨论下卷积神经网络和人类视觉皮层的相似性。而这个相似性也是我写这篇文章的原因之一。Image feature decoding and the homology of CNN and the human brain.这个图出现在第二篇文章之中。a 是预测的特征矩阵不同层和实际的特征值的对比,有一定的重合,说明Decoder 确实在一定程度上学到了 从fMRI信号到卷积神经网络不同层特征的映射。B图是用不同视觉皮层预测出来的feature value 和 实际的feature value 的比较。这里比较有趣的是,低级的视觉皮层,如V1,V2,V3 在拟合低层卷积神经网络 的时候效果相对稍好,而高级视觉皮层(FFA ( fusiform face area,梭状回面孔识别区,神经科学研究发现主要参与人脸识别),PPA(Parahippocampal place area,神经科学发现主要参与场景识别))在拟合高层卷积神经网络的时候效果相对稍好。Preferred images and weight distributions for CNN layers.在神经科学领域,有类似的研究,证明 FFA,PPA 这种相对高级的皮层,会对更复杂的视觉刺激有比较强烈的反应,如FFA,主要对人脸反应,PPA 对物体,而底层皮层,如V1,V2,V3 更多的对底层视觉元素反应,如不同方向的线以及颜色等等。作者用一种 Activation Maximization 的方法来生成更能刺激相应层的图片,并用这些图片来给被试看,并用这些数据的fMRI来生成特征矩阵。发现了类似的现象。人越高级的皮层,拟合的结果对应高级卷积层的效果越好。这暗示着卷积神经网络和人类视觉皮层有一定的相似性,低级主管局部特征,高层主管语义特征。整体文章就完结了。可能有些朋友觉得看的一头雾水,我在这重新整理下行文逻辑。1.证明视知觉和梦境在视觉皮层上的神经活动有部分类似的 pattern。2.以正常视知觉为训练集训练一个 Decoder,从被试的视觉皮层神经活动信号到最后的物体类别。这里是分成两部分,先从 fMRI 信号到特征空间,再从特征空间用相关性分析的办法推测物体类别。3.用这个 Decoder 来预测梦境中的物体类别。4. 夹点私货,用里面的数据来说下 视觉皮层和 卷积神经网络底层的相似性,也算是解释了 为什么用卷积神经网络的效果要更好。5. 最后我个人从一个认知神经科学研究生和一个机器学习初学者的角度来分析下这个工作。个人对一系列文章的评价:很有趣的工作,13年的时候,第一次用fMRI+机器学习技术尝试解析梦境,15年的时候,能做到以一定的准确程度从被试的fMRI信号中成功解析看到的物体,从这两点来看,是非常有开创性的工作。除此之外,关于卷积神经网络 和相关脑区的比较也是比较有趣的工作,一定程度上说明了卷积神经网络和人类视觉皮层的相似性。作为一个认知神经科学研究生,我认为这几个实验做得挺好的,简单,但是十分有效,如果说有什么改进的话,就是如果能来和我们所合作,用7T更高分辨率来试一下是不是会更好啊,还有就是最新的一些序列可能能做到更好的结果。但是相信作者也是有一些权衡的,不止要考虑分辨率,还要考虑SNR, 尤其是梦境里面,噪音也需要注意一下。作为一个机器学习方向初学者来说,我个人认为,可以改进的地方还是有一些的,主要集中在模型部分。这个8层神经网络如果用一些更先进的模型,会不会有一些更好的效果。还有特征矩阵做平均,卷积神经网络在低层只是能对简单特征进行反应,一个物体的不同面的局部特征差异会比较大,这样做平均的结果,会导致实际的预测能力比较差。个人觉得或许一个好一些的方法是做继续前向,最后得出类别之后来做投票。除此之外,我个人还有一些其他想法,想来用我这边的一些东西来试着实现下。如果有一样对此有兴趣的同学,欢迎留言讨论。行为与认知神经科学 专栏的编辑亦有帮助。参考文献:本文使用的全部图片都来基于参考文献中的figure,做了适当裁剪和缩放。[1] Horikawa T, Tamaki M, Miyawaki Y, et al. Neural decoding of visualimagery during sleep[J]. Science, 2013, 340(6132): 639-642.[2] Horikawa T, Kamitani Y. Generic decoding of seen and imagined objectsusing hierarchical visual features[J]. arXiv preprint arXiv:1510.06479, 2015.[3] Horikawa T, Kamitani Y. Hierarchical Neural Representation of DreamedObjects Revealed by Brain Decoding with Deep Neural Network Features[J].Frontiers in computational neuroscience, 2017, 11. ————— 给爱学习的你的福利 —————随着大众互联网理财观念的逐步普及,理财规模随之扩大,应运而生的智能投顾,成本低、风险分散、无情绪化,越来越多的中产阶层、大众富裕阶层已然在慢慢接受。王蓁博士将以真实项目带你走上智能投顾之路,详情请识别下图二维码或点击文末阅读原文~———————————————————— via: http://mp.weixin.qq.com/s?__biz=MzI5NTIxNTg0OA==&mid=2247487972&idx=2&sn=938a6cd8f6a3cf383f4020769df9c889&scene=0#wechat_redirect

公告板 深度学习 视觉 算法 应用 自然语言处理 Brain Decoding Harold Yue SVM 分类 广告系统 机器翻译 神经科学 神经网络 王蓁 问题 语言学

「干货 | 用深度学习来解析梦境中出现的物体」AI科技评论按:本文作者Harold Yue,首发于知乎专栏神经科学和人工智能,AI科技评论获其授权转载。这篇文章主要的工作算是机器学习和神经科学的结合工作,需要读者在这两个方向有一定的基础。另有科普版本,结构更加清晰,不过删减了很多内容。科普版本如下:用深度学习来解析梦境中出现的物体 – 行为与认知神经科学( https://zhuanlan.zhihu.com/p/27948255)机器学习简介:机器学习算法是一类从数据中自动分析获得规律,并利用规律对未知数据进行预测的算法。最近大火的深度学习则是机器学习的一个分支,主要用基于人工神经网络的各种方法来实现目的,现在有很多变种,本文中使用的神经网络是一个卷积神经网络(Convolutional Neural Networks, CNN)。文章中神经科学实验部分主要使用的信号读取方法是功能磁共振( functional Magnetic Resonance Imaging,功能核磁共振),主要原理是通过监测脑区血流量的变化来间接测量脑区的活动程度,当一个脑区活动程度增强的时候,相应的血流量也会增加,为脑区输送更多的氧气,影响,以及排除废物。功能磁共振的空间分辨率很高,但其时间分辨率比较有限,只能采集到2s 左右时间内的平均活动程度,同时对于神经活动的检测有一定延时。前一周去开ASSC 的时候听到一个很有趣的工作,用深度学习来解析人类梦境中出现的物体类别。我见到的为数不多融合深度学习和神经科学的工作。回来之后翻了下相关文章,来在这分享下。本文介绍的总体思路:证明视知觉和梦境在视觉皮层上的神经活动有部分类似的激活模式。[1]以正常视知觉为训练集训练一个 Decoder,从被试的视觉皮层神经活动信号到最后的物体类别。这里是分成两部分,先从 fMRI 信号到特征空间,再从特征空间用相关性分析的办法推测物体类别。[2]用这个 Decoder 来预测梦境中的物体类别。[3]夹点私货,用里面的数据来说下视觉皮层和卷积神经网络底层的相似性,也算是解释了为什么用卷积神经网络的效果要更好。最后我个人从一个认知神经科学研究生和一个机器学习初学者的角度来分析下这个工作。前三点,对应了他们组发的三篇文章。我们从头开始说。先是13年的一个工作Neural Decoding of Visual Imagery During Sleep.实验部分实验过程中被试躺在核磁共振成像仪里面,在持续通过脑电图(electroencephalogram, EEG)来检测被试的睡眠状态的同时扫描大脑活动。在通过特定的脑电特征了解被试进入梦境状态之后,会叫醒被试并让其口头描述梦境内容。(如下图所示)结果部分在梦境实验之前,作者收集了被试们在看图片时候视觉皮层的Fmri信号,并基于此训练一个线性SVM(Support Vector Machine,支持向量机)分类器。并用此分类器尝试解码出被试在梦境状态下的看到的物体,这里作者使用的任务相对简单,是要在两个物体类别里面挑出正确的那一个。结果是预测准确率大于50%,高于随机水平,说明视知觉和梦境在视觉皮层有类似的信息表征机制。这个工作做的其实超前,在13年的时候大概是首次尝试解析梦境的工作,也是很早把机器学习和神经科学结合起来的工作,但是由于和今天的主题不是特别相关,所以只介绍了我需要的结果,至于具体用的思路和方法,在此略过,有兴趣的同学,可以自行查找原文。[1]接下来是重点,如何从被试看图片的 fMRI 信号中解出物体类别。实验部分作者在此主要做了两类实验,一类是正常看物体的图片,另一类是基于线索来想象物体的形象。在看物体实验中,被试会被呈现不同的图片,每张图片9秒钟。这里加了一个比较简单的小任务,当出现的图片和上一张出现的图片相同的时候,被试需要做按键反应。这里是为了让被试的注意维持在图片上。 第二类是想象实验,在线索阶段,会有1个目标词汇和49个干扰词出现,在听到‘滴’声之后,被试要闭上眼睛,想象目标词汇的形象。过了15s,听到‘滴’ 之后,睁眼,确认想象的形象是目标形象。 在实验进行的过程中,会采集被试视觉皮层的fMRI信号。从fMRI到物体类别接下来的数据分析工作,也就是从fMRI信号到物体类别是分两步走的,第一步是fMRI 信号到特征空间。作者在此用了一个8层预训练好的神经网络来做特征提取。在前七层中每层随机选1000个神经元,以及第八层的全部1000个神经元,把一张图片前向传播过网络后,这些神经元的输出作为特征。这样每张图片前向传播之后,可以获得一个 8层 * 1000 特征/层 的特征矩阵。之后是被试用被试的fMRI信号来训练一系列Decoder,从被试的fMRI信号来拟合不同层中不同特征的值。来实现从fMRI信号到特征空间的转换。第二步是从特征空间到物体的类别。这里作者首先做的是,计算各个物体类别的特征矩阵。他的做法是,每一个类别下面所有图片前向跑一遍网络,把生成的所有的特征矩阵平均,得到一个物体类别对应的特征矩阵。如果要计算上一步中,被试梦境中解码出来的特征矩阵具体对应着哪个类别的物体。这里做一个简单的相关,取相关系数最高的那个类别为预测类别。结 果这篇文章做出的结果不能说很好,但是确实为这个领域的应用提出了一个有趣的方向。这张图截取的是卷积神经网络部分预测准确率。可以看到,在被试真正看到图片的情况下,使用某些层的预测准确率可以到达很高,超过90%,在直接用这个网络迁移到想象情况下,也可以达到一个高于随机猜测的准确率。明显看出,现有模型对于想象图片的预测能力要差很多。其实想来有一定道理,第一就是,想象和直接看肯定有不同的底层视觉机制。第二就是模型是基于真正看图片的情况来训练的,迁移到另外一个相似却不完全相同的任务上表现表现自然会差一些。解梦的工作这篇文章是重点讲的。再重点也不会逐字翻译,我只会把整体的逻辑讲通。喜欢这篇文章的同学们欢迎去看原文。[3]这篇文章很巧妙的地方在于,他没做实验,用的是第一篇文章的数据和第二篇文章的模型。Single category feature decoding with averaged trials梦境中单物体类别的识别。这里用的是书的例子,被试在做梦的时候,可能会在多个梦境中都出现书这个物体,作者把这几个梦境对应的fMRI信号加起来做平均,然后通过文章2中训练处的Decoder 来预测出当前梦境的特征矩阵,之后和书这个类别的特征矩阵做相关。结果显示,高级脑区和神经网络的高层对于物体识别的效果比较好,当他们两结合在一起时候产生的效果最好。Multi-category feature decoding with individual trials当然,一个梦境里面只出现书也不现实,大家都有这样的经历,梦境更多是一整个场景,会出现多个物体,如上图,这个梦境中,除了书还有一个男人和食物。所以作者也做了这个实验,单个梦境里面多物体的识别。用的是单个梦境对应fMRI信号Decode出来的特征矩阵来和被试报告的所有类别的特征矩阵的平均矩阵做相关比较。这个预测结果更差了,但是从趋势上和上一个实验类似。高级脑区和网络的高层有更好的预测能力。最后一个实验,其实是重现了文章1中最后的实验,在两个物体类别中找到真正在梦境中出现的那个类别。用的方法也是特征矩阵的相关。准确率大大高于第一篇文章基于SVM(支持向量机)的结果。这里也可以看到的是,看到物体实验的结果在神经网络的中间层(4,5,6层)表现比较好,到最后层反倒有一个下降的趋势,这个趋势在想象的结果中也有体现。对于梦境这个实验,虽然预测效果同样大于随机猜测,但是在7层出现了一个下降而又在8层回升的现象,模式与看图片和想图片的模式不符。暗示梦境的神经机制和视知觉虽然有一定相似性,但是具体的机制还存在一定的差异。夹带私货。用这个文章的数据来简要讨论下卷积神经网络和人类视觉皮层的相似性。而这个相似性也是我写这篇文章的原因之一。Image feature decoding and the homology of CNN and the human brain.这个图出现在第二篇文章之中。a 是预测的特征矩阵不同层和实际的特征值的对比,有一定的重合,说明Decoder 确实在一定程度上学到了 从fMRI信号到卷积神经网络不同层特征的映射。B图是用不同视觉皮层预测出来的feature value 和 实际的feature value 的比较。这里比较有趣的是,低级的视觉皮层,如V1,V2,V3 在拟合低层卷积神经网络 的时候效果相对稍好,而高级视觉皮层(FFA ( fusiform face area,梭状回面孔识别区,神经科学研究发现主要参与人脸识别),PPA(Parahippocampal place area,神经科学发现主要参与场景识别))在拟合高层卷积神经网络的时候效果相对稍好。Preferred images and weight distributions for CNN layers.在神经科学领域,有类似的研究,证明 FFA,PPA 这种相对高级的皮层,会对更复杂的视觉刺激有比较强烈的反应,如FFA,主要对人脸反应,PPA 对物体,而底层皮层,如V1,V2,V3 更多的对底层视觉元素反应,如不同方向的线以及颜色等等。作者用一种 Activation Maximization 的方法来生成更能刺激相应层的图片,并用这些图片来给被试看,并用这些数据的fMRI来生成特征矩阵。发现了类似的现象。人越高级的皮层,拟合的结果对应高级卷积层的效果越好。这暗示着卷积神经网络和人类视觉皮层有一定的相似性,低级主管局部特征,高层主管语义特征。整体文章就完结了。可能有些朋友觉得看的一头雾水,我在这重新整理下行文逻辑。1.证明视知觉和梦境在视觉皮层上的神经活动有部分类似的 pattern。2.以正常视知觉为训练集训练一个 Decoder,从被试的视觉皮层神经活动信号到最后的物体类别。这里是分成两部分,先从 fMRI 信号到特征空间,再从特征空间用相关性分析的办法推测物体类别。3.用这个 Decoder 来预测梦境中的物体类别。4. 夹点私货,用里面的数据来说下 视觉皮层和 卷积神经网络底层的相似性,也算是解释了 为什么用卷积神经网络的效果要更好。5. 最后我个人从一个认知神经科学研究生和一个机器学习初学者的角度来分析下这个工作。个人对一系列文章的评价:很有趣的工作,13年的时候,第一次用fMRI+机器学习技术尝试解析梦境,15年的时候,能做到以一定的准确程度从被试的fMRI信号中成功解析看到的物体,从这两点来看,是非常有开创性的工作。除此之外,关于卷积神经网络 和相关脑区的比较也是比较有趣的工作,一定程度上说明了卷积神经网络和人类视觉皮层的相似性。作为一个认知神经科学研究生,我认为这几个实验做得挺好的,简单,但是十分有效,如果说有什么改进的话,就是如果能来和我们所合作,用7T更高分辨率来试一下是不是会更好啊,还有就是最新的一些序列可能能做到更好的结果。但是相信作者也是有一些权衡的,不止要考虑分辨率,还要考虑SNR, 尤其是梦境里面,噪音也需要注意一下。作为一个机器学习方向初学者来说,我个人认为,可以改进的地方还是有一些的,主要集中在模型部分。这个8层神经网络如果用一些更先进的模型,会不会有一些更好的效果。还有特征矩阵做平均,卷积神经网络在低层只是能对简单特征进行反应,一个物体的不同面的局部特征差异会比较大,这样做平均的结果,会导致实际的预测能力比较差。个人觉得或许一个好一些的方法是做继续前向,最后得出类别之后来做投票。除此之外,我个人还有一些其他想法,想来用我这边的一些东西来试着实现下。如果有一样对此有兴趣的同学,欢迎留言讨论。行为与认知神经科学 专栏的编辑亦有帮助。参考文献:本文使用的全部图片都来基于参考文献中的figure,做了适当裁剪和缩放。[1] Horikawa T, Tamaki M, Miyawaki Y, et al. Neural decoding of visualimagery during sleep[J]. Science, 2013, 340(6132): 639-642.[2] Horikawa T, Kamitani Y. Generic decoding of seen and imagined objectsusing hierarchical visual features[J]. arXiv preprint arXiv:1510.06479, 2015.[3] Horikawa T, Kamitani Y. Hierarchical Neural Representation of DreamedObjects Revealed by Brain Decoding with Deep Neural Network Features[J].Frontiers in computational neuroscience, 2017, 11. ————— 给爱学习的你的福利 —————随着大众互联网理财观念的逐步普及,理财规模随之扩大,应运而生的智能投顾,成本低、风险分散、无情绪化,越来越多的中产阶层、大众富裕阶层已然在慢慢接受。王蓁博士将以真实项目带你走上智能投顾之路,详情请识别下图二维码或点击文末阅读原文~———————————————————— via: http://mp.weixin.qq.com/s?__biz=MzI5NTIxNTg0OA==&mid=2247487972&idx=2&sn=938a6cd8f6a3cf383f4020769df9c889&scene=0#wechat_redirect

wx:奕欣 网页版 2017-11-04 23:39

算法 应用 知识工程 自然语言处理 代码 广告系统 韩旭 可视化 林衍凯 刘知远 涂存超 王蓁 谢若冰 张正彦 知识库

「开发 | 清华大学团队开源OpenKE与OpenNE工具包,助力NLP系统梳理」AI科技评论消息,近期,清华大学计算机科学与技术系自然语言处理实验室的刘知远助理教授所带领的团队动作频频。组内分别于 10月27日和11月2日先后开源了两个工具包 OpenNE 与 OpenKE 。网络表示能够衔接网络原始数据和网络应用任务,通过网络表示学习算法,可以从网络数据中获得网络中每个节点的向量表示,并将其作为节点特征应用于网络应用任务,如节点分类、链接预测和可视化等。AI科技评论获悉,清华大学博士生涂存超和本科生张正彦贡献的 OpenNE(Open-Source Network Embedding)针对网络表示学习(NE/NRL)进行了系统梳理,统一了 NE 模型的输入/输出/评测接口,并修订复现了经典的网络表示学习模型,包括DeepWalk, LINE, node2vec, GraRep, TADW, GCN等。GItHub地址: https://github.com/thunlp/OpenNE知识表示学习(Knowledge Embedding)旨在将知识图谱中实体与关系嵌入到低维向量空间中,有效提升知识计算效率。AI科技评论了解到,清华大学刘知远团队博士生韩旭、林衍凯和已毕业硕士生谢若冰于近期共同完成整理推出 OpenKE 平台。官网地址: http://openke.thunlp.org/index/about根据助理教授刘知远在微博上的介绍,主要功能包括:(1)TransE 、TransH、TransR、TransD、RESCAL、DistMult、HolE、ComplEx等算法的统一接口的高效实现。(2)面向WikiData和Freebase两大通用KG全量数据的预训练好的知识表示模型下载,不需要大家再费心重复训练。工具包目前托管在GitHub上: https://github.com/thunlp/OpenKE,欢迎大家下载使用。————— 给爱学习的你的福利 —————随着大众互联网理财观念的逐步普及,理财规模随之扩大,应运而生的智能投顾,成本低、风险分散、无情绪化,越来越多的中产阶层、大众富裕阶层已然在慢慢接受。王蓁博士将以真实项目带你走上智能投顾之路,详情请识别下图二维码或点击文末阅读原文~———————————————————— via: http://mp.weixin.qq.com/s?__biz=MzI5NTIxNTg0OA==&mid=2247487972&idx=3&sn=73ae30ba7c8ef727f4587c8f5d8d280e&scene=0#wechat_redirect

算法 应用 知识工程 自然语言处理 代码 广告系统 韩旭 可视化 林衍凯 刘知远 涂存超 王蓁 谢若冰 张正彦 知识库

「开发 | 清华大学团队开源OpenKE与OpenNE工具包,助力NLP系统梳理」AI科技评论消息,近期,清华大学计算机科学与技术系自然语言处理实验室的刘知远助理教授所带领的团队动作频频。组内分别于 10月27日和11月2日先后开源了两个工具包 OpenNE 与 OpenKE 。网络表示能够衔接网络原始数据和网络应用任务,通过网络表示学习算法,可以从网络数据中获得网络中每个节点的向量表示,并将其作为节点特征应用于网络应用任务,如节点分类、链接预测和可视化等。AI科技评论获悉,清华大学博士生涂存超和本科生张正彦贡献的 OpenNE(Open-Source Network Embedding)针对网络表示学习(NE/NRL)进行了系统梳理,统一了 NE 模型的输入/输出/评测接口,并修订复现了经典的网络表示学习模型,包括DeepWalk, LINE, node2vec, GraRep, TADW, GCN等。GItHub地址: https://github.com/thunlp/OpenNE知识表示学习(Knowledge Embedding)旨在将知识图谱中实体与关系嵌入到低维向量空间中,有效提升知识计算效率。AI科技评论了解到,清华大学刘知远团队博士生韩旭、林衍凯和已毕业硕士生谢若冰于近期共同完成整理推出 OpenKE 平台。官网地址: http://openke.thunlp.org/index/about根据助理教授刘知远在微博上的介绍,主要功能包括:(1)TransE 、TransH、TransR、TransD、RESCAL、DistMult、HolE、ComplEx等算法的统一接口的高效实现。(2)面向WikiData和Freebase两大通用KG全量数据的预训练好的知识表示模型下载,不需要大家再费心重复训练。工具包目前托管在GitHub上: https://github.com/thunlp/OpenKE,欢迎大家下载使用。————— 给爱学习的你的福利 —————随着大众互联网理财观念的逐步普及,理财规模随之扩大,应运而生的智能投顾,成本低、风险分散、无情绪化,越来越多的中产阶层、大众富裕阶层已然在慢慢接受。王蓁博士将以真实项目带你走上智能投顾之路,详情请识别下图二维码或点击文末阅读原文~———————————————————— via: http://mp.weixin.qq.com/s?__biz=MzI5NTIxNTg0OA==&mid=2247487972&idx=3&sn=73ae30ba7c8ef727f4587c8f5d8d280e&scene=0#wechat_redirect

wx:AI Lab 网页版 2017-11-04 23:39

会议活动 深度学习 视觉 算法 自然语言处理 CVPR ICCV ICLR ICML Li Fei-Fei Li-Jia Li 行业动态 会议 强化学习 神经网络 王蓁 语言学

「业界 | 腾讯 AI Lab 斩获 MSCOCO Captions 冠军,领衔图像描述生成技术」AI 科技评论按:图像描述生成技术是一个计算机视觉与 NLP 交叉研究领域的研究领域,在如今的浪潮下更显火热。今年8月,腾讯 AI Lab 凭借自主研发的强化学习算法在微软 MS COCO 相关的 Image Captioning 任务上排名第一,超过了微软、谷歌、IBM 等参赛公司。MS COCO (Microsoft Common Objects in Context,常见物体图像识别) 数据集( http://cocodataset.org/)是由微软发布并维护的图像数据集。在这个数据集上,共有物体检测 (Detection)、人体关键点检测 (Keypoints)、图像分割 (Stuff)、图像描述生成 (Captions) 四个类别的比赛任务。由于这些视觉任务是计算机视觉领域当前最受关注和最有代表性的,MS COCO 成为了图像理解与分析方向最重要的标杆之一。其中图像描述生成任务 (Captions),需要同时对图像与文本进行深度的理解与分析,相比其他三个任务更具有挑战性,因此也吸引了更多的工业界(Google,IBM,Microsoft)以及国际顶尖院校(UC Berkeley、Stanford University)的参赛队伍,迄今共有 80 个队伍参与这项比赛。通俗来说,图像描述生成(image captioning)研究的是使机器拥有人类理解图像的能力,并用人类语言描述感知到的图像内容。图像描述生成使得机器可以帮助有视觉障碍的人来理解图像,给图像提供除了标签(tag)以外更加丰富的描述,因此这项任务具有广泛的实际意义。从学术研究的角度来说,图像描述生成的研究不仅仅需要理解图像,更需要理解自然语言,是一个跨学科跨模态的交叉研究课题,也是对深度神经网络的学习能力向多个数据域扩展的一步重要的探索。因此,众多科技企业和科研机构参与了此任务,包括 Google [1][3]、Microsoft [5]、IBM [2]、Snapchat [4]、Montreal/Toronto University [6]、UC Berkeley [7]、 Stanford University [8]、百度 [9] 等。最近,腾讯 AI Lab 研发了新的强化学习算法(Reinforcement Learning)以进一步提高图像描述生成的模型能力,如上图所示。相应的图像描述生成模型,采用了编码器-解码器(encoder-decoder)[1] 的框架,同时引入了注意力(attention)的机制 [3]。基于之前研究的空间和通道注意力模型(spatial and channel-wise attention)[10] 的研究成果, AI Lab 构建了新网络模型引入了一个多阶段的注意力机制(Multi-stage Attention)。编码器,使用已有的图像卷积神经网络(CNN)如 VGG,Inception,ResNet 等,将给定的图像编码成为蕴含图像语义信息的向量。这些向量能够表征图像不同尺度的语义信息,譬如全局的语义、多尺度的局部语义。解码器,使用当前最流行的长短时记忆模型(LSTM),将编码器得到的图像的全局和局部语义向量,解码生成描述图像内容的文本语句。正是在解码的过程中,AI Lab 创新性地使用了多阶段的注意力机制:将图像不同尺度的局部语义信息,通过不同阶段的注意力模块,嵌入到每一个单词的生成过程中;同时注意力模块需要考虑不同尺度引入的不同阶段的注意力信号强弱。除了引入多阶段的注意力机制,AI Lab 所研发的强化学习算法能进一步提升构建的网络模型的训练效果。使用传统的交叉熵(cross entropy)作为损失函数进行训练,无法充分地优化图像描述生成的衡量指标,譬如 BLEU,METEOR,ROUGE,CIDER,SPICE 等。这些衡量指标作为损失函数都是不可微的。针对此不可微的问题,AI Lab 使用强化学习算法训练网络模型以优化这些衡量指标。训练过程可以总结为以下几个阶段:给定一幅图像,通过深度网络模型产生相应的语句;将相应的语句与标注语句比对以计算相应的衡量指标;使用强化学习构建深度网络模型的梯度信息,执行梯度下降完成网络的最终优化。经过充分的训练,腾讯 AI Lab 研发的图像描述生成模型在微软 MS COCO 的 Captions 任务上排名第一,超过了微软、谷歌、IBM 等科技公司。[1]. O. Vinyals, A. Toshev, S. Bengio, and D. Erhan,「Show and Tell: A Neural Image Caption Generator」, CVPR 2015.[2]. S. J. Rennie, E. Marcheret, Y. Mroueh, J. Ross, and V. Goel,「Self-critical Sequence Training for Image Captioning」, CVPR 2017.[3]. S. Liu; Z. Zhu; N. Ye; S. Guadarrama; and K. Murphy,「Improved Image Captioning via Policy Gradient Optimization of SPIDEr」, ICCV 2017.[4]. Z. Ren, X. Wang, N. Zhang, X. Lv, and Li-Jia Li,「Deep Reinforcement Learning-Based Image Captioning With Embedding Reward」, CVPR 2017.[5]. H. Fang, S. Gupta, F. Iandola, R. Srivastava, L. Deng, P. Dollár, J. Gao, X. He, M. Mitchell, J. Platt, C.L. Zitnick, and G. Zweig,「From Captions to Visual Concepts and Back」, CVPR 2015.[6]. K. Xu, J. Ba, R. Kiros, K. Cho, A. Courville, R. Salakhudinov, R. Zemel, and Y. Bengio. Show,「Attend and Tell: Neural Image Caption Generation with Visual Attention」, ICML 2015.[7]. J. Donahue, L. Hendricks, S. Guadarrama, M. Rohrbach, S. Venugopalan, K. Saenko, and T. Darrell,「Long-term Recurrent Convolutional Networks for Visual Recognition and Description」, CVPR 2015.[8]. A. Karpathy and Li Fei-Fei,「Deep Visual-Semantic Alignments for Generating Image Descriptions」, CVPR 2015.[9]. J. Mao, W. Xu, Y. Yang, J. Wang, and A. L. Yuille,「Deep Captioning with Multimodal Recurrent Neural Networks (m-RNN)」, ICLR 2015.[10]. L. Chen, H. Zhang, J. Xiao, L. Nie, J. Shao, W. Liu, and T. Chua,「SCA-CNN: Spatial and Channel-wise Attention in Convolutional Networks for Image Captioning」, CVPR 2017. ————— 给爱学习的你的福利 —————随着大众互联网理财观念的逐步普及,理财规模随之扩大,应运而生的智能投顾,成本低、风险分散、无情绪化,越来越多的中产阶层、大众富裕阶层已然在慢慢接受。王蓁博士将以真实项目带你走上智能投顾之路,详情请识别下图二维码或点击文末阅读原文~———————————————————— via: http://mp.weixin.qq.com/s?__biz=MzI5NTIxNTg0OA==&mid=2247487972&idx=4&sn=cc233614a39e4ec9951f4a2fdf21a6c6&scene=0#wechat_redirect

会议活动 深度学习 视觉 算法 自然语言处理 CVPR ICCV ICLR ICML Li Fei-Fei Li-Jia Li 行业动态 会议 强化学习 神经网络 王蓁 语言学

「业界 | 腾讯 AI Lab 斩获 MSCOCO Captions 冠军,领衔图像描述生成技术」AI 科技评论按:图像描述生成技术是一个计算机视觉与 NLP 交叉研究领域的研究领域,在如今的浪潮下更显火热。今年8月,腾讯 AI Lab 凭借自主研发的强化学习算法在微软 MS COCO 相关的 Image Captioning 任务上排名第一,超过了微软、谷歌、IBM 等参赛公司。MS COCO (Microsoft Common Objects in Context,常见物体图像识别) 数据集( http://cocodataset.org/)是由微软发布并维护的图像数据集。在这个数据集上,共有物体检测 (Detection)、人体关键点检测 (Keypoints)、图像分割 (Stuff)、图像描述生成 (Captions) 四个类别的比赛任务。由于这些视觉任务是计算机视觉领域当前最受关注和最有代表性的,MS COCO 成为了图像理解与分析方向最重要的标杆之一。其中图像描述生成任务 (Captions),需要同时对图像与文本进行深度的理解与分析,相比其他三个任务更具有挑战性,因此也吸引了更多的工业界(Google,IBM,Microsoft)以及国际顶尖院校(UC Berkeley、Stanford University)的参赛队伍,迄今共有 80 个队伍参与这项比赛。通俗来说,图像描述生成(image captioning)研究的是使机器拥有人类理解图像的能力,并用人类语言描述感知到的图像内容。图像描述生成使得机器可以帮助有视觉障碍的人来理解图像,给图像提供除了标签(tag)以外更加丰富的描述,因此这项任务具有广泛的实际意义。从学术研究的角度来说,图像描述生成的研究不仅仅需要理解图像,更需要理解自然语言,是一个跨学科跨模态的交叉研究课题,也是对深度神经网络的学习能力向多个数据域扩展的一步重要的探索。因此,众多科技企业和科研机构参与了此任务,包括 Google [1][3]、Microsoft [5]、IBM [2]、Snapchat [4]、Montreal/Toronto University [6]、UC Berkeley [7]、 Stanford University [8]、百度 [9] 等。最近,腾讯 AI Lab 研发了新的强化学习算法(Reinforcement Learning)以进一步提高图像描述生成的模型能力,如上图所示。相应的图像描述生成模型,采用了编码器-解码器(encoder-decoder)[1] 的框架,同时引入了注意力(attention)的机制 [3]。基于之前研究的空间和通道注意力模型(spatial and channel-wise attention)[10] 的研究成果, AI Lab 构建了新网络模型引入了一个多阶段的注意力机制(Multi-stage Attention)。编码器,使用已有的图像卷积神经网络(CNN)如 VGG,Inception,ResNet 等,将给定的图像编码成为蕴含图像语义信息的向量。这些向量能够表征图像不同尺度的语义信息,譬如全局的语义、多尺度的局部语义。解码器,使用当前最流行的长短时记忆模型(LSTM),将编码器得到的图像的全局和局部语义向量,解码生成描述图像内容的文本语句。正是在解码的过程中,AI Lab 创新性地使用了多阶段的注意力机制:将图像不同尺度的局部语义信息,通过不同阶段的注意力模块,嵌入到每一个单词的生成过程中;同时注意力模块需要考虑不同尺度引入的不同阶段的注意力信号强弱。除了引入多阶段的注意力机制,AI Lab 所研发的强化学习算法能进一步提升构建的网络模型的训练效果。使用传统的交叉熵(cross entropy)作为损失函数进行训练,无法充分地优化图像描述生成的衡量指标,譬如 BLEU,METEOR,ROUGE,CIDER,SPICE 等。这些衡量指标作为损失函数都是不可微的。针对此不可微的问题,AI Lab 使用强化学习算法训练网络模型以优化这些衡量指标。训练过程可以总结为以下几个阶段:给定一幅图像,通过深度网络模型产生相应的语句;将相应的语句与标注语句比对以计算相应的衡量指标;使用强化学习构建深度网络模型的梯度信息,执行梯度下降完成网络的最终优化。经过充分的训练,腾讯 AI Lab 研发的图像描述生成模型在微软 MS COCO 的 Captions 任务上排名第一,超过了微软、谷歌、IBM 等科技公司。[1]. O. Vinyals, A. Toshev, S. Bengio, and D. Erhan,「Show and Tell: A Neural Image Caption Generator」, CVPR 2015.[2]. S. J. Rennie, E. Marcheret, Y. Mroueh, J. Ross, and V. Goel,「Self-critical Sequence Training for Image Captioning」, CVPR 2017.[3]. S. Liu; Z. Zhu; N. Ye; S. Guadarrama; and K. Murphy,「Improved Image Captioning via Policy Gradient Optimization of SPIDEr」, ICCV 2017.[4]. Z. Ren, X. Wang, N. Zhang, X. Lv, and Li-Jia Li,「Deep Reinforcement Learning-Based Image Captioning With Embedding Reward」, CVPR 2017.[5]. H. Fang, S. Gupta, F. Iandola, R. Srivastava, L. Deng, P. Dollár, J. Gao, X. He, M. Mitchell, J. Platt, C.L. Zitnick, and G. Zweig,「From Captions to Visual Concepts and Back」, CVPR 2015.[6]. K. Xu, J. Ba, R. Kiros, K. Cho, A. Courville, R. Salakhudinov, R. Zemel, and Y. Bengio. Show,「Attend and Tell: Neural Image Caption Generation with Visual Attention」, ICML 2015.[7]. J. Donahue, L. Hendricks, S. Guadarrama, M. Rohrbach, S. Venugopalan, K. Saenko, and T. Darrell,「Long-term Recurrent Convolutional Networks for Visual Recognition and Description」, CVPR 2015.[8]. A. Karpathy and Li Fei-Fei,「Deep Visual-Semantic Alignments for Generating Image Descriptions」, CVPR 2015.[9]. J. Mao, W. Xu, Y. Yang, J. Wang, and A. L. Yuille,「Deep Captioning with Multimodal Recurrent Neural Networks (m-RNN)」, ICLR 2015.[10]. L. Chen, H. Zhang, J. Xiao, L. Nie, J. Shao, W. Liu, and T. Chua,「SCA-CNN: Spatial and Channel-wise Attention in Convolutional Networks for Image Captioning」, CVPR 2017. ————— 给爱学习的你的福利 —————随着大众互联网理财观念的逐步普及,理财规模随之扩大,应运而生的智能投顾,成本低、风险分散、无情绪化,越来越多的中产阶层、大众富裕阶层已然在慢慢接受。王蓁博士将以真实项目带你走上智能投顾之路,详情请识别下图二维码或点击文末阅读原文~———————————————————— via: http://mp.weixin.qq.com/s?__biz=MzI5NTIxNTg0OA==&mid=2247487972&idx=4&sn=cc233614a39e4ec9951f4a2fdf21a6c6&scene=0#wechat_redirect

wx:何智群 网页版 2017-11-04 20:45

会议活动 深度学习 视觉 算法 资源 Chris Rowen ICCV PCA PDF 代码 董远 樊应若 行业动态 何智群 华先胜 会议 活动 贾佳亚 卢湖川 神经网络 孙剑 文强 语言学 智能汽车 庄骏飞

「【视觉目标跟踪最高峰】VOT Challenge 2017 亚军北邮团队技术分享(附代码)」【AI WORLD 2017世界人工智能大会倒计时 4 天】 在2017年11月8日在北京国家会议中心举办的AI World 2017世界人工智能大会上,我们邀请到阿里巴巴副总裁、iDST副院长华先胜,旷视科技Face++首席科学家、旷视研究院院长孙剑博士,腾讯优图实验室杰出科学家贾佳亚教授,以及硅谷知名企业家、IEEE Fellow Chris Rowen,共论智慧城市、视觉AI新认知等前沿计算机视觉技术。 大会官网: http://www.aiworld2017.com 新智元报道 作者:何智群,北京邮电大学编辑:文强【新智元导读】视觉跟踪领域国际顶级赛事 Visual-Object-Tracking Challenge (VOT) 2017年结果出炉,结合传统滤波及深度学习的方案取得最佳成绩。本文是第二名北京邮电大学代表团队的技术分享。他们基于滤波的框架,抛弃传统特征,只使用CNN特征,减少了特征冗余,缓解了模型过拟合,使追踪器在速度和精度上都有不小的提高。代码分享链接: https://github.com/he010103/CFWCR.git 随着深度学习在计算机视觉方面大放异彩,近几年物体追踪也得到了飞速的发展。物体追踪解决的问题是在一段时间内对于同一个物体在复杂的背景下(如遮挡,光照,物体旋转等),进行持续高速的跟踪。因此,物体追踪是监控,安防,自动驾驶,无人机,智能家居等应用中必须解决的关键课题。 作为视觉跟踪领域的最高峰,Visual-Object-Tracking Challenge (VOT) 是国际目标跟踪领域最权威的测评平台,由伯明翰大学、卢布尔雅那大学、布拉格捷克技术大学、奥地利科技学院联合创办,旨在评测在复杂场景下单目标短时跟踪的算法性能。由于每年的评测序列都会更新,且标注的精确度一年一年提高,VOT竞赛也被视为视觉跟踪领域最难的竞赛,远远超过了其他数据集。因此,每年最好的追踪算法都会在上面一展拳脚,在激烈的比拼中擦出灵感的火花。 今年的比赛 VOT 2017,作为 ICCV 2017的一个workshop,吸引了来自全世界的38个队伍参加(CMU,中科院,法国科学院,香港理工,华中科技大学,国防科大,美国海军研究院,牛津大学,中国科技大学,浙江大学等),提交了38个新的算法参加了比赛,加上组委会自行提交的13个算法,总共对比分析了51个跟踪器在VOT2017 数据集上的表现。 在公开的38个队伍中,大连理工大学的卢湖川教授队伍夺得第一名。由北京邮电大学董远教授指导,北京飞搜科技&北京邮电大学代表队何智群、樊应若、庄骏飞、白洪亮提交的结果(CFWCR)获得VOT 2017竞赛公开的60个评测序列中第二名。 VOT 2017与VOT 2016相比,VOT 2016中某些序列已经被多数tracker准确跟踪,所以在VOT 2017中,将VOT 2016的10个评测效果差图像序列替换如图1,并且保证总体的序列属性分布不变。与此同时,VOT2017相对于VOT2016对所有序列的还对所有序列的ground truth进行了重新标定,精确到像素级别,然后重新拟合矩形框。 图1 vot2017标注变化图 VOT2017使用EAO(Expected Average Overlap)、Accuracy、Robustness三个主要指标对跟踪结果进行评估, 平均重叠期望(EAO)是对每个跟踪器在一个短时图像序列上的非重置重叠的期望值,是VOT评估跟踪算法精度的最重要指标。准确率(Accuracy)是指跟踪器在单个测试序列下的平均重叠率(两矩形框的相交部分面积除以两矩形框的相并部分的面积)。鲁棒性(Robustness)是指单个测试序列下的跟踪器失败次数,当重叠率为0时即可判定为失败。 今年的VOT结果如下: 图2 VOT2017结果图 VOT 2017结果显示,目前跟踪算法的主流方法主要分为三种,一是传统的相关滤波方法,二是基于卷积神经网络方法,三是深度卷积特征和传统的协同滤波相结合的方法。 其中,使用深度卷积特征和协同滤波结合的方法效果最好。例如今年VOT第一名,大连理工大学卢老师的LSART,他们提出的追踪器以一种新的方式结合了CNN和相关滤波,通过设计算法让CNN专注于特定区域的回归,相关滤波专注于全局的回归,在最后对回归的结果进行组合,以互补的方式得到物体的精确定位。 今年VOT的51个tracker中,深度特征和相关滤波结合的方法共9种,采用如VGG网络提取特征再输入到相关滤波框架内,以非端到端线上更新滤波参数,达到准确追踪的效果。这9种深度特征和相关滤波结合的方法在VOT2017种表现均较为出色,包揽了前四名。 北京飞搜科技&北京邮电大学代表队提交的结果(CFWCR)获得VOT 2017竞赛公开的60个评测序列中第二名。 我们的方法基于业界流行的相关滤波的框架。我们使用了单CNN特征的多尺度追踪方案。现有很多追踪器融合了CNN特征和传统的机器学习特征,如hog特征,CN颜色特征等。在我们的实验中,我们发现CNN的浅层特征具有物体轮廓的信息,高层的深度特征具有物体的语义信息,将CNN的浅层和高层特征进行融合,能使追踪器具有很好的性能。 CNN的特征和传统特征的融合会使得特征的冗余太多,容易导致参数更新的时候模型过拟合,解决过拟合的一种方法是用PCA对特征进行降维。但是,过于复杂的特征组合方式不太利于超参数的精调,我们摒弃了传统的特征,只使用了CNN的特征。这一做法,减少了我们的特征冗余,模型过拟合的情况得到很大的缓解,使得我们的追踪器无论是在速度上还是精度上都有了不小的提高。 图3 CFWCR追踪效果对比图 使用相关滤波框架的一大困难是具有很多的超参数,这和目前主流的端到端深度学习训练框架有很大的不同。我们发现用PCA对特征进行压缩,能使得追踪器在追踪速度上有很大的提高,但是性能会略有下降。因此,我们在评测上没有使用PCA,而在实用的追踪系统中用PCA能更好地均衡速度和精度。 此外,我们发现,在评测中,增加候选尺度的数量能使我们的追踪器更好地适应物体在时间序列中形状的变化。最后,我们对CNN的轮廓信息和语义信息进行了加权融合,以最优的方法对特征进行组合。 下面是我们的追踪器在不同的序列长度下的表现曲线。可以看到,我们的算法在短视频序列的表现明显优于其他主流的算法。 图4 CFWCR重叠率性能图 连续两年的VOT比赛中,基于相关滤波和CNN结合的追踪器表现突出,在性能指标上遥遥领先于其他算法。然而,非端到端的训练框架拥有很多的超参数,线上更新的方式也使得在实际算法部署的过程中,目前性能最优的一些追踪器难以满足实时性的要求。 视觉追踪方向和物体检测、物体分割方向不同的一点,在于CNN并没有完全发挥它的强大作用。未来的视觉追踪方向应该会更加关注实时性和训练的便捷性,端到端训练的追踪器会更多涌现,让CNN能够完全在视觉追踪领域发挥功效。我们也将继续在视觉跟踪领域深入研究,希望能给学术界和工业界做一些小小的贡献! 代码分享链接: https://github.com/he010103/CFWCR.git 参考资料[1] http://www.votchallenge.net[2]http://openaccess.thecvf.com/content_ICCV_2017_workshops/papers/w28/Kristan_The_Visual_Object_ICCV_2017_paper.pdf[3]http://openaccess.thecvf.com/content_ICCV_2017_workshops/papers/w28/He_Correlation_Filters_With_ICCV_2017_paper.pdf 想要了解更多计算机视觉技术前沿及产业应用?11月8日,欢迎来新智元世界人工智能大会,马上抢票! 【AI WORLD 2017世界人工智能大会倒计时 4 天】点击图片查看嘉宾与日程。抢票链接: http://www.huodongxing.com/event/2405852054900?td=4231978320026AI WORLD 2017 世界人工智能大会购票二维码: via: http://mp.weixin.qq.com/s?__biz=MzI3MTA0MTk1MA==&mid=2652007262&idx=2&sn=2d7e661cfe31909bb41523540221ee9a&scene=0#wechat_redirect

会议活动 深度学习 视觉 算法 资源 Chris Rowen ICCV PCA PDF 代码 董远 樊应若 行业动态 何智群 华先胜 会议 活动 贾佳亚 卢湖川 神经网络 孙剑 文强 语言学 智能汽车 庄骏飞

「【视觉目标跟踪最高峰】VOT Challenge 2017 亚军北邮团队技术分享(附代码)」【AI WORLD 2017世界人工智能大会倒计时 4 天】 在2017年11月8日在北京国家会议中心举办的AI World 2017世界人工智能大会上,我们邀请到阿里巴巴副总裁、iDST副院长华先胜,旷视科技Face++首席科学家、旷视研究院院长孙剑博士,腾讯优图实验室杰出科学家贾佳亚教授,以及硅谷知名企业家、IEEE Fellow Chris Rowen,共论智慧城市、视觉AI新认知等前沿计算机视觉技术。 大会官网: http://www.aiworld2017.com 新智元报道 作者:何智群,北京邮电大学编辑:文强【新智元导读】视觉跟踪领域国际顶级赛事 Visual-Object-Tracking Challenge (VOT) 2017年结果出炉,结合传统滤波及深度学习的方案取得最佳成绩。本文是第二名北京邮电大学代表团队的技术分享。他们基于滤波的框架,抛弃传统特征,只使用CNN特征,减少了特征冗余,缓解了模型过拟合,使追踪器在速度和精度上都有不小的提高。代码分享链接: https://github.com/he010103/CFWCR.git 随着深度学习在计算机视觉方面大放异彩,近几年物体追踪也得到了飞速的发展。物体追踪解决的问题是在一段时间内对于同一个物体在复杂的背景下(如遮挡,光照,物体旋转等),进行持续高速的跟踪。因此,物体追踪是监控,安防,自动驾驶,无人机,智能家居等应用中必须解决的关键课题。 作为视觉跟踪领域的最高峰,Visual-Object-Tracking Challenge (VOT) 是国际目标跟踪领域最权威的测评平台,由伯明翰大学、卢布尔雅那大学、布拉格捷克技术大学、奥地利科技学院联合创办,旨在评测在复杂场景下单目标短时跟踪的算法性能。由于每年的评测序列都会更新,且标注的精确度一年一年提高,VOT竞赛也被视为视觉跟踪领域最难的竞赛,远远超过了其他数据集。因此,每年最好的追踪算法都会在上面一展拳脚,在激烈的比拼中擦出灵感的火花。 今年的比赛 VOT 2017,作为 ICCV 2017的一个workshop,吸引了来自全世界的38个队伍参加(CMU,中科院,法国科学院,香港理工,华中科技大学,国防科大,美国海军研究院,牛津大学,中国科技大学,浙江大学等),提交了38个新的算法参加了比赛,加上组委会自行提交的13个算法,总共对比分析了51个跟踪器在VOT2017 数据集上的表现。 在公开的38个队伍中,大连理工大学的卢湖川教授队伍夺得第一名。由北京邮电大学董远教授指导,北京飞搜科技&北京邮电大学代表队何智群、樊应若、庄骏飞、白洪亮提交的结果(CFWCR)获得VOT 2017竞赛公开的60个评测序列中第二名。 VOT 2017与VOT 2016相比,VOT 2016中某些序列已经被多数tracker准确跟踪,所以在VOT 2017中,将VOT 2016的10个评测效果差图像序列替换如图1,并且保证总体的序列属性分布不变。与此同时,VOT2017相对于VOT2016对所有序列的还对所有序列的ground truth进行了重新标定,精确到像素级别,然后重新拟合矩形框。 图1 vot2017标注变化图 VOT2017使用EAO(Expected Average Overlap)、Accuracy、Robustness三个主要指标对跟踪结果进行评估, 平均重叠期望(EAO)是对每个跟踪器在一个短时图像序列上的非重置重叠的期望值,是VOT评估跟踪算法精度的最重要指标。准确率(Accuracy)是指跟踪器在单个测试序列下的平均重叠率(两矩形框的相交部分面积除以两矩形框的相并部分的面积)。鲁棒性(Robustness)是指单个测试序列下的跟踪器失败次数,当重叠率为0时即可判定为失败。 今年的VOT结果如下: 图2 VOT2017结果图 VOT 2017结果显示,目前跟踪算法的主流方法主要分为三种,一是传统的相关滤波方法,二是基于卷积神经网络方法,三是深度卷积特征和传统的协同滤波相结合的方法。 其中,使用深度卷积特征和协同滤波结合的方法效果最好。例如今年VOT第一名,大连理工大学卢老师的LSART,他们提出的追踪器以一种新的方式结合了CNN和相关滤波,通过设计算法让CNN专注于特定区域的回归,相关滤波专注于全局的回归,在最后对回归的结果进行组合,以互补的方式得到物体的精确定位。 今年VOT的51个tracker中,深度特征和相关滤波结合的方法共9种,采用如VGG网络提取特征再输入到相关滤波框架内,以非端到端线上更新滤波参数,达到准确追踪的效果。这9种深度特征和相关滤波结合的方法在VOT2017种表现均较为出色,包揽了前四名。 北京飞搜科技&北京邮电大学代表队提交的结果(CFWCR)获得VOT 2017竞赛公开的60个评测序列中第二名。 我们的方法基于业界流行的相关滤波的框架。我们使用了单CNN特征的多尺度追踪方案。现有很多追踪器融合了CNN特征和传统的机器学习特征,如hog特征,CN颜色特征等。在我们的实验中,我们发现CNN的浅层特征具有物体轮廓的信息,高层的深度特征具有物体的语义信息,将CNN的浅层和高层特征进行融合,能使追踪器具有很好的性能。 CNN的特征和传统特征的融合会使得特征的冗余太多,容易导致参数更新的时候模型过拟合,解决过拟合的一种方法是用PCA对特征进行降维。但是,过于复杂的特征组合方式不太利于超参数的精调,我们摒弃了传统的特征,只使用了CNN的特征。这一做法,减少了我们的特征冗余,模型过拟合的情况得到很大的缓解,使得我们的追踪器无论是在速度上还是精度上都有了不小的提高。 图3 CFWCR追踪效果对比图 使用相关滤波框架的一大困难是具有很多的超参数,这和目前主流的端到端深度学习训练框架有很大的不同。我们发现用PCA对特征进行压缩,能使得追踪器在追踪速度上有很大的提高,但是性能会略有下降。因此,我们在评测上没有使用PCA,而在实用的追踪系统中用PCA能更好地均衡速度和精度。 此外,我们发现,在评测中,增加候选尺度的数量能使我们的追踪器更好地适应物体在时间序列中形状的变化。最后,我们对CNN的轮廓信息和语义信息进行了加权融合,以最优的方法对特征进行组合。 下面是我们的追踪器在不同的序列长度下的表现曲线。可以看到,我们的算法在短视频序列的表现明显优于其他主流的算法。 图4 CFWCR重叠率性能图 连续两年的VOT比赛中,基于相关滤波和CNN结合的追踪器表现突出,在性能指标上遥遥领先于其他算法。然而,非端到端的训练框架拥有很多的超参数,线上更新的方式也使得在实际算法部署的过程中,目前性能最优的一些追踪器难以满足实时性的要求。 视觉追踪方向和物体检测、物体分割方向不同的一点,在于CNN并没有完全发挥它的强大作用。未来的视觉追踪方向应该会更加关注实时性和训练的便捷性,端到端训练的追踪器会更多涌现,让CNN能够完全在视觉追踪领域发挥功效。我们也将继续在视觉跟踪领域深入研究,希望能给学术界和工业界做一些小小的贡献! 代码分享链接: https://github.com/he010103/CFWCR.git 参考资料[1] http://www.votchallenge.net[2]http://openaccess.thecvf.com/content_ICCV_2017_workshops/papers/w28/Kristan_The_Visual_Object_ICCV_2017_paper.pdf[3]http://openaccess.thecvf.com/content_ICCV_2017_workshops/papers/w28/He_Correlation_Filters_With_ICCV_2017_paper.pdf 想要了解更多计算机视觉技术前沿及产业应用?11月8日,欢迎来新智元世界人工智能大会,马上抢票! 【AI WORLD 2017世界人工智能大会倒计时 4 天】点击图片查看嘉宾与日程。抢票链接: http://www.huodongxing.com/event/2405852054900?td=4231978320026AI WORLD 2017 世界人工智能大会购票二维码: via: http://mp.weixin.qq.com/s?__biz=MzI3MTA0MTk1MA==&mid=2652007262&idx=2&sn=2d7e661cfe31909bb41523540221ee9a&scene=0#wechat_redirect

深度学习 视觉

【新智元导读】视觉跟踪领域国际顶级赛事 Visual-Object-Tracking Challenge (VOT) 2017年结果出炉,结合传统滤波及深度学习的方案取得最佳成绩。本文是第二名北京邮电大学代表团队的技术分享。他们基于滤波的框架,抛弃传统特征,只使用CNN特征,减少了特征冗余,缓解了模型过拟合,使追踪器在速度和…全文: http://m.weibo.cn/5703921756/4170348263889438

深度学习 算法 神经网络

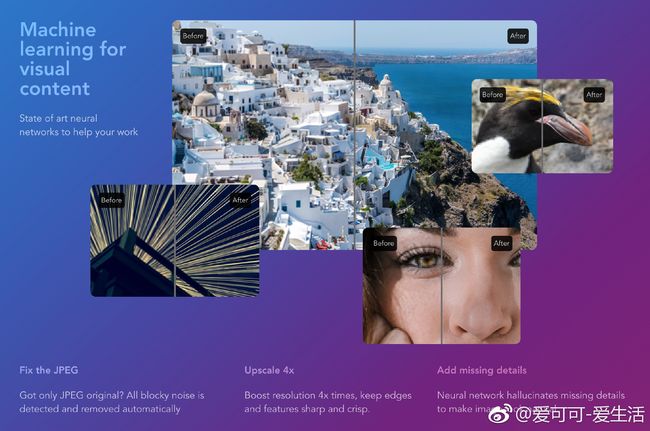

【深度网络超分辨率在线服务letsenhance.io】“Let’s Enhance – free online image upscale and enhancement with neural networks” http://t.cn/RltvbPn

深度学习 算法 ELM Python 代码

Python机器学习库和深度学习库总结 >>>> 习神经影像数据的Python模块。它利用Python语言中的scikit-learn 工具箱和一些进行预测建模,分类,解码,连通性分析的应用程序来进行多元的统计…集。 22.Python-ELM www.github.com/dclambert/Python-ELM 这是一个在Python语言下基于scikit-le …全文: http://m.weibo.cn/5291384903/4170257645918895

Kaggle 数据科学

【Kaggle Data Science Bowl 2017优胜方案(全流程】“Walkthough of winning submission for the Kaggle Data Science Bowl 2017” by grt123 http://t.cn/Rl5vj5t data: http://t.cn/Rl5vj5c

硅谷中人 网页版 2017-11-04 06:39

硅谷中人 网页版 2017-11-04 06:39

算法 应用 机器人

#人工智能#进入投资界,操盘ETF。华尔街的同学,你们怕了吗? 第一发,10月18日,美国的AI Powered Equity ETF(代码:AIEQ)上市。 AIEQ在IBM Watson平台上用AI算法 (The “EquBot Model”)选股。选股范围为美股。 第二发,今天(11月3日),韩国人的完全由机器人操盘的面向全球市场的Horizons Active AI…全文: http://m.weibo.cn/1717540653/4170250867686208

深度学习 代码

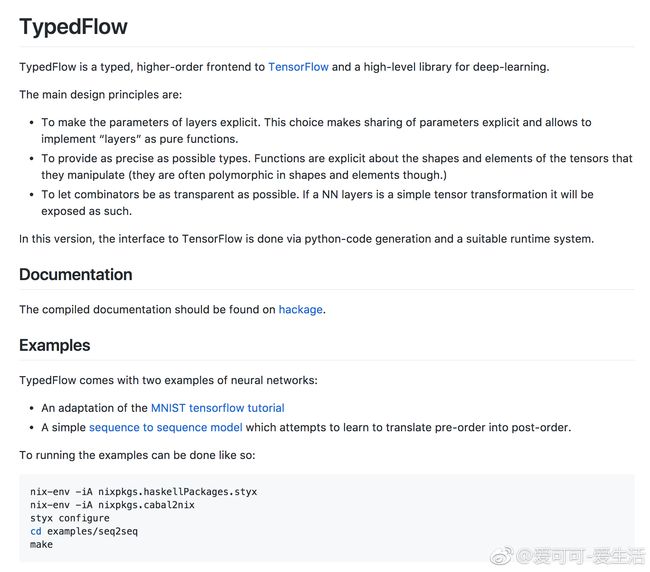

‘TypedFlow – a typed, higher-order frontend to TensorFlow and a high-level library for deep-learning’ by CLASP GitHub: https:\//github.com\/GU-CLASP/TypedFlow