20180610hadoop的初识以及完全安装

第一部分:分布式了解

相对于集中式

集中式特点:

一台机器,所有东西(软件)都放在此计算机上(安装)

分布式特点:

多台机器:将东西进行划分,每台机器存储一部分

主从架构

主节点:管理,项目经理, 管理者,调度者

从节点: 被管理者,干活的

集中式特点:

一台机器,所有东西(软件)都放在此计算机上(安装)

分布式特点:

多台机器:将东西进行划分,每台机器存储一部分

主从架构

主节点:管理,项目经理, 管理者,调度者

从节点: 被管理者,干活的

分布式文件系统HDFS

主节点: NameNode:就是在系统中启动一个进程JVM process

功能: 将存储的文件划分block块进行存储(128M),每个block的副本是3个。

从节点: DataNode真正存储数据块的地方(实际存储在机器的硬盘上)

主节点: NameNode:就是在系统中启动一个进程JVM process

功能: 将存储的文件划分block块进行存储(128M),每个block的副本是3个。

从节点: DataNode真正存储数据块的地方(实际存储在机器的硬盘上)

分布式集群资源管理YARN

集群的资源(内存和cpu core)

任务(job)调度

主节点: ResouceManager:管理集群的所有资源, 接收客户端提交的应用

从节点: NodeManager:管理当前节点资源

集群的资源(内存和cpu core)

任务(job)调度

主节点: ResouceManager:管理集群的所有资源, 接收客户端提交的应用

从节点: NodeManager:管理当前节点资源

伪分布式安装

从创建一个虚拟机,并对虚拟机进行网络配置开始。

1、创建一个虚拟机

1、创建一个虚拟机

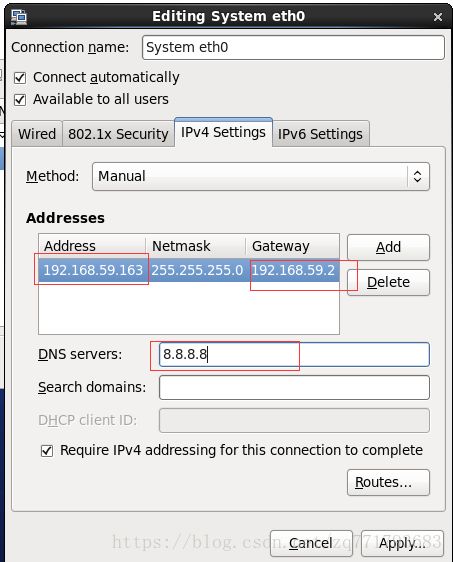

2、修改VMware Vmnt8的适配器网段地址192.168.59.0

3、修改主机名:vi /etc/syconfig/network

4、配置ip和主机名映射

vi /etc/hosts

192.168.59.160 bigdata-hpsk01.huadian.com bigdata-hpsk01

测试:ping bigdata-hpsk01.huadian.com

注意:window也改一下,

C:\Windows\System32\drivers\etc\hosts

192.168.59.160 bigdata-hpsk01.huadian.com bigdata-hpsk01

192.168.59.160 bigdata-hpsk01.huadian.com bigdata-hpsk01

测试:ping bigdata-hpsk01.huadian.com

注意:window也改一下,

C:\Windows\System32\drivers\etc\hosts

192.168.59.160 bigdata-hpsk01.huadian.com bigdata-hpsk01

5、使用远程连接

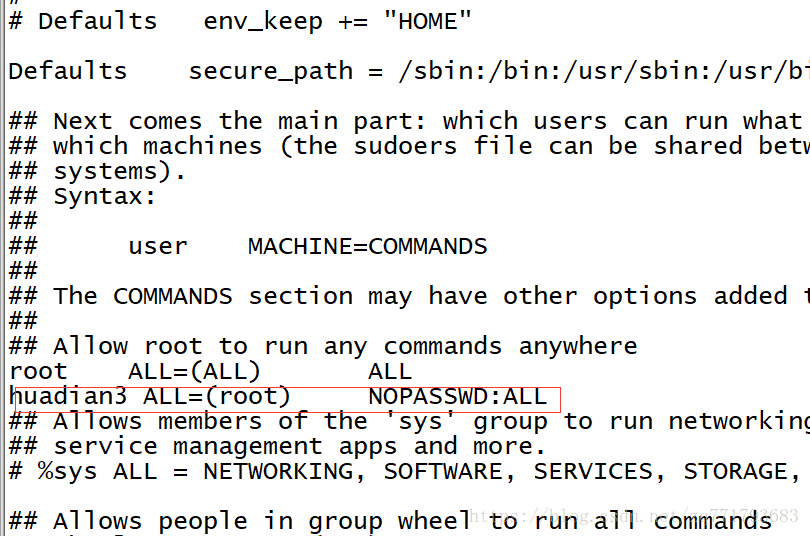

6、配置自己的普通用户拥有sudo权限 visudo

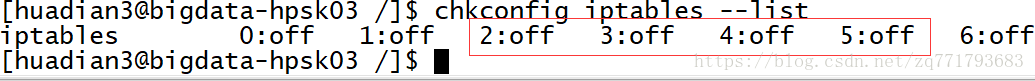

7、关闭防火墙

当前关闭:

sudo service iptables stop

8、在opt下创建四个目录 /datas /softwares /modules /tools

修改四个目录所属者跟所属组:chown huadian:huadian /datas /softwares /modules /tools

修改四个目录所属者跟所属组:chown huadian:huadian /datas /softwares /modules /tools

9、下载Linux自带的上传与下载的软件:sudo yum install -y lrzsz

10、安装jdk

注意:Linux安装jdk类似于Windows安装一个绿色版本软件直接解压,然后配置环境变量即可

(1)使用rz将jdk上传到/opt/softwares

(2)解压: tar -zxf jdk-8u91-linux-x64.tar.gz -C /opt/modules/

(3)配置环境变量

sudo vi /etc/profile

#JAVA_HOME

export JAVA_HOME=/opt/modules/jdk1.8.0_91

export PATH=${PATH}:${JAVA_HOME}/bin

使其生效: source /etc/profile

验证: java -version

(1)使用rz将jdk上传到/opt/softwares

(2)解压: tar -zxf jdk-8u91-linux-x64.tar.gz -C /opt/modules/

(3)配置环境变量

sudo vi /etc/profile

#JAVA_HOME

export JAVA_HOME=/opt/modules/jdk1.8.0_91

export PATH=${PATH}:${JAVA_HOME}/bin

使其生效: source /etc/profile

验证: java -version

11、关机,快照

12、开机,开始伪分布式安装,上传解压

12、开机,开始伪分布式安装,上传解压

13、查看目录结构,并删除里面的文件:

bin/*.cmd

sbin/*.cmd share/doc

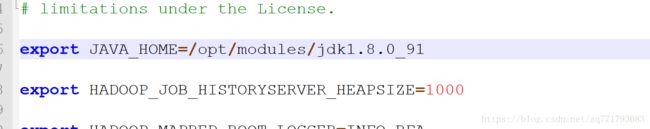

14、修改三个模块的环境变量(*.evn):hadoop-env.sh、 yarn-env.sh、mapred-env.sh

14、修改三个模块的环境变量(*.evn):hadoop-env.sh、 yarn-env.sh、mapred-env.sh

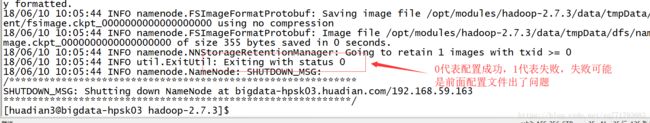

16、common配置:core-site.xml

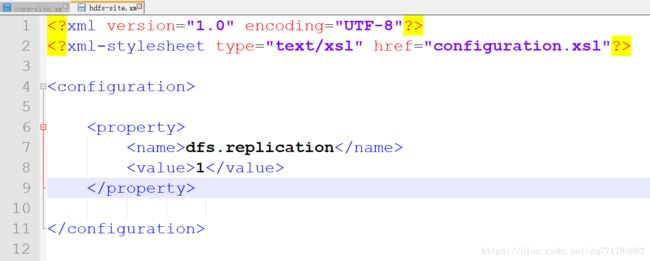

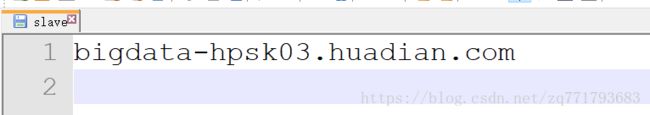

17、HDFS配置:hdfs-site.xml slaves

18、启动HDFS

格式系统:

bin/hdfs namenode -format

启动

主节点

sbin/hadoop-daemon.sh start namenode

sbin/hadoop-daemon.sh stop namenode

从节点

sbin/hadoop-daemon.sh start datanode

sbin/hadoop-daemon.sh stop datanode

验证是否启动成功

方式一:jsp

方式二: 通过webUI 界面查看bigdata-hpsk03.huadian.com:50070

测试HDFS

帮助文档: bin/hdfs dfs

HDFS文件系统目录和Linux目录结构类似, 命令也类似

创建目录: bin/hdfs dfs -mkdir /datas

查看目录: bin/hdfs dfs -ls /datas

上传文件: bin/hdfs dfs -put /opt/datas/input.data /datas/

查看文件内容: bin/hdfs dfs -text /datas/input.data

下载文件: bin/hdfs dfs -get /datas/input.data ./

删除文件: bin/hdfs dfs -rm -r /datas/input.data

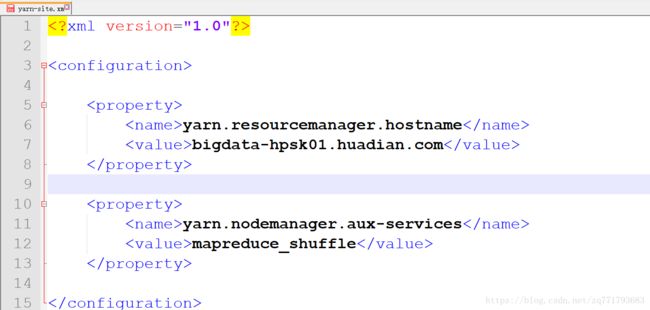

19、配置YARN,yarn-site.xml,slavex(前面以及配置过)

帮助文档: bin/hdfs dfs

HDFS文件系统目录和Linux目录结构类似, 命令也类似

创建目录: bin/hdfs dfs -mkdir /datas

查看目录: bin/hdfs dfs -ls /datas

上传文件: bin/hdfs dfs -put /opt/datas/input.data /datas/

查看文件内容: bin/hdfs dfs -text /datas/input.data

下载文件: bin/hdfs dfs -get /datas/input.data ./

删除文件: bin/hdfs dfs -rm -r /datas/input.data

19、配置YARN,yarn-site.xml,slavex(前面以及配置过)

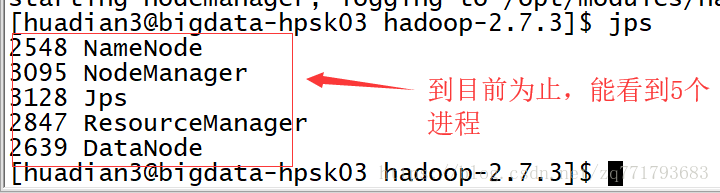

20、启动节点

启动:

主节点:resourceManager

sbin/yarn-daemon.sh start resourcemanager

从节点:nodeManager sbin/yarn-daemon.sh start nodemanager

验证:

方式一:jps === ps -ef |grep java

方式二:bigdata-hpsk01.huadian.com:8088

从节点:nodeManager sbin/yarn-daemon.sh start nodemanager

验证:

方式一:jps === ps -ef |grep java

方式二:bigdata-hpsk01.huadian.com:8088

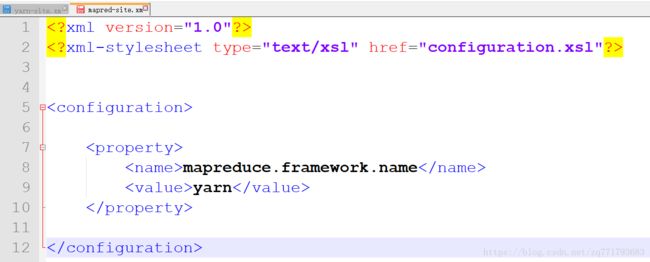

21、MapReduce配置 首先在/etc/hadoop 运行cp mapred-site.xml.template mapred-site.xml

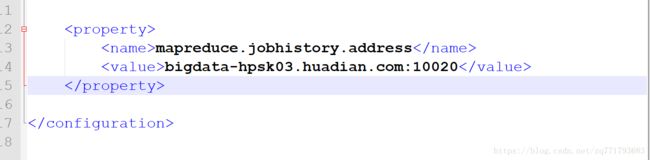

22、配置历史服务器 mapred-site.xml 启动历史服务器sbin/mr-jobhistory-daemon.sh start historyserver

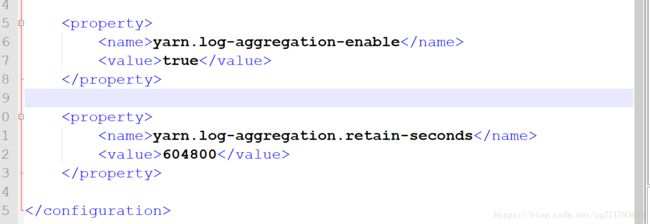

23、日志聚集功能 yarn-site.xml

24、到此为止,全部配完,关机,快照