Windows下搭建本地hadoop开发环境(单机版),Are you Get?

一、下载必备安装包

1.JDK下载地址:点击打开链接

2.Hadoop下载地址:点击打开链接

3.Windows下安装Hadoop工具下载地址:点击打开链接 密码:yk9u

二、Hadoop环境配置

下载Hadoop,并解压到你的本地目录,我下载的是hadoop-2.6.5版本,解压在D:\hadoop\hadoop-2.6.5。

三、配置Hadoop的环境变量

1.计算机 –>属性 –>高级系统设置 –>高级选项卡 –>环境变量 –> 单击新建HADOOP_HOME

注意:路径到bin的上级目录即可。

2.Path环境变量下配置【%HADOOP_HOME%\bin;】变量

四、配置Hadoop文件

1.编辑“E:\hadoop\hadoop-2.6.5\etc\hadoop”下的core-site.xml文件,将下列文本粘贴进去,并保存。

hadoop.tmp.dir

/D:/hadoop/workplace/tmp

dfs.name.dir

/D:/hadoop/workplace/name

fs.default.name

hdfs://localhost:9000

2.编辑“E:\hadoop\hadoop-2.6.5\etc\hadoop”目录下的mapred-site.xml(如果不存在将mapred-site.xml.template重命名为mapred-site.xml)文件,粘贴一下内容并保存。

mapreduce.framework.name

yarn

mapred.job.tracker

hdfs://localhost:9001

3.编辑“E:\hadoop\hadoop-2.6.5\etc\hadoop”目录下的hdfs-site.xml文件,粘贴以下内容并保存。

dfs.replication

1

dfs.data.dir

/D:/hadoop/workplace/data

4.编辑“E:\hadoop\hadoop-2.6.5\etc\hadoop”目录下的yarn-site.xml文件,粘贴以下内容并保存。

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.aux-services.mapreduce.shuffle.class

org.apache.hadoop.mapred.ShuffleHandler

5.编辑“E:\hadoop\hadoop-2.6.5\etc\hadoop”目录下的hadoop-env.cmd文件,将JAVA_HOME用 @rem注释掉,编辑为JAVA_HOME的路径,然后保存。

@rem set JAVA_HOME=%JAVA_HOME%

set JAVA_HOME=E:\java\jdk9.0.1

五、替换文件

将1.3下载到的hadooponwindows-master.zip,解压,将全部bin目录文件替换至hadoop目录下的bin目录。

六、运行环境

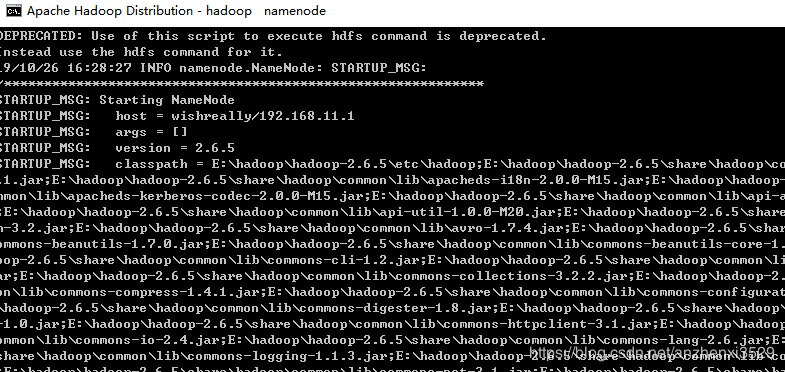

1.运行cmd窗口,执行hdfs namenode -format。

E:\hadoop\hadoop-2.6.5\etc\hadoop>hdfs namenode -format

19/10/26 15:40:31 INFO namenode.NameNode: STARTUP_MSG:

/************************************************************

STARTUP_MSG: Starting NameNode

STARTUP_MSG: host = wishreally/192.168.11.1

STARTUP_MSG: args = [-format]

STARTUP_MSG: version = 2.6.5

STARTUP_MSG: classpath = E:\hadoop\hadoop-2.6.5\etc\hadoop;E:\hadoop\hadoop-2.6.5\share\hadoop\common\lib\activation-1

.1.jar;E:\hadoop\hadoop-2.6.5\share\hadoop\common\lib\apacheds-i18n-2.0.0-M15.jar;E:\hadoop\hadoop-2.6.5\share\hadoop\co

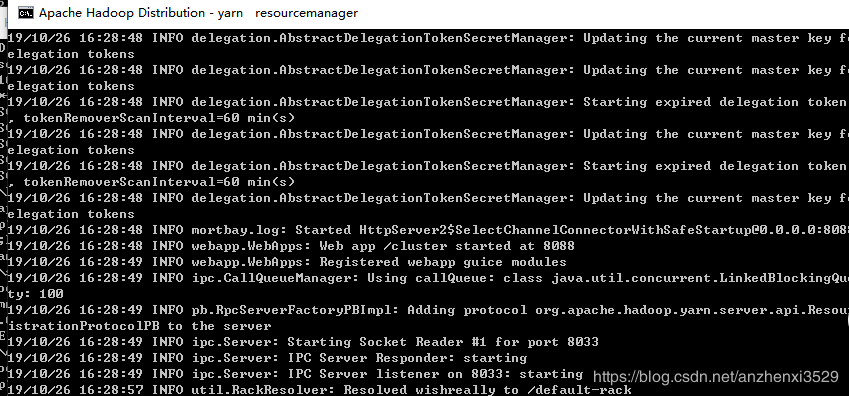

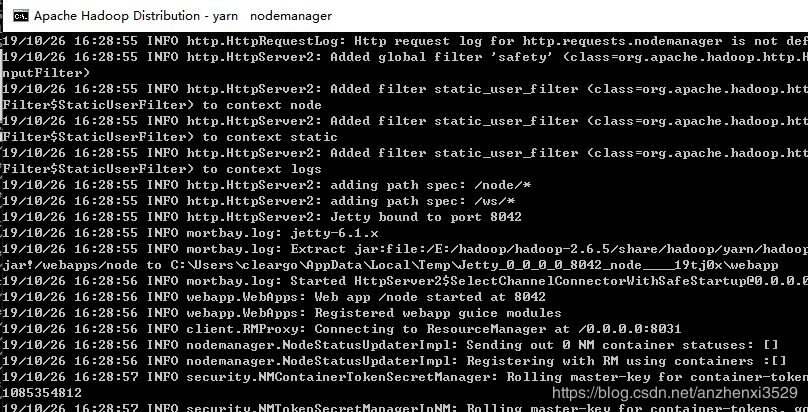

mmon\lib\apacheds-kerberos-codec-2.0.0-M15.jar;E:\hadoop\hadoop-2.6.5\share\hadoop\common\lib\api-asn1-api-1.0.0-M20.jar2.运行cmd窗口,切换到hadoop的sbin目录,执行start-all.cmd,它将会启动以下4个进程窗口。

七、上传测试

根据你core-site.xml的配置,接下来你就可以通过:hdfs://localhost:9000来对hdfs进行操作了。

1.在HDFS系统中创建目录(具体相关详细的hdfs命令到我的另外博客文章中查找)

C:\WINDOWS\system32>hadoop fs -mkdir hdfs://localhost:9000/user/

2.上传数据文件到hdfs指定目录下:

E:\hadoop\hadoop-2.6.5\sbin>hadoop fs -put "E:\HELLO CHINA.txt" /user

3.查看文件

E:\hadoop\hadoop-2.6.5\sbin>hadoop fs -ls /user

WARNING: An illegal reflective access operation has occurred

WARNING: Illegal reflective access by org.apache.hadoop.security.authentication.util.KerberosUtil (file:/E:/hadoop/hadoo

p-2.6.5/share/hadoop/common/lib/hadoop-auth-2.6.5.jar) to method sun.security.krb5.Config.getInstance()

WARNING: Please consider reporting this to the maintainers of org.apache.hadoop.security.authentication.util.KerberosUti

l

WARNING: Use --illegal-access=warn to enable warnings of further illegal reflective access operations

WARNING: All illegal access operations will be denied in a future release

Found 1 items

-rw-r--r-- 1 cleargo supergroup 0 2019-10-26 17:12 /user/HELLO CHINA.txtQA常见问题:

1:启动hadoop可能提示找不到JAVA_HOME路径,是因为hadoop读取JAVA_HOME环境变量存在空格导致。

2:启动hadoop提示找不到HADOOP,是因为Hadoop环境变量没有配置好,请检查Hadoop环境变量配置。