竞赛地址:https://kits19.grand-challenge.org/

竞赛论文地址:https://arxiv.org/abs/1908.03204

一、KiTS19 Challenge基本情况

每年有超过40万例的新发肾癌患者,而手术是其最常见的治疗方法。由于肾脏和肾脏肿瘤形态具有多样性,关于肿瘤形态与手术结果有关的话题一直都是热门方向,以及开发先进的手术计划技术。自动语义分割是完成上述技术的有效工具,但形态异质性使其成为一个难题。

KiTS19挑战的目标是加速开发可靠的肾脏和肾脏肿瘤语义分割方法。该挑战赛已经准备了300例肾癌患者的动脉期腹部CT数据和相应金标准分割数据。其中210例被用于模型训练和验证,剩下90例将用于客观模型评估。

与在中国深圳的MICCAI 2019一起举办此项挑战,并邀请前5名比赛队伍小组口头介绍实现的方法,并合作撰写关于挑战的期刊论文。

二、KiTS19数据格式

原始图像和金标准图像的数据格式是NIFTI格式,形状是(num_slices,高度,宽度),num_slices对应于轴向视图,并且随着切片索引的增加从上到下,切片厚度范围为1mm至5mm。

三、挑战赛组队

我们队伍两个人,最终获取名次第7名,总的800多支队伍报名,最终成功提交结果的106支队伍。

四、数据预处理

该竞赛肾肿瘤训练数据一共有210例,为此划分训练和测试数据集,选择0-199例来训练,200-209例来测试。

(1)分析肾肿瘤数据金标准的类别信息,一共有三个类别值:0是背景,1是肾区域,2是肾肿瘤区域。

(2)分析肾肿瘤数据的大小和Spacing信息,大多数图像大小都是512x512xthickness,只有第160例数据是796x512xthickness,thickness数值从几十到几百,z方向上Spacing值是从1mm到5mm。

(3)分析窗宽窗位信息去除噪声和不相关区域信息。

(4)窗宽窗位设置成-200-300,将图像x和y都缩放到512,通过插值将z方向上Spacing值从原始变成1mm。

(5)为了准备3D分割肾区域,需要对图像取Patch操作,Patch大小选择128x128x32,如果你的GPU显存够大可以设置成48或64。

一、二维分割方法的初实践

由于之前做的项目都是针对二维图像的处理,为此,首先针对该竞赛想到的是将三维图像分解为二维图像,然后再利用二维分割网络进行分割。

1、Vnet-FPN网络:

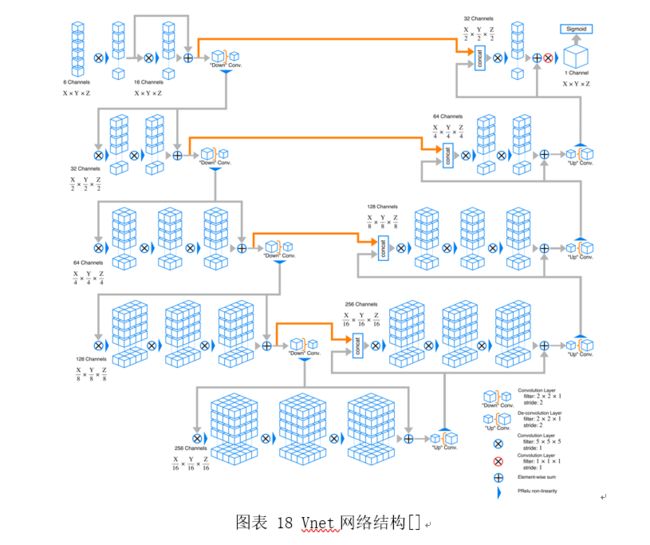

(1)vnet网络结构

(2)FPN网络构架

(3)Vnet-FPN网络构建

2、Vnet-FPN2d肾肿瘤分割

肾肿瘤分割初步尝试:采用Vnet2d来实现的,图像输入大小是256x256,在1060显卡上跑可以设置batchsize为8,如果大家出现OOM错误,请修改该参数,设置小一些。

3、测试数据上分割结果

把0-209例肾肿瘤数据全部用来训练,选择80%来训练,20%来验证测试。在测试的时候,直接输入原始图像大小512x512。然后计算20%验证数据的dice值,并计算加权平均,结果是0.872。结果看上去并不是那么糟糕。

竞赛方法的调研

1、采用GAN的方法进行分割,首先用分割网络分割出来最初的分割结果,然后分割网络的结果和原图进行相乘,金标准标签和原图进行相乘作为判别器网络的输入,进行对抗训练,最终使得分割网络的结果和原图相乘的结果能够欺骗判别器,则达到了较高的分割精度。

2、采用双Unet网络进行分割,首先,用第一个Unet网络分割出来肾,作为第二个Unet网络的输入(感兴趣区域)分割出肿瘤。

3、采用RCNN和CNN结合的方法,由于3D图像之间如果解析为2D图像,图像之间是有连续的,类似OCT图像的断层扫描,每个层之间是存在连续的,可以说各个层之间是存在关联的,采用RCNN可以用来时间序列预测,把每个阶段的图像之间的信息连接起来(比如RCNN中的记忆门),然后最终提升CNN网络的分割结果。

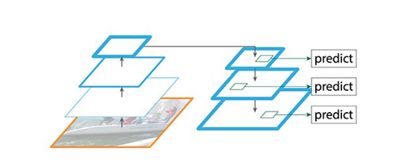

4、采用深度监督的学习方法。深度监督就是在分割网络的上采样阶段,每个阶段(或者其中一些阶段)输入,模型形成了单输入多输出的结构,在该结构中,多个输出之间形成了一种深度监督的情形,首先,在上采样阶段,较小分辨率层的输入如果预测较好,也可以让较大分辨层的预测结果就好,从而形成了一种深度监督的效果。

竞赛论文地址:https://arxiv.org/abs/1908.03204

基于多尺度监督3D U-Net的肾脏和肿瘤分割的研究

摘要

U-Net在各种医学图像分割挑战中取得了巨大成功。当使用最优超参数时,各种具有花哨功能的新架构可能在某些数据集中成功,但是它们的推广总是无法保证。在这里,我们专注于基本的U-Net架构,并为KiTS19挑战中的分段任务提出了一个多尺度监督3D U-Net。为了提高性能,我们的工作可归纳为三个方面:首先,我们在解码器路径中使用多尺度监控,这可以鼓励网络预测来自深层的正确结果;第二,为了减轻肾脏和肿瘤样本失衡的不良影响,我们采用了指数对数损失;第三,基于连通域的后处理方法用于去除明显错误的分割区域。在已发表的KiTS19训练数据集(共210名患者)中,我们将42名患者分为测试数据集,最终获得了肾脏和肿瘤的DICE评分分别为0.969和0.805。在挑战中,我们最终在106支队伍中排名第7位,复合Dice为0.8961,即肾脏Dice为0.9741,肿瘤Dice为0.8181。

关键词:医学图像分割,3D U-Net,多尺度监督。

1、介绍

自动语义分割为探索肿瘤形态学与其相应的手术结果之间的关系以及开发先进的手术技术提供了有前景的工具[1,2,3],但由于形态异质性,实现良好的性能仍然具有挑战性。

KiTS19挑战[4]旨在加速推进肾脏和肾脏肿瘤语义分割方法的发展。 它对300名不同肾癌患者进行了CT扫描,并发布了210例用于模型训练和验证,另外90例患者扫描将被保留作为测试数据集。 基于肾脏和肿瘤分割的平均Dice系数来测量所提交模型的最终性能。

深度卷积神经网络(CNN)已经被认为是用于各种图像分类和分割任务的最新方法。 具有编码器 - 解码器架构的U-Net [5]是经常用于医学图像分割的网络。 由于在生物医学数据分析中3D数据比2D图像更丰富,为了充分利用诸如CT和MRI的3D图像的空间信息,提出了3D卷积并且认为更加有效。 Fabian [6]基于3D U-Net进行了微小的修改[7],并在许多医学图像分割挑战中获得了冠军或顶级排名,这证明优化的U-Net具有足够的潜力,比许多其他新架构表现更好。

受[6]的启发,我们还丢弃了一些关于架构的常见技巧,例如残差块[8],密集块[9],注意机制[10],特征金字塔网络[11]和特征重新校准[12]。 从我们的观点来看,医学图像远不如自然图像多样化,因此它们不需要太深的卷积层或太多的连接。 只有5层的基本U-Net足以表示或学习用于像素分类的功能。

根据这样的建议,我们的工作重点是更好地训练3D U-Net并更有效地利用有限的训练数据集。 由于最终的全分辨率预测是从较深的低分辨率层上采样的,因此保证深层预测的准确性非常重要。 因此,我们设计了多尺度监督3D U-Net,以鼓励网络不仅在最后一层预测,而且在每个分辨率级别预测,从而提高了最终层的性能。 为了减轻不平衡类数据带来的负面影响,我们使用增强的焦点丢失[13],指数对数损失[14]。 最后,我们的后处理将去除预测失误的散落的肾脏或没有肾脏的肿瘤(即误分割区域)。

2 方法

在这一部分中,我们将介绍我们的方法细节,不仅包括网络架构,还包括预处理,数据增强,训练过程,后期处理,因为这些对于实现提升3D U-Net分割的性能也非常重要。

2.1 预处理和数据扩充

为了消除可能来自某些金属物的异常强度值,我们将CT图像的强度值剪切为0.5和99.5百分位数。 然后按照惯例,我们通过典型的权重初始化方法将数据标准化为全局前景均值和标准差。 需要强调的是,三维数据的各向异性会破坏三维卷积的优势,因为它不能学习具有相同感受野的不同体素空间数据的统一表示。 因此,如果不是,我们将数据重新采样到相同的体素空间中。

手动注释医学图像总是很繁琐,因此标记的数据集体积通常是有限的。 我们采用强大的数据增强来避免模型过度拟合,包括随机旋转,随机缩放,随机弹性变形,伽马校正增强和镜像。

2.2 网络架构

U-Net [5]是一种经典的编码器 - 解码器分割网络,近年来引起了很多关注。 编码器路径与典型的分类网络类似,逐层提取更高级的语义特征。 然后,解码器路径恢复每个体素的定位,并利用特征信息对其进行分类。 为了使用嵌入在编码器中的位置信息,在同一级中的层之间构建直接连接。

我们基于3D U-Net设计了我们的网络[7]。 该框架如图1所示。这种多尺度监督网络采用解码器路径的不同层进行预测,不像经典的3D U-Net仅从最后一层预测。 这些段输出将与相应的分辨率标签进行比较,然后用于计算最终损失函数。 这种监督方法主要鼓励网络从将被上采样的低分辨率特征图正确地预测为全分辨率特征图。

2.3 训练步骤

受实验内GPU内存的限制,我们选择大小为192'192'48,并使用2个GPU中的数据并行(Tesla,32GB)将批量大小设置为8。 该大小是随机抽样的,我们将一轮训练为250次迭代。 我们使用Adam作为我们的优化器。 学习率初始化为3×10**(-4),如果连续30轮的训练损失没有进一步改善,则学习率将下降0.2倍。

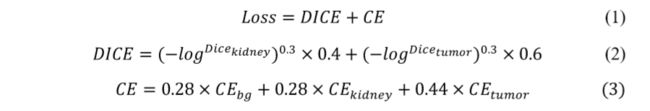

对于CT图像中的肾脏和肿瘤分割,背景样本标签远远超过肾脏和肿瘤标签。 而且,由于其形态异质性,肿瘤更难以分类。 为了缓解这种不平衡,我们使用了指数对数损失[14]。 这种损失强调了难以处理的样本的影响,并通过使损失非线性来赋予它们更多的权重。 同时,我们赋予背景,肾脏和肿瘤不同的权重。

我们将Soft Dice和Cross Entropy结合起来训练我们的模型。 损失函数公式的可归纳如下:

2.4 推理和后处理

当预测病例时,我们使用滑动窗口方法,并且预测之间存在重叠。 为了提高准确性,将原始数据和镜像数据的预测结合起来。

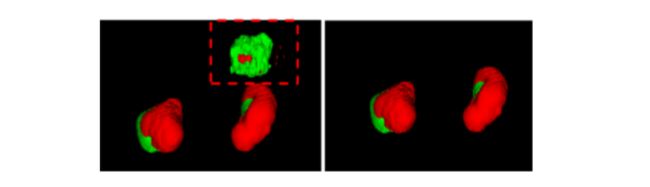

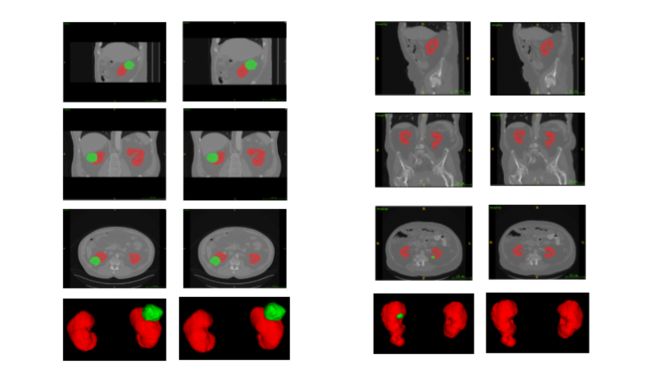

一些常见的人类知识可以帮助进一步提高性能。 例如,一名患者最多有两个肾脏,肿瘤应附着肾脏。 因此,我们设计了一个简单的基于连通组件的后处理方法来消除明显错误的预测。 效果如图2所示。

3 实验和结果

发布了210个患者CT扫描以训练模型。 我们将其中的42个划分为测试数据集,并使用其他图像来训练我们的模型。 在2个GPU(Tesla 32GB)上运行大约5天。 训练期间的损失如图3所示。

我们的分割输出和箱线图的样本如图4和图5所示。对于肾脏和肿瘤,测试数据集的平均Dice系数分别为0.969和0.805。 我们在肾脏方面取得了相当有希望的表现,但是有些肿瘤太小而不能很好地分割。

4 结论与讨论

在本文中,我们演示了我们的模型及其在KiTS19数据集中的表现。我们的方法是基于经典的3D U-Net构建的,并且通过多尺度监督,指数对数损失和基于连通分量的后处理来增强。在已发表的数据中进行测试,我们的方法分别获得了肾脏和肿瘤的平均Dice系数为0.969和0.805。在最终竞赛方提供的90例样本中,我们得到的复合Dice系数(肾脏Dice和肿瘤Dice取平均)为0.8961,肾脏Dice为0.9741,肿瘤Dice为0.8181。

由于我们遵循Fabian [6]的精神,我们在这里没有使用太多的架构技巧,而是专注于训练程序。 具有严重形态异质性的肿瘤总是很难分割。 在未来,我们计划尝试两阶段肿瘤分割方法,即我们应首先提出感兴趣区域,然后使用可变形卷积而不是传统卷积来适应肿瘤特征。

References

1. Kutikov, A., & Uzzo, R. G. (2009). The R.E.N.A.L. Nephrometry Score: A Comprehensive Standardized System for Quantitating Renal Tumor Size, Location and Depth. Journal of Urology. https://doi.org/10.1016/j.juro.2009.05.035

2. Ficarra, V., Novara, G., Secco, S., Macchi, V., Porzionato, A., De Caro, R., & Artibani, W. (2009). Preoperative Aspects and Dimensions Used for an Anatomical (PADUA) Classification of Renal Tumours in Patients who are Candidates for Nephron-Sparing Surgery. European Urology. https://doi.org/10.1016/j.eururo.2009.07.040

3. Taha, A., Lo, P., Li, J., & Zhao, T. (2018). Kid-Net: Convolution Networks for Kidney Vessels Segmentation from CT-Volumes. Lecture Notes in Computer Science (Including Subseries Lecture Notes in Artificial Intelligence and Lecture Notes in Bioinformatics). https://doi.org/10.1007/978-3-030-00937-3_53

4. Heller, N., Sathianathen, N., Kalapara, A., Walczak, E., Moore, K., Kaluzniak, H., … Weight, C. (2019). The KiTS19 Challenge Data: 300 Kidney Tumor Cases with Clinical Context, CT Semantic Segmentations, and Surgical Outcomes. 1–13. Retrieved from http://arxiv.org/abs/1904.00445

5. Ronneberger, O., Fischer, P., & Brox, T. (2015). U-net: Convolutional networks for biomedical image segmentation. Lecture Notes in Computer Science (Including Subseries Lecture Notes in Artificial Intelligence and Lecture Notes in Bioinformatics), 9351, 234–241. https://doi.org/10.1007/978-3-319-24574-4_28

6. Isensee, F., Petersen, J., Kohl, S. A. A., Jäger, P. F., & Maier-Hein, K. H. (2019). nnU-Net: Breaking the Spell on Successful Medical Image Segmentation. 1, 1–8. Retrieved from http://arxiv.org/abs/1904.08128

7. Cicek, O., Abdulkadir, A., Lienkamp, S. S., Brox, T., & Ronneberger, O. (2016). 3D U-Net : Learning Dense Volumetric. Medical Image Computing and Computer-Assisted Intervention - MICCAI 2016, 424–432. https://doi.org/10.1007/978-3-319-46723-8 8. Milletari, F. (2016). V-Net: Fully Convolutional Neural Networks for Volumetric Medical Image Segmentation. 2016 Fourth International Conference on 3D Vision (3DV), 565–571. https://doi.org/10.1109/3DV.2016.79

9. Li, X., Chen, H., Qi, X., Dou, Q., Fu, C. W., & Heng, P. A. (2018). H-DenseUNet: Hybrid Densely Connected UNet for Liver and Tumor Segmentation from CT Volumes. IEEE Transactions on Medical Imaging. https://doi.org/10.1109/TMI.2018.2845918

10. Oktay, O., Schlemper, J., Folgoc, L. Le, Lee, M., Heinrich, M., Misawa, K., … Rueckert, D. (2018). Attention U-Net: Learning Where to Look for the Pancreas. (Midl). Retrieved from http://arxiv.org/abs/1804.03999

11. Lin, T.-Y., Dollár, P., Girshick, R., He, K., Hariharan, B., & Belongie, S. (n.d.). Feature Pyramid Networks for Object Detection. Retrieved from https://arxiv.org/pdf/1612.03144.pdf

12. Roy, A. G., Navab, N., & Wachinger, C. (2018). Concurrent spatial and channel ‘squeeze & excitation’ in fully convolutional networks. Lecture Notes in Computer Science (Including Subseries Lecture Notes in Artificial Intelligence and Lecture Notes in Bioinformatics). https://doi.org/10.1007/978-3-030-00928-1_48

13. Lin, T. Y., Goyal, P., Girshick, R., He, K., & Dollar, P. (2017). Focal Loss for Dense Object Detection. Proceedings of the IEEE International Conference on Computer Vision, 2017October, 2999–3007. https://doi.org/10.1109/ICCV.2017.324

14. Wong, K. C. L., Moradi, M., Tang, H., & Syeda-Mahmood, T. (2018). 3D segmentation with exponential logarithmic loss for highly unbalanced object sizes. Lecture Notes in Computer Science (Including Subseries Lecture Notes in Artificial Intelligence and Lecture Notes in Bioinformatics), 11072 LNCS, 612–619. https://doi.org/10.1007/978-3-03000931-1_70