大数据技术之Hadoop之HDFS(3)—— win10安装hadoop3.1.2

第三章:win10安装hadoop3.1.2

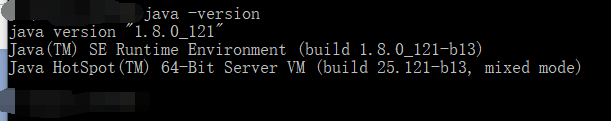

1、安装环境

win10 64位

jdk1.8

hadoop3.1.2

2、安装jdk1.8,并配置环境变量

3、安装配置hadoop

3.1、下载

到hadoop官网下载hadoop的最新版本压缩包,下载地址:Hadoop3.1.2,解压过后目录如下所示:

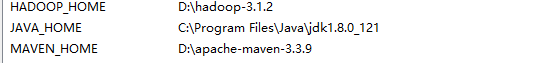

3.2、解压并配置环境变量

在环境变量中新建HADOOP_HOME变量,变量值是hadoop压缩包解压后所在的文件路径

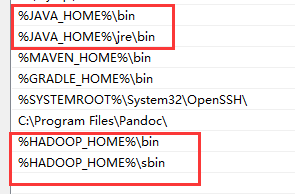

将HADOOP_HOME变量添加到系统变量PATH路径中,并进入\bin中,配置如下:

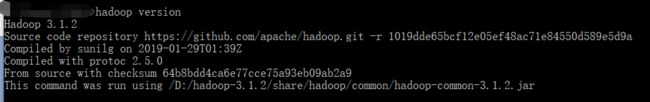

3.3、查看Hadoop版本

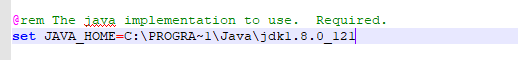

用记事本打开etc\hadoop\hadoop-env.cmd文件,找到set JAVA_HOME=%JAVA_HOME% 一行,将其值修改为jdk所在目录。因为Program Files中存在空格,需要使用PROGRA~1 代替Program Files,即改为C:\PROGRA~1\Java\jdk1.8.0_121

查看Hadoop版本:

3.4、修改配置文件

在core-site.xml 文件中添加:

<configuration>

<property>

<name>fs.defaultFS</name>

<value>hdfs://localhost:9000</value>

</property>

<property>

<name>hadoop.tmp.dir</name>

<value>/D:/hadoop-3.1.2/data/tmp</value>

</property>

<property>

<name>fs.trash.interval</name>

<value>1440</value>

</property>

</configuration>

在mapred-site.xml文件中添加:

<configuration>

<property>

<name>mapreduce.framework.name</name>

<value>yarn</value>

</property>

</configuration>

在yarn-site.xml文件中添加:

<configuration>

<property>

<name>yarn.nodemanager.aux-services</name>

<value>mapreduce_shuffle</value>

</property>

<property>

<name>yarn.nodemanager.aux-services.mapreduce.shuffle.class</name>

<value>org.apache.hahoop.mapred.ShuffleHandler</value>

</property>

</configuration>

在hdfs-site.xml文件添加:

首先在D:/hadoop-3.1.2/下创建data文件夹,并在data下创建namenode和datanode两个子文件夹,然后修改hdfs-site.xml文件:

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

<property>

<name>dfs.permissions.enabled</name>

<value>false</value>

</property>

<property>

<name>dfs.namenode.name.dir</name>

<value>/D:/hadoop-3.1.2/data/namenode</value>

</property>

<property>

<name>fs.checkpoint.dir</name>

<value>/D:/hadoop-3.1.2/data/snn</value>

</property>

<property>

<name>fs.checkpoint.edits.dir</name>

<value>/D:/hadoop-3.1.2/data/snn</value>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/D:/hadoop-3.1.2/data/datanode</value>

</property>

</configuration>

3.5、替换bin目录下的文件

默认下载的Hadoop不支持Windows系统,需要替换bin目录下的文件方便在Windows上运行。找到3.1.0版本winutils,下载后直接替换掉hadoop目录下bin文件即可:

没有winutils3.0以上版本私聊我

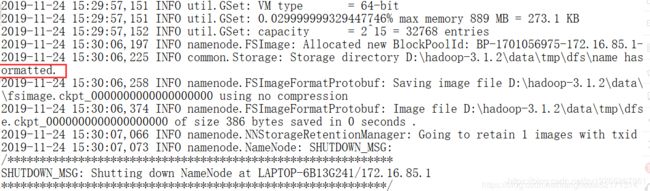

3.6、格式化namenode

命令:hdfs namenode -format

注意:第一次启动前执行,只执行一次。

当出现下图时说明格式化成功:

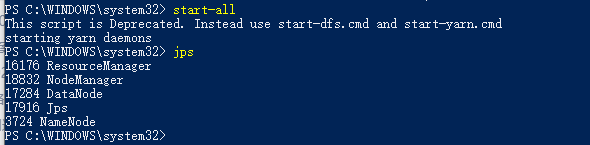

3.7、启动Hadoop(超级管理员运行cmd)

将D:\hadoop-3.1.2\share\hadoop\yarn\timelineservice 将这个文件夹下的hadoop-yarn-server-timelineservice-3.1.2.jar 包 复制到这个路径下D:\hadoop-3.1.2\share\hadoop\yarn 即可解决。

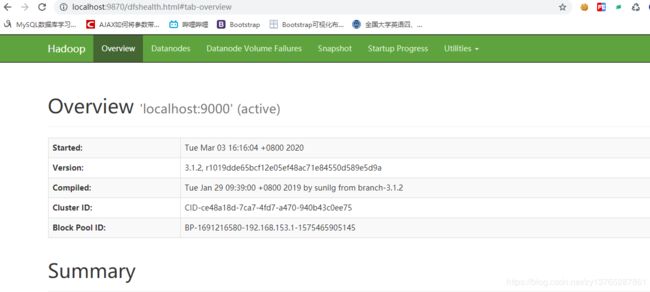

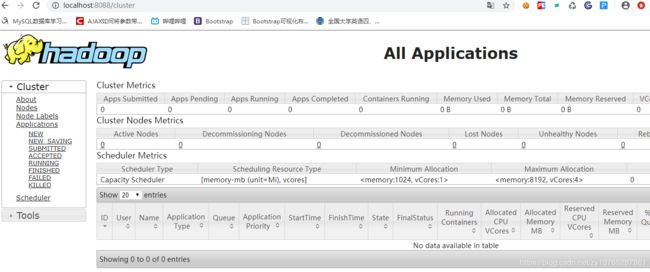

3.8、查看管理页面

http://localhost:8088/cluster

http://localhost:9870/dfshealth.html#tab-overview