python笔记 爬虫精进·第3课 【“下厨房”爬虫解析,爬取文字网页信息】

下厨房“本周最受欢迎”爬虫过程

网址:http://www.xiachufang.com/explore/

需要爬取内容:菜名、所需材料、菜名详情页url

获取数据:requests.get()

解析数据:BeautifulSoup

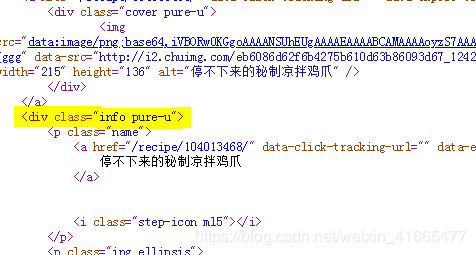

备注:菜名是 a 标签内的文本,URL是 a 标签里属性href的值,食材藏身于 p class=“ing ellipsis” 。最后,它们三者的最小共同父级标签,是 div class=“info pure-u” 。

【爬虫思路】

思路一:

先爬取所有的最小父级标签div class=“info pure-u”,然后针对每一个父级标签,想办法提取里面的菜名、URL、食材。

思路二:

分别提取所有的菜名、所有的URL、所有的食材。然后让菜名、URL、食材给一一对应起来(第0个菜名,对应第0个URL,对应第0组食材,按顺序走即可)。

代码实现一

思路:先去爬取所有的最小父级标签

第一步:获取数据与解析数据

过程代码示例:

import requests #引用requests库

from bs4 import BeautifulSoup #引用BeautifulSoup库

res_foods = requests.get('http://www.xiachufang.com/explore/') #获取数据

bs_foods = BeautifulSoup(res_foods.text,'html.parser') #解析数据

print(bs_foods) #打印解析结果

第二步:提取最小父级标签

备注:它的标签是div,有一个class属性,其值是info pure-u。我们可以使用find_all()语法,来找到它们。

过程代码示例:

import requests #引用requests库

from bs4 import BeautifulSoup #引用BeautifulSoup库

res_foods = requests.get('http://www.xiachufang.com/explore/') #获取数据

bs_foods = BeautifulSoup(res_foods.text,'html.parser') #解析数据

list_foods = bs_foods.find_all('div',class_='info pure-u') #查找最小父级标签

print(list_foods) #打印最小父级标签验证是否正确

操作说明:

在实践操作当中,其实常常会因为标签选取不当,或者网页本身的编写没做好板块区分,你可能会多打印出一些奇怪的东西。

当遇到这种情况,一般有两种处理方案:数量太多而无规律,我们会换个标签提取;数量不多而有规律,我们会对提取的结果进行筛选——只要列表中的若干个元素就好。

第三步:提取一组菜名、URL、食材

先不急于提取出所有的菜名、URL和食材。我们先尝试提取一组,等成功了,再去写循环提取所有。

1.提取菜名和URL

提取第0个父级标签中的第0个标签,并输出

过程代码示例:

import requests

#引用requests库

from bs4 import BeautifulSoup

#引用BeautifulSoup库

res_foods = requests.get('http://www.xiachufang.com/explore/')

#获取数据

bs_foods = BeautifulSoup(res_foods.text,'html.parser')

#解析数据

list_foods = bs_foods.find_all('div',class_='info pure-u')

#查找最小父级标签

tag_a = list_foods[0].find('a')

#提取第0个父级标签中的标签

print(tag_a.text[17:-13])

#输出菜名,使用[17:-13]切掉了多余的信息

print('http://www.xiachufang.com'+tag_a['href'])

#输出URL

2.提取食材

查找

标签,然后使用text提取

标签里的纯文本信息

过程代码示例:

import requests

#引用requests库

from bs4 import BeautifulSoup

#引用BeautifulSoup库

res_foods = requests.get('http://www.xiachufang.com/explore/')

#获取数据

bs_foods = BeautifulSoup(res_foods.text,'html.parser')

#解析数据

list_foods = bs_foods.find_all('div',class_='info pure-u')

#查找最小父级标签

tag_a = list_foods[0].find('a')

#提取第0个父级标签中的标签

name = tag_a.text[17:-13]

#菜名,使用[17:-13]切掉了多余的信息

URL = 'http://www.xiachufang.com'+tag_a['href']

#获取URL

tag_p = list_foods[0].find('p',class_='ing ellipsis')

#提取第0个父级标签中的标签

ingredients = tag_p.text[1:-1]

#食材,使用[1:-1]切掉了多余的信息

print(ingredients)

#打印食材

第四步:写循环,存储列表

输出样式:[[菜A,URL_A,食材A],[菜B,URL_B,食材B],[菜C,URL_C,食材C]]

最终代码:

import requests

#引用requests库

from bs4 import BeautifulSoup

#引用BeautifulSoup库

res_foods = requests.get('http://www.xiachufang.com/explore/')

#获取数据

bs_foods = BeautifulSoup(res_foods.text,'html.parser')

#解析数据

list_foods = bs_foods.find_all('div',class_='info pure-u')

#查找最小父级标签

list_all = []

#创建一个空列表,用于存储信息

for food in list_foods:

tag_a = food.find('a')

# 提取第0个父级标签中的标签

name = tag_a.text[17:-13]

# 菜名,使用[17:-13]切掉了多余的信息

URL = 'http://www.xiachufang.com'+tag_a['href']

# 获取URL

tag_p = food.find('p',class_='ing ellipsis')

# 提取第0个父级标签中的标签

ingredients = tag_p.text[1:-1]

# 食材,使用[1:-1]切掉了多余的信息

list_all.append([name,URL,ingredients])

# 将菜名、URL、食材,封装为列表,添加进list_all

print(list_all)

#打印

代码实现二

思路:分别提取所有的菜名、所有的URL、所有的食材。然后让菜名、URL、食材给一一对应起来。

步骤:

第一步:获取数据,解析数据,略过。

第二步:去查找所有,包含菜名和URL的p标签。此处p标签是a标签的父标签。

为什么不直接选a标签?还记得我们怎么说的吗?在实践操作当中,其实常常会因为标签选取不当,或者网页本身的编写没做好板块区分,你可能会多打印出一些奇怪的东西。

当遇到这种糟糕的情况,一般有两种处理方案:数量太多而无规律,我们会换个标签提取;数量不多而有规律,我们会对提取的结果进行筛选——只要列表中的若干个元素就好。

这里如果是直接提取a标签,你就会遇到这种情况。

第三步:去查找所有,包含食材的p标签。

第四步:创建一个空列表,启动循环,循环长度等

最终代码示例:

import requests

#引用requests库

from bs4 import BeautifulSoup

#引用BeautifulSoup库

res_foods = requests.get('http://www.xiachufang.com/explore/')

#获取数据

bs_foods = BeautifulSoup(res_foods.text,'html.parser')

#解析数据

tag_name = bs_foods.find_all('p',class_='name')

#查找包含菜名和URL的标签

tag_ingredients = bs_foods.find_all('p',class_='ing ellipsis')

#查找包含食材的

标签

list_all = []

#创建一个空列表,用于存储信息

for x in range(len(tag_name)):

#启动一个循环,次数等于菜名的数量

list_food = [tag_name[x].text[18:-14],tag_name[x].find('a')['href'],tag_ingredients[x].text[1:-1]]

# 提取信息,封装为列表。注意此处[18:-14]切片和之前不同,是因为此处使用的是

标签,而之前是

list_all.append(list_food)

# 将信息添加进list_all

print(list_all)

#打印

代码实现小结

确认目标-分析过程-代码实现,是我们做每一个项目的必经之路。

寻找最小共同父级标签是一种很常见的提取数据思路,它能有效规避这个问题。

text获取到的是该标签内的纯文本信息,即便是在它的子标签内,也能拿得到。但提取属性的值,只能提取该标签本身的。