《Adversarial Camouflage: Hiding Physical-World Attacks with Natural Styles》学习笔记

摘要

作者提出了一种灵活地对抗攻击的方法:AdvCam,用来产生和伪造对抗样本。AdvCam可以生成较大的扰动,可自定义攻击区域和风格。 它对评估DNN网络抵抗来自物理世界的干扰非常有用。

在数字和物理世界场景中进行的实验表明,AdvCam伪造的对抗样本具有很高的隐蔽性,在欺骗最新的DNN图像分类器时仍然有效。

一些概念

对抗攻击有两种不同的应用场景:

1.数字情况(digital setting):攻击者可以将输入的数字图像直接输入DNN分类器;

2.现实世界情况(physical-world setting):DNN分类器仅接受来自摄像机的输入,攻击者只能向摄像机展示对抗图像。

可以使用三个属性来表征对抗攻击:

1.对抗强度(adversarial strength):表示愚弄DNN分类器的能力;

2.对抗隐蔽性(adversarial stealthiness):表示对抗扰动能否被人类观测到;

3.伪装灵活性(camouflage flexibility):表示攻击者可以控制对抗图像外观的程度。

问题阐述和解决方法

首先是对抗隐蔽性,由于只有在数字情况下对抗扰动才会小,在现实情况下扰动都会很大甚至没有上限,因此在现实情况下对抗隐蔽性一般会很差。而 且现有的攻击需要精确的扰动大小才能实现隐蔽性,然而很难为视觉感知力和对抗强度决定合适的扰动大小,尤其是在现实情况下。

其次是现在的方法难以控制生成对抗样本的过程,比如攻击者无法控制对抗样本的外观。

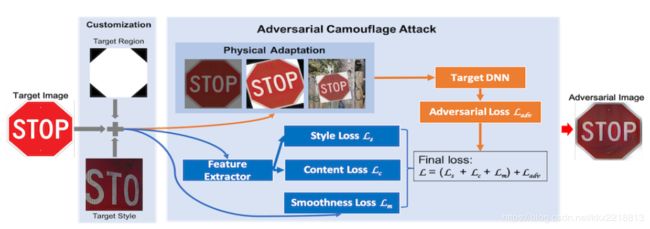

因此作者使用了风格迁移的方法来实现隐蔽性,使用对抗攻击的技术来实现对抗强度。

如图,使用作者的方法产生的对抗图像(b、d)中扰动的痕迹明显比其他方法(a、c)自然很多。

模型概述

对于给定的图像 x ∈ R m x\in{\Bbb{R}}^m x∈Rm和对应的类别标签 y y y,一个DNN分类器将图像像素映射到一个离散的标签集和一个目标类别 y a d v ≠ y y_{adv}\neq{y} yadv=y。对抗攻击的目的是找到对应于 x x x的对抗样本 x , x^, x,,通过解决如下优化问题:

其中 D D D是用来定义对抗样本的隐身属性的距离度量, L L L是对抗损失, [ 0 , 255 ] [0,255] [0,255]是可用的像素值, λ \lambda λ是用来调节对抗强度的参数。

作者的目的是是开发一种机制,将具有较大扰动的对抗样本制作和伪装成指定样式,并且攻击者可以灵活地定义攻击区域或样式。

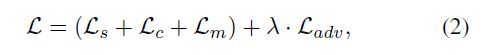

作者使用样式转换技术来达到伪装的目的,而使用对抗性攻击技术来达到对抗性。于是将最后的对抗伪装损失(adversarial camouflage loss)定义成:

L s L_s Ls是风格损失(style loss),用于风格生成;

L c L_c Lc是内容损失(content loss),用于保留源图像的内容;

L m L_m Lm是平滑损失(smoothness loss),用于生成局部平滑区域。

首先由攻击者来定义,目标图像、目标攻击区域以及预期的目标风格,然后AdvCam在指定的区域生成指定风格的对抗扰动

风格损失(style loss)

在传统对抗中,隐身度(stealthiness metric)通常定义为:![]()

这里通常使用p范数,2范数和无穷范数。目的是为了将扰动限制为“小”。在作者的模型中,隐身度是由对抗性样本 x , x^, x,和风格参考图像 x s x^s xs之间的距离定义的。这个距离可以定义为:

其中 F ~ \tilde{F} F~是一个特征提取器,它可以与目标模型不同。 g g g是从 F ~ \tilde{F} F~的一组样式层提取的深层特征的Gram矩阵。由于可以在不同的层上学习到不同的样式,因此作者将网络的所有卷积层用作样式层。

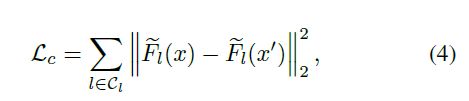

内容损失

C l C_l Cl表示用于提取内容表示的内容层集。这是为了确保对抗图像具有与深度表示空间中的原始图像非常相似的内容。 将特征提取器网络的更深层用作内容层。

平滑损失

对抗图像的平滑度可以通过减少相邻像素之间的变化来提高。平滑损失定义为:

其中 x i , j , x^{,}_{i,j} xi,j,是像素在坐标 ( i , j ) (i,j) (i,j)下的图像 x , x^, x,。直观上,这将鼓励图像具有低方差的局部色块。

对抗损失

使用交叉熵损失,其中 p y a d v ( ) p_{yadv}() pyadv()是目标模型F相对于类别 y a d v y_{adv} yadv的概率输出。

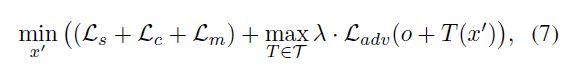

在现实世界条件下的调整

为了应对现实世界环境经常涉及条件波动,例如视点移动,相机噪声和其他自然变化,要做出一些调整。作者考虑了用于模拟现实世界条件波动的转换,包括旋转,缩放比例大小,颜色偏移(以模拟闪电变化)和随机背景。

o代表我们在现实世界中采样的随机背景图像,T代表旋转,调整大小和颜色偏移的随机变换。

实验

上图在图像不同区域生成不同形状的扰动,对抗攻击都取得了不错的效果。

通过上图可以观察到,内容损失可以保证对抗样本和原图像在内容上的一致性(交通标志图),平滑损失可以帮助产生光滑的物体表面。