kafka的编译和使用

一.kafka的使用

kafka官网提供了编译好的二进制包,下载即用 http://kafka.apache.org/downloads。最新版本的是1.1.0

Kafka是使用scala编写的运行于jvm虚拟机上的程序,虽然也可以在windows上使用,但基本上是运行在linux服务器上,因此我们这里也使用linux(Fedora 20)来开始今天的实战。

首先确保你的机器上安装了jdk,kafka需要java运行环境,以前的kafka还需要zookeeper,新版的kafka已经内置了一个zookeeper环境,所以我们可以直接使用。

1.安装jdk

linux系统一般默认会安装openjdk,据说是jdk的开源版本,先卸载之。

2.安装kafka

创建producer,停留在cmd终端,接受输入,以回车发送,即每一行是一条单独的消息

二.kafka的编译

kafka官网提供了编译好的二进制包,下载即用 http://kafka.apache.org/downloads。最新版本的是1.1.0

Kafka是使用scala编写的运行于jvm虚拟机上的程序,虽然也可以在windows上使用,但基本上是运行在linux服务器上,因此我们这里也使用linux(Fedora 20)来开始今天的实战。

首先确保你的机器上安装了jdk,kafka需要java运行环境,以前的kafka还需要zookeeper,新版的kafka已经内置了一个zookeeper环境,所以我们可以直接使用。

1.安装jdk

我的Fedora 20是32位的,但是最新的JDK 10只有64位版本了,因此要下载老版本,JDK 7以上的版本就行。

历史版本下载地址:http://www.oracle.com/technetwork/java/javase/archive-139210.html

我下载的是jdk-7u80-linux-i586.rpm

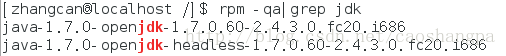

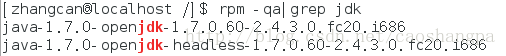

☆查看当前的jdk情况

# rpm -qa|grep jdk

linux系统一般默认会安装openjdk,据说是jdk的开源版本,先卸载之。

☆卸载openjdk

# yum -y remove java java-1.7.0-openjdk*☆安装jdk

# rpm -ivh jdk-7u80-linux-i586.rpm☆查看jdk版本

# java -version

2.安装kafka

说是安装,实际上就是解压。如果只需要进行最简单的尝试的话我们只需要解压到任意目录即可,这里我们将kafka压缩包解压到/home目录。

> tar -xzf kafka_2.11-1.1.0.tgz

> cd kafka_2.11-1.1.0启动zookeeper

> bin/zookeeper-server-start.sh config/zookeeper.properties> bin/kafka-server-start.sh config/server.properties> bin/kafka-topics.sh --create --zookeeper localhost:2181 --replication-factor 1 --partitions 1 --topic test> bin/kafka-topics.sh --list --zookeeper localhost:2181

test创建producer,停留在cmd终端,接受输入,以回车发送,即每一行是一条单独的消息

> bin/kafka-console-producer.sh --broker-list localhost:9092 --topic test

This is a message

This is another message> bin/kafka-console-consumer.sh --bootstrap-server localhost:9092 --topic test --from-beginning

This is a message

This is another message所有的命令行都有可选参数,如果不带参数,会显示详细的使用信息

关闭zookeeper

> bin/zookeeper-server-stop.shSIGNAL=${SIGNAL:-TERM}

PIDS=$(ps ax | grep java | grep -i zookeeper | grep -v grep | awk '{print $1}')

if [ -z "$PIDS" ]; then

echo "No zookeeper server to stop"

exit 1

else

kill -s $SIGNAL $PIDS

fi> bin/kafka-server-stop.shSIGNAL=${SIGNAL:-KILL}

PIDS=$(ps ax | grep -i kafka | grep java | grep -v grep | awk '{print $1}')

if [ -z "$PIDS" ]; then

echo "No kafka server to stop"

exit 1

else

kill -s $SIGNAL $PIDS

fi二.kafka的编译

会编译,有备无患。下载源码kafka-1.1.0-src.tgz

解压,这里也解压到/home目录下

> tar -xzf kafka-1.1.0-src.tgz

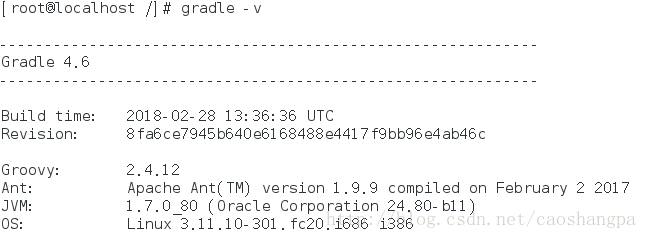

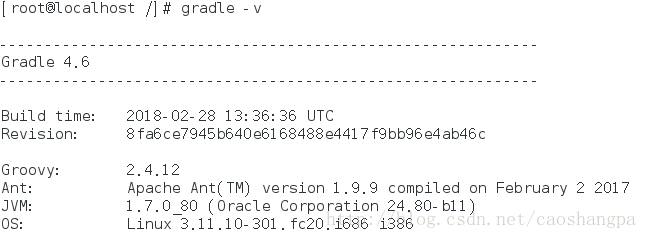

> cd kafka-1.1.0-srcGradle下载https://gradle.org/install/,该页面指出Gradle依赖Java 7或更高版本。最新的Gradle版本是4.6,下载其编译好的二进制包gradle-4.6-bin.zip。

解压,这里也解压到/home目录下

$ unzip -d gradle-4.6-bin.zip

$ ls radle-4.6

LICENSE NOTICE bin getting-started.html init.d lib mediaexport PATH=$PATH:/home/zhangcan/gradle-4.6/bin$ source /etc/profile$ gradle -v

CD到kafka源码目录,开始编译

1.输入gradle指令,开始下载环境

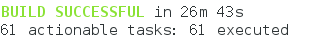

$ gradle2.编译

$ ./gradlew releaseTarGz -x signArchives此时,会在kafka-1.1.0-src/core/build/distributions目录下生成一个名为kafka_2.11-1.1.0.tgz的二进制包,这个包和从官网下载的二进制包是一毛一样的。

编译过程很顺利,没有发现任何问题。

参考链接:http://kafka.apache.org/quickstart