python 下实现xgboost 调参演示

基于前阵子京东金融JDD数据探索大赛比赛拿下总决赛季军的经验,发现xgboost真的是一个很好的利器,精确度的提升是很疯狂的,从最远先使用的RF模型到XGBOOST模型,精确度可以说提升了0.3的跨度。

相信很多人跟我一样都被xgboost惊艳到, 今天就来记录下xgboost的调参演示,刚接触xgboost可以看看。

以下实现, 我使用sklearn.datasets的make_hastie_10_2 做数据集

from sklearn.model_selection import train_test_split

from sklearn import metrics

from sklearn.datasets import make_hastie_10_2

from sklearn.ensemble import GradientBoostingClassifier

from xgboost.sklearn import XGBClassifier

##载入示例数据 10维度

X, y = make_hastie_10_2(random_state=0)

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.5, random_state=0)##test_size测试集合所占比例默认XGB参数下的AUC值和ACCURACY

auc_Score=[]

accuracy=[]

clf = XGBClassifier()

clf.fit(X_train, y_train)

y_pre= clf.predict(X_test)

y_pro= clf.predict_proba(X_test)[:,1]

print "AUC Score : %f" % metrics.roc_auc_score(y_test, y_pro)

print"Accuracy : %.4g" % metrics.accuracy_score(y_test, y_pre)

auc_Score.append(metrics.roc_auc_score(y_test, y_pro))

accuracy.append(metrics.accuracy_score(y_test, y_pre))结果:AUC Score : 0.972424

Accuracy : 0.8993XGB需要调整的参数

- max_depth = 5 :

- 和GBM中的参数相同,这个值为树的最大深度。

- 这个值也是用来避免过拟合的。max_depth越大,模型会学到更具体更局部的样本。

- 需要使用CV函数来进行调优。

- 典型值:3-10

- min_child_weight = 1:

- 决定最小叶子节点样本权重和。

- 和GBM的 min_child_leaf 参数类似,但不完全一样。XGBoost的这个参数是最小样本权重的和,而GBM参数是最小样本总数。

- 这个参数用于避免过拟合。当它的值较大时,可以避免模型学习到局部的特殊样本。

- 但是如果这个值过高,会导致欠拟合。这个参数需要使用CV来调整。

- gamma = 0:

- 在节点分裂时,只有分裂后损失函数的值下降了,才会分裂这个节点。Gamma指定了节点分裂所需的最小损失函数下降值。

- 这个参数的值越大,算法越保守。这个参数的值和损失函数息息相关,所以是需要调整的。

- subsample:

- 和GBM中的subsample参数一模一样。这个参数控制对于每棵树,随机采样的比例。

- 减小这个参数的值,算法会更加保守,避免过拟合。但是,如果这个值设置得过小,它可能会导致欠拟合。

- 典型值:0.5-1

- colsample_bytree:

- 和GBM里面的max_features参数类似。用来控制每棵随机采样的列数的占比(每一列是一个特征)。

- 典型值:0.5-1

- scale_pos_weight = 1:

- 在各类别样本十分不平衡时,把这个参数设定为一个正值,可以使算法更快收敛。

一下过程我们用一步步修改的方法,来查看结果,用for 函数来列举各个调参过程,for函数我就不列举了,直接通过for得出的结果给大家列举最有参数。当然你也可以不用for 来做,可以用sklearn.moedel_selection的GridSearchCV来快速调参。

我们先从n_estimators 来定

'n_estimators':[100,200,500,1000,1500]

取1000最好

clf = XGBClassifier(

learning_rate =0.1, #默认0.3

n_estimators=1000, #树的个数

max_depth=5,

min_child_weight=1,

gamma=0,

subsample=0.8,

colsample_bytree=0.8,

objective= 'binary:logistic', #逻辑回归损失函数

nthread=4, #cpu线程数

scale_pos_weight=1,

seed=27) #随机种子

clf.fit(X_train, y_train)

y_pre= clf.predict(X_test)

y_pro= clf.predict_proba(X_test)[:,1]

print "AUC Score : %f" % metrics.roc_auc_score(y_test, y_pro)

print"Accuracy : %.4g" % metrics.accuracy_score(y_test, y_pre)

auc_Score.append(metrics.roc_auc_score(y_test, y_pro))

accuracy.append(metrics.accuracy_score(y_test, y_pre))结果:AUC Score : 0.989145

Accuracy : 0.9405第二步: max_depth 和 min_weight 它们对最终结果有很大的影响

max_depth range(3,10,2)=[3, 5, 7, 9]

min_weight range(1,6,2)=[1, 3, 5]

max_depth=3 min_weight=1 最好

clf = XGBClassifier(

learning_rate =0.1, #默认0.3

n_estimators=1000, #树的个数

max_depth=3,

min_child_weight=1,

gamma=0,

subsample=0.8,

colsample_bytree=0.8,

objective= 'binary:logistic', #逻辑回归损失函数

nthread=4, #cpu线程数

scale_pos_weight=1,

seed=27) #随机种子

clf.fit(X_train, y_train)

y_pre= clf.predict(X_test)

y_pro= clf.predict_proba(X_test)[:,1]

print "AUC Score : %f" % metrics.roc_auc_score(y_test, y_pro)

print"Accuracy : %.4g" % metrics.accuracy_score(y_test, y_pre)

auc_Score.append(metrics.roc_auc_score(y_test, y_pro))

accuracy.append(metrics.accuracy_score(y_test, y_pre))结果:AUC Score : 0.991693

Accuracy : 0.9485第三步:gamma参数调优

'gamma':[i/10.0 for i in range(0,7)]=[0.0, 0.1, 0.2, 0.3, 0.4, 0.5, 0.6]

gamma=0.5 最好

clf = XGBClassifier(

learning_rate =0.1, #默认0.3

n_estimators=1000, #树的个数

max_depth=3,

min_child_weight=1,

gamma=0.5,

subsample=0.8,

colsample_bytree=0.8,

objective= 'binary:logistic', #逻辑回归损失函数

nthread=4, #cpu线程数

scale_pos_weight=1,

seed=27) #随机种子

clf.fit(X_train, y_train)

y_pre= clf.predict(X_test)

y_pro= clf.predict_proba(X_test)[:,1]

print "AUC Score : %f" % metrics.roc_auc_score(y_test, y_pro)

print"Accuracy : %.4g" % metrics.accuracy_score(y_test, y_pre)

auc_Score.append(metrics.roc_auc_score(y_test, y_pro))

accuracy.append(metrics.accuracy_score(y_test, y_pre))结果:AUC Score : 0.991749

Accuracy : 0.9497第四步:调整subsample 和 colsample_bytree 参数

'subsample':[i/10.0 for i in range(6,10)]=[0.6, 0.7, 0.8, 0.9]

'colsample_bytree':[i/10.0 for i in range(6,10)]=[0.6, 0.7, 0.8, 0.9]

'subsample': 0.6, 'colsample_bytree': 0.6 最好

clf = XGBClassifier(

learning_rate =0.1, #默认0.3

n_estimators=1000, #树的个数

max_depth=3,

min_child_weight=1,

gamma=0.5,

subsample=0.6,

colsample_bytree=0.6,

objective= 'binary:logistic', #逻辑回归损失函数

nthread=4, #cpu线程数

scale_pos_weight=1,

seed=27) #随机种子

clf.fit(X_train, y_train)

y_pre= clf.predict(X_test)

y_pro= clf.predict_proba(X_test)[:,1]

print "AUC Score : %f" % metrics.roc_auc_score(y_test, y_pro)

print"Accuracy : %.4g" % metrics.accuracy_score(y_test, y_pre)

auc_Score.append(metrics.roc_auc_score(y_test, y_pro))

accuracy.append(metrics.accuracy_score(y_test, y_pre))结果:AUC Score : 0.992504

Accuracy : 0.954第五步:正则化参数调优

'reg_alpha':[1e-5, 1e-2, 0.1, 1, 100]=[1e-05, 0.01, 0.1, 1, 100] 默认0 L1正则项参数,参数值越大,模型越不容易过拟合

'reg_lambda':[1,5,10,50] 默认1L2正则项参数,参数值越大,模型越不容易过拟合

{'reg_alpha': 1e-05, 'reg_lambda': 1} 正则变化不大

clf = XGBClassifier(

learning_rate =0.1, #默认0.3

n_estimators=1000, #树的个数

max_depth=3,

min_child_weight=1,

gamma=0.5,

subsample=0.6,

colsample_bytree=0.6,

objective= 'binary:logistic', #逻辑回归损失函数

nthread=4, #cpu线程数

scale_pos_weight=1,

reg_alpha=1e-05,

reg_lambda=1,

seed=27) #随机种子

clf.fit(X_train, y_train)

y_pre= clf.predict(X_test)

y_pro= clf.predict_proba(X_test)[:,1]

print "AUC Score : %f" % metrics.roc_auc_score(y_test, y_pro)

print"Accuracy : %.4g" % metrics.accuracy_score(y_test, y_pre)

auc_Score.append(metrics.roc_auc_score(y_test, y_pro))

accuracy.append(metrics.accuracy_score(y_test, y_pre))结果:AUC Score : 0.992504

Accuracy : 0.954第6步:进一步 降低学习速率 增加更多的树

'learning_rate':[0.01,0.1,0.3]

'learning_rate': 0.1 不变

'n_estimators':[1000,1200,1500,2000,2500]

'n_estimators': 2000 较好

clf = XGBClassifier(

learning_rate =0.1, #默认0.3

n_estimators=2000, #树的个数

max_depth=3,

min_child_weight=1,

gamma=0.5,

subsample=0.6,

colsample_bytree=0.6,

objective= 'binary:logistic', #逻辑回归损失函数

nthread=4, #cpu线程数

scale_pos_weight=1,

reg_alpha=1e-05,

reg_lambda=1,

seed=27) #随机种子

clf.fit(X_train, y_train)

y_pre= clf.predict(X_test)

y_pro= clf.predict_proba(X_test)[:,1]

print "AUC Score : %f" % metrics.roc_auc_score(y_test, y_pro)

print"Accuracy : %.4g" % metrics.accuracy_score(y_test, y_pre)

auc_Score.append(metrics.roc_auc_score(y_test, y_pro))

accuracy.append(metrics.accuracy_score(y_test, y_pre))结果:AUC Score : 0.993114

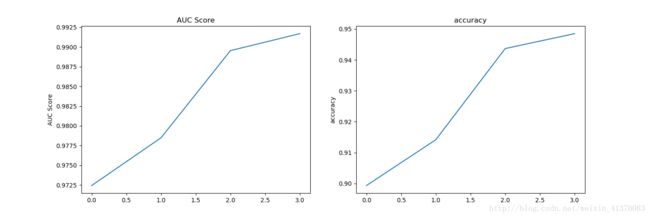

Accuracy : 0.957import matplotlib.pyplot as plt

fig=plt.figure(figsize=(15,5))

p1=fig.add_subplot(1,2,1)

p1.plot(auc_Score)

p1.set_ylabel('AUC Score')

p1.set_title('AUC Score')

p2=fig.add_subplot(1,2,2)

p2.plot(accuracy)

p2.set_ylabel('accuracy')

p2.set_title('accuracy')

plt.show()