OpenCV-Python——第33章:光流

翻译自:https://docs.opencv.org/master/d7/d8b/tutorial_py_lucas_kanade.html

程序中的视频素材在此下载

链接: https://pan.baidu.com/s/1DIkyYTq7lE3Wou17oHZDnw 提取码: jk4j

目录

1 光流

2 Lucas-Kanade 法

3 OpenCV 中的 Lucas-Kanade 光流

4 OpenCV 中的稠密光流

1 光流

由于目标对象或者摄像机的移动造成的图像对象在连续两帧图像中的移动被称为光流。它是一个 2D 向量场,可以用来显示一个点从第一帧图像到第二帧图像之间的移动。如下图所示

上图显示了一个点在连续的五帧图像间的移动。箭头表示光流场向量。光流在很多领域中都很有用:

● 由运动重建结构

● 视频压缩

● Video Stabilization 等

光流是基于一下假设的:

1. 在连续的两帧图像之间(目标对象的)像素的灰度值不改变。

2. 相邻的像素具有相同的运动

第一帧图像中的像素 I (x,y,t) 在时间 dt 后移动到第二帧图像的(x+dx,y +dy)处。根据第一条假设:灰度值不变。所以我们可以得到:

![]()

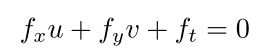

对等号右侧进行泰勒级数展开,消去相同项,两边都除以 dt,得到如下方程:

其中:

上边的等式叫做光流方程。其中![]() 和

和 ![]() 是图像梯度,同样 ft 是时间方向的梯度。但(u,v)是不知道的。我们不能在一个等式中求解两个未知数。有 几个方法可以帮我们解决这个问题,其中的一个是 Lucas-Kanade 法

是图像梯度,同样 ft 是时间方向的梯度。但(u,v)是不知道的。我们不能在一个等式中求解两个未知数。有 几个方法可以帮我们解决这个问题,其中的一个是 Lucas-Kanade 法

2 Lucas-Kanade 法

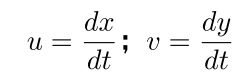

现在我们要使用第二条假设,邻域内的所有点都有相似的运动。LucasKanade 法就是利用一个 3x3 邻域中的 9 个点具有相同运动的这一点。这样 我们就可以找到这 9 个点的光流方程,用它们组成一个具有两个未知数 9 个等 式的方程组,这是一个约束条件过多的方程组。一个好的解决方法就是使用最 小二乘拟合。下面就是求解结果:

(有没有发现上边的逆矩阵与 Harris 角点检测器非常相似,这说明角点很 适合被用来做跟踪)从使用者的角度来看,想法很简单,我们取跟踪一些点,然后我们就会获得这些点的光流向量。但是还有一些问题。直到现在我们处理的都是很小的运动。 如果有大的运动怎么办呢?图像金字塔。我们可以使用图像金字塔的顶层,此 时小的运动被移除,大的运动装换成了小的运动,现在再使用 Lucas-Kanade 算法,我们就会得到尺度空间上的光流。

3 OpenCV 中的 Lucas-Kanade 光流

上述所有过程都被OpenCV打包成了一个函数:cv2.calcOpticalFlowPyrLK()。现在我们使用这个函数创建一个小程序来跟踪视频中的一些点。要跟踪那些点 呢?我们使用函数 cv2.goodFeatureToTrack() 来确定要跟踪的点。我们首先在视频的第一帧图像中检测一些 Shi-Tomasi 角点,然后我们使用 LucasKanade算法迭代跟踪这些角点。我们要给函数cv2.calcOpticlaFlowPyrLK()传入前一帧图像和其中的点,以及下一帧图像。函数将返回带有状态数的点, 如果状态数是 1,那说明在下一帧图像中找到了这个点(上一帧中角点),如果 状态数是 0,就说明没有在下一帧图像中找到这个点。我们再把这些点作为参 数传给函数,如此迭代下去实现跟踪。

重要函数:

corners = cv.goodFeaturesToTrack(image, maxCorners, qualityLevel, minDistance, mask, blockSize, useHarrisDetector, k)

确定图像上较好的角点。

该函数查找图像或指定图像区域中最突出的角点,如

- 函数使用cornerMinEigenVal或cornerHarris计算每个源图像像素处的边角质量。

- 执行非最大抑制(保留3 x 3邻域中的局部最大值)。

- 最小特征值的边角小于

被拒绝了。

被拒绝了。 - 剩余的边角按质量降序排序。

- Function throws away each corner for which there is a stronger corner at a distance less than maxDistance.(不懂)

该函数可用于初始化对象的基于点的跟踪器。

- image:输入8位或浮点32位单通道图像。

- corners:输出检测到的角点的矢量。

- maxCorners:要返回的最大角点数。如果角落多于找到的角落,则返回最强的角落。

maxCorners <= 0意味着不设置最大值限制并返回所有检测到的角点。 - qualityLevel:表征图像角落的最小可接受质量的参数。参数值乘以最佳拐角质量度量,即最小特征值(参见cornerMinEigenVal)或Harris函数响应(参见cornerHarris)。质量测量小于产品的角落被拒绝。例如,如果最佳角点的质量度量为1500,质量等级为0.01,则质量度量小于15的所有角落都将被拒绝。

- minDistance:返回角落之间的最小可能欧几里德距离。

- mask:可选的感兴趣区域。如果图像不为空(它需要具有类型CV_8UC1并且与图像大小相同),则它指定检测到角的区域。

- blockSize:用于计算每个像素邻域上的导数共变矩阵的平均块的大小。请参阅cornerEigenValsAndVecs。

- useHarrisDetector:参数指示是否使用Harris检测器(请参阅cornerHarris)或cornerMinEigenVal。

- k:Harris探测器的自由参数。

nextPts, status, err = cv.calcOpticalFlowPyrLK(prevImg, nextImg, prevPts, nextPts, status, err, winSize, maxLevel, criteria, flags, minEigThreshold)

使用具有金字塔的迭代Lucas-Kanade方法计算稀疏特征集的光流。

- prevImg:由buildOpticalFlowPyramid构造的第一个8位输入图像或金字塔。

- nextImg:与prevImg相同尺寸和相同类型的第二输入图像或金字塔

- prevPts:需要找到流量的2D点的矢量; 点坐标必须是单精度浮点数。

- nextPts:2D点的输出矢量(具有单精度浮点坐标),包含第二图像中输入特征的计算新位置; 当传递OPTFLOW_USE_INITIAL_FLOW标志时,向量必须与输入中的大小相同。

- status:输出状态向量(无符号字符); 如果找到相应特征的流,则向量的每个元素设置为1,否则设置为0。

- err:输出错误的矢量; 向量的每个元素都设置为相应特征的错误,错误度量的类型可以在flags参数中设置; 如果未找到流,则未定义错误(使用status参数查找此类情况)。

- winSize:每个金字塔等级的搜索窗口的大小。

- maxLevel:基于0的最大金字塔等级数; 如果设置为0,则不使用金字塔(单级),如果设置为1,则使用两个级别,依此类推; 如果将金字塔传递给输入,则算法将使用与金字塔具有但不超过maxLevel的级别。

- criteria:指定迭代搜索算法的终止条件(在指定的最大迭代次数criteria.maxCount之后或当搜索窗口移动小于criteria.epsilon时)。

- flags:

OPTFLOW_USE_INITIAL_FLOW使用初始估计,存储在nextPts中; 如果未设置标志,则将prevPts复制到nextPts并将其视为初始估计。

OPTFLOW_LK_GET_MIN_EIGENVALS使用最小特征值作为误差测量(参见minEigThreshold描述); 如果没有设置标志,则将原稿周围的色块和移动点之间的L1距离除以窗口中的像素数,用作误差测量。

- minEigThreshold:该算法计算光流方程的2×2正常矩阵的最小特征值(该矩阵在[23]中称为空间梯度矩阵),除以窗口中的像素数; 如果此值小于minEigThreshold,则过滤掉相应的功能并且不处理其流程,因此它允许删除坏点并获得性能提升。

程序如下:

import numpy as np

import cv2 as cv

cap = cv.VideoCapture('video.mp4')

# ShiTomasi角落检测的参数

feature_params = dict(maxCorners=100,

qualityLevel=0.3,

minDistance=7,

blockSize=7)

# lucas kanade光流的参数

lk_params = dict(winSize=(15, 15),

maxLevel=2,

criteria=(cv.TERM_CRITERIA_EPS | cv.TERM_CRITERIA_COUNT, 10, 0.03))

# 创建一些随机颜色

color = np.random.randint(0, 255, (100, 3))

# 拍摄第一帧并在其中找到角落

ret, old_frame = cap.read()

old_gray = cv.cvtColor(old_frame, cv.COLOR_BGR2GRAY)

p0 = cv.goodFeaturesToTrack(old_gray, mask=None, **feature_params)

# 创建一个用于绘图目的的蒙版图像

mask = np.zeros_like(old_frame)

while(1):

ret, frame = cap.read()

frame_gray = cv.cvtColor(frame, cv.COLOR_BGR2GRAY)

# #计算光流

p1, st, err = cv.calcOpticalFlowPyrLK(

old_gray, frame_gray, p0, None, **lk_params)

# 选择较好的点

good_new = p1[st == 1]

good_old = p0[st == 1]

# 画出曲线

for i, (new, old) in enumerate(zip(good_new, good_old)):

a, b = new.ravel()

c, d = old.ravel()

mask = cv.line(mask, (a, b), (c, d), color[i].tolist(), 2)

frame = cv.circle(frame, (a, b), 5, color[i].tolist(), -1)

img = cv.add(frame, mask)

cv.imshow('frame', img)

k = cv.waitKey(30) & 0xff

if k == 27:

break

# 现在更新上一帧和前一点

old_gray = frame_gray.copy()

p0 = good_new.reshape(-1, 1, 2)

cv.destroyAllWindows()

cap.release()

效果如下

4 OpenCV 中的稠密光流

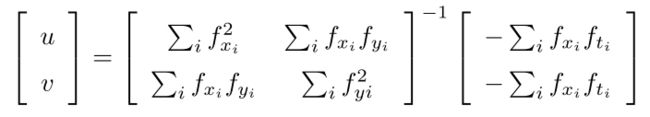

Lucas-Kanade 法是计算一些特征点的光流(我们上面的例子使用的是Shi-Tomasi 算法检测到的角点)。OpenCV 还提供了一种计算稠密光流的 方法。它会图像中的所有点的光流。这是基于 Gunner_Farneback 的算法(2003 年)。 下面的例子就是使用上面的算法计算稠密光流。结果是一个带有光流向量(u,v)的双通道数组。通过计算我们能得到光流的大小和方向。我们使用颜 色对结果进行编码以便于更好的观察。方向对应于 H(Hue)通道,大小对应 于 V(Value)通道。

重要函数:

flow = cv.calcOpticalFlowFarneback(prev, next, flow, pyr_scale, levels, winsize, iterations, poly_n, poly_sigma, flags)

使用Gunnar Farneback的算法计算密集的光流。

- prev:第一个8位单通道输入图像。

- next:与prev相同尺寸和相同类型的第二输入图像

- flow:计算出的流图像与prev相同,并且类型为CV_32FC2。

- pyr_scale:指定图像比例为每个图像构建金字塔; pyr_scale = 0.5表示经典金字塔,其中每个下一层比前一层小两倍。

- levels:包括初始图像的金字塔层数; levels = 1表示不创建额外的图层,仅使用原始图像。

- winsize:平均窗口大小; 较大的值会增加算法对图像噪声的鲁棒性,并为快速运动检测提供更多机会,但会产生更模糊的运动场。

- iterations:算法在每个金字塔等级执行的迭代次数。

- poly_n:用于在每个像素中找到多项式展开的像素邻域的大小; 较大的值意味着图像将用更光滑的表面近似,从而产生更稳健的算法和更模糊的运动场,通常poly_n = 5或7。

- poly_sigma:高斯的标准偏差,用于平滑导数,用作多项式展开的基础; 对于poly_n = 5,你可以设置poly_sigma = 1.1,对于poly_n = 7,一个好的值是poly_sigma = 1.5。

- flags:可以是以下的组合:

OPTFLOW_USE_INITIAL_FLOW 使用输入流作为初始流近似值。

OPTFLOW_FARNEBACK_GAUSSIAN 使用winsize×winsize的高斯过滤器而不是相同尺寸的盒式过滤器,用于光流估计; 通常,这个选项比使用箱式过滤器更准确地流动,代价是降低速度; 通常,高斯窗口的winsize应设置为更大的值,以实现相同级别的稳健性。

magnitude, angle = cv.cartToPolar(x, y, magnitude, angle, angleInDegrees)

计算2D矢量的大小和角度。

- x:x坐标数组; 这必须是单精度或双精度浮点数组。

- y:y坐标数组,必须与x具有相同的大小和相同的类型。

- magnitude:输出与x相同大小和类型的数量的数组。

- angle:输出与x具有相同大小和类型的角度数组; 角度以弧度(从0到2π)或以度(0到360度)测量

- angleInDegrees:指示角度是以弧度(默认为False)或以度为单位测量(True)。

代码如下:

import cv2

import numpy as np

cap = cv2.VideoCapture("video.mp4")

ret, frame1 = cap.read()

prvs = cv2.cvtColor(frame1, cv2.COLOR_BGR2GRAY)

hsv = np.zeros_like(frame1)

hsv[..., 1] = 255

while(1):

ret, frame2 = cap.read()

next = cv2.cvtColor(frame2, cv2.COLOR_BGR2GRAY)

flow = cv2.calcOpticalFlowFarneback(

prvs, next, None, 0.5, 3, 15, 3, 5, 1.2, 0)

mag, ang = cv2.cartToPolar(flow[..., 0], flow[..., 1])

hsv[..., 0] = ang*180/np.pi/2

hsv[..., 2] = cv2.normalize(mag, None, 0, 255, cv2.NORM_MINMAX)

bgr = cv2.cvtColor(hsv, cv2.COLOR_HSV2BGR)

cv2.imshow('frame2', bgr)

k = cv2.waitKey(30) & 0xff

if k == 27:

break

elif k == ord('s'):

cv2.imwrite('opticalfb.png', frame2)

cv2.imwrite('opticalhsv.png', bgr)

prvs = next

cap.release()

cv2.destroyAllWindows()

效果如下: