Python爬取酷狗音乐-详解(多图预警)

目录

- 1.前言

- 2.分析一下

- 1.

- 2.

- 3.

- 3.代码解释

- 4.完整代码

- 5.结语

1.前言

前面发布了一篇关于QQ音乐爬取的教程,但对于我们这种文艺青年来说,一个平台的歌曲怎么够我们听的,也是因为每个平台歌曲的权限不同,所以不同平台也有不同的歌曲,今天,给大家带来爬取酷狗音乐的教程,就是歌多!!!

2.分析一下

我们大家听歌的时候大都是去搜喜欢的歌曲名或者是喜欢的歌手,那今天我们就以歌手为例,下载搜索歌手出现的歌曲列表,如下。

1.

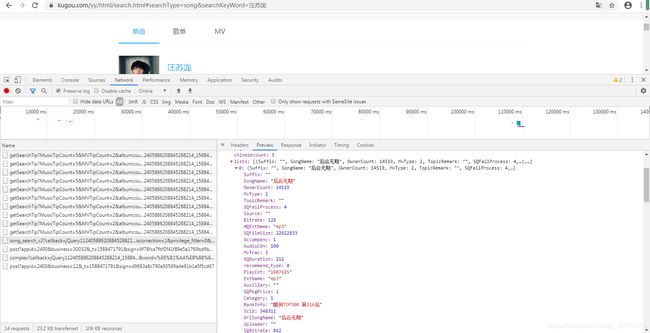

首先我们分析一下,我们执行代码时,改变的肯定是歌手名,就是当我们输入歌手的名字时,它会获取到有关这个列表的所有歌曲的信息,所以我们要从搜索部分入手。

如图:当我们在搜索框输入信息时,每按一次键盘就会出现一个文件,当我们搜索完,按回车时,会发现一个文件,这个文件包含了这个列表的所有信息,也就是所搜索歌手的全部歌曲,而且每一项都包含了这首歌曲的详细信息,但遗憾的是没有这首歌曲的播放地址,没关系,至少我们的方向是对的。

我们分析这个文件的地址:

https://songsearch.kugou.com/song_search_v2?callback=jQuery112405886208845288214_1588464073802&keyword=%E6%B1%AA%E8%8B%8F%E6%B3%B7&page=1&pagesize=30&userid=-1&clientver=&platform=WebFilter&tag=em&filter=2&iscorrection=1&privilege_filter=0&_=1588464073826

这应该是经过地址编码的,我们转码看一下:

https://songsearch.kugou.com/song_search_v2?callback=jQuery112405886208845288214_1588464073802&keyword=汪苏泷&page=1&pagesize=30&userid=-1&clientver=&platform=WebFilter&tag=em&filter=2&iscorrection=1&privilege_filter=0&_=1588464073826

看到变化了吗,没错,关键字"keyword"就是歌手名,我们改变地址中的keyword就可以得到,不同歌手的歌曲列表

2.

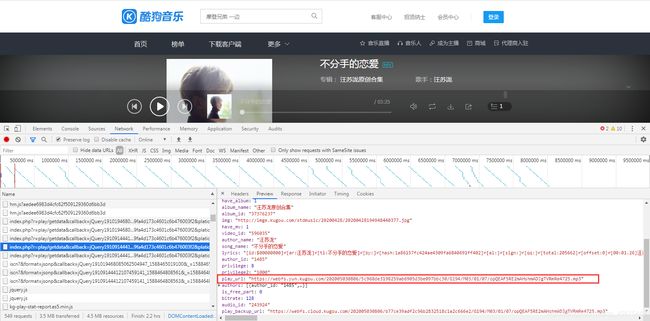

既然我们找到了歌曲的详细信息,就要分析信息中哪些是我们想要的,但在此之前,我们得找到歌曲的其他信息,不然一处信息是无法判断的。我们点开一首歌曲,检查一下,我们可以看到这样一个文件。

这个文件包也是包含了歌曲的详细信息,但重要的是,有一个可疑的地址,我们点开来看,猜对了,就是歌曲的播放地址,哈哈,是不是信心大增。

3.

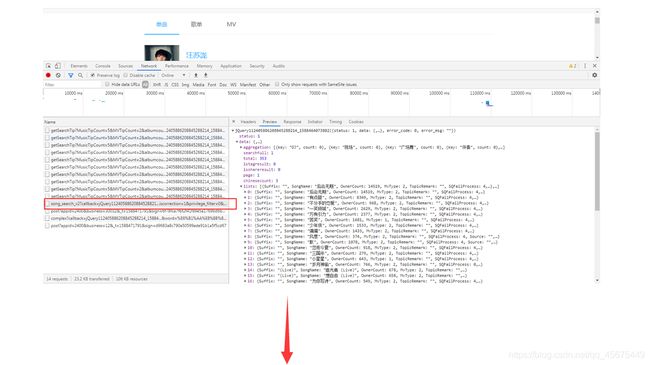

如果只看播放地址的话我们发现不了什么规律,那我们看一看这个文件的地址,多看几个,没准你会有新的发现。

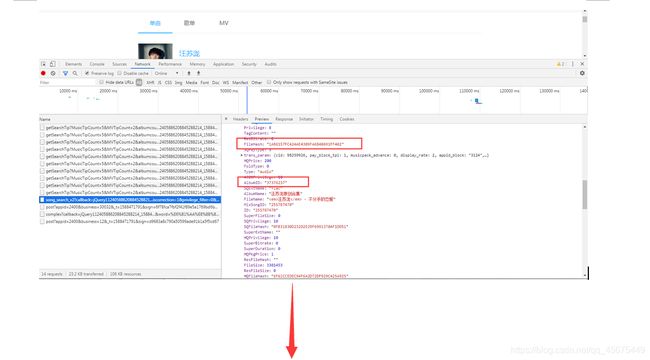

仔细看一看,发没发现两个关键字,“hash"和"album_id”,是不是觉得和我们前面发现的信息有联系啊,没错,我们最开始分析的那个文件中,歌曲的详细信息里就包含了这两个关键字的值。

所以获取歌曲播放地址的步骤我们大致也明白了,我们可以根据我们分析的第一个文件中的"hash"和"album_id"来获取我们分析的第二个文件的地址,第二个文件包含了歌曲的播放地址,所以,好吧,图解一下。

这下应该很非常清楚了吧,光看图也该明白了吧!!!

3.代码解释

再给你们稍微说明一下。

我们根据歌手搜索时,参数歌手名是字符串类型,但带到地址中要进行编码转换。

调入模块:

import urllib.request,urllib.error,urllib.parse

代码部分:

code_name = urllib.parse.quote(name) #字符串转化为编码格式

获取歌手的歌曲列表,这是图解的第一步,注释部分是根据搜索的歌名获取歌曲列表,也就是一首歌曲的不同演唱版本,使用时只需要将上面的地址注释就可以了

代码:

music_list = "https://songsearch.kugou.com/song_search_v2?callback=jQuery112405886208845288214_1588464073802&keyword=%s&page=1&pagesize=30&userid=-1&clientver=&platform=WebFilter&tag=em&filter=2&iscorrection=1&privilege_filter=0&_=1588464073804" % code_name #获取歌名产生的歌曲列表 下载列表全部

# music_list = "https://songsearch.kugou.com/song_search_v2?callback=jQuery112406527023765769748_1588091726282&keyword=%s&page=1&pagesize=30&userid=-1&clientver=&platform=WebFilter&tag=em&filter=2&iscorrection=1&privilege_filter=0&_=1588091726284" % code_name #搜索歌手产生的歌曲列表 下载列表全部

获取带有歌曲播放地址的文件的地址,这是图解的第三步:

代码:

information_url = "https://wwwapi.kugou.com/yy/index.php?r=play/getdata&callback=jQuery19101144344902676131_1588093696865&hash={}&album_id={}&dfid=2AHvg428HZSx0oRNWX0prTMo&mid=4b42424f9fa4d173c4601c6b476003f2&platid=4&_=1588093696867".format(music_hash,music_albumid)

获取歌曲的播放地址,这是图解的最后一步:

代码:

music_url = cut_dict["data"]["play_url"]

分析一下的目的就是让你们在看完整代码的时候没有那么懵,结合我们分析的步骤,和每段代码的作用,完整看一遍代码,很容易理解。

4.完整代码

import requests

import re

import json

import os

import urllib.request,urllib.error,urllib.parse

import time

headers = {"cookie": "kg_mid=4b42424f9fa4d173c4601c6b476003f2; kg_dfid=2AHvg428HZSx0oRNWX0prTMo; Hm_lvt_aedee6983d4cfc62f509129360d6bb3d=1587913892,1588084386; kg_dfid_collect=d41d8cd98f00b204e9800998ecf8427e; kg_mid_temp=4b42424f9fa4d173c4601c6b476003f2; Hm_lpvt_aedee6983d4cfc62f509129360d6bb3d=1588093697",

"user-agent": "Mozilla/5.0 (Windows NT 6.1; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/80.0.3987.163 Safari/537.36"}

content_url_list = []

def get_url(name):

code_name = urllib.parse.quote(name) #字符串转化为编码格式

music_list = "https://songsearch.kugou.com/song_search_v2?callback=jQuery112405886208845288214_1588464073802&keyword=%s&page=1&pagesize=30&userid=-1&clientver=&platform=WebFilter&tag=em&filter=2&iscorrection=1&privilege_filter=0&_=1588464073804" % code_name #获取歌名产生的歌曲列表 下载列表全部

# music_list = "https://songsearch.kugou.com/song_search_v2?callback=jQuery112406527023765769748_1588091726282&keyword=%s&page=1&pagesize=30&userid=-1&clientver=&platform=WebFilter&tag=em&filter=2&iscorrection=1&privilege_filter=0&_=1588091726284" % code_name #搜索歌手产生的歌曲列表 下载列表全部

music_list_response = requests.get(music_list,headers=headers,).text

music_list_html = re.findall(r'\((.*)\)',music_list_response)[0]

music_list_html_dict = json.loads(music_list_html)

for i in range(len(music_list_html_dict["data"]["lists"])):

music_hash = music_list_html_dict["data"]["lists"][i]["FileHash"] #关键字 hash

music_albumid = music_list_html_dict["data"]["lists"][i]["AlbumID"] #关键字album_id

information_url = "https://wwwapi.kugou.com/yy/index.php?r=play/getdata&callback=jQuery19101144344902676131_1588093696865&hash={}&album_id={}&dfid=2AHvg428HZSx0oRNWX0prTMo&mid=4b42424f9fa4d173c4601c6b476003f2&platid=4&_=1588093696867".format(music_hash,music_albumid)

content_url_list.append(information_url) #包含歌曲详细信息

return content_url_list

def Preservation(sid):

url = sid

response = requests.get(url,headers=headers).text

time.sleep(3) #时间延迟 控制爬虫爬取速度

cut_json = re.findall(r'\((.*)\)',response)[0] #格式为json格式

cut_dict = json.loads(cut_json) #转换为字典格式 才能根据键获取值

music_url = cut_dict["data"]["play_url"] #歌曲播放地址

music_name = cut_dict["data"]["song_name"] #歌曲名

singer = cut_dict["data"]["author_name"] #歌手名

data_url = "D:/Pycharm文件/网络爬虫/酷狗音乐/"

data_name = data_url + music_name + "_____" + singer + ".mp3"

content_url = requests.get(music_url,headers=headers).content

try:

if not os.path.exists(data_url): #判断有误文件夹

os.mkdir(data_url)

if not os.path.exists(data_name): #判断有无文件

print("正在下载 %s" % (music_name + "---" + singer))

with open(data_name,"wb") as f:

f.write(content_url)

print(" %s 下载成功" % (music_name + "---" + singer))

else:

print("文件已存在")

except:

print("下载失败")

for sid in get_url("不分手的恋爱"): # 当没有版权时是没有play_url的 这部分要修改

Preservation(sid)

time.sleep(2) #时间延迟 控制爬虫访问服务器时间 避免过快被反爬

5.结语

这次,我感觉写的挺详细了,当然只是我自己觉得(嘻嘻),有什么意见或建议都可以私信我,我会努力改正,代码有不足的地方还请指点,我也会努力改正,我们一起加油呀。对了,别忘了多多支持我呀(嘻嘻)。