- 深度 Qlearning:在直播推荐系统中的应用

AGI通用人工智能之禅

程序员提升自我硅基计算碳基计算认知计算生物计算深度学习神经网络大数据AIGCAGILLMJavaPython架构设计Agent程序员实现财富自由

深度Q-learning:在直播推荐系统中的应用关键词:深度Q-learning,强化学习,直播推荐系统,个性化推荐1.背景介绍1.1问题的由来随着互联网技术的飞速发展,直播平台如雨后春笋般涌现。面对海量的直播内容,用户很难快速找到自己感兴趣的内容。因此,个性化推荐系统在直播平台中扮演着越来越重要的角色。1.2研究现状目前,主流的个性化推荐算法包括协同过滤、基于内容的推荐等。这些方法在一定程度上缓

- OpenAI o1 的价值意义及“强化学习的Scaling Law” & Kimi创始人杨植麟最新分享:关于OpenAI o1新范式的深度思考

光剑书架上的书

ChatGPT大数据AI人工智能计算人工智能算法机器学习

OpenAIo1的价值意义及“强化学习的ScalingLaw”蹭下热度谈谈OpenAIo1的价值意义及RL的Scalinglaw。一、OpenAIo1是大模型的巨大进步我觉得OpenAIo1是自GPT4发布以来,基座大模型最大的进展,逻辑推理能力提升的效果和方法比预想的要好,GPT4o和o1是发展大模型不同的方向,但是o1这个方向更根本,重要性也比GPT4o这种方向要重要得多,原因下面会分析。为什

- 探索未来,大规模分布式深度强化学习——深入解析IMPALA架构

汤萌妮Margaret

探索未来,大规模分布式深度强化学习——深入解析IMPALA架构scalable_agent项目地址:https://gitcode.com/gh_mirrors/sc/scalable_agent在当今的人工智能研究前沿,深度强化学习(DRL)因其在复杂任务中的卓越表现而备受瞩目。本文要介绍的是一个开源于GitHub的重量级项目:“ScalableDistributedDeep-RLwithImp

- 如何有效的学习AI大模型?

Python程序员罗宾

学习人工智能语言模型自然语言处理架构

学习AI大模型是一个系统性的过程,涉及到多个学科的知识。以下是一些建议,帮助你更有效地学习AI大模型:基础知识储备:数学基础:学习线性代数、概率论、统计学和微积分等,这些是理解机器学习算法的数学基础。编程技能:掌握至少一种编程语言,如Python,因为大多数AI模型都是用Python实现的。理论学习:机器学习基础:了解监督学习、非监督学习、强化学习等基本概念。深度学习:学习神经网络的基本结构,如卷

- 反思的魔力:用语言的力量强化AI智能体

步子哥

人工智能机器学习

在浩瀚的代码海洋中,AI智能体就像初出茅庐的航海家,渴望探索未知的宝藏。然而,面对复杂的编程任务,他们常常迷失方向。今天,就让我们跟随“反思”的灯塔,见证AI智能体如何通过语言的力量,点亮智慧的明灯,成为代码世界的征服者!智能体的困境近年来,大型语言模型(LLM)在与外部环境(如游戏、编译器、API)交互的领域中大放异彩,化身为目标驱动的智能体。然而,传统的强化学习方法如同一位严苛的训练师,需要大

- 机器学习实战笔记5——线性判别分析

绍少阿

机器学习笔记可视化机器学习python人工智能

任务安排1、机器学习导论8、核方法2、KNN及其实现9、稀疏表示3、K-means聚类10、高斯混合模型4、主成分分析11、嵌入学习5、线性判别分析12、强化学习6、贝叶斯方法13、PageRank7、逻辑回归14、深度学习线性判别分析(LDA)Ⅰ核心思想对于同样一件事,站在不同的角度,我们往往会有不同的看法,而降维思想,亦是如此。同上节课一样,我们还是学习降维的算法,只是提供了一种新的角度,由上

- 大模型的实践应用29-大语言模型的RLHF(人类反馈强化学习)的具体应用与原理介绍

微学AI

大模型的实践应用语言模型人工智能自然语言处理RLHF

大家好,我是微学AI,今天给大家介绍一下大模型的实践应用29-大语言模型的RLHF(人类反馈强化学习)的具体应用与原理介绍。在当今人工智能发展的浪潮中,大语言模型(LargeLanguageModels,LLMs)凭借其强大的语言理解和生成能力,成为了研究与应用的热点。而在这股浪潮中,一种名为“基于人类反馈的强化学习”的方法脱颖而出,为大语言模型的优化和应用开辟了新的路径。本文首部分将深入浅出地介

- 坚定理想信念,锤炼党性修养

知涵知

理想信念是中国共产党人的政治灵魂,是共产党人精神上的“钙”,没有理想信念,理想信念不坚定,精神上就会“缺钙”,就会得“软骨病”。党员干部只有坚定理想信念,强化责任担当,锤炼道德操守,提升党性修养,才能切实做到为党分忧、为国尽责、为民奉献。坚定理想信念,就要强化学习精神、自律精神、担当精神。思想理论上的坚定清醒是政治上坚定的前提,党员干部要始终把理论学习作为政治责任、事业需要和精神追求,积极参加组织

- python 物理引擎_在 Gym 上构建会动的人工智障1(python)

weixin_39542608

python物理引擎

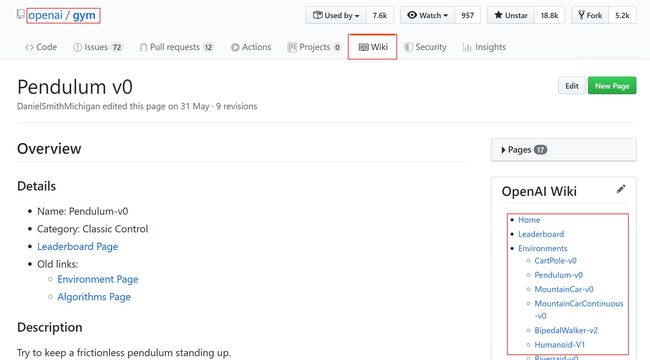

背景说明作者最近使用processing的一个重要目标就是为学生的编程学习设计具体的应用场景,最近突然发现有一个包已经提供了部分功能,所以探索一下。这个包就是我们今天的主人公:Gym。Gym是用于开发和比较强化学习算法的python包,但是我们也完全可以使用它来作为我们自己程序的应用背景,并提供可视化。简单的说,就是我们使用自己写的小程序,而不是强化学习算法,来尝试完成其中的任务,并把完成任务的过

- 强化学习(二)----- 马尔可夫决策过程MDP

Duckie-duckie

机器学习数据数据分析数据挖掘机器学习算法

1.马尔可夫模型的几类子模型大家应该还记得马尔科夫链(MarkovChain),了解机器学习的也都知道隐马尔可夫模型(HiddenMarkovModel,HMM)。它们具有的一个共同性质就是马尔可夫性(无后效性),也就是指系统的下个状态只与当前状态信息有关,而与更早之前的状态无关。马尔可夫决策过程(MarkovDecisionProcess,MDP)也具有马尔可夫性,与上面不同的是MDP考虑了动作

- Python强化学习,基于gym的马尔可夫决策过程MDP,动态规划求解,体现序贯决策

baozouxiaoxian

pythongymqlearningpython强化学习mdp动态规划求解马尔科夫决策过程

决策的过程分为单阶段和多阶段的。单阶段决策也就是单次决策,这个很简单。而序贯决策指按时间序列的发生,按顺序连续不断地作出决策,即多阶段决策,决策是分前后顺序的。序贯决策是前一阶段决策方案的选择,会影响到后一阶段决策方案的选择,后一阶段决策方案的选择是取决于前一阶段决策方案的结果。强化学习过程中最典型的例子就是非线性二级摆系统,有4个关键值,小车受力,受力方向,摆速度,摆角,每个状态下都需要决策车的

- 强化学习分类

0penuel0

Model-free:Qlearning,Sarsa,PolicyGradientsModel-based:能通过想象来预判断接下来将要发生的所有情况.然后选择这些想象情况中最好的那种基于概率:PolicyGradients基于价值:Qlearning,Sarsa两者融合:Actor-Critic回合更新:Monte-carlolearning,基础版的policygradients单步更新:Ql

- 7. 深度强化学习:智能体的学习与决策

Network_Engineer

机器学习学习机器学习深度学习神经网络python算法

引言深度强化学习结合了强化学习与深度学习的优势,通过智能体与环境的交互,使得智能体能够学习最优的决策策略。深度强化学习在自动驾驶、游戏AI、机器人控制等领域表现出色,推动了人工智能的快速发展。本篇博文将深入探讨深度强化学习的基本框架、经典算法(如DQN、策略梯度法),以及其在实际应用中的成功案例。1.强化学习的基本框架强化学习是机器学习的一个分支,专注于智能体在与环境的交互过程中,学习如何通过最大

- 深度强化学习之DQN-深度学习与强化学习的成功结合

CristianoC

目录概念深度学习与强化学习结合的问题DQN解决结合出现问题的办法DQN算法流程总结一、概念原因:在普通的Q-Learning中,当状态和动作空间是离散且维数不高的时候可以使用Q-Table来存储每个状态动作对应的Q值,而当状态和动作空间是高维连续时,使用Q-Table不现实。一是因为当问题复杂后状态太多,所需内存太大;二是在这么大的表格中查询对应的状态也是一件很耗时的事情。image通常的做法是把

- 一对一包教会脑电教学服务

茗创科技

茗创科技专注于脑科学数据处理,涵盖(EEG/ERP,fMRI,结构像,DTI,ASL,FNIRS)等,欢迎留言讨论及转发推荐,也欢迎了解茗创科技的脑电课程,数据处理服务及脑科学工作站销售业务,可添加我们的工程师(微信号MCKJ-zhouyi或17373158786)咨询。★课程简介★最近有不少人留言“脑电该怎么学习?想强化学习脑电某个内容版块可以吗?...”,也有小伙伴联系我们,咨询脑电相关内容能

- 基于时序差分的无模型强化学习:Q-learning 算法详解

晓shuo

算法强化学习

目录一、无模型强化学习中的时序差分方法与Q-learning1.1时序差分法1.2Q-learning算法状态-动作值函数(Q函数)Q-learning的更新公式Q-learning算法流程Q-learning的特点1.3总结一、无模型强化学习中的时序差分方法与Q-learning 动态规划算法依赖于已知的马尔可夫决策过程(MDP),在环境的状态转移概率和奖励函数完全明确的情况下,智能体无需与环

- (18-1)基于深度强化学习的股票交易模型:项目介绍+准备环境

码农三叔

强化学习从入门到实践人工智能深度学习股票交易模型DRLDoubleDQNDuelingDQN

在本章的这个项目中,实现了一个用于股票交易的DRL模型,旨在展示DRL在金融领域的潜力,提供其在股票交易中应用的实际例子。希望通过本章内容的学习,能够为那些对金融与机器学习交叉领域感兴趣的人士提供有益的参考。1.1项目介绍在金融市场中,股票交易是一项充满挑战的任务,需要在高度波动和复杂的市场环境中做出快速且精准的决策。传统的交易策略通常依赖于经验、基本面分析或技术分析。然而,这些方法往往无法在快速

- 深度学习算法——Transformer

fw菜菜

数学建模深度学习transformer人工智能数学建模pythonpytorch

参考教材:动手学pytorch一、模型介绍Transformer模型完全基于注意力机制,没有任何卷积层或循环神经网络层。尽管Transformer最初是应用于在文本数据上的序列到序列学习,但现在已经推广到各种现代的深度学习中,例如语言、视觉、语音和强化学习领域。Transformer作为编码器-解码器架构的一个实例,其整体架构图在下图中展示。正如所见到的,Trans‐former是由编码器和解码器

- sumo carla 自动驾驶联合仿真 安装 配置 教程 开发 驾驶模拟 强化学习

jZhUeZPQZw

自动驾驶人工智能机器学习

sumocarla自动驾驶联合仿真安装配置教程开发驾驶模拟强化学习轨迹预测轨迹规划标题:基于SUMO和CARLA的自动驾驶联合仿真系统安装与配置:教程与开发探索摘要:随着自动驾驶技术的迅猛发展,仿真环境在自动驾驶系统的评估、训练和验证中扮演着重要的角色。本文介绍了基于SUMO(SimulationofUrbanMObility)和CARLA(CarLearningtoAct)的自动驾驶联合仿真系统

- Python知识点:如何使用Python实现强化学习机器人

杰哥在此

Python系列python机器人开发语言编程面试

实现一个强化学习机器人涉及多个步骤,包括定义环境、状态和动作,选择适当的强化学习算法,并训练模型。下面是一个简单的例子,使用Python和经典的Q-learning算法来实现一个强化学习机器人,目标是通过OpenAIGym提供的FrozenLake环境训练机器人学会如何在冰面上移动以找到目标。1.安装必要的库首先,需要安装OpenAIGym和Numpy。你可以使用以下命令安装它们:pipinsta

- 机器学习在医学中的应用

听忆.

机器学习人工智能

边走、边悟迟早会好机器学习在医学中的应用是一个广泛且复杂的领域,涵盖了从基础研究到临床应用的多个方面。以下是一个万字总结的结构性思路,分章节深入探讨不同应用场景、技术方法、挑战与未来展望。1.引言背景与发展:介绍医学领域的数字化转型以及机器学习的兴起,探讨其在医学中的潜力。机器学习的基本概念:简要介绍机器学习的基本原理、分类(监督学习、非监督学习、强化学习等)和常用算法(如神经网络、支持向量机、随

- 人工智能&机器学习&深度学习

AA杂货铺111

机器学习:一切通过优化方法挖掘数据中规律的学科。深度学习:一切运用了神经网络作为参数结构进行优化的机器学习算法。强化学习:不仅能利用现有数据,还可以通过对环境的探索获得新数据,并利用新数据循环往复地更新迭代现有模型的机器学习算法。学习是为了更好地对环境进行探索,而探索是为了获取数据进行更好的学习。深度强化学习:一切运用了神经网络作为参数结构进行优化的强化学习算法。人工智能定义与分类人工智能(Art

- 学习日志6

Simon#0209

学习

关于量子强化学习:论文Variational_Quantum_Circuits_for_Deep_Reinforcement_Learning:变分量子电路在深度强化学习中的应用论文主要内容:将经典深度强化学习算法(如经验重放和目标网络)重塑为变分量子电路的表示摘要当前最先进的机器学习方法基于经典冯·诺伊曼计算架构,并在许多工业和学术领域得到广泛应用。随着量子计算的发展,研究人员和技术巨头们试图为

- 【科技前沿】用深度强化学习优化电网,让电力调度更聪明!

风清扬雨

人工智能人工智能python智能电网深度强化学习

Hey小伙伴们,今天我要跟大家分享一个超级酷炫的技术应用——深度强化学习在电网优化中的典型案例!如果你对机器学习感兴趣,或是正寻找如何用AI技术解决实际问题的方法,这篇分享绝对不容错过!✨开场白大家好,我是你们的技术小助手!今天我们要聊的是如何利用深度强化学习(DRL)来优化电网的调度,让电力系统变得更智能、更高效。引入话题想象一下,如果你能够通过一种先进的技术手段,自动调整电网中的能源分配,不

- 大模型对齐方法笔记一:DPO及其变种IPO、KTO、CPO

chencjiajy

深度学习笔记机器学习人工智能

DPODPO(DirectPreferenceOptimization)出自2023年5月的斯坦福大学研究院的论文《DirectPreferenceOptimization:YourLanguageModelisSecretlyaRewardModel》,大概是2023-2024年最广为人知的RLHF的替代对齐方法了。DPO的主要思想是在强化学习的目标函数中建立决策函数与奖励函数之间的关系,以规避

- 多智能体环境设计(二)

AI-星辰

强化学习自定义环境python机器学习

多智能体环境设计:接口设计与实现目录引言PettingZoo框架概述核心接口方法详解3.1reset()方法3.2step(action)方法3.3observe(agent)方法3.4render()方法空间定义4.1观察空间4.2动作空间高级特性5.1并行环境5.2智能体通信5.3动态环境性能优化测试和调试实际应用示例最佳实践和常见陷阱1.引言多智能体环境是强化学习和人工智能研究中的一个重要领

- 【伤寒强化学习训练】打卡第四十五天 一期90天

A卐炏澬焚

3.5.2麻黄汤续讲与大、小青龙汤麻黄九禁【7.18】脉浮紧者,法当汗出而解。若身重心悸者,不可发汗,须自汗出乃愈。所以然者,尺中脉微,此里虚也。须里实,津液自和,便自汗出愈。【7.19】脉浮紧者,法当身疼痛,宜以汗解之。假令尺中迟者,不可发汗。所以然者,以荣气不足,血弱故也。【7.18】:脉浮紧的人照理说要发汗,如果身体重、心悸是不可以发汗;发汗,不一定用麻黄汤,大青龙汤也可以感冒很多人身体都是

- 从自动驾驶看无人驾驶叉车的技术落地和应用

电气_空空

自动驾驶自动驾驶机器人人工智能毕设

摘要|介绍无人驾驶叉车在自动驾驶技术中的应用,分析其关键技术,如环境感知、定位、路径规划等,并讨论机器学习算法和强化学习算法的应用以提高无人叉车的运行效率和准确性。无人叉车在封闭结构化环境、机器学习、有效数据集等方法的助力下,可有效推动叉车无人驾驶关键技术的发展。关键词:无人叉车;自动驾驶;机器学习;数据集随着人工智能技术的持续进步,无人叉车领域的供给与需求均呈现迅猛增长态势。它们不仅正在逐步替代

- 强化学习自定义环境基础知识

AI-星辰

强化学习自定义环境python机器学习

1.引言本文旨在全面介绍OpenAIGym自定义环境的创建过程,重点解析其接口、关键属性和函数。本指南适合初学者深入了解强化学习环境的构建原理和实践方法。2.OpenAIGym环境基础OpenAIGym提供了一个标准化的接口,用于创建和使用强化学习环境。了解这个接口的核心组件是创建自定义环境的基础。2.1Env类所有Gym环境都继承自gym.Env类。这个基类定义了环境应该具有的基本结构和方法。i

- 【《伤寒论》强化学习训练】打卡第32天,一期目标90天

最闪亮的那颗星_b02d

一、桂枝加葛根汤和葛根汤不能通用,因为葛根汤里有麻黄,会散阳气。太阳传到阳明时血分受邪,要用麻黄从血分把邪气发出来,所以用葛根汤治燥热感冒。桂枝汤治营卫不调的出汗或桂枝加附子汤治阳虚自汗,不能一开始就用黄芪,黄芪会让桂枝汤发挥不了通营卫的效果,汗止不了。人体表面的能量不足的时候,身体不能收摄自己身体的水分,桂枝加附子汤里有附子,可治阳虚自汗。玉屏风散治表虚的汗有效;桂枝加附子汤治虚汗有效,但是两个

- java线程Thread和Runnable区别和联系

zx_code

javajvmthread多线程Runnable

我们都晓得java实现线程2种方式,一个是继承Thread,另一个是实现Runnable。

模拟窗口买票,第一例子继承thread,代码如下

package thread;

public class ThreadTest {

public static void main(String[] args) {

Thread1 t1 = new Thread1(

- 【转】JSON与XML的区别比较

丁_新

jsonxml

1.定义介绍

(1).XML定义

扩展标记语言 (Extensible Markup Language, XML) ,用于标记电子文件使其具有结构性的标记语言,可以用来标记数据、定义数据类型,是一种允许用户对自己的标记语言进行定义的源语言。 XML使用DTD(document type definition)文档类型定义来组织数据;格式统一,跨平台和语言,早已成为业界公认的标准。

XML是标

- c++ 实现五种基础的排序算法

CrazyMizzz

C++c算法

#include<iostream>

using namespace std;

//辅助函数,交换两数之值

template<class T>

void mySwap(T &x, T &y){

T temp = x;

x = y;

y = temp;

}

const int size = 10;

//一、用直接插入排

- 我的软件

麦田的设计者

我的软件音乐类娱乐放松

这是我写的一款app软件,耗时三个月,是一个根据央视节目开门大吉改变的,提供音调,猜歌曲名。1、手机拥有者在android手机市场下载本APP,同意权限,安装到手机上。2、游客初次进入时会有引导页面提醒用户注册。(同时软件自动播放背景音乐)。3、用户登录到主页后,会有五个模块。a、点击不胫而走,用户得到开门大吉首页部分新闻,点击进入有新闻详情。b、

- linux awk命令详解

被触发

linux awk

awk是行处理器: 相比较屏幕处理的优点,在处理庞大文件时不会出现内存溢出或是处理缓慢的问题,通常用来格式化文本信息

awk处理过程: 依次对每一行进行处理,然后输出

awk命令形式:

awk [-F|-f|-v] ‘BEGIN{} //{command1; command2} END{}’ file

[-F|-f|-v]大参数,-F指定分隔符,-f调用脚本,-v定义变量 var=val

- 各种语言比较

_wy_

编程语言

Java Ruby PHP 擅长领域

- oracle 中数据类型为clob的编辑

知了ing

oracle clob

public void updateKpiStatus(String kpiStatus,String taskId){

Connection dbc=null;

Statement stmt=null;

PreparedStatement ps=null;

try {

dbc = new DBConn().getNewConnection();

//stmt = db

- 分布式服务框架 Zookeeper -- 管理分布式环境中的数据

矮蛋蛋

zookeeper

原文地址:

http://www.ibm.com/developerworks/cn/opensource/os-cn-zookeeper/

安装和配置详解

本文介绍的 Zookeeper 是以 3.2.2 这个稳定版本为基础,最新的版本可以通过官网 http://hadoop.apache.org/zookeeper/来获取,Zookeeper 的安装非常简单,下面将从单机模式和集群模式两

- tomcat数据源

alafqq

tomcat

数据库

JNDI(Java Naming and Directory Interface,Java命名和目录接口)是一组在Java应用中访问命名和目录服务的API。

没有使用JNDI时我用要这样连接数据库:

03. Class.forName("com.mysql.jdbc.Driver");

04. conn

- 遍历的方法

百合不是茶

遍历

遍历

在java的泛

- linux查看硬件信息的命令

bijian1013

linux

linux查看硬件信息的命令

一.查看CPU:

cat /proc/cpuinfo

二.查看内存:

free

三.查看硬盘:

df

linux下查看硬件信息

1、lspci 列出所有PCI 设备;

lspci - list all PCI devices:列出机器中的PCI设备(声卡、显卡、Modem、网卡、USB、主板集成设备也能

- java常见的ClassNotFoundException

bijian1013

java

1.java.lang.ClassNotFoundException: org.apache.commons.logging.LogFactory 添加包common-logging.jar2.java.lang.ClassNotFoundException: javax.transaction.Synchronization

- 【Gson五】日期对象的序列化和反序列化

bit1129

反序列化

对日期类型的数据进行序列化和反序列化时,需要考虑如下问题:

1. 序列化时,Date对象序列化的字符串日期格式如何

2. 反序列化时,把日期字符串序列化为Date对象,也需要考虑日期格式问题

3. Date A -> str -> Date B,A和B对象是否equals

默认序列化和反序列化

import com

- 【Spark八十六】Spark Streaming之DStream vs. InputDStream

bit1129

Stream

1. DStream的类说明文档:

/**

* A Discretized Stream (DStream), the basic abstraction in Spark Streaming, is a continuous

* sequence of RDDs (of the same type) representing a continuous st

- 通过nginx获取header信息

ronin47

nginx header

1. 提取整个的Cookies内容到一个变量,然后可以在需要时引用,比如记录到日志里面,

if ( $http_cookie ~* "(.*)$") {

set $all_cookie $1;

}

变量$all_cookie就获得了cookie的值,可以用于运算了

- java-65.输入数字n,按顺序输出从1最大的n位10进制数。比如输入3,则输出1、2、3一直到最大的3位数即999

bylijinnan

java

参考了网上的http://blog.csdn.net/peasking_dd/article/details/6342984

写了个java版的:

public class Print_1_To_NDigit {

/**

* Q65.输入数字n,按顺序输出从1最大的n位10进制数。比如输入3,则输出1、2、3一直到最大的3位数即999

* 1.使用字符串

- Netty源码学习-ReplayingDecoder

bylijinnan

javanetty

ReplayingDecoder是FrameDecoder的子类,不熟悉FrameDecoder的,可以先看看

http://bylijinnan.iteye.com/blog/1982618

API说,ReplayingDecoder简化了操作,比如:

FrameDecoder在decode时,需要判断数据是否接收完全:

public class IntegerH

- js特殊字符过滤

cngolon

js特殊字符js特殊字符过滤

1.js中用正则表达式 过滤特殊字符, 校验所有输入域是否含有特殊符号function stripscript(s) { var pattern = new RegExp("[`~!@#$^&*()=|{}':;',\\[\\].<>/?~!@#¥……&*()——|{}【】‘;:”“'。,、?]"

- hibernate使用sql查询

ctrain

Hibernate

import java.util.Iterator;

import java.util.List;

import java.util.Map;

import org.hibernate.Hibernate;

import org.hibernate.SQLQuery;

import org.hibernate.Session;

import org.hibernate.Transa

- linux shell脚本中切换用户执行命令方法

daizj

linuxshell命令切换用户

经常在写shell脚本时,会碰到要以另外一个用户来执行相关命令,其方法简单记下:

1、执行单个命令:su - user -c "command"

如:下面命令是以test用户在/data目录下创建test123目录

[root@slave19 /data]# su - test -c "mkdir /data/test123"

- 好的代码里只要一个 return 语句

dcj3sjt126com

return

别再这样写了:public boolean foo() { if (true) { return true; } else { return false;

- Android动画效果学习

dcj3sjt126com

android

1、透明动画效果

方法一:代码实现

public View onCreateView(LayoutInflater inflater, ViewGroup container, Bundle savedInstanceState)

{

View rootView = inflater.inflate(R.layout.fragment_main, container, fals

- linux复习笔记之bash shell (4)管道命令

eksliang

linux管道命令汇总linux管道命令linux常用管道命令

转载请出自出处:

http://eksliang.iteye.com/blog/2105461

bash命令执行的完毕以后,通常这个命令都会有返回结果,怎么对这个返回的结果做一些操作呢?那就得用管道命令‘|’。

上面那段话,简单说了下管道命令的作用,那什么事管道命令呢?

答:非常的经典的一句话,记住了,何为管

- Android系统中自定义按键的短按、双击、长按事件

gqdy365

android

在项目中碰到这样的问题:

由于系统中的按键在底层做了重新定义或者新增了按键,此时需要在APP层对按键事件(keyevent)做分解处理,模拟Android系统做法,把keyevent分解成:

1、单击事件:就是普通key的单击;

2、双击事件:500ms内同一按键单击两次;

3、长按事件:同一按键长按超过1000ms(系统中长按事件为500ms);

4、组合按键:两个以上按键同时按住;

- asp.net获取站点根目录下子目录的名称

hvt

.netC#asp.nethovertreeWeb Forms

使用Visual Studio建立一个.aspx文件(Web Forms),例如hovertree.aspx,在页面上加入一个ListBox代码如下:

<asp:ListBox runat="server" ID="lbKeleyiFolder" />

那么在页面上显示根目录子文件夹的代码如下:

string[] m_sub

- Eclipse程序员要掌握的常用快捷键

justjavac

javaeclipse快捷键ide

判断一个人的编程水平,就看他用键盘多,还是鼠标多。用键盘一是为了输入代码(当然了,也包括注释),再有就是熟练使用快捷键。 曾有人在豆瓣评

《卓有成效的程序员》:“人有多大懒,才有多大闲”。之前我整理了一个

程序员图书列表,目的也就是通过读书,让程序员变懒。 写道 程序员作为特殊的群体,有的人可以这么懒,懒到事情都交给机器去做,而有的人又可

- c++编程随记

lx.asymmetric

C++笔记

为了字体更好看,改变了格式……

&&运算符:

#include<iostream>

using namespace std;

int main(){

int a=-1,b=4,k;

k=(++a<0)&&!(b--

- linux标准IO缓冲机制研究

音频数据

linux

一、什么是缓存I/O(Buffered I/O)缓存I/O又被称作标准I/O,大多数文件系统默认I/O操作都是缓存I/O。在Linux的缓存I/O机制中,操作系统会将I/O的数据缓存在文件系统的页缓存(page cache)中,也就是说,数据会先被拷贝到操作系统内核的缓冲区中,然后才会从操作系统内核的缓冲区拷贝到应用程序的地址空间。1.缓存I/O有以下优点:A.缓存I/O使用了操作系统内核缓冲区,

- 随想 生活

暗黑小菠萝

生活

其实账户之前就申请了,但是决定要自己更新一些东西看也是最近。从毕业到现在已经一年了。没有进步是假的,但是有多大的进步可能只有我自己知道。

毕业的时候班里12个女生,真正最后做到软件开发的只要两个包括我,PS:我不是说测试不好。当时因为考研完全放弃找工作,考研失败,我想这只是我的借口。那个时候才想到为什么大学的时候不能好好的学习技术,增强自己的实战能力,以至于后来找工作比较费劲。我

- 我认为POJO是一个错误的概念

windshome

javaPOJO编程J2EE设计

这篇内容其实没有经过太多的深思熟虑,只是个人一时的感觉。从个人风格上来讲,我倾向简单质朴的设计开发理念;从方法论上,我更加倾向自顶向下的设计;从做事情的目标上来看,我追求质量优先,更愿意使用较为保守和稳妥的理念和方法。

&