【数据集收集】用于视觉问答VQA常用的数据集(持续更新,最后更新时间2019-09)

一、背景

最近刚开始做视觉问答VQA,看了很多文献,但是目前还无从下手,所以准备先把网上的公开的VQA数据集记录下来。前面自己也读了一些文献,文献中多多少少都有介绍数据集的情况,比如:

[1] 【文献阅读】VQA的综述:数据集,算法和挑战(K. Kafle等人,Computer Vision and Image Understanding,2017)

[2] 【文献阅读】兼顾图像理解和推理能力的VQA模型(R. Shrestha等人,CVPR,2019)

其中第[2]篇文章中对数据集的分类比较客观,主要可以分为两类,一类是自然图像,用于图像内容理解研究;一类是合成图像,用于图像中的关系推理研究。

二、数据集整理

1. 自然场景图像数据集

(1)DAQUAR(DAtaset for QUestion Answering on Real-world images)

介绍:最早也是最小的VQA数据集,包含了6795张训练数据和5673张测试数据,所有图像来自于数据集NYU-DepthV2 Dataset。该数据集质量较差,一些图像杂乱无章,分辨率低,并且问题和回答有明显的语法错误。

下载地址:https://www.mpi-inf.mpg.de/departments/computer-vision-and-machine-learning/research/vision-and-language/visual-turing-challenge/

参考文献:M. Malinowski and M. Fritz, \A multi-world approach to question answering about realworld scenes based on uncertain input," in Advances in Neural Information Processing Systems (NIPS), 2014.

(2)COCO-QA

介绍:QA pairs是由NLP算法生成的,图像来自COCO数据集,一共有78736个训练QA pairs和38948个测试QA pairs,大部分的问题是关于图像中的目标(69.84%),其他问题是关于颜色(16.59%),计数(7.47%),位置(6.10%)。所有问题的答案都是一个单词,只有435个独一无二的答案。数据集最大的缺点在于QA pairs是用NLP算法生成的,是将长句子划分成短句子处理的,这就忽视了句子中的语法和从句问题,算法结果不够智能;另外,数据集只有4类问题。

下载地址:http://www.cs.toronto.edu/~mren/imageqa/data/cocoqa/ (目前不可用)

参考文献:M. Ren, R. Kiros, and R. Zemel, \Exploring models and data for image questionanswering," in Advances in Neural Information Processing Systems (NIPS), 2015.

(3)FM-IQA(Freestyle Multilingual Image Question Answering)

介绍:基于COCO的一个数据集。数据集的QA都是人类生成的,来源是汉语,然后再机器翻译为英语,答案可以是一个句子。结果评估建议手动。

下载地址:

参考文献:H. Gao, J. Mao, J. Zhou, Z. Huang, L. Wang, and W. Xu, \Are you talking to a machine? Dataset and methods for multilingual image question answering," in Advances in Neural Information Processing Systems (NIPS), 2015.

(4)VQA-real

介绍:该数据集来自Virginia Tech,共有123287张训练图像,81434张测试图像,图像都来源于COCO,标注由人工进行,允许二值类问题,允许多选问题,每个问题可以提供17个备选答案。一共包含614163个问题,每一个问题都由10个不同的人进行一次回答。统计结果中,18%的问题需要常识,5.5%的问题需要成人常识。

下载地址:

参考文献:

(5)Visual Genome

介绍:包含图像108077张和1445233个QA Pairs,图像来源是YFCC100M和COCO数据集,共有约540万张图像中的区域描述信息,这些信息能够达到精细的语义层次,问题类型是6W(what, where, how, when, who, why),数据集并没有对训练和测试数据进行切分。QA的收集有两种方法,一种是随意人为提问(会出现相似问题或对图像全局内容提问),另一种是针对图像中的特定区域提问。该数据集中没有二值类问题。

下载地址:http://visualgenome.org/api/v0/api_home.html

参考文献:Ranjay Krishna, Yuke Zhu, Oliver Groth, Justin Johnson, Kenji Hata, Joshua Kravitz, Stephanie Chen, Yannis Kalantidis, Li-Jia Li, David A. Shamma, Michael S. Bernstein, and Li Fei-Fei. Visual genome: Connecting language and vision using crowdsourced dense image annotations. Int. J. Comp. Vis., 123(1):32–73, 2017.

(6)Visual7W

介绍:是Visual Genome数据集的一个子集,有47300张图像和139868个QA pairs,回答是多选式的,每一个问题有4个候选答案,其中只有一个是正确的。数据集不包含二值问题。

下载地址:http://web.stanford.edu/~yukez/visual7w/ (目前好像失效了)

参考文献:Yuke Zhu, Oliver Groth, Michael Bernstein, and Li Fei-Fei. Visual7w: Grounded question answering in images. In Proc. IEEE Conf. Comp. Vis. Patt. Recogn., 2016.

(7)VQAv1

介绍:人工标注的开放式问答数据集,但是VQAv1有很多类语言偏见(bias)。

下载地址:https://visualqa.org/vqa_v1_download.html

参考文献:S. Antol, A. Agrawal, J. Lu, M. Mitchell, D. Batra, C. L. Zitnick, and D. Parikh. VQA: Visual question answering. In ICCV, 2015.

(8)VQAv2

介绍:人工标注的开放式问答数据集,相较于VQAv1尽量减少了语言偏见(为每个问题补充了图片),但是仍存在一些偏见。

下载地址:https://visualqa.org/download.html

参考文献:Y. Goyal, T. Khot, D. Summers-Stay, D. Batra, and D. Parikh. Making the V in VQA matter: Elevating the role of image understanding in Visual Question Answering. In CVPR, 2017.

(9)Visual Madlibs

介绍:这一个填空的数据集。一共有10738张图(来自COCO),360001个描述句。

下载地址:

参考文献:L. Yu, E. Park, A. C. Berg, and T. L. Berg. Visual madlibs: Fill in the blank image generation and question answering. In Proc. IEEE Int. Conf. Comp. Vis., 2015

(10)TDIUC

介绍:该数据集尝试解决语言偏见,将问题分成了12类。

下载地址:

参考文献:K. Kafle and C. Kanan. An analysis of visual question answering algorithms. In ICCV, 2017.

2. 合成场景图像数据集

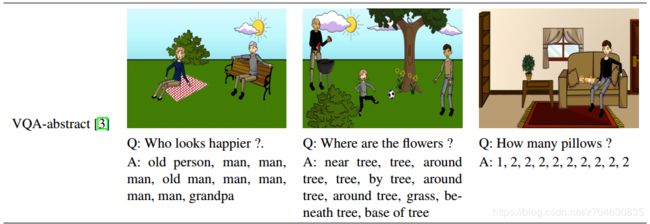

(1)VQA abstract scenes

介绍:该数据集的目标是进行高层次的推理。这些图像都是手动设计的,场景有两种,室内和室外,总计有50000个场景,每个场景有3个问题,每个问题提供10个答案,根据答案类型,可以将问题标记为“yes/no”,“number”,“other”三类。

下载地址:

参考文献:S. Antol, A. Agrawal, J. Lu, M. Mitchell, D. Batra, C. L. Zitnick, and D. Parikh. VQA: Visual Question Answering. In Proc. IEEE Int. Conf. Comp. Vis., 2015

示例如下:

(2)Balanced dataset

介绍:该数据集是为了解决数据偏见而设计的,一共包含了10295张训练图像和5328张测试图像。

下载地址:

参考文献:P. Zhang, Y. Goyal, D. Summers-Stay, D. Batra, and D. Parikh. Yin and yang: Balancing and answering binary visual questions. In Proc. IEEE Conf. Comp. Vis. Patt. Recogn., 2016

(3)CLEVR

介绍:该数据集为合成数据集,是由一些简单的几何形状构成的视觉场景。数据集中的问题总是需要一长串的推理过程,为了对推理能力进行详细评估,所有问题分为了5类:属性查询(querying attribute),属性比较(comparing attributes),存在性(existence),计数(counting),整数比较(integer comparison)。所有的问题都是程序生成的。该数据集的人为标注数据子集为CLEVR-Humans,

下载地址:

参考文献:J. Johnson, B. Hariharan, L. van der Maaten, L. Fei-Fei, C. L. Zitnick, and R. Girshick. CLEVR: A diagnostic dataset for compositional language and elementary visual reasoning. In CVPR, 2017.

3. 外部知识数据集

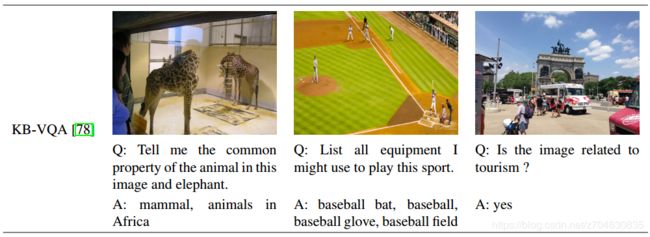

(1)KB-VQA

介绍:知识库是基于DBpedia,图片来源于COCO,每张图会有3-5个QA pairs,总计有2402个问题,每个问题都是从23种模板里面选择的。

下载地址:

参考文献:P. Wang, Q. Wu, C. Shen, A. v. d. Hengel, and A. Dick. Explicit knowledge-based reasoning for visual question answering. arXiv preprint arXiv:1511.02570, 2015

示例如下:

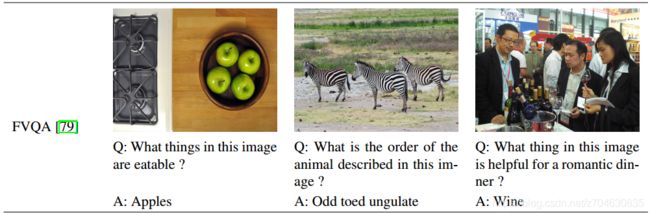

(2)FVQA

介绍:该数据集不仅有图像和QA pairs,还有外部知识(extra knowledge),知识库有193, 449个事实句子,包含图像2190张,问题5826个,整个数据集分成了5个train/test集,每个集合包含1100张训练图像和1090张测试图像,分别有2927和2899个问题,问题总共可以分成32类。

下载地址:

参考文献:Peng Wang, Qi Wu, Chunhua Shen, Anthony Dick, and Anton van den Hengel. FVQA: Fact-based visual question answering. IEEE Trans. Pattern Anal. Mach. Intell., pages 1–1, 2017.

示例如下:

4. 其他数据集

(1)Diagrams

介绍:数据集超过5000个场景,包含15000个多选问题及答案,

下载地址:

参考文献:A. Kembhavi, M. Salvato, E. Kolve, M. J. Seo, H. Hajishirzi, and A. Farhadi. A diagram is worth a dozen images. arXiv preprint arXiv:1603.07396, 2016

(2)Shapes

介绍:数据集包含244个问题和15616张图片,问题包含2-4种属性、目标类型、关系等。

下载地址:

参考文献:J. Andreas, M. Rohrbach, T. Darrell, and D. Klein. Neural Module Networks. In Proc. IEEE Conf. Comp. Vis. Patt. Recogn., 2016