每天一篇论文 304/365DeepFusion: Real-Time Dense 3D Reconstruction for Monocular SLAM

DeepFusion: Real-Time Dense 3D Reconstruction for Monocular SLAM using Single-View Depth and Gradient Predictions

摘要

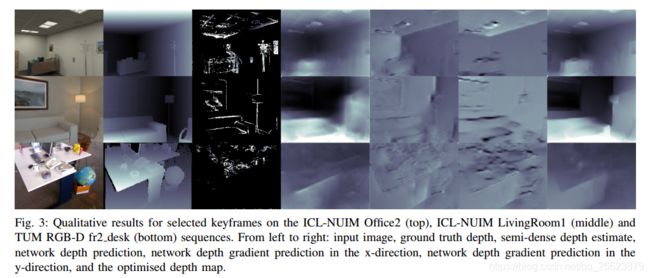

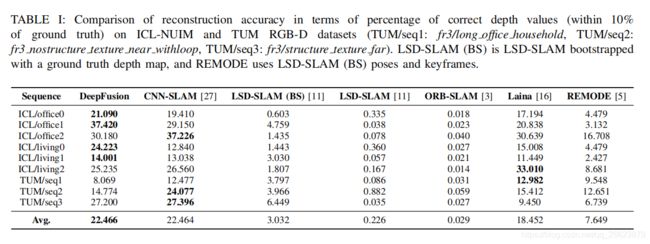

稀疏单目同步定位与映射(SLAM)系统生成的基于关键点的地图对于摄像机跟踪是有用的,但是对于许多机器人任务,可能需要密集的三维重建。涉及深度相机的解决方案在范围和室内空间上都是有限的,基于最小化帧间光度误差的密集重建系统通常受到很差的约束,并且会受到尺度模糊的影响。为了解决这些问题,我们提出了一个三维重建系统,该系统利用卷积神经网络(CNN)的输出为包含度量尺度的关键帧生成完全稠密的深度图。我们的系统,DeepFusion,能够在GPU上产生实时的密集重建。它使用网络产生的学习不确定性,以概率方式将半稠密多视图立体算法的输出与CNN的深度和梯度预测相融合。虽然每个关键帧只需要运行一次网络,但我们可以优化每个新帧的深度贴图,以便不断使用新的几何约束。基于它在合成数据集和真实世界数据集上的性能,我们证明了DeepFusion至少能够与其他可比系统一样执行。

方法

深度格式

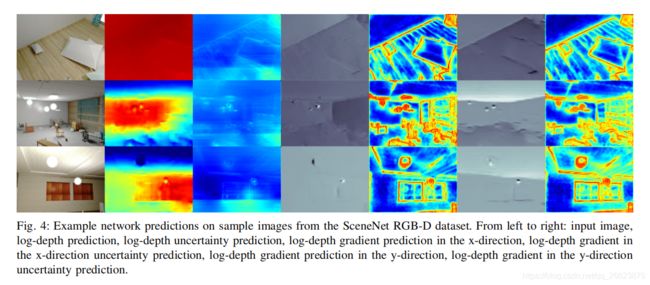

本文预测测log深度,而不是深度或反深度,因为它在数值上更适合于网络预测(负值有意义),而且它具有两个测log深度之间的差异(测log深度图像的梯度)是两个深度的比率的方便特性,这是标度不变的。我们还选择预测图像平面上x和y方向的测井深度梯度,而不是表面法线,以保持优化问题的线性,因为这避免了执行点积和归一化操作的需要。单视图深度预测是一个高度欠约束的问题,在实际应用中,网络似乎更容易对细粒度局部几何体进行精确预测,而不是对每像素深度进行绝对预测。

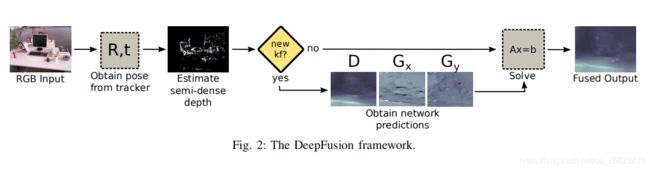

因此,我们分别预测绝对测log深度值和测log深度梯度,因为我们希望不同的不确定性反映出网络在这两种不同任务下能力的差异。如果未创建新的关键帧,则将当前半密集深度贴图和网络输出融合以更新当前深度贴图。

网络结构

为了将网络的输出与来自半稠密多视点立体系统的估计融合,我们要求在每个对数深度和梯度图像中的每个像素相关联的不确定性。

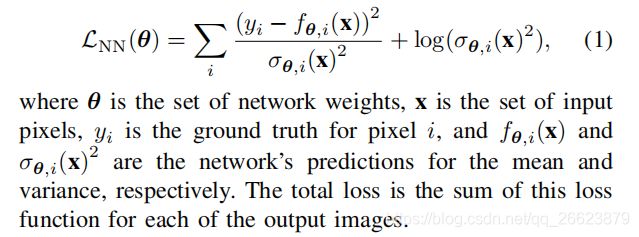

为了获得这一点,使用在[What uncertainties do we need in bayesian deep learning for computer vision ]中描述的方法使网络学习用最大似然代价函数预测均值和方差:

我们训练我们的网络来预测由scenet相机焦距标准化的测井深度。与CNN-SLAM[27]一样,我们通过测试时使用的摄像机焦距来缩放网络的对数深度预测,以便可以恢复具有不同内在特征的摄像机捕获的图像的绝对比例。由于所有预测都是在对数空间中进行的,因此不需要缩放梯度(表示深度比)和不确定性。