- springboot 整合 elk (Elasticsearch+Logstash+Kibana)

高大王竟然被注册

spring运维

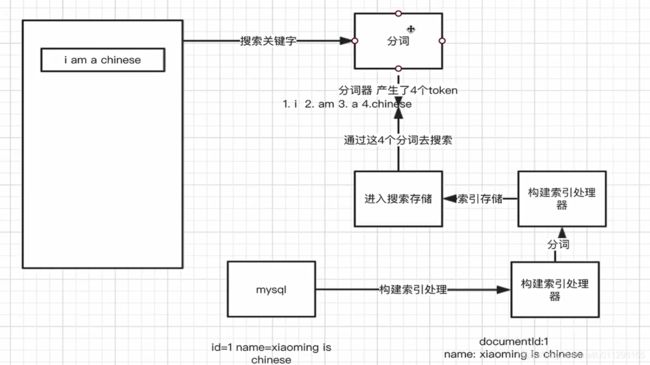

Elasticsearch是个开源分布式搜索引擎,它的特点有:分布式,零配置,自动发现,索引自动分片,索引副本机制,restful风格接口,多数据源,自动搜索负载等。Logstash是一个完全开源的工具,他可以对你的日志进行收集、过滤,并将其存储供以后使用(如,搜索)。Kibana也是一个开源和免费的工具,它Kibana可以为Logstash和ElasticSearch提供的日志分析友好的Web界

- 【Springboot知识】开发属于自己的中间件健康监测HealthIndicate

问道飞鱼

微服务相关技术springboot中间件后端HealthIndicate

文章目录**一、技术栈****二、项目结构****三、依赖配置(pom.xml)****四、配置文件(application.yml)****五、自定义健康检查实现****1.Redis健康检查****2.Elasticsearch健康检查****3.Kafka健康检查****4.MySQL健康检查****六、自定义健康检查接口(可选)****七、测试与验证****八、高级功能扩展****九、部署

- elk的相关的基础

weixin_43806846

elk

以下是关于ELK(Elasticsearch,Logstash,Kibana)的200个基础问题及其答案,涵盖了ELK的核心概念、组件、配置、使用场景、优化等方面。Elasticsearch基础**什么是Elasticsearch?**答:Elasticsearch是一个分布式、RESTful的搜索和分析引擎,基于ApacheLucene构建。**Elasticsearch的主要用途是什么?**答

- Elasticsearch Java High Level Client [7.17] 使用

DavidSoCool

javaelasticsearch开发语言

es的HighLevelClient存在es源代码的引用,结合springboot使用时,会存在es版本的冲突,这里记录下解决冲突和使用方式(es已经不建议使用这个了)。注意es服务端的版本需要与client的版本对齐,否则返回数据可能会解析失败!!!文档地址:JavaHighLevelRESTClient|JavaRESTClient[7.17]|Elastic1、首先创建个javaspring

- ES 使用geo point 查询离目标地址最近的数据

DavidSoCool

elasticsearchMysqlelasticsearch搜索引擎mysql

需求描述:项目中需要通过经纬度坐标查询目标地所在的行政区。解决思路大致有种,使用es和mysql分别查询。1、使用es进行查询将带有经纬度坐标的省市区数据存入es中,mappings字段使用geopoint类型,索引及查询dsl如下。geopoint文档地址:Geo-distancequery|ElasticsearchGuide[8.6]|ElasticSortsearchresults|Ela

- 【实战ES】实战 Elasticsearch:快速上手与深度实践-附录-1-常用命令速查表-集群健康检查、索引生命周期管理、故障诊断命令

言析数智

实战elasticsearch搜索引擎大数据

点击关注不迷路点击关注不迷路点击关注不迷路附录-常用命令速查表1-Elasticsearch运维命令速查表(集群健康检查、ILM管理、故障诊断)一、集群健康检查与监控1.1集群健康状态核心命令1.2节点级健康诊断二、索引生命周期管理(ILM)2.1ILM策略配置模板2.2ILM操作命令集三、故障诊断命令大全3.1分片问题诊断流程3.2常见故障场景处理场景1:`节点离线导致分片未分配`场景2:`高内

- SpringBoot整合Netty

晚上睡不着!

#SpringBootspringbootniowebsockettcp/iphttp

前言Netty是一个高性能、异步事件驱动的网络应用程序框架,用于快速开发可维护的高并发协议服务器和客户端。Netty主要基于JavaNIO实现,提供了异步和事件驱动的网络编程工具,简化了TCP和UDP服务器的编程。Netty广泛应用于分布式系统、实时通信、游戏开发等领域,例如,知名的Elasticsearch和Dubbo框架内部都采用了Netty。Netty吸收了多种协议的实现经验,经过精心设计,

- 通过 ElasticSearch的Python API和`curl` 命令获取Elasticsearch 所有索引名称

BigBookX

elasticsearchjenkins大数据

导言在大数据管理和实时搜索场景中,Elasticsearch是一款不可或缺的工具。无论是开发调试、数据维护,还是系统监控,快速列出所有索引名称都是一个高频需求。本文将手把手教你如何通过Python客户端连接Elasticsearch,并用两种方法获取索引列表,同时提供代码示例和实战技巧,助你高效掌控Elasticsearch的索引管理。一、为什么需要列出索引名称?在Elasticsearch中,索

- [特殊字符] Elasticsearch 双剑合璧:HTTP API 与 Java API 实战整合指南

周小闯

elasticsearch项目实战elasticsearchhttpjava

Elasticsearch双剑合璧:HTTPAPI与JavaAPI实战整合指南一、HTTPAPI定义与用途Elasticsearch的HTTPAPI是基于RESTful接口设计的核心交互方式,支持通过URL和JSON数据直接操作索引、文档、集群等资源。适用于快速调试、脚本调用和跨语言集成。1.索引管理(1)创建索引(指定分片与映射)PUT/products{"settings":{"number_

- Easyliev在线视频分享平台项目总结——SpringBoot、Mybatis、Redis、ElasticSearch、FFmpeg

周小闯

项目总结springbootmybatisredis

EasyLive项目总结登陆注册获取图片验证码captchat插件base编码(图片,用于前端展示)checkCodeKey验证码标识(用于匹配redis缓存,校验验证码)redis缓存保存验证码缓存用于登录注册校验(checkCodeKey为标识)注册校验验证码根据前端传递的checkCodeKey,在Redis缓存中查找验证码并进行比较注册昵称是否被使用邮箱是否被使用清除Redis中的验证码缓

- 【大数据】大数据处理-Lambda架构-Kappa架构

weixin_33884611

大数据系统架构

大数据处理-Lambda架构-Kappa架构elasticsearch-headElasticsearch-sqlclientNLPchina/elasticsearch-sql:UseSQLtoqueryElasticsearch360企业安全V5.6SP1,杨军01,您好!lamda架构_百度搜索Lambda架构vsKappa架构-数据源博客-CSDN博客数据系统架构——Lambdaarchi

- flink-cdc实时增量同步mysql数据到elasticsearch

大数据技术派

#Flinkelasticsearchflinkmysql

什么是CDC?CDC是(ChangeDataCapture变更数据获取)的简称。核心思想是,监测并捕获数据库的变动(包括数据或数据表的插入INSERT、更新UPDATE、删除DELETE等),将这些变更按发生的顺序完整记录下来,写入到消息中间件中以供其他服务进行订阅及消费。1.环境准备mysqlelasticsearchflinkonyarn说明:如果没有安装hadoop,那么可以不用yarn,直

- Kibana 单机与集群部署教程

闲人编程

大数据集群部署教程大数据集群单机部署Kibana日志分析数据可视化

目录Kibana单机与集群部署教程第一部分:Kibana概述第二部分:Kibana单机部署教程1.安装Kibana1.1安装依赖项1.2下载和安装Kibana1.3启动Kibana2.单机案例代码实现(Python)3.常见问题及解决方法3.1无法启动Kibana服务3.2Kibana无法连接到Elasticsearch第三部分:Kibana集群部署教程1.配置集群节点1.1配置Elasticse

- Elasticsearch(ES)详解:从入门到实践

坚持蛊

elasticsearchjenkins大数据

引言简介:Elasticsearch是一个基于Lucene的分布式搜索引擎,具有高效的全文搜索功能,广泛应用于日志分析、搜索引擎、实时数据处理等领域。本文目标:介绍Elasticsearch的基本概念、架构设计、配置优化、常见应用以及实际案例,帮助开发者掌握ES1.Elasticsearch概述Elasticsearch的背景和发展历程核心功能:全文检索、分布式搜索、实时数据分析主要应用场景:日志

- ES8的Java API client 8.0 简单示例操作 Elasticsearch

it-shiyadi

esjavaelasticsearch开发语言

1.加入依赖co.elastic.clientselasticsearch-java8.12.22.配置类@Slf4j@ConfigurationpublicclassElasticSearchConfig{@Value("${elasticsearch.hosts}")privateStringhosts;@Value("${elasticsearch.port}")privateintport

- Elasticsearch 入门教学:从零开始掌握分布式搜索引擎

格子先生Lab

搜索引擎elasticsearch分布式

引言Elasticsearch是一个开源的分布式搜索引擎,基于ApacheLucene构建,能够实现近乎实时的数据搜索和分析。它广泛应用于日志分析、全文搜索、数据可视化等场景。本文将带你从零开始学习Elasticsearch,掌握其基本概念、安装配置、数据操作及搜索功能。1.Elasticsearch简介1.1什么是Elasticsearch?Elasticsearch是一个分布式的RESTful

- ELK Stack 安装教程 - 构建日志存储告警系统

运维

介绍“ELK”是三个开源项目的首字母缩写,这三个项目分别是:Elasticsearch、Logstash和Kibana。Elasticsearch是一个搜索和分析引擎。Logstash是服务器端数据处理管道,能够同时从多个来源采集数据,转换数据,然后将数据发送到诸如Elasticsearch等“存储库”中。Kibana则可以让用户在Elasticsearch中使用图形和图表对数据进行可视化。目前最

- 快速入门:利用fast-elasticsearch-vector-scoring提升ES向量搜索效率

劳泉文Luna

快速入门:利用fast-elasticsearch-vector-scoring提升ES向量搜索效率fast-elasticsearch-vector-scoringScoredocumentsusingembedding-vectorsdot-productorcosine-similaritywithESLuceneengine项目地址:https://gitcode.com/gh_mirro

- ARM64环境部署EFK8.15.3收集K8S集群容器日志

llody_55

kubernetes容器云原生运维esjavaelasticsearch

环境规划主机IP系统部署方式ES版本CPU架构用户名密码192.168.1.225Ubuntu22.04.4LTSdockerelasticsearch:8.15.3ARM64elasticllodyi4TMmZDES集群部署创建持久化目录(所有节点)mkdir-p/data/es/{data,certs,logs,plugins}mkdir-p/data/es/certs/{ca,es01}服务

- 这给我干哪来了,MySQL都9.2了

赵师的工作日

mysql数据库

作者:赵师的工作日(赵明中)现役OracleACE、MySQL8.0ocp、TiDBPCTA\PCTP、ElasticsearchCertifiedEngineer微信号:mzzhao23微信公众号:赵师的工作日墨天轮社区:赵师的工作日CSND:赵师的工作日MySQL9.2都来了确实有时间没上MySQL官网(www.mysql.com),MySQL都出9.2版本了。现在业内大头都是8.x版本,少部

- MySQL-关于如何保存“大数据”

赵师的工作日

mysql大数据数据库

作者:赵师的工作日(赵明中)现役OracleACE、MySQL8.0ocp、TiDBPCTA\PCTP、ElasticsearchCertifiedEngineer微信号:mzzhao23微信公众号:赵师的工作日墨天轮社区:赵师的工作日CSND:赵师的工作日数据库的种类有很多,各类数据库充分发挥各自的优势从而保证业务稳定运行,mysql轻量级、关键数据,redis缓存、快,ES搜索,Mongodb

- 【实战ES】实战 Elasticsearch:快速上手与深度实践-6.2.2GDPR数据脱敏处理

言析数智

实战elasticsearch大数据搜索引擎

点击关注不迷路点击关注不迷路点击关注不迷路文章大纲6.2.2GDPR数据脱敏处理深度实践指南1.GDPR核心要求映射1.1关键条款与技术要求1.2`数据类型与脱敏策略`2.全链路脱敏配置2.1`动态脱敏管道`2.2静态脱敏模板3.`脱敏算法性能对比`3.1算法性能矩阵3.2存储成本分析4.企业级合规方案4.1金融行业案例4.2医疗行业方案5.合规性验证方案5.1自动化检查脚本5.2审计检查清单6.

- doris:Elasticsearch

向阳1218

大数据doris

ElasticsearchCatalog除了支持自动映射ES元数据外,也可以利用Doris的分布式查询规划能力和ES(Elasticsearch)的全文检索能力相结合,提供更完善的OLAP分析场景解决方案:ES中的多index分布式Join查询。Doris和ES中的表联合查询,更复杂的全文检索过滤。使用限制支持Elasticsearch5.x及以上版本。创建CatalogCREATECATALOG

- Elasticsearch在Linux环境下部署(单机版)

Handsome Mr.Li

elasticsearchelasticsearchlinux搜索引擎

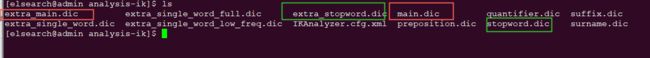

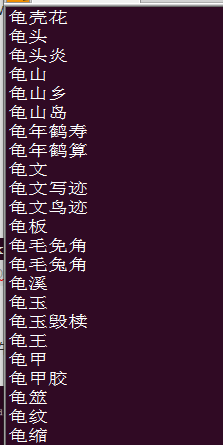

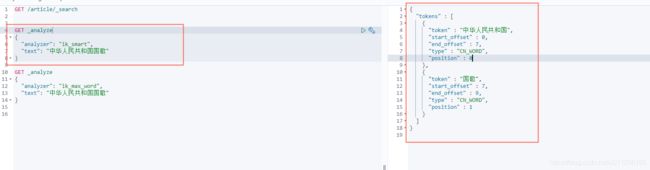

目录1.前言2.Centos下安装2.1下载完成后进行解压操作2.2修改内存参数2.3创建ES专属用户2.4修改ES核心配置信息3.配置Elasticsearch的用户名密码3.1编辑配置文件3.2重启es服务3.3设置用户名密码3.4验证是否生效4.安装ik中文分词器1.前言我的Elasticsearch版本为7.3.2Elasticsearch下载地址:下载地址2.Centos下安装2.1下载

- 基于Linux环境部署和使用ElasticSearch搜索引擎

探模之翼

数据库搜索引擎linuxelasticsearch向量数据库多模态检索

目录一.Elasticsearch基础介绍二.Docker部署单节点ElasticSearch1.环境配置2.创建数据目录3.创建ES自定义配置文件4.启动ElasticSearch服务5.验证服务三.DockerCompose部署单节点ElasticSearch1.环境配置2.创建docker-compose.yml3.创建配置文件elasticsearch.yml4.启动ElasticSear

- 2025年渗透测试面试题总结-快某手-安全实习生(一面、二面)(题目+回答)

独行soc

2025年渗透测试面试指南安全科技网络面试护网2015年

网络安全领域各种资源,学习文档,以及工具分享、前沿信息分享、POC、EXP分享。不定期分享各种好玩的项目及好用的工具,欢迎关注。目录快某手-安全实习生一面一、Linux操作:查看进程PID的5种方法二、Elasticsearch(ES)核心要点三、HTTPS建立过程(TLS1.3优化版)四、Python内存管理机制五、深拷贝与浅拷贝对比六、Python多线程局限性七、XSS防御方案八、SQL注入防

- laravel使用elasticsearch

菜菜c

PHPelasticsearchlaravel搜索引擎

laravel使用elasticsearchlaravel中安装扩展包composer安装elasticsearch扩展包Elasticsearch官方提供了Composer包,在引入时需要注意要指定版本,因为不同版本的Elasticsearch的API略有不同,因为我用的是7.12.x,因此需使用~7.12.x来指定包版本。composerrequireelasticsearch/elastic

- 如何使用Java和ElasticSearch实现全文搜索

微赚淘客系统开发者@聚娃科技

javaelasticsearch开发语言

如何使用Java和ElasticSearch实现全文搜索大家好,我是微赚淘客系统3.0的小编,是个冬天不穿秋裤,天冷也要风度的程序猿!今天我们来探讨如何使用Java和ElasticSearch实现全文搜索。ElasticSearch是一个分布式搜索和分析引擎,能够处理大规模数据并提供实时搜索功能。在本文中,我们将介绍如何使用Java客户端与ElasticSearch进行交互,实现简单的全文搜索功能

- docker 安装ELK 8.17.3

离开水的飞鱼

dockerelk容器

ELK是指Elasticsearch、Logstash和Kibana这三个开源软件的组合。Elasticsearch是一个分布式的搜索和分析引擎,用于日志的存储,搜索,分析,查询。Logstash是一个数据收集、转换和传输工具,用于收集过滤和转换数据,然后将其发送到Elasticsearch或其他目标存储中。Kibana是一个数据可视化平台,通过与Elasticsearch的集成,提供了强大的数据

- Laravel Elasticsearch 教程

贾泉希

LaravelElasticsearch教程laravel-elasticsearchElasticsearchforLaravel项目地址:https://gitcode.com/gh_mirrors/lar/laravel-elasticsearch本指南将帮助您了解laravel-elasticsearch开源项目的基础,包括其目录结构、启动文件以及配置文件的简介,以便您可以顺利地在Lara

- 微信开发者验证接口开发

362217990

微信 开发者 token 验证

微信开发者接口验证。

Token,自己随便定义,与微信填写一致就可以了。

根据微信接入指南描述 http://mp.weixin.qq.com/wiki/17/2d4265491f12608cd170a95559800f2d.html

第一步:填写服务器配置

第二步:验证服务器地址的有效性

第三步:依据接口文档实现业务逻辑

这里主要讲第二步验证服务器有效性。

建一个

- 一个小编程题-类似约瑟夫环问题

BrokenDreams

编程

今天群友出了一题:

一个数列,把第一个元素删除,然后把第二个元素放到数列的最后,依次操作下去,直到把数列中所有的数都删除,要求依次打印出这个过程中删除的数。

&

- linux复习笔记之bash shell (5) 关于减号-的作用

eksliang

linux关于减号“-”的含义linux关于减号“-”的用途linux关于“-”的含义linux关于减号的含义

转载请出自出处:

http://eksliang.iteye.com/blog/2105677

管道命令在bash的连续处理程序中是相当重要的,尤其在使用到前一个命令的studout(标准输出)作为这次的stdin(标准输入)时,就显得太重要了,某些命令需要用到文件名,例如上篇文档的的切割命令(split)、还有

- Unix(3)

18289753290

unix ksh

1)若该变量需要在其他子进程执行,则可用"$变量名称"或${变量}累加内容

什么是子进程?在我目前这个shell情况下,去打开一个新的shell,新的那个shell就是子进程。一般状态下,父进程的自定义变量是无法在子进程内使用的,但通过export将变量变成环境变量后就能够在子进程里面应用了。

2)条件判断: &&代表and ||代表or&nbs

- 关于ListView中性能优化中图片加载问题

酷的飞上天空

ListView

ListView的性能优化网上很多信息,但是涉及到异步加载图片问题就会出现问题。

具体参看上篇文章http://314858770.iteye.com/admin/blogs/1217594

如果每次都重新inflate一个新的View出来肯定会造成性能损失严重,可能会出现listview滚动是很卡的情况,还会出现内存溢出。

现在想出一个方法就是每次都添加一个标识,然后设置图

- 德国总理默多克:给国人的一堂“震撼教育”课

永夜-极光

教育

http://bbs.voc.com.cn/topic-2443617-1-1.html德国总理默多克:给国人的一堂“震撼教育”课

安吉拉—默克尔,一位经历过社会主义的东德人,她利用自己的博客,发表一番来华前的谈话,该说的话,都在上面说了,全世界想看想传播——去看看默克尔总理的博客吧!

德国总理默克尔以她的低调、朴素、谦和、平易近人等品格给国人留下了深刻印象。她以实际行动为中国人上了一堂

- 关于Java继承的一个小问题。。。

随便小屋

java

今天看Java 编程思想的时候遇见一个问题,运行的结果和自己想想的完全不一样。先把代码贴出来!

//CanFight接口

interface Canfight {

void fight();

}

//ActionCharacter类

class ActionCharacter {

public void fight() {

System.out.pr

- 23种基本的设计模式

aijuans

设计模式

Abstract Factory:提供一个创建一系列相关或相互依赖对象的接口,而无需指定它们具体的类。 Adapter:将一个类的接口转换成客户希望的另外一个接口。A d a p t e r模式使得原本由于接口不兼容而不能一起工作的那些类可以一起工作。 Bridge:将抽象部分与它的实现部分分离,使它们都可以独立地变化。 Builder:将一个复杂对象的构建与它的表示分离,使得同

- 《周鸿祎自述:我的互联网方法论》读书笔记

aoyouzi

读书笔记

从用户的角度来看,能解决问题的产品才是好产品,能方便/快速地解决问题的产品,就是一流产品.

商业模式不是赚钱模式

一款产品免费获得海量用户后,它的边际成本趋于0,然后再通过广告或者增值服务的方式赚钱,实际上就是创造了新的价值链.

商业模式的基础是用户,木有用户,任何商业模式都是浮云.商业模式的核心是产品,本质是通过产品为用户创造价值.

商业模式还包括寻找需求

- JavaScript动态改变样式访问技术

百合不是茶

JavaScriptstyle属性ClassName属性

一:style属性

格式:

HTML元素.style.样式属性="值";

创建菜单:在html标签中创建 或者 在head标签中用数组创建

<html>

<head>

<title>style改变样式</title>

</head>

&l

- jQuery的deferred对象详解

bijian1013

jquerydeferred对象

jQuery的开发速度很快,几乎每半年一个大版本,每两个月一个小版本。

每个版本都会引入一些新功能,从jQuery 1.5.0版本开始引入的一个新功能----deferred对象。

&nb

- 淘宝开放平台TOP

Bill_chen

C++c物流C#

淘宝网开放平台首页:http://open.taobao.com/

淘宝开放平台是淘宝TOP团队的产品,TOP即TaoBao Open Platform,

是淘宝合作伙伴开发、发布、交易其服务的平台。

支撑TOP的三条主线为:

1.开放数据和业务流程

* 以API数据形式开放商品、交易、物流等业务;

&

- 【大型网站架构一】大型网站架构概述

bit1129

网站架构

大型互联网特点

面对海量用户、海量数据

大型互联网架构的关键指标

高并发

高性能

高可用

高可扩展性

线性伸缩性

安全性

大型互联网技术要点

前端优化

CDN缓存

反向代理

KV缓存

消息系统

分布式存储

NoSQL数据库

搜索

监控

安全

想到的问题:

1.对于订单系统这种事务型系统,如

- eclipse插件hibernate tools安装

白糖_

Hibernate

eclipse helios(3.6)版

1.启动eclipse 2.选择 Help > Install New Software...> 3.添加如下地址:

http://download.jboss.org/jbosstools/updates/stable/helios/ 4.选择性安装:hibernate tools在All Jboss tool

- Jquery easyui Form表单提交注意事项

bozch

jquery easyui

jquery easyui对表单的提交进行了封装,提交的方式采用的是ajax的方式,在开发的时候应该注意的事项如下:

1、在定义form标签的时候,要将method属性设置成post或者get,特别是进行大字段的文本信息提交的时候,要将method设置成post方式提交,否则页面会抛出跨域访问等异常。所以这个要

- Trie tree(字典树)的Java实现及其应用-统计以某字符串为前缀的单词的数量

bylijinnan

java实现

import java.util.LinkedList;

public class CaseInsensitiveTrie {

/**

字典树的Java实现。实现了插入、查询以及深度优先遍历。

Trie tree's java implementation.(Insert,Search,DFS)

Problem Description

Igna

- html css 鼠标形状样式汇总

chenbowen00

htmlcss

css鼠标手型cursor中hand与pointer

Example:CSS鼠标手型效果 <a href="#" style="cursor:hand">CSS鼠标手型效果</a><br/>

Example:CSS鼠标手型效果 <a href="#" style=&qu

- [IT与投资]IT投资的几个原则

comsci

it

无论是想在电商,软件,硬件还是互联网领域投资,都需要大量资金,虽然各个国家政府在媒体上都给予大家承诺,既要让市场的流动性宽松,又要保持经济的高速增长....但是,事实上,整个市场和社会对于真正的资金投入是非常渴望的,也就是说,表面上看起来,市场很活跃,但是投入的资金并不是很充足的......

- oracle with语句详解

daizj

oraclewithwith as

oracle with语句详解 转

在oracle中,select 查询语句,可以使用with,就是一个子查询,oracle 会把子查询的结果放到临时表中,可以反复使用

例子:注意,这是sql语句,不是pl/sql语句, 可以直接放到jdbc执行的

----------------------------------------------------------------

- hbase的简单操作

deng520159

数据库hbase

近期公司用hbase来存储日志,然后再来分析 ,把hbase开发经常要用的命令找了出来.

用ssh登陆安装hbase那台linux后

用hbase shell进行hbase命令控制台!

表的管理

1)查看有哪些表

hbase(main)> list

2)创建表

# 语法:create <table>, {NAME => <family&g

- C语言scanf继续学习、算术运算符学习和逻辑运算符

dcj3sjt126com

c

/*

2013年3月11日20:37:32

地点:北京潘家园

功能:完成用户格式化输入多个值

目的:学习scanf函数的使用

*/

# include <stdio.h>

int main(void)

{

int i, j, k;

printf("please input three number:\n"); //提示用

- 2015越来越好

dcj3sjt126com

歌曲

越来越好

房子大了电话小了 感觉越来越好

假期多了收入高了 工作越来越好

商品精了价格活了 心情越来越好

天更蓝了水更清了 环境越来越好

活得有奔头人会步步高

想做到你要努力去做到

幸福的笑容天天挂眉梢 越来越好

婆媳和了家庭暖了 生活越来越好

孩子高了懂事多了 学习越来越好

朋友多了心相通了 大家越来越好

道路宽了心气顺了 日子越来越好

活的有精神人就不显

- java.sql.SQLException: Value '0000-00-00' can not be represented as java.sql.Tim

feiteyizu

mysql

数据表中有记录的time字段(属性为timestamp)其值为:“0000-00-00 00:00:00”

程序使用select 语句从中取数据时出现以下异常:

java.sql.SQLException:Value '0000-00-00' can not be represented as java.sql.Date

java.sql.SQLException: Valu

- Ehcache(07)——Ehcache对并发的支持

234390216

并发ehcache锁ReadLockWriteLock

Ehcache对并发的支持

在高并发的情况下,使用Ehcache缓存时,由于并发的读与写,我们读的数据有可能是错误的,我们写的数据也有可能意外的被覆盖。所幸的是Ehcache为我们提供了针对于缓存元素Key的Read(读)、Write(写)锁。当一个线程获取了某一Key的Read锁之后,其它线程获取针对于同

- mysql中blob,text字段的合成索引

jackyrong

mysql

在mysql中,原来有一个叫合成索引的,可以提高blob,text字段的效率性能,

但只能用在精确查询,核心是增加一个列,然后可以用md5进行散列,用散列值查找

则速度快

比如:

create table abc(id varchar(10),context blog,hash_value varchar(40));

insert into abc(1,rep

- 逻辑运算与移位运算

latty

位运算逻辑运算

源码:正数的补码与原码相同例+7 源码:00000111 补码 :00000111 (用8位二进制表示一个数)

负数的补码:

符号位为1,其余位为该数绝对值的原码按位取反;然后整个数加1。 -7 源码: 10000111 ,其绝对值为00000111 取反加一:11111001 为-7补码

已知一个数的补码,求原码的操作分两种情况:

- 利用XSD 验证XML文件

newerdragon

javaxmlxsd

XSD文件 (XML Schema 语言也称作 XML Schema 定义(XML Schema Definition,XSD)。 具体使用方法和定义请参看:

http://www.w3school.com.cn/schema/index.asp

java自jdk1.5以上新增了SchemaFactory类 可以实现对XSD验证的支持,使用起来也很方便。

以下代码可用在J

- 搭建 CentOS 6 服务器(12) - Samba

rensanning

centos

(1)安装

# yum -y install samba

Installed:

samba.i686 0:3.6.9-169.el6_5

# pdbedit -a rensn

new password:123456

retype new password:123456

……

(2)Home文件夹

# mkdir /etc

- Learn Nodejs 01

toknowme

nodejs

(1)下载nodejs

https://nodejs.org/download/ 选择相应的版本进行下载 (2)安装nodejs 安装的方式比较多,请baidu下

我这边下载的是“node-v0.12.7-linux-x64.tar.gz”这个版本 (1)上传服务器 (2)解压 tar -zxvf node-v0.12.

- jquery控制自动刷新的代码举例

xp9802

jquery

1、html内容部分 复制代码代码示例: <div id='log_reload'>

<select name="id_s" size="1">

<option value='2'>-2s-</option>

<option value='3'>-3s-</option

![]()

![]()