Spring Cloud Alibaba Seata处理分布式事务

一、分布式事务问题

1.1 分布式之后

- 单体应用被拆分成微服务应用,原来的三个模块被拆分成三个独立的应用,分别使用三个独立的数据源

- 业务操作需要调用三个服务来完成。此时每个服务内部的数据一致性由本地事务来保证, 但是全局的数据一致性问题没法保证。

1.2 分布式前

- 单机单库没这个问题,从1:1 -> 1:N -> N: N,到微服务。

总结:**微服务中一次业务操作需要跨多个数据源或需要跨多个系统进行远程调用,就会产生分布式事务问题。**即对一次业务操作部分微服务数据源更新成功,部分微服务的数据源更新失败,不满足事务的特性ACID。

1.3 如何解决分布式事务问题

二、Seata简介

官网地址:http://seata.io/zh-cn/

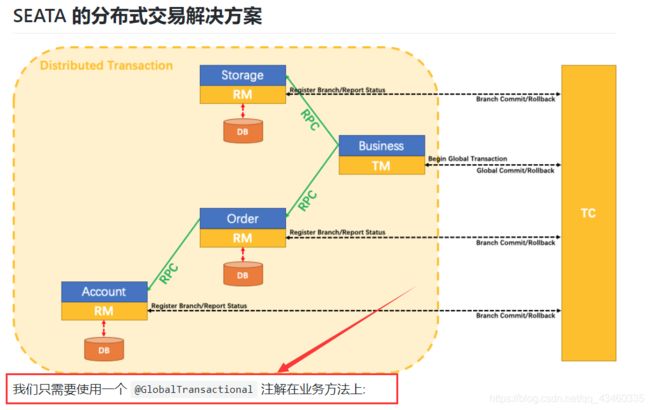

Seata是一款开源的分布式事务解决方案,致力于在微服务架构下提供高性能和简单易用的分布式事务服务。

2.1 分布式事务处理过程的-ID+三组件模型

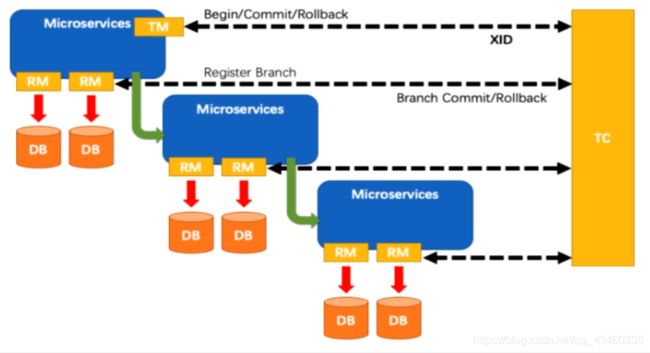

- Transaction ID XID:全局唯一的事务ID

- TC (Transaction Coordinator) - 事务协调者 :维护全局事务的运行状态,负责协调并驱动全局事务的提交或回滚;

- TM (Transaction Manager) - 事务管理器 :定义全局事务的范围:开始全局事务、提交或回滚全局事务。

- RM (Resource Manager) - 资源管理器 :控制分支事务,负责分支注册,状态汇报,并接收事务协调器的指令,驱动分支(本地)事务的提交和回滚。

2.2 一个典型的分布式事务过程

- TM向TC申请开启一 个全局事务,全局事务创建成功并生成一 个全局唯一 的XID;

- XID在微服务调用链路的上下文中传播;

- RM向TC注册分支事务,将其纳入XID对应全局事务的管辖;

- TM向TC发起针对XID的全局提交或回滚决议;

- TC 调度XID下管辖的全部分支事务完成提交或回滚请求。

三、Seata-Server安装

3.1 下载

下载地址:https://github.com/seata/seata/releases

这里下载0.9版本用于测试。

3.2 解压并修改配置文件

seata-server-0.9.0.zip解压到指定目录并修改conf目录下的file.conf配置文件:

- 先备份原始file.conf文件

- 主要修改:自定义事务组名称+事务日志存储模式为db+数据库连接信息

file.conf:

- service模块:

vgroup_mapping.my_test_tx_group = "fsp_tx_group" - store模块:

mode = "db"

url = "jdbc:mysql://127.0.0.1:3306/seata"

user = "root"

password = "你自己的密码"

3.3 mysql数据库新建库seata

在seata库里建表:建表db_store.sql在\seata-server-0.9.0\seata\conf目录里面,db_store.sql 语句执行即可。

SQL语句:

-- the table to store GlobalSession data

drop table if exists `global_table`;

create table `global_table` (

`xid` varchar(128) not null,

`transaction_id` bigint,

`status` tinyint not null,

`application_id` varchar(32),

`transaction_service_group` varchar(32),

`transaction_name` varchar(128),

`timeout` int,

`begin_time` bigint,

`application_data` varchar(2000),

`gmt_create` datetime,

`gmt_modified` datetime,

primary key (`xid`),

key `idx_gmt_modified_status` (`gmt_modified`, `status`),

key `idx_transaction_id` (`transaction_id`)

);

-- the table to store BranchSession data

drop table if exists `branch_table`;

create table `branch_table` (

`branch_id` bigint not null,

`xid` varchar(128) not null,

`transaction_id` bigint ,

`resource_group_id` varchar(32),

`resource_id` varchar(256) ,

`lock_key` varchar(128) ,

`branch_type` varchar(8) ,

`status` tinyint,

`client_id` varchar(64),

`application_data` varchar(2000),

`gmt_create` datetime,

`gmt_modified` datetime,

primary key (`branch_id`),

key `idx_xid` (`xid`)

);

-- the table to store lock data

drop table if exists `lock_table`;

create table `lock_table` (

`row_key` varchar(128) not null,

`xid` varchar(96),

`transaction_id` long ,

`branch_id` long,

`resource_id` varchar(256) ,

`table_name` varchar(32) ,

`pk` varchar(36) ,

`gmt_create` datetime ,

`gmt_modified` datetime,

primary key(`row_key`)

);

3.4 修改seata-server-0.9.0\seata\conf目录下的registry.conf配置文件

registry {

# file 、nacos 、eureka、redis、zk、consul、etcd3、sofa

type = "nacos"

nacos {

serverAddr = "localhost:8848"

namespace = ""

cluster = "default"

}

目的是:指明注册中心为nacos,及修改nacos连接信息

3.5 测试启动

先启动Nacos端口号8848,再启动seata-server,直接执行softs\seata-server-0.9.0\seata\bin下的seata-server.bat即可,若出现闪退,则可在cmd窗口运行该文件。

可能会出现以下问题(我搞了好久,o(╥﹏╥)o)

Exception in thread "main" java.lang.RuntimeException: java.net.BindException: Address already in use: bind

at io.seata.core.rpc.netty.AbstractRpcRemotingServer.start(AbstractRpcRemotingServer.java:161)

at io.seata.core.rpc.netty.RpcServer.init(RpcServer.java:130)

at io.seata.server.Server.main(Server.java:87)

Caused by: java.net.BindException: Address already in use: bind

at sun.nio.ch.Net.bind0(Native Method)

at sun.nio.ch.Net.bind(Net.java:433)

at sun.nio.ch.Net.bind(Net.java:425)

at sun.nio.ch.ServerSocketChannelImpl.bind(ServerSocketChannelImpl.java:223)

at io.netty.channel.socket.nio.NioServerSocketChannel.doBind(NioServerSocketChannel.java:130)

at io.netty.channel.AbstractChannel$AbstractUnsafe.bind(AbstractChannel.java:558)

at io.netty.channel.DefaultChannelPipeline$HeadContext.bind(DefaultChannelPipeline.java:1358)

at io.netty.channel.AbstractChannelHandlerContext.invokeBind(AbstractChannelHandlerContext.java:501)

at io.netty.channel.AbstractChannelHandlerContext.bind(AbstractChannelHandlerContext.java:486)

at io.netty.channel.DefaultChannelPipeline.bind(DefaultChannelPipeline.java:1019)

at io.netty.channel.AbstractChannel.bind(AbstractChannel.java:254)

at io.netty.bootstrap.AbstractBootstrap$2.run(AbstractBootstrap.java:366)

at io.netty.util.concurrent.AbstractEventExecutor.safeExecute(AbstractEventExecutor.java:163)

at io.netty.util.concurrent.SingleThreadEventExecutor.runAllTasks(SingleThreadEventExecutor.java:404)

at io.netty.channel.nio.NioEventLoop.run(NioEventLoop.java:462)

at io.netty.util.concurrent.SingleThreadEventExecutor$5.run(SingleThreadEventExecutor.java:897)

at io.netty.util.concurrent.FastThreadLocalRunnable.run(FastThreadLocalRunnable.java:30)

at java.lang.Thread.run(Thread.java:748)

即启动的时候发现端口被占用,通过查资料才知道Seata的端口默认为8091,然后查看电脑上的8091端口使用情况,发现8091端口果然已经被占用了…

这里有两种方法解决:

- 杀死占用端口的进程

- 修改默认端口号8091

修改的话直接找到上面修改过的file.conf:修改service中的default.grouplist

service {

#vgroup->rgroup

vgroup_mapping.my_test_tx_group = "fsp_tx_group"

#only support single node

default.grouplist = "127.0.0.1:8092"

#degrade current not support

enableDegrade = false

#disable

disable = false

#unit ms,s,m,h,d represents milliseconds, seconds, minutes, hours, days, default permanent

max.commit.retry.timeout = "-1"

max.rollback.retry.timeout = "-1"

}

然后启动时使用命令:seata-server.bat -p 8092 即可解决。

启动成功后访问:http://localhost:8848/nacos在服务列表中发现:

![]()

即代表启动注册成功。

四、测试用例

下面参照官网:http://seata.io/zh-cn/docs/user/quickstart.html,编写功能测试案例。

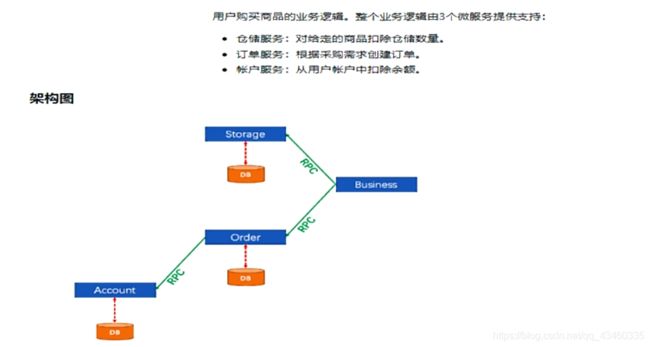

用户购买商品的业务逻辑。整个业务逻辑由3个微服务提供支持:

- 仓储服务:对给定的商品扣除仓储数量。

- 订单服务:根据采购需求创建订单。

- 帐户服务:从用户帐户中扣除余额。

这里我们会创建三个服务, 一个订单服务, 一个库存服务,一个账户服务。

当用户下单时,会在订单服务中创建一个订单, 然后通过远程调用库存服务来扣减下单商品的库存,再通过远程调用账户服务来扣减用户账户里面的余额,最后在订单服务中修改订单状态为已完成。

该操作跨越三个数据库,有两次远程调用(下订单–>扣库存–>减账户(余额)),很明显会有分布式事务问题。

项目架构图见 1.1

五、订单/库存/账户业务数据库准备

5.1 以下演示都需要先启动Nacos后启动Seata,保证两个都OK

5.2 分布式事务业务说明

下订单–>扣库存–>减账户(余额)

5.3 创建业务数据库

- seata_order: 存储订单的数据库

- seata_storage:存储库存的数据库

- seata_account: 存储账户信息的数据库

建库sql:

CREATE DATABASE seata_order;

CREATE DATABASE seata_storage;

CREATE DATABASE seata_account;

5.4 按照上述3库分别建对应业务表

- seata_order库下建t_order表

CREATE TABLE t_order(

`id` BIGINT(11) NOT NULL AUTO_INCREMENT PRIMARY KEY,

`user_id` BIGINT(11) DEFAULT NULL COMMENT '用户id',

`product_id` BIGINT(11) DEFAULT NULL COMMENT '产品id',

`count` INT(11) DEFAULT NULL COMMENT '数量',

`money` DECIMAL(11,0) DEFAULT NULL COMMENT '金额',

`status` INT(1) DEFAULT NULL COMMENT '订单状态:0:创建中; 1:已完结'

) ENGINE=INNODB AUTO_INCREMENT=7 DEFAULT CHARSET=utf8;

SELECT * FROM t_order;

- seata_storage库下建t_storage表

CREATE TABLE t_storage(

`id` BIGINT(11) NOT NULL AUTO_INCREMENT PRIMARY KEY,

`product_id` BIGINT(11) DEFAULT NULL COMMENT '产品id',

`total` INT(11) DEFAULT NULL COMMENT '总库存',

`used` INT(11) DEFAULT NULL COMMENT '已用库存',

`residue` INT(11) DEFAULT NULL COMMENT '剩余库存'

) ENGINE=INNODB AUTO_INCREMENT=2 DEFAULT CHARSET=utf8;

INSERT INTO seata_storage.t_storage(`id`,`product_id`,`total`,`used`,`residue`)

VALUES('1','1','100','0','100');

SELECT * FROM t_storage;

- seata_account库下建t_account表

CREATE TABLE t_account(

`id` BIGINT(11) NOT NULL AUTO_INCREMENT PRIMARY KEY COMMENT 'id',

`user_id` BIGINT(11) DEFAULT NULL COMMENT '用户id',

`total` DECIMAL(10,0) DEFAULT NULL COMMENT '总额度',

`used` DECIMAL(10,0) DEFAULT NULL COMMENT '已用余额',

`residue` DECIMAL(10,0) DEFAULT '0' COMMENT '剩余可用额度'

) ENGINE=INNODB AUTO_INCREMENT=2 DEFAULT CHARSET=utf8;

INSERT INTO seata_account.t_account(`id`,`user_id`,`total`,`used`,`residue`) VALUES('1','1','1000','0','1000')

SELECT * FROM t_account;

5.5 按照上述3库分别建对应的回滚日志表

订单-库存-账户3个库下都需要建各自的回滚日志表,执行\seata-server-0.9.0\seata\conf目录下的db_undo_log.sql 文件中的sql语句即可。

drop table `undo_log`;

CREATE TABLE `undo_log` (

`id` bigint(20) NOT NULL AUTO_INCREMENT,

`branch_id` bigint(20) NOT NULL,

`xid` varchar(100) NOT NULL,

`context` varchar(128) NOT NULL,

`rollback_info` longblob NOT NULL,

`log_status` int(11) NOT NULL,

`log_created` datetime NOT NULL,

`log_modified` datetime NOT NULL,

`ext` varchar(100) DEFAULT NULL,

PRIMARY KEY (`id`),

UNIQUE KEY `ux_undo_log` (`xid`,`branch_id`)

) ENGINE=InnoDB AUTO_INCREMENT=1 DEFAULT CHARSET=utf8;

5.6 最终数据库效果

六、订单/库存/账户业务微服务准备

业务需求:下订单->减库存->扣余额->改(订单)状态

- 新建订单Order-Module

- 新建库存Storage-Module

- 新建账户Account-Module

详细代码请查看:https://github.com/firecode7/cloud2020

七、测试

下订单->减库存->扣余额->改(订单)状态

7.1 数据库初始情况

7.2 正常下单

http://localhost:2001/order/create?userId=1&productId=1&count=10&money=100

7.3 手动添加超时异常测试,没加@GlobalTransactional

AccountServiceImpl添加超时:

/**

* 账户业务实现类

*/

@Service

public class AccountServiceImpl implements AccountService {

private static final Logger LOGGER = LoggerFactory.getLogger(AccountServiceImpl.class);

@Resource

AccountDao accountDao;

/**

* 扣减账户余额

*/

@Override

public void decrease(Long userId, BigDecimal money) {

LOGGER.info("------->account-service中扣减账户余额开始");

try { TimeUnit.SECONDS.sleep(20); } catch (InterruptedException e) { e.printStackTrace(); }

accountDao.decrease(userId,money);

LOGGER.info("------->account-service中扣减账户余额结束");

}

}

数据库情况:

- 当库存和账户余额扣减后,订单状态并没有设置为已经完成,没有从零改为1

- 而且由于feign的重试机制,账户余额还有可能被多次扣减

7.4 超时异常,添加@GlobalTransactional

AccountServiceImpl添加超时:如上所示

OrderServiceImpl使用@GlobalTransactional:

@Service

@Slf4j

public class OrderServiceImpl implements OrderService {

@Resource

private OrderDao orderDao;

@Resource

private StorageService storageService;

@Resource

private AccountService accountService;

/**

* 创建订单->调用库存服务扣减库存->调用账户服务扣减账户余额->修改订单状态

*/

@Override

@GlobalTransactional(name = "fsp-create-order",rollbackFor = Exception.class)

public void create(Order order){

log.info("----->开始新建订单");

//新建订单

orderDao.create(order);

//扣减库存

log.info("----->订单微服务开始调用库存,做扣减Count");

storageService.decrease(order.getProductId(),order.getCount());

log.info("----->订单微服务开始调用库存,做扣减end");

//扣减账户

log.info("----->订单微服务开始调用账户,做扣减Money");

accountService.decrease(order.getUserId(),order.getMoney());

log.info("----->订单微服务开始调用账户,做扣减end");

//修改订单状态,从零到1代表已经完成

log.info("----->修改订单状态开始");

orderDao.update(order.getUserId(),0);

log.info("----->修改订单状态结束");

log.info("----->下订单结束了");

}

}

下单后虽然仍然报超时错误但是数据库数据并没有任何改变:记录都添加不进来

八、Seata之原理简介

8.1 Seata

- Simple Extensible Autonomous Transaction Architecture,简单可扩展自治事务框架

2019年1月份蚂蚁金服和阿里巴巴共同开源的分布式事务解决方案。2020起初,参加工作后用1.0以后的版本

8.2 分布式事务的执行流程

1、TM开启分布式事务(TM向TC注册全局事务记录)

2、换业务场景,编排数据库,服务等事务内资源(RM向TC汇报资源准备状态)

3、TM结束分布式事务,事务一阶段结束(TM通知TC提交/回滚分布式事务)

4、TC汇总事务信息,决定分布式事务是提交还是回滚

5、TC通知所有RM提交/回滚资源,事务二阶段结束。

8.3 Seata默认工作与AT模式

8.4 AT模式工作步骤

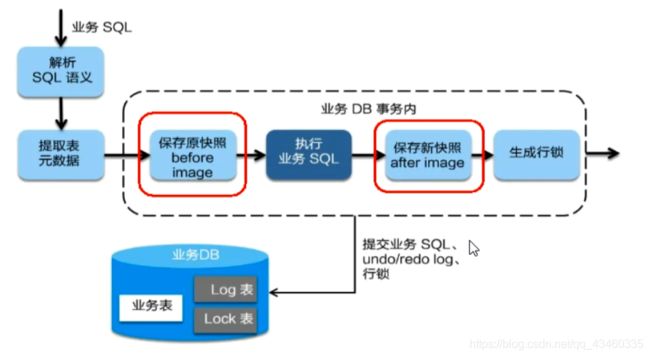

8.4.1 一阶段加载

在一阶段, Seata拦截“业务SQL" :

1、解析SQL语义,找到“业务SQL"要更新的业务数据,在业务数据被更新前,将其保存成"before image” ,

2、执行“业务SQL”更新业务数据,在业务数据更新之后,

3、其保存成"after image” ,最后生成行锁。

以上操作全部在一个数据库事务内完成, 这样保证了一阶段操作的原子性。

官网执行步骤:

1、解析 SQL:得到 SQL 的类型、表、条件等相关的信息。

2、生成查询前镜像:根据解析得到的条件信息,生成查询语句,定位数据。

3、执行业务 SQL

4、生成查询后镜像:根据SQL执行后的结果,通过 主键 定位数据。

5、插入回滚日志:把前后镜像数据以及业务 SQL 相关的信息组成一条回滚日志记录,插入到 UNDO_LOG 表中。

6、提交前,向 TC 注册分支:申请 表中的 全局锁 。

7、本地事务提交:业务数据的更新和前面步骤中生成的 UNDO LOG 一并提交。

8、将本地事务提交的结果上报给 TC。

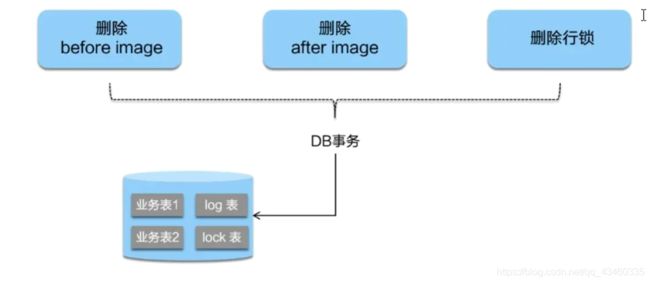

8.4.2 二阶段提交

官网步骤:

1、收到 TC 的分支提交请求,把请求放入一个异步任务的队列中,马上返回提交成功的结果给 TC。

2、异步任务阶段的分支提交请求将异步和批量地删除相应 UNDO LOG 记录。

二阶段如是顺利提交的话,

因为“业务SQL”在-阶段已经提交至数据库,所以Seata框架只需将一阶段保存的快照数据和行 锁删掉,完成数据清理即可。

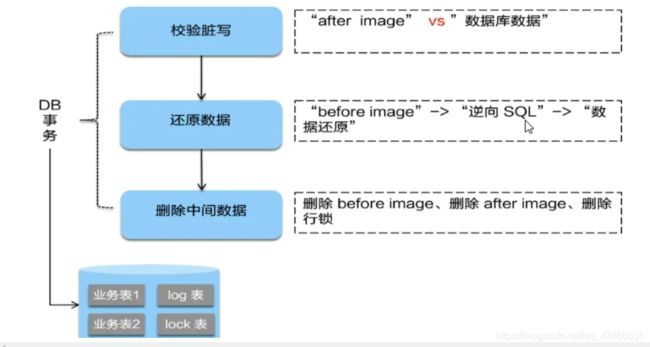

8.4.3 二阶段回滚

二阶段回滚:

二阶段如果是回滚的话,Seata 就需要回滚一阶段已经执行的“业务SQL”,还原业务数据。回滚方式便是用"before image"还原业务数据;但在还原前要首先要校验脏写, 对比”数据库当前业务数据”和"after image”,如果两份数据完全一致就说明没有脏写, 可以还原业务数据,如果不一致就说明有脏写, 出现脏写就需要转人工处理。

官网步骤:

1、收到 TC 的分支回滚请求,开启一个本地事务,执行如下操作。

2、通过 XID 和 Branch ID 查找到相应的 UNDO LOG 记录。

3、数据校验:拿 UNDO LOG 中的后镜与当前数据进行比较,如果有不同,说明数据被当前全局事务之外的动作做了修改。这种情况,需要根据配置策略来做处理,详细的说明在另外的文档中介绍。

4、根据 UNDO LOG 中的前镜像和业务 SQL 的相关信息生成并执行回滚的语句。

5、提交本地事务。并把本地事务的执行结果(即分支事务回滚的结果)上报给 TC。

总体执行流程图:

全局锁和本地锁:https://blog.csdn.net/weixin_39800144/article/details/102730415