搭建hadoop集群(两台),详细教程

所需工具:

centos7,SecureCRT ,hadoop

centos7安装教程

https://blog.csdn.net/qq_44714603/article/details/88829423

SecureCRT安装教程

https://blog.csdn.net/luoyir1997/article/details/80236570

SecureCRT ,hadoop网盘地址

链接:https://pan.baidu.com/s/1KrLSyWWnx3VNVB8qpk7jHA

提取码:hd73

安装好虚拟机后先安装jdk,这个是必须要用的,之后在克隆就不用配两次环境变量。

一:1.克隆

右击虚拟机–>管理–克隆

点击下一步,注意

便可克隆

2.根据securecrt安装教程可到

3.为两虚拟机创建用户hadoop1,hadoop2(也可直接用root)

useradd hadoop1

4.修改密码

设置hadoop1拥有root权限

5.修改两虚拟机名

vim /etc/sysconfig/network

打开之后

linux文件保存退出命令是 : “:wq”

下一步 将主机名加入hosts文件

切换用户: su hadoop1

sudo vim /etc/hosts

如果出现no valid sudoers sources found, quitting 请查看

https://blog.csdn.net/zb199738/article/details/106683540

6.如果使用的是网桥连接模式vmnet0,则这步不用操作

修改ifconfig-eth0

vim /etc/udev/rules.d/70-persistent-ipoib.rules

复制

粘贴到 vim /etc/sysconfig/network-scripts/ipcfg-eth0

注意操作完成要重启两虚拟机命令 :reboot

到此,虚拟机的准备工作完成!

二:

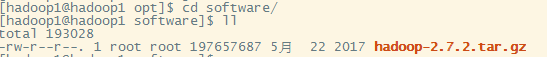

1.在hadoop1的/opt下创建两个文件夹:

放解压后文件:mkdir module

放压缩包:mkdir software

2.传压缩包:alt+p

直接拖拽hadoop压缩包

注意:安装hadoop首先要有jdk,安装jdk同样也是拖拽到这文件夹下,如本文开头已经装好配好,则不用配,其他也行,我就在其他文件夹下,配置环境变量,

解压到module

完成

配置hadoop,需要在jdk里配置

进入/etc/profile

配置

这时候你键入 hadoop命令还是不能使用的,必须再加一步

![]()

之后测试

OK!

3.将hadoop1的module文件夹及其中所有文件复制到hadoop2的module:

![]()

修改文件夹的拥有者和所有组:

sudo chown hadoop2:hadoop2 module/ -R

![]()

注意:还得在etc/profile中配置hadoop

至此,搭建集群的所有准备工作已完成!

三:接下来就正式开始搭建了

最好是NameNode,SecodaryNameNode,ResourceManager分别放在三个虚拟机中,但我电脑配置太低,我将NameNode和SecodaryNameNode搭建在hadoop1中,将ResourceManager搭建在hadoop2中,

1.修改配置文件

cd module/hadoop-2.7.2/etc/hadoop/

vim core-site.xml

增加配置

fs.defaultFS

hdfs://hadoop1:9000

hadoop.tmp.dir

/opt/module/hadoop-2.7.2/data/tmp

修改hadoop-env.sh

修改hdfs-site.xml

dfs.replication

2

dfs.namenode.secondary.http-address

hadoop1:50090

yarn配置文件

yarn-env.sh

yarn-site.xml

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.resourcemanager.hostname

hadoop2

yarn.log-aggregation-enable

true

yarn.log-aggregation.retain-seconds

604800

mapreduce配置文件

mapred-env.sh

mapred-site.xml

首先需要 cp

虚拟机hadoop2和hadoop1具有相同的配置

至此,集群搭建完成

让我们来测试一下吧!

启动namenode命令:sbin/hadoop-daemon.sh start namenode

查看java进程命令:jps

不知道为啥我输入hadoop1:50070无法访问,可能要重启网络我没重启。。。我直接输入ip地址了,检测没什么问题。

OK!

我也是初学,如果有什么问题或者错误,为了不误人子弟,希望各位前辈不吝赐教,我会及时改正,不胜感激!!