创新视觉体验的7个维度——理解超高清/VR/6DoF的框架

背景——为什么要写这篇文章

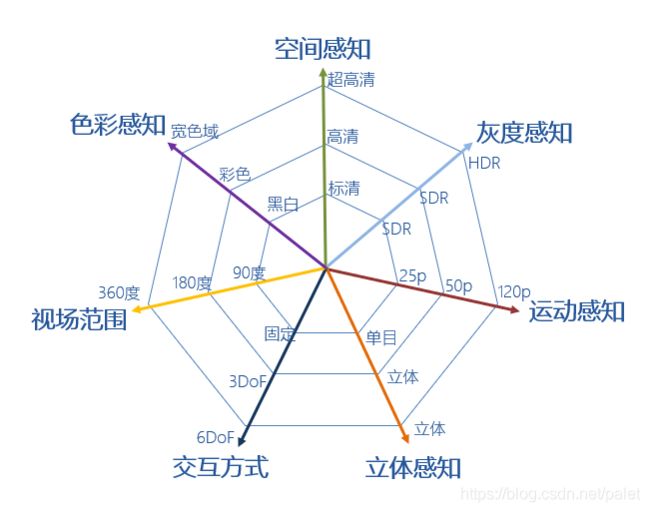

在研究超高清、VR、6DoF等最新的视觉体验的时候,往往感觉各种概念层出不穷,令人目不暇接。同时这些概念又都互相关联,盘根错节,理解起来颇费一些脑筋。经过一段时间的研究和思考,我从人眼视觉体验的角度去梳理,建立了一个具有7个维度的框架,便于我们去理解视觉体验从过去到未来发展的整个脉络。

已有的工作

其实在计算机视觉、图像、视频领域,已经有一些相关的成果和观点(见文末参考文献的文章或论坛讲座[1][2][3])。文章[1]介绍了与活动图像质量相关的5个因素(2D画面):分辨率(空间分辨率)、色域(彩色分辨率)、量化(灰度分辨率)、动态范围(宽容度分辨率)、帧速率(时间分辨率)。文章[2]指出了沉浸式视觉媒体的多个维度:宽色域范围、高动态范围、高时间分辨率、高空间分辨率、宽视场范围、多视点高自由度、表达模型。文章[3]则提出了六维度超视觉技术体系:分辨率、动态范围、色域、采样、帧率、视点。

以上这些模型从各自的技术体系对创新视觉的维度进行了概括,做了很多基础工作。但是有的模型只介绍了平面视频,缺乏沉浸式视频的内容。有的模型选取维度的标准没有充分说明,显得不太平衡。基于以上原因,本文试图从一个统一角度、即人眼视觉体验的角度去给出一个相对比较综合的框架。

创新视觉的7个维度

首先声明,在考虑人的体验时,我们这里只关注人眼的视觉,也就是我们能看到的内容,以及如何去看。至于影响体验的其它维度,如听觉、嗅觉、触觉等等,不在本文讨论范围之内。比如说,一些体验性游戏可以让您感受到游戏中火把的温度,这个体验不是视觉体验,这里不考虑作为一个维度。另外,我们下面谈的每一个维度,都与人的某一类生理视觉特性相关,如感知色彩、感知立体形象等等,而且这些维度之间是相互独立的,因而能够单独成其为一个维度。

言归正传,直接上图如下:

维度1:空间感知

就是我们常说的分辨率、解析度。其起因是我们采用了数字技术以后,图像是离散数据,以像素点来表示。在一定可视范围内,单位面积的像素点越多,显示效果越细腻。反之,如果单位面积的像素点不够,分辨率太低,我们的眼睛感受到的图像就会有明细的颗粒感。所以,从人眼视觉的角度来来理解,由分辨率来表征的空间感知,本质上就是对这种颗粒度的感知。

电视视频经过几十年的发展,走过了从标清到高清的历程,目前正在向超高清(4K/8K)迈进。其中,对中国而言,标清分辨率为720x576;高清分辨率为1920x1080;超高清(4K)分辨率为3840x2160;超高清(8K)尚在发展中,为:7680x4320。

其实我们的眼睛对这种颗粒度的感知,不仅跟图像本身的分辨率有关系,还跟观看距离、视场范围等因素也有关系。分辨率很小的图像,从远处看,也不会有颗粒感。人眼在一定视角内能够感知到的像素多少是有生理极限的。所以,在家庭常见的观看距离内,如果观看普通的40到50吋的电视,单纯提升分辨率,视觉效果不一定有很大提升。

下图是对高清->4K超高清->8K超高清画幅大小的直观对比:

维度2:灰度感知

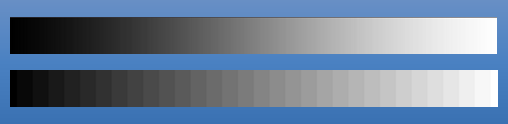

刚才讲的空间感知,其实是在说整个图像包括的像素的多少。具体到每一个像素中包含的视觉信息,主要是两方面:亮度信息和色彩信息。色彩后面再讲,先说亮度。灰度感知其实就是一种对亮度的感知。人眼可以是具备分清不同亮度的能力的。但是,还是由于数字化的原因,我们在表达亮度时候,只能用一定的比特数(也就是位数、量化位数)来表示。通常如果是8bit的话,只能表示256个灰度级别。本来正常人眼能够感知比较连续的灰度,如果位数不够,就会出现如下图所示的现象(上面是正常的连续灰度,下面是数字化导致的灰度层次):

所以,为了表示更多的灰度层次,在超高清视频中,对灰度的表示就从8bit到了10bit,以后据说还要到12bit,20bit。其实有了10bit以后,灰度层次增加到1024级,应该已经很好了。人眼对灰度的感知层次,毕竟也是有极限的。

其实,为了更好地描述人眼觉感知的灰度级别,量化位数是个重要因素,但却不是唯一因素。人的心理感知的灰度,跟自然界物理的亮度值,不是线性关系。同时还涉及到显示设备的亮度还原能力等等一系列因素。把这些因素都考虑进来,就是所谓的高动态范围(HDR, High-Dynamic Range)技术。

这些技术综合运用的效果,使得我们看到的图像黑的很黑,白的更白,不同亮度的层次丰富,细节清楚。

讲完前面这两个维度,我们形象地说,就是能看到一幅黑白画作或者照片了。

维度3:色彩感知

讲完亮度,我们再说色彩。自然界是五彩斑斓的,我们的人眼能够感知到这些颜色的不同。为了表征不同的颜色,人们建立很多模型,称为色彩空间(或称彩色模型、彩色空间、颜色模型等等),这里不详细介绍,有兴趣可以自行找相关文章学习。

下图是人眼能够感知的可见光范围内的所有颜色。其中红色和绿色三角形范围内的颜色,是目前标清和高清视频中已经被表示的颜色。而蓝色三角形范围内的颜色,是超高清视频能够表示的颜色。可以看到,超高清视频能够给大家展示的颜色,比以前要多了,因此,超高清视频的颜色会更为鲜艳亮丽,更为丰富多彩。

当然,从高清到超高清,色彩空间的扩大的代价,是更多的比特数对颜色进行表示。

讲到这里,顺便提一下4:4:4/4:2:2/4:2:0采样的事情。我的理解,它们其实是亮度和色彩数据分配策略。能否把它们单独列为一个维度呢?技术层面当然没问题。但我们这里选取维度的标准,是必须有一定视觉的意义。如果4:4:4/4:2:2/4:2:0从视觉感知上不能很明显地说出它们的区别和意义,暂时就不宜列为一个单独维度。这一点还待进一步研究。

讲完前面这三个维度,形象地说,就是能看到一幅彩色画作或者照片。

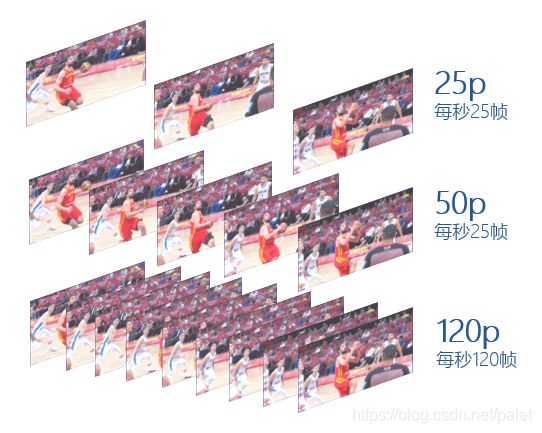

维度4:运动感知

显然我们不会仅仅满足于看静止画面,事实上我们的人眼能够感知活动画面。人眼的“视觉暂留”的特性使得我们能够看到活动的东西。以每秒中24帧的速度播放静止画面,我们就会把它们连起来形成活动画面。因此,技术层面来表征运动画面的指标就是帧率,不同帧率的效果如下图所示:

高帧率的影视内容观看感觉更为流畅。尤其对于剧烈变化的画面,提升效果更明显,同时便于做慢动作回放等特效处理。

讲到这里,我们可以看到的就是一段彩色的活动视频了。

维度5:立体感知

更进一步,人是有两只眼睛的。由于两只眼睛看到的内容略有不同,形成了视差,使得我们看到的内容有立体感,这就是立体感知。

从技术层面来表达,就是在采集、传输、观看的时候,要同时考虑左右两只眼睛的视频数据,把它们忠实地记录和还原出来。看来数据量需要加倍了(实际考虑左右眼数据的冗余,会少一些),同时还需要考虑左右眼同步的问题,难度是增加了。

讲到这里,我们能够看到的,就是具备立体感的彩色视频了。

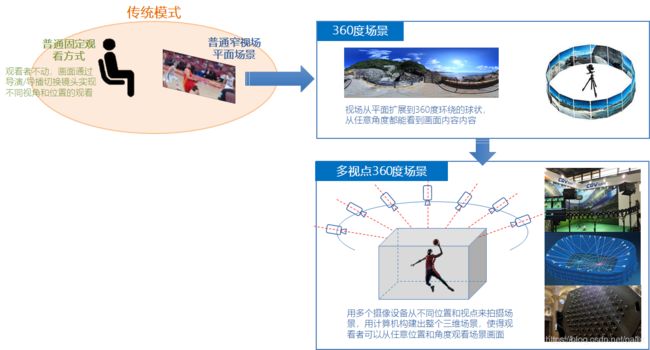

维度6:视场范围

前面讲的所有内容都有一个小前提,就是观看的范围是一个窗口。当我们提1920x1080这样的分辨率时,其实隐含了这样一个假设。但是,事实上,人在观察场景时,并不局限于这样一个窗口,我们是上下左右所有的角度都可以看的,换言之,场景可以扩展为360度场景。更进一步,如果建立了场景的三维模型,那就可以从任何一个位置和任何一个角度看场景,即多视点360度场景。如下图所示:

这里把这个维度称为“视场范围”,稍微有点差强人意。本质上是我们能够通过眼睛看到的场景的范围。正如上文所说,如果做到极致,我们是能够从任意角度,任意位置去观察场景的。

当然,要达到这个理想,需要巨量的视频采集设备,需要巨量的视频处理能力,需要类似于点云这样的数据表达模型,是非常不容易的。但这也是未来研究的方向。

维度7:交互方式

前面六个维度其实一直是在说场景的表示:平面的、彩色的、立体的、360三维的、活动的场景。接下来要说的,就是我们如何去看这些场景,也就是人与场景的交互方式。这是一个非常复杂的话题,因为它是跟场景的表示具体相关的。

如果要看的场景是平面视频的,类似于我们去看电影、电视,交互方式其实是最简单的,眼睛盯着屏幕看就可以了。虽然如此,我们看到的内容却是丰富多彩的,导演/导播会给我们切不同的镜头,给远景、中景、近景、特写。换言之,我们看到的场景是在不断变化的,只不过这个变化不是我们主动做的,而是由专业的导演导播帮我们做的。我们很舒适、很懒惰地享受了这些服务,付出的代价是不能自主选择要看的内容。

为了给大家提供这种主动选择的机会,一些服务商推出了多视角视频。一场比赛、一个演唱会,除了导播给您切的那一路主画面,还会同时把其他摄像机的视频都列出来,想看哪个看哪个。如果是电视,可以用遥控器选择。如果是手机,可以直接用触摸屏选择。

以上说的还是平面视频,如果我们的视频扩展为360度全景、那可以交互的方式就更多了。比如,在手机上直接用多点触控方式或者利用手机的陀螺仪进行移动、放缩等交互操作,自己选择要看的内容。如果有VR头盔这一类的装备,就可以享受更加自由的观看体验,即3DoF的体验。如果再加上其它能够感知位置变化的设备,还可以移动在场景中的位置,体验6DoF的精彩。如下图所示:

小结

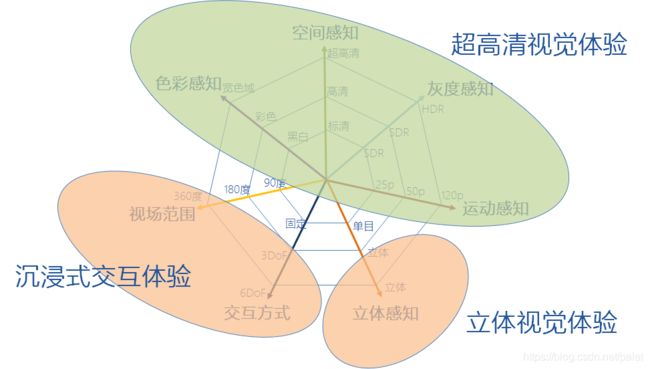

总结以上7个维度,我觉得可以分为三类,其实就是学术界和工业界孜孜以求的未来的创新视觉的三个方向:

- 超高清视觉体验;

- 沉浸式交互体验;

- 立体视觉体验;

如下图所示:

最后留个小尾巴:全息影像技术应该放到什么位置?如何去理解?还有待进一步研究、思考和和总结。

参考文献

[1] 4K超高清HDR技术简介

[2] 虞露,浙江大学,“MPEG中面向沉浸式视觉体验的标准化活动”https://blog.csdn.net/vn9PLgZvnPs1522s82g/article/details/99669793

[3] 马思伟,北京大学,“视频编码技术标准、应用及未来展望”阿里云栖大会(杭州)2019