大数据Hadoop3.1.3——HDFS文件系统的客户端操作(基础)

1、 HDFS客户端环境准备

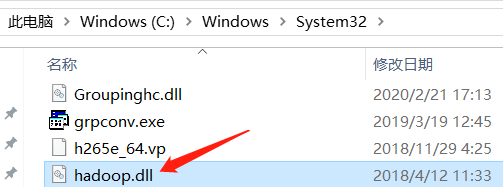

1、将Windows依赖hadoop-3.1.0放到指定位置,设置环境变量

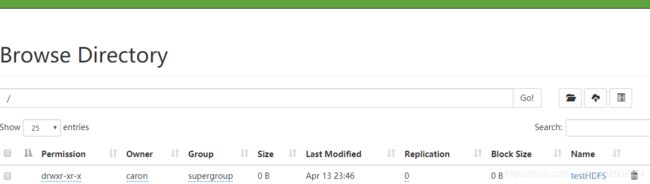

将bin目录下的hadoop.dll放到下列目录下:

2.配置HADOOP_HOME环境变量

3. 配置Path环境变量,然后重启电脑

![]()

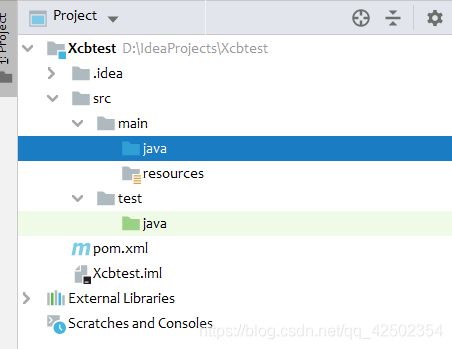

4.创建一个Maven工程

5.导入相应的依赖坐标+日志添加

junit

junit

4.12

org.apache.logging.log4j

log4j-slf4j-impl

2.12.0

org.apache.hadoop

hadoop-client

3.1.3

在项目的src/main /resources目录下,新建一个文件,命名为“log4j2.xml”,在文件中填入

6.创建包名:com.caron.hdfs

7.创建HdfsClient类

public class HdfsClient{

@Test

public void testHdfsClient() throws IOException, InterruptedException {

//1. 创建HDFS客户端对象,传入uri,configuration , user

FileSystem fileSystem = FileSystem.get(URI.create("hdfs://hadoop101:9820"), new Configuration(), "caron");

//2. 操作集群

// 例如:在集群的/目录下创建 testHDFS目录

fileSystem.mkdirs(new Path("/testHDFS"));

//3. 关闭资源

fileSystem.close();

}

}2、HDFS的API操作

1、 HDFS文件上传(测试参数优先级)

1.编写源代码

@Test

public void testCopyFromLocalFile() throws IOException, InterruptedException, URISyntaxException {

// 1 获取文件系统

Configuration configuration = new Configuration();

// 设置副本数为2个

configuration.set("dfs.replication", "2");

FileSystem fs = FileSystem.get(new URI("hdfs://hadoop101:9820"), configuration, "caron");

// 2 上传文件

fs.copyFromLocalFile(new Path("e:/banzhang.txt"),

new Path("/banzhang.txt"));

// 3 关闭资源

fs.close();

} 2.在项目的resources中新建hdfs-site.xml文件,并将如下内容拷贝进去,再次测试

<?xml version="1.0" encoding="UTF-8"?>

<?xml-stylesheet type="text/xsl" href="configuration.xsl"?>

<configuration>

<property>

<name>dfs.replication</name>

<value>1</value>

</property>

</configuration> 3.参数优先级

参数优先级排序:(1)客户端代码中设置的值 >(2)ClassPath下的用户自定义配置文件 >(3)然后是服务器的自定义配置(xxx-site.xml) >(4)服务器的默认配置(xxx-default.xml)

2、 HDFS文件下载

@Test

public void testCopyToLocalFile() throws IOException, InterruptedException,URISyntaxException{

// 1 获取文件系统

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://hadoop101:9820"), configuration, "caron");

// 2 执行下载操作

// boolean delSrc 指是否将原文件删除

// Path src 指要下载的文件路径

// Path dst 指将文件下载到的路径

// boolean useRawLocalFileSystem 是否开启文件校验

fs.copyToLocalFile(false, new Path("/banzhang.txt"), new Path("e:/banhua.txt"), true);

// 3 关闭资源

fs.close();

}3、 HDFS文件夹删除

@Test

public void testDelete() throws IOException, InterruptedException, URISyntaxException{

// 1 获取文件系统

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://hadoop101:9820"), configuration, "caron");

// 2 执行删除

fs.delete(new Path("/0213/"),true);

// 3 关闭资源

fs.close();

}

4、HDFS文件名更改/移动

@Test

public void testRename() throws IOException, InterruptedException, URISyntaxException{

// 1 获取文件系统

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://hadoop101:9820"), configuration, "caron");

// 2 修改文件名称

fs.rename(new Path("/banzhang.txt"), new Path("/banhua.txt"));

// 3 关闭资源

fs.close();

}5、HDFS文件详情查看

查看文件名称、权限、长度、块信息

@Test

public void testListFiles() throws IOException, InterruptedException, URISyntaxException{

// 1获取文件系统

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://hadoop101:9820"), configuration, "caron");

// 2 获取文件详情

RemoteIterator<LocatedFileStatus> listFiles = fs.listFiles(new Path("/"), true);

while(listFiles.hasNext()){

LocatedFileStatus status = listFiles.next();

// 输出详情

// 文件名称

System.out.println(status.getPath().getName());

// 长度

System.out.println(status.getLen());

// 权限

System.out.println(status.getPermission());

// 分组

System.out.println(status.getGroup());

// 获取存储的块信息

BlockLocation[] blockLocations = status.getBlockLocations();

for (BlockLocation blockLocation : blockLocations) {

// 获取块存储的主机节点

String[] hosts = blockLocation.getHosts();

for (String host : hosts) {

System.out.println(host);

}

}

System.out.println("-----------漂亮的分割线----------");

}

// 3 关闭资源

fs.close();

}6、HDFS文件和文件夹判断

@Test

public void testListStatus() throws IOException, InterruptedException, URISyntaxException{

// 1 获取文件配置信息

Configuration configuration = new Configuration();

FileSystem fs = FileSystem.get(new URI("hdfs://hadoop101:9820"), configuration, "caron");

// 2 判断是文件还是文件夹

FileStatus[] listStatus = fs.listStatus(new Path("/"));

for (FileStatus fileStatus : listStatus) {

// 如果是文件

if (fileStatus.isFile()) {

System.out.println("f:"+fileStatus.getPath().getName());

}else {

System.out.println("d:"+fileStatus.getPath().getName());

}

}

// 3 关闭资源

fs.close();

}