HBASE单机安装教程(centOS6.5)

注意Hadoop与HBASE对应支持支持版本

1基本配置

1.1关闭防火墙

Chkconfig –list | grep iptables

确定全部为off

否则执行chkconfig iptables off

Service iptables stop

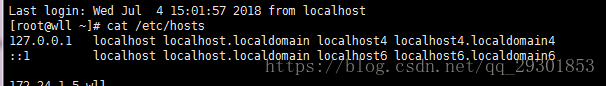

1.2添加 主机IP 和对应的主机名称,做映射。主机名可用hostname查看(注:在配置文件中使用主机名的话,这个映射必须做!)

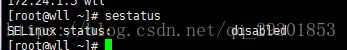

1.3查看sestatus

如果没有显示disabled则 vi /etc/selinux/config将SELINUX=disabled

1.4修改主机名

Vi /home/hadoop3.1.0/etc/hadoop/slave

修改成自己的主机名

2 jdk安装

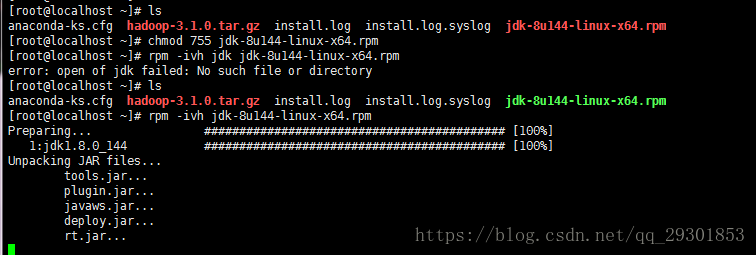

2.1将jdk-8u144-linux-x64.rpm放入根目录下

上传完后的文件如下,文件只有读写权限,没有执行权限

-》执行chmod 755 jdk-8u144-linux-x64.rpm授权

-》执行rpm -ivh jdk-8u144-linux-x64.rpm进行安装

如果在安装时出现如下错误

warning:waiting for transaction lock on /var/lib/rpm/.rpm.lock

使用如下命令来进行安装

sudo rpm -ivh jdk-8u144-linux-x64.rpm

如果仍然不可以,使用如下命令强制解锁后再次安装即可

sudo rm /var/lib/rpm/.rpm.lock

-

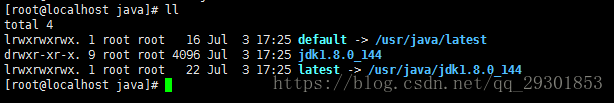

- jdk安装成功后,默认存放在/usr/java文件目录中

2.3、配置环境变量

vi /etc/profile

在文件尾部添加如下内容,保存退出

export JAVA_HOME=/usr/java/jdk1.8.0_144

export PATH=$JAVA_HOME/bin:$PATH

export CLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tool.jar

再使用source /etc/profile使环境变量生效

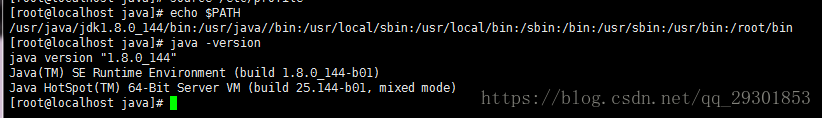

输入如下命令验证环境变量是否生效

echo $PATH

输入如下命令查看jdk版本

java –version

3 hadoop安装

3.1、解压hadoop-2.7.6.tar.gz

Tar –zvxfhadoop-2.7.6.tar.gz可将文件移至home下

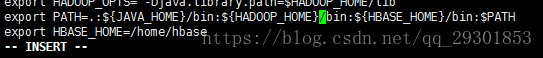

3.2、profile 文件更改

export HADOOP_HOME=/home/hadoop

export HADOOP_COMMON_LIB_NATIVE_DIR=$HADOOP_HOME/lib/native

export HADOOP_OPTS="-Djava.library.path=$HADOOP_HOME/lib"

export PATH=.:${JAVA_HOME}/bin:${HADOOP_HOME}/bin:$PATH

输入source /etc/profile

3.3、修改配置文件

3.3.1 在修改配置文件之前,先在root目录下建立一些文件夹。

mkdir /root/hadoop

mkdir /root/hadoop/tmp

mkdir /root/hadoop/var

mkdir /root/hadoop/dfs

mkdir /root/hadoop/dfs/name

mkdir /root/hadoop/dfs/data

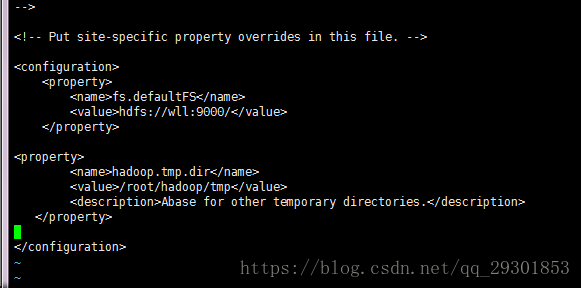

3.3.2 修改core-site.xml

在

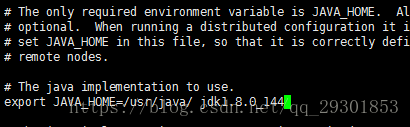

3.3.3修改 hadoop-env.sh

export JAVA_HOME=/usr/java/ jdk1.8.0_144

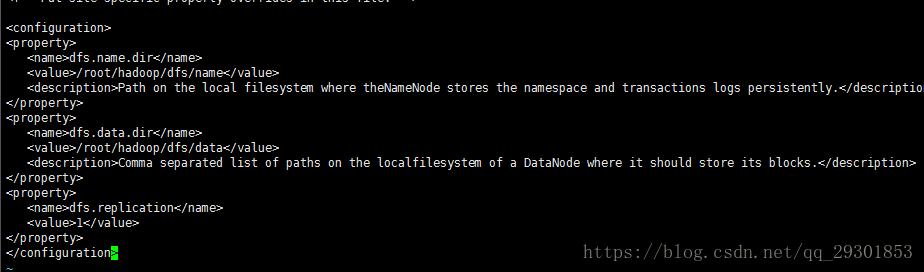

3.3.3修改 hdfs-site.xml

在

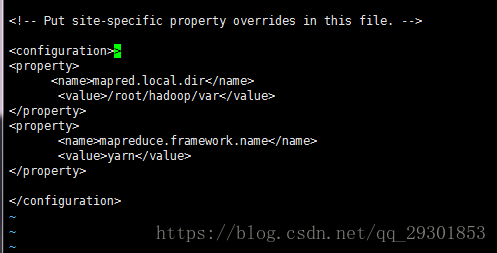

3.3.4 修改mapred-site.xml

<property>

<name>mapred.local.dirname>

<value>/root/hadoop/varvalue>

property>

<property>

<name>mapreduce.framework.namename>

<value>yarnvalue>

property>

到此 Hadoop 的单机模式的配置就完成了。

4 免密登录

先测试是否能免密登录,输入试试localhost,出现以下则不能免密登录

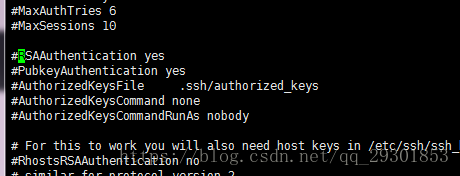

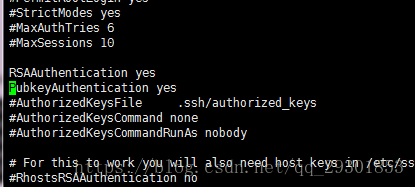

去掉 /etc/ssh/sshd_config中的两行注释,如没有则添加

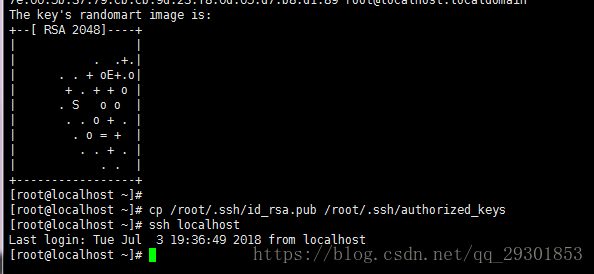

生成秘钥,输入命令 ssh-keygen -t rsa 然后一路回车

复制到公共密钥中

cp /root/.ssh/id_rsa.pub /root/.ssh/authorized_keys

测试是否成功

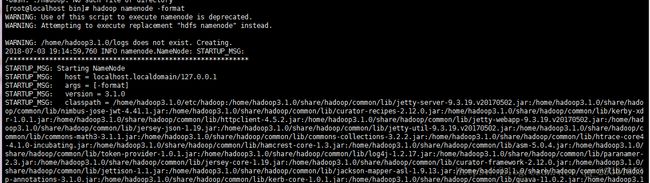

5 hadoop启动

第一次启动Hadoop需要初始化,切换到 /home/hadoop/bin目录下输入

hadoop namenode -format

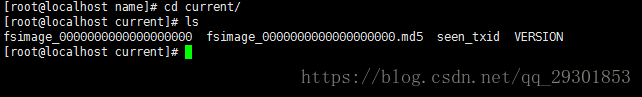

初始化成功后,可以在/root/hadoop/dfs/name 目录下看见新增了一个current 目录以及一些文件。

切换到/home/hadoop/hadoop3.1.0/sbin目录,启动HDFS

输入:

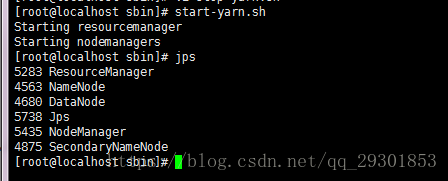

start-dfs.sh

start-yarn.sh

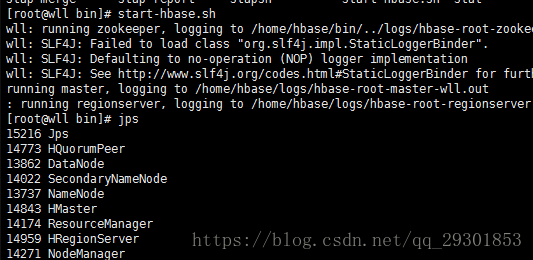

输入jps:出现以下信息,配置完成

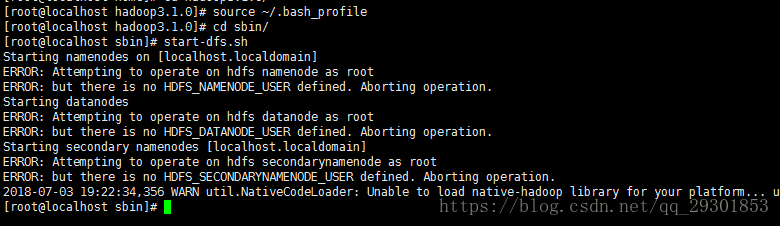

错误一:

输入: start-dfs.sh

如果出现以下错误,则输入source ~/.bash_profile

错误二:

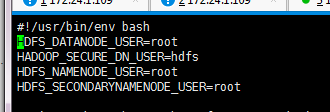

如果运行start-dfs.sh脚本报如下错误

(缺少用户定义而造成的)因此编辑启动和关闭

vi sbin/start-dfs.sh

vi sbin/stop-dfs.sh

顶部加入

HDFS_DATANODE_USER=root

HADOOP_SECURE_DN_USER=hdfs

HDFS_NAMENODE_USER=root

HDFS_SECONDARYNAMENODE_USER=root

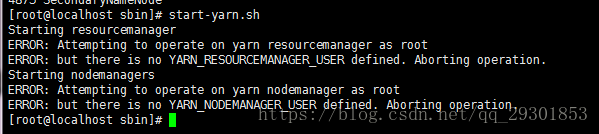

错误三:

运行start-yarn.sh报错

是因为缺少用户定义造成的,所以分别编辑开始和关闭脚本

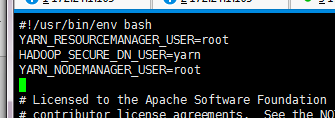

vi sbin/start-yarn.sh

vi sbin/stop-yarn.sh

顶部添加

YARN_RESOURCEMANAGER_USER=root

HADOOP_SECURE_DN_USER=yarn

YARN_NODEMANAGER_USER=root

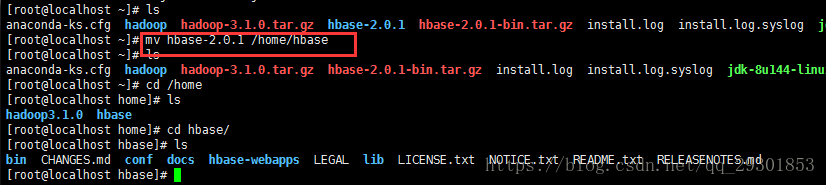

6 hbase安装

6.1、解压hbase-2.0.1-bin.tar.gz

tar –zvxf hbase-2.0.1-bin.tar.gz

然后移动到 /home/hbase

mv hbase-2.0.1 /home/hbase

6.2 、编辑 /etc/profile 文件

注意修改在前基础上修改PATH路径

export PATH=.:${JAVA_HOME}/bin:${HADOOP_HOME}/bin:${HBASE_HOME}/bin:$PATH

export HBASE_HOME=/home/hbase

输入source /etc/profile使修改生效

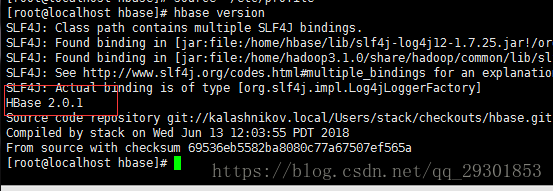

查看hbase版本hbase version

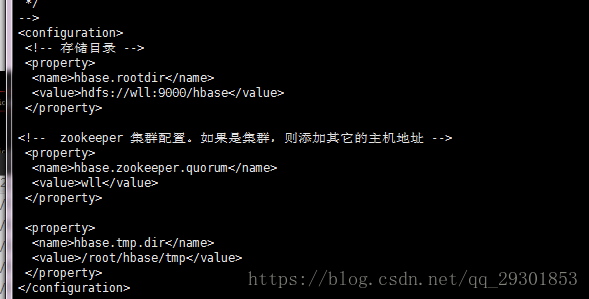

6.3、修改配置文件

在 root目录下新建文件夹

mkdir /root/hbase

mkdir /root/hbase/tmp

mkdir /root/hbase/pids

编辑hbase-site.xml 文件,在添加如下配置

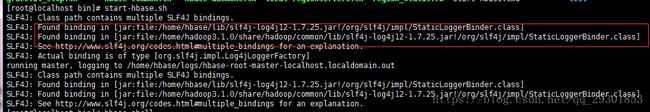

7 HBASE启动

SLF4J: Class path contains multiple SLF4J bindings.

SLF4J: Found binding in [jar:file:/home/hbase/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: Found binding in [jar:file:/home/hadoop3.1.0/share/hadoop/common/lib/slf4j-log4j12-1.7.25.jar!/org/slf4j/impl/StaticLoggerBinder.class]

SLF4J: See http://www.slf4j.org/codes.html#multiple_bindings for an explanation.

SLF4J: Actual binding is of type [org.slf4j.impl.Log4jLoggerFactory]

发现这两个jar重复,删除其中一个即可

启动后:

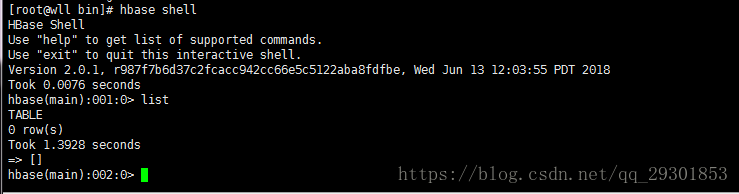

进入操作语句执行界面HBASE shell