Oracle VM上实施Oracle 12cR2 RAC

环境准备

Oracle VM:3.4.2

节点1:

-CPU&MEM: 4C8GB

-HOSTNAME: pnode01

-IP: 10.20.1.130

-VIP: 10.20.1.132

-PRIV-IP: 192.168.1.100

-OS: Oracle Linux 7.5

节点2:

-CPU&MEM: 4C8GB

-HOSTNAME: pnode02

-IP: 10.20.1.131

-VIP: 10.20.1.133

-PRIV-IP: 192.168.1.101

-OS: Oracle Linux 7.5

Oracle Database: 12.2.0.1

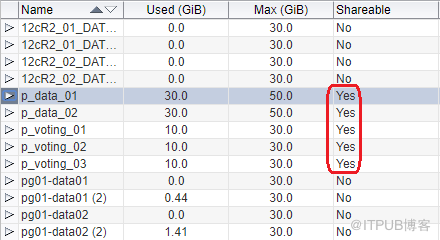

为了实现共享存储,需要创建shareable类型的磁盘:

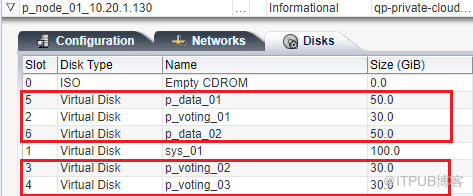

然后将共享磁盘分别挂载到2个节点上:

系统软件包

安装grid及database需要安装以下软件包:

bc

binutils-2.23.52.0.1-12.el7 (x86_64)

compat-libcap1-1.10-3.el7 (x86_64)

compat-libstdc++-33-3.2.3-71.el7 (i686)

compat-libstdc++-33-3.2.3-71.el7 (x86_64)

glibc-2.17-36.el7 (i686)

glibc-2.17-36.el7 (x86_64)

glibc-devel-2.17-36.el7 (i686)

glibc-devel-2.17-36.el7 (x86_64)

ksh

libaio-0.3.109-9.el7 (i686)

libaio-0.3.109-9.el7 (x86_64)

libaio-devel-0.3.109-9.el7 (i686)

libaio-devel-0.3.109-9.el7 (x86_64)

libX11-1.6.0-2.1.el7 (i686)

libX11-1.6.0-2.1.el7 (x86_64)

libXau-1.0.8-2.1.el7 (i686)

libXau-1.0.8-2.1.el7 (x86_64)

libXi-1.7.2-1.el7 (i686)

libXi-1.7.2-1.el7 (x86_64)

libXtst-1.2.2-1.el7 (i686)

libXtst-1.2.2-1.el7 (x86_64)

libgcc-4.8.2-3.el7 (i686)

libgcc-4.8.2-3.el7 (x86_64)

libstdc++-4.8.2-3.el7 (i686)

libstdc++-4.8.2-3.el7 (x86_64)

libstdc++-devel-4.8.2-3.el7 (i686)

libstdc++-devel-4.8.2-3.el7 (x86_64)

libxcb-1.9-5.el7 (i686)

libxcb-1.9-5.el7 (x86_64)

make-3.82-19.el7 (x86_64)

nfs-utils-1.3.0-0.21.el7.x86_64 (for Oracle ACFS)

net-tools-2.0-0.17.20131004git.el7 (x86_64) (for Oracle RAC

and Oracle Clusterware)

smartmontools-6.2-4.el7 (x86_64)

sysstat-10.1.5-1.el7 (x86_64)

从Oracle Linux 6开始,Oracle提供了一个RPM来方便的安装系统所需要的软件包,只要执行:

yum install oracle-database-server-12cR2-preinstall

系统就会自动把所需的软件包都装上,并且还会设置安装时要求的系统参数。

GRID的安装

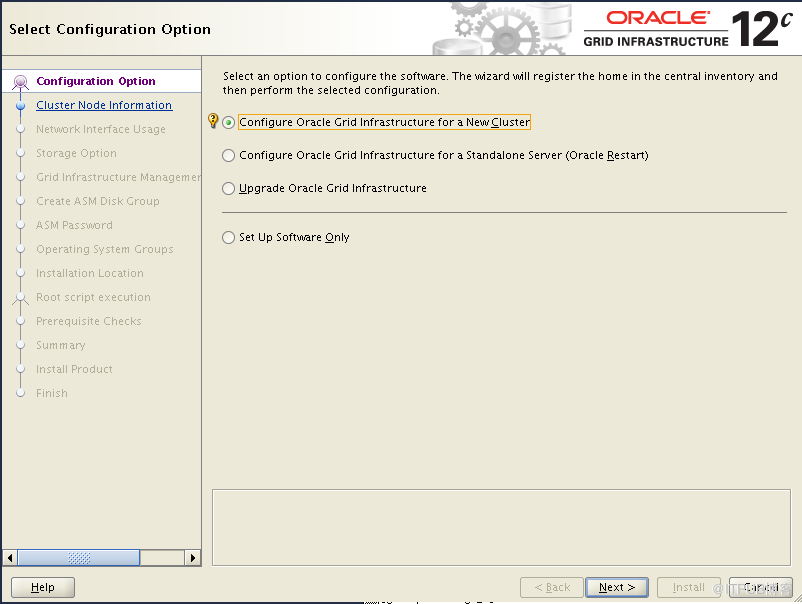

将grid的安装包复制到节点1的安装路径下,然后解压(可以参见另一篇文章《Oracle 12.2 GRID的安装方式》)运行gridSetup.sh:

选择配置新集群,下一步:

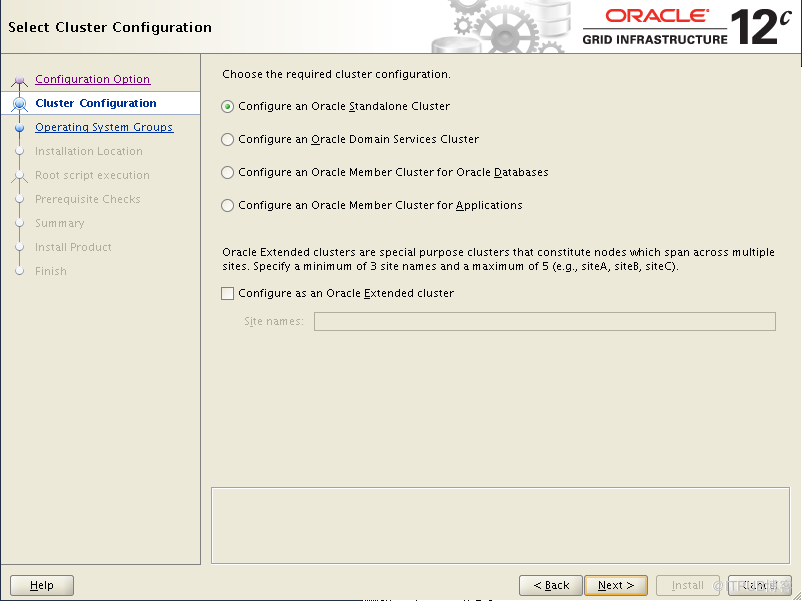

新增了Oracle Domain Service Cluster和Oracle Member Cluster,这两种类型的Cluster主要是为数据库云服务的。我们这里创建的是独立的集群,暂时用不到该类型的集群,所以选择Standalone Cluster。

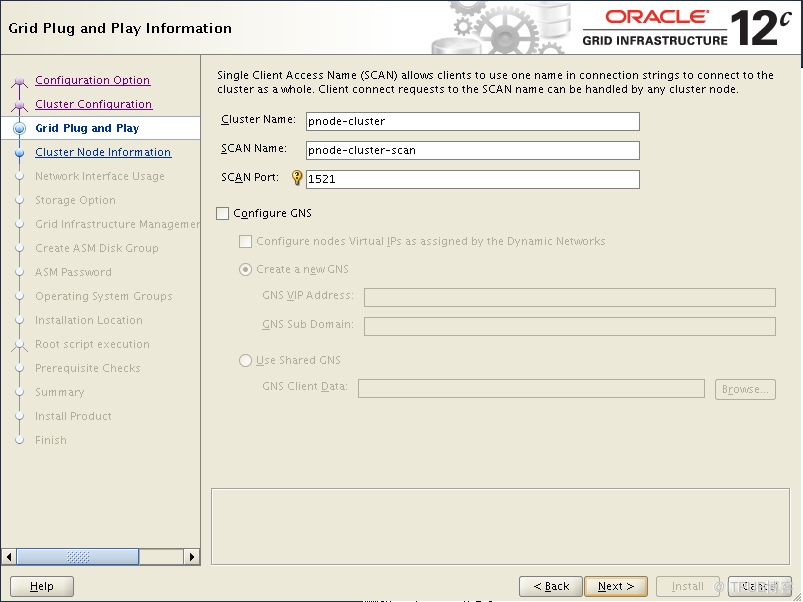

Oracle从11g开始引入了SCAN的概念,我们这里由于没有使用DNS,所以后面可能会出现关于SCAN的警告和错误,忽略即可,不影响正常的使用。

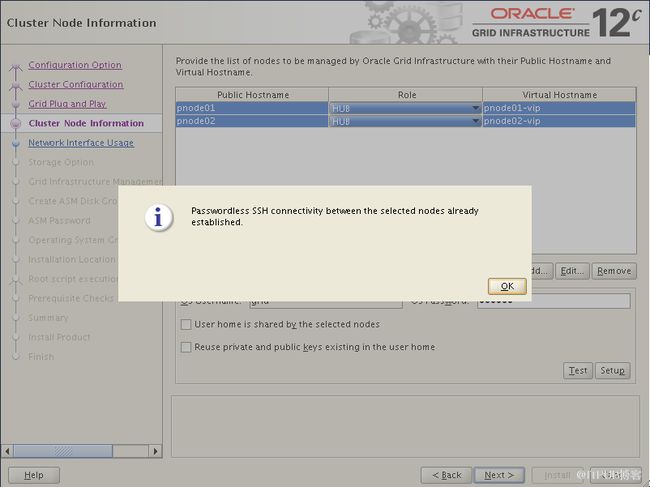

配置节点1和节点2的基本信息,注意要确保SSH的连通性,然后配置网卡:

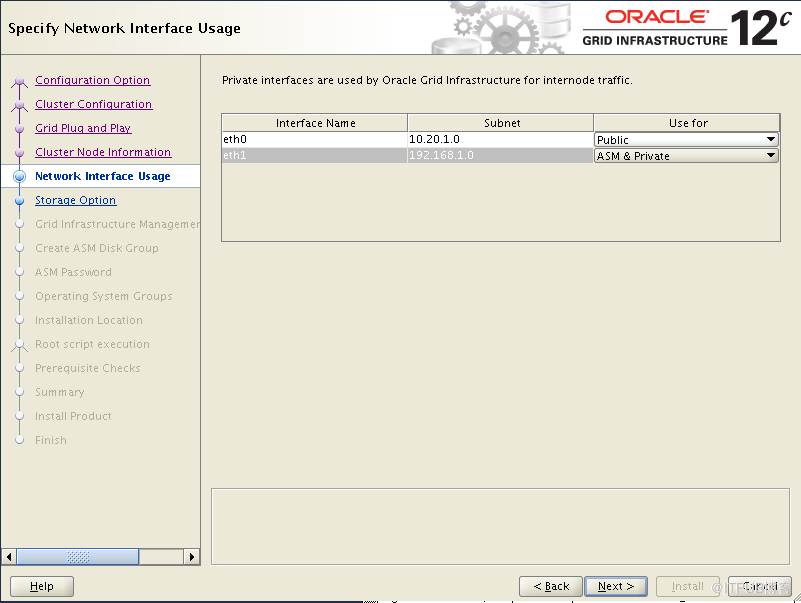

安装之前的规划,eth0网段10.20.1作为公共网络,而eth1网段192.168.1作为ASM和私有网络。然后配置ASM:

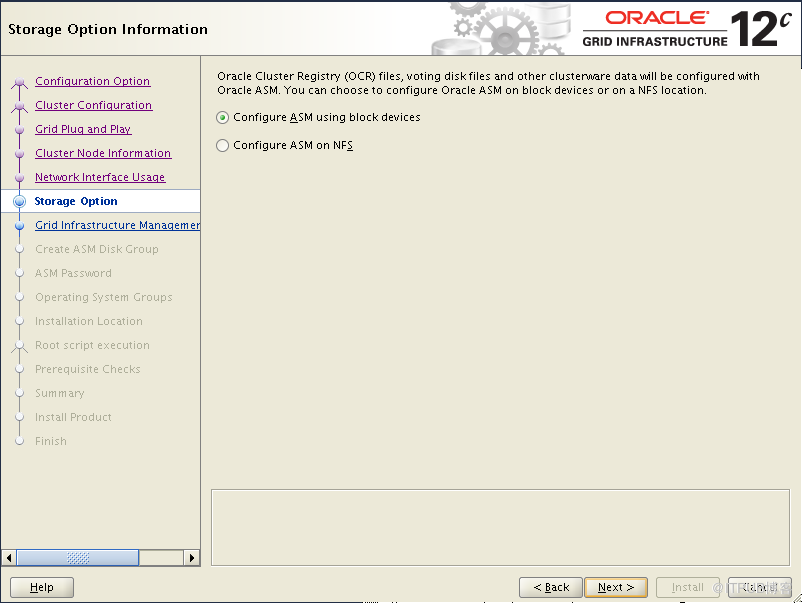

12.2开始可以直接选用NFS了,不过我们这里选择块设备。然后下一步:

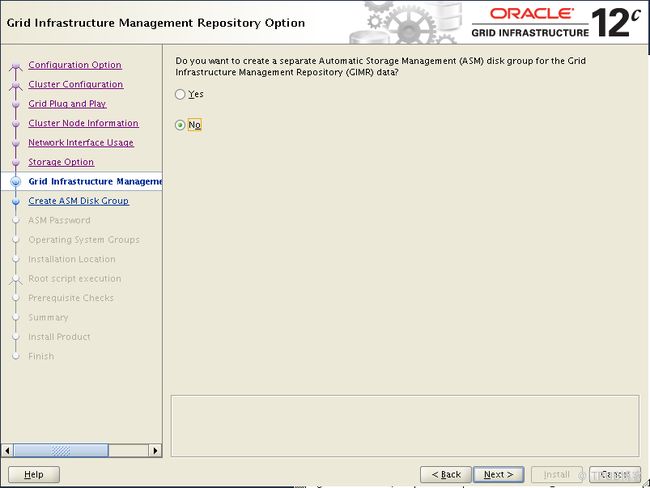

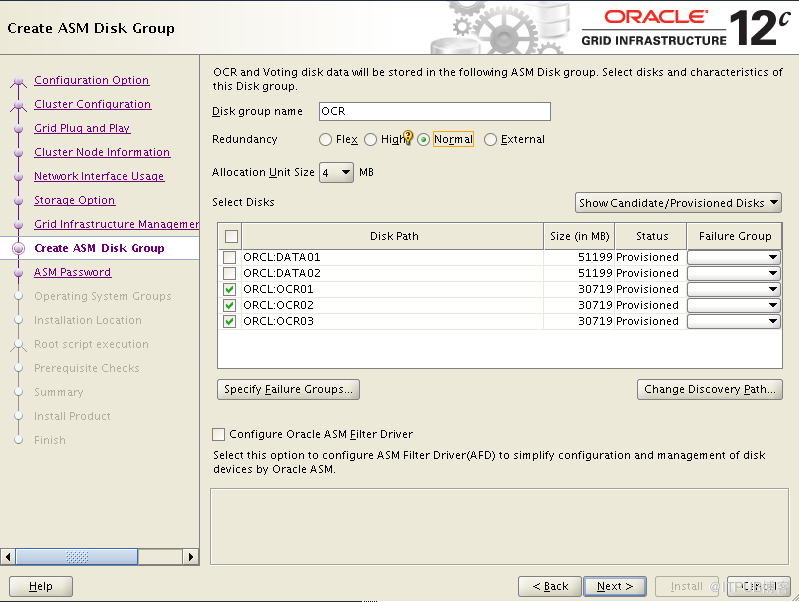

12.2增加了一个GIMR的概念,所谓GIMR其实就是用来存储集群信息的一个数据库,可以单独部署在一个磁盘组里,也可以和OCR共用一个磁盘组。这里要注意的是,如果选择和OCR共用磁盘组,磁盘组的容量需要40G(准备的说是3850MB)以上,否则会出现空间不足的错误。我们这里选择和OCR共用磁盘组。下一步创建OCR磁盘组:

下一步安装程序会检查磁盘组的容量是否满足需求,如果容量不满足即报错,无法进行后续的步骤。所以在开始规划时OCR的磁盘要分配大一些。

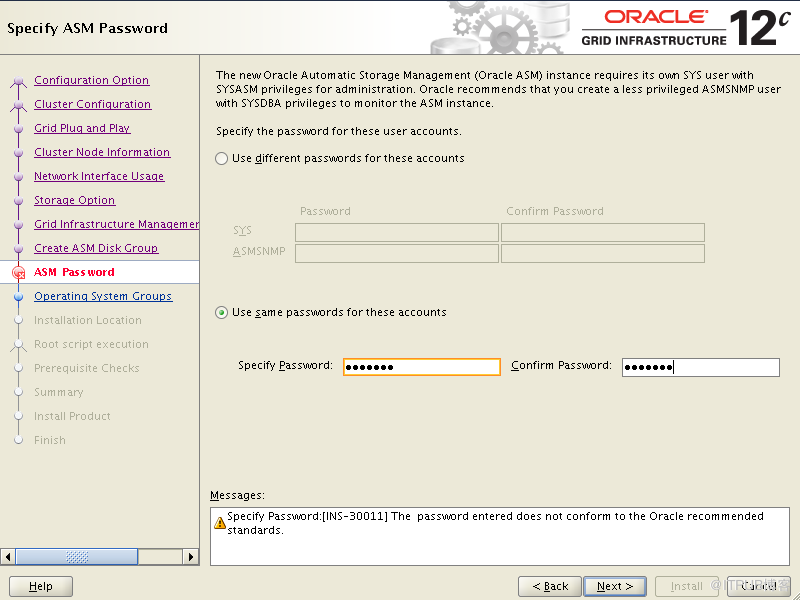

然后设置SYS和ASMSNMP的口令,这里为了方便将两个账号的口令设置成一样并且使用了比较简单的口令。在实际生产中出于安全考虑建议还是单独设置,并使用复杂的口令(安装程序会检查口令是否满足要求)。

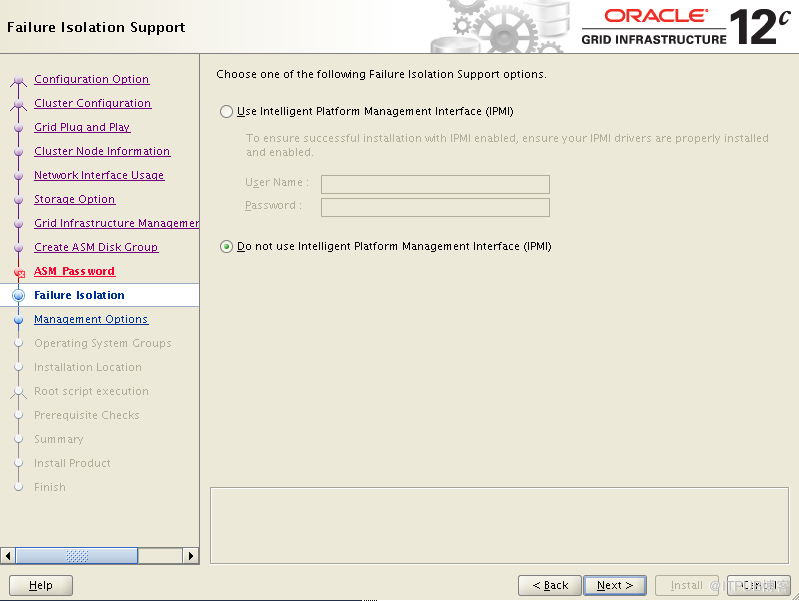

配置IPMI,使用默认的选项,不使用IPMI。然后下一步:

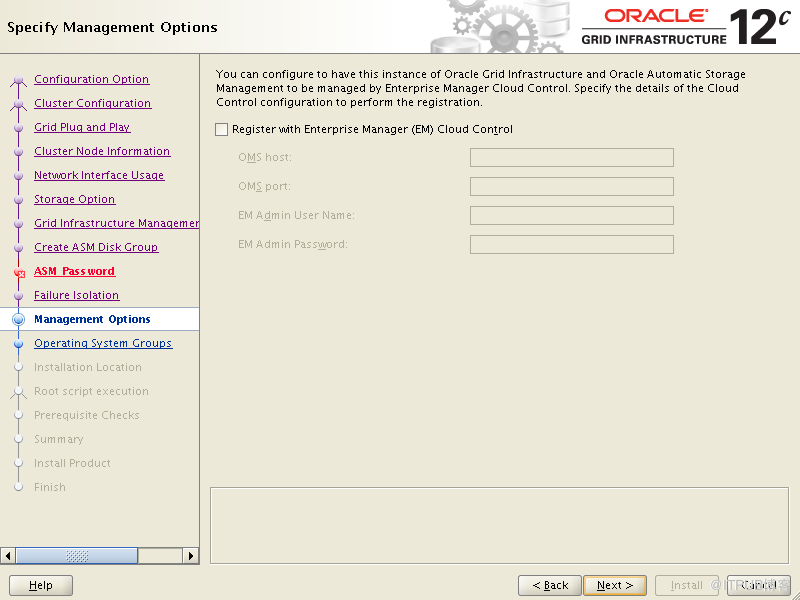

配置EM。如果组织里使用EM进行管理的可以进行配置。然后下一步配置用户组和软件路径:

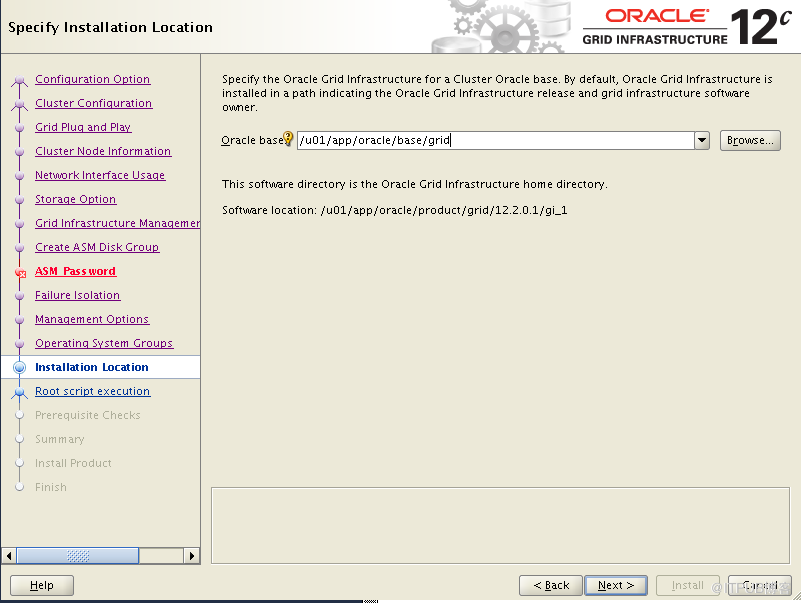

这里只要配置Oracle base的路径就可以了。然后配置inventory的路径:

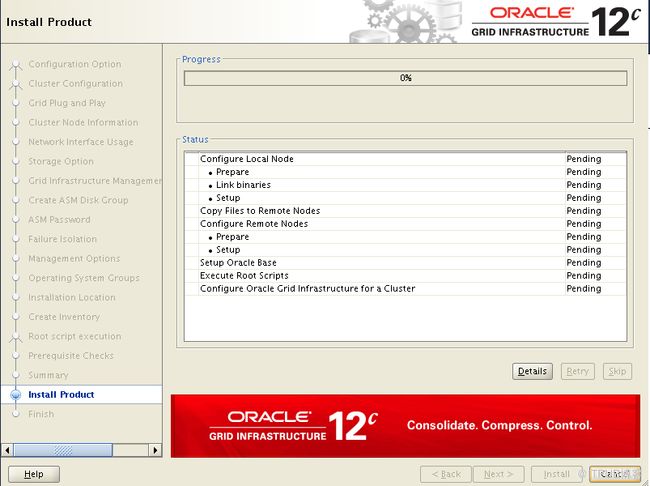

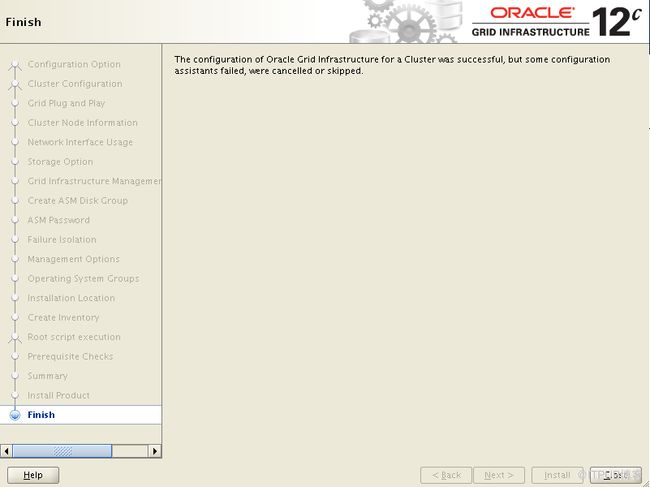

最后检查没问题后,开始安装:

安装配置还是需要点时间的,在本次配置的虚机上,差不多花费了1个多小时才安装完成。

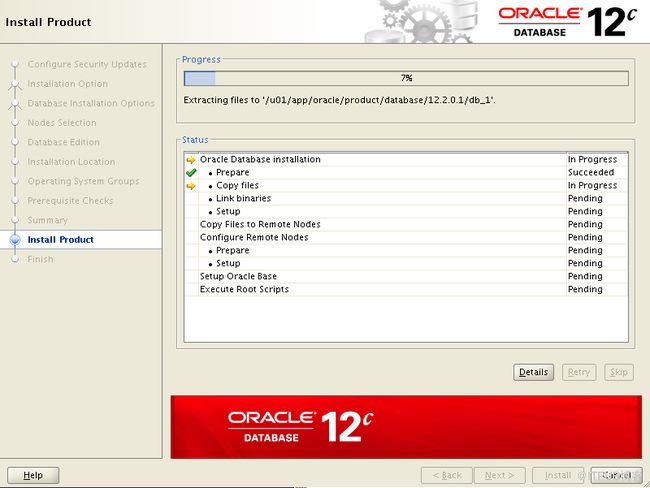

Database的安装

相比grid,database的安装基本上没多大的变化。这里我们只安装数据库软件,建库的操作放到后面进行。可能唯一的变化是系统用户组的选择,多了好几个:

也就是说权限分的更细了:备份、高可用、集群等都单独分配组。这里为了方便都设置为dba。实际中还是需要根据各自的实际情况来进行设置。

最后完成安装即可。

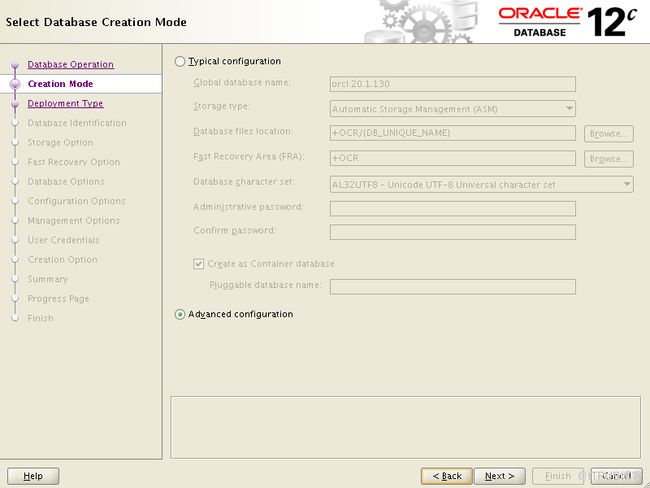

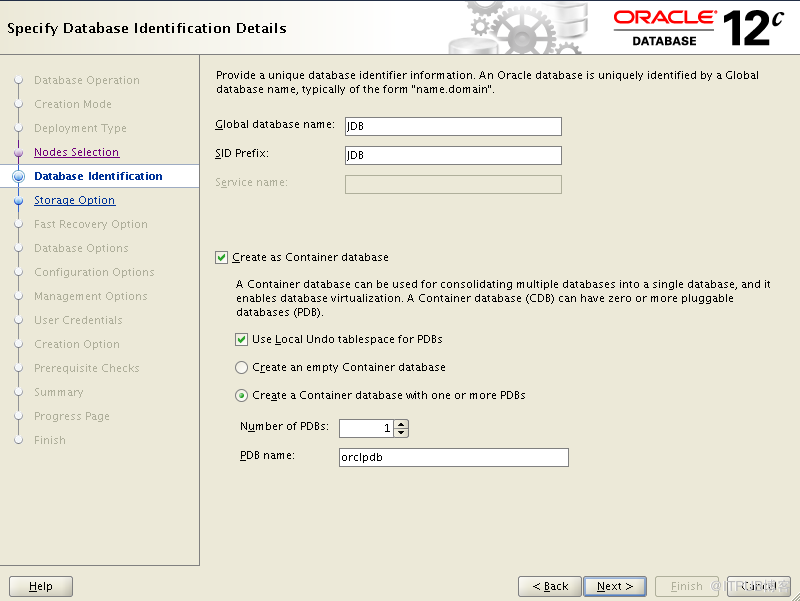

创建集群数据库

我们使用高级模式来创建数据库。在创建过程中,需要注意以下几点:

1、数据库部署类型,需要选择为RAC

2、需要将节点都选上(这里是pnode01、pnode02)

3、数据库的类型,是CDB还是non-CDB,需要根据实际需求来选择。这里选择CDB类型,并创建一个PDB

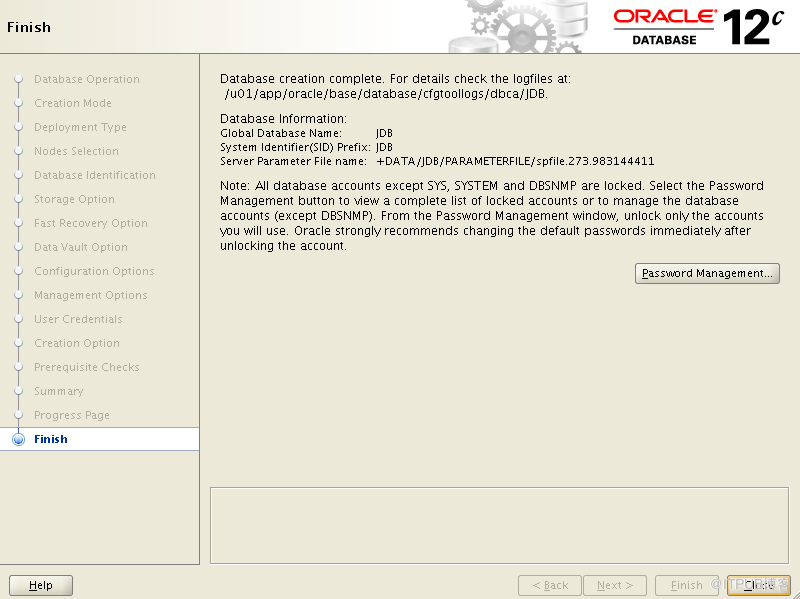

然后是配置数据库的各种参数,包括数据文件路径和大小、在线日志路径和大小、归档路径、内存大小、进程数量、口令等,这些在 前期规划时就需要做好 。最后创建完成:

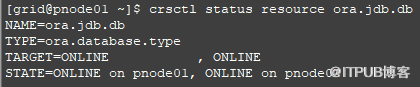

最后我们验证以下数据库的状态:

可以看到数据库已经在pnode01和pnode02上正常运行。

来自 “ ITPUB博客 ” ,链接:http://blog.itpub.net/13885898/viewspace-2169070/,如需转载,请注明出处,否则将追究法律责任。

转载于:http://blog.itpub.net/13885898/viewspace-2169070/