【true positive,false positive,true negative,false negative】的几个解释 ||| ROC Curve and AUC

前言:

TP:True positive

FP:False positive

TN:True negative

FN:False negative

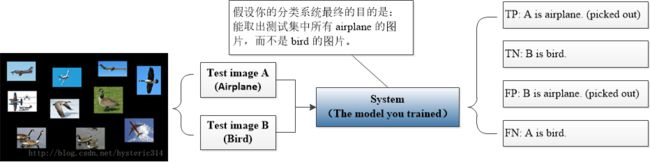

(从下文【解释1】中整理而来的图解)

上述四个名词广泛应用于各种领域。召回率(Recall),精确率(Precision),平均正确率(AP),交除并(IoU)是【object detection】领域的几个性能的衡量指标,其中 AP 取决于 Recall and Precision 组成的曲线,而 Recall and Precision 的计算与上述四个名词息息相关,公式分别如下所示:

![]()

![]()

本文主要找了几个比较受益的相关资料整理于此,之后也会根据自己慢慢学习过程中的理解进一步完善这篇博文。

解释1:(摘抄至)http://blog.csdn.net/syoung9029/article/details/56276567

本文主要摘抄参考资料中的实例:大雁与飞机

假设现在有这样一个测试集,测试集中的图片只由大雁和飞机两种图片组成,如下图所示:

假设你的分类系统最终的目的是:能取出测试集中所有飞机的图片,而不是大雁的图片。现在做如下的定义:

True positives : 飞机的图片被正确的识别成了飞机。

True negatives: 大雁的图片没有被识别出来,系统正确地认为它们是大雁。

False positives: 大雁的图片被错误地识别成了飞机。

False negatives: 飞机的图片没有被识别出来,系统错误地认为它们是大雁。

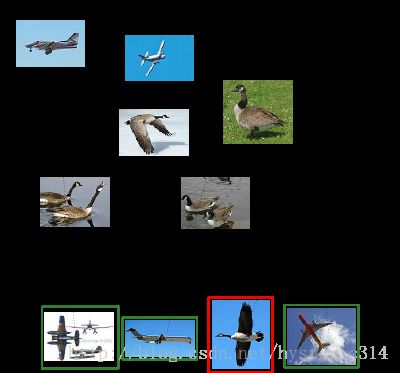

假设你的分类系统使用了上述假设识别出了四个结果,如下图所示:

那么在识别出的这四张照片中:

True positives : 有三个,画绿色框的飞机。

False positives: 有一个,画红色框的大雁。

没被识别出来的六张图片中:

True negatives : 有四个,这四个大雁的图片,系统正确地没有把它们识别成飞机。

False negatives: 有两个,两个飞机没有被识别出来,系统错误地认为它们是大雁。

Precision 与 Recall 的计算:

Precision其实就是在识别出来的图片中,True positives所占的比率: ![]()

其中的n代表的是(True positives + False positives),也就是系统一共识别出来多少照片 。

在这一例子中,True positives为3,False positives为1,所以Precision值是 3/(3+1)=0.75。

意味着在识别出的结果中,飞机的图片占75%。

Recall 是被正确识别出来的飞机个数与测试集中所有飞机的个数的比值: ![]()

Recall的分母是(True positives + False negatives),这两个值的和,可以理解为一共有多少张飞机的照片。

在这一例子中,True positives为3,False negatives为2,那么Recall值是 3/(3+2)=0.6。

意味着在所有的飞机图片中,60%的飞机被正确的识别成飞机。

解释2:(摘抄至)http://blog.51cto.com/simon/73395

ROC Curve and AUC:https://blog.csdn.net/ice110956/article/details/20288239

ROC空间将伪阳性率(FPR)定义为 X 轴,真阳性率(TPR)定义为 Y 轴。ROC曲线上的一个点对应一个阈值,遍历所有的阈值,得到ROC曲线。

标量值AUC:ROC曲线所覆盖的区域面积。AUC越大,分类器分类效果越好。

(详情请参考标题所附链接)