win10单机配置hadoop 3.1.1

win10单机配置hadoop环境

- 本机环境

- 步骤大纲

- 一、java jdk安装

- 二、hadoop下载安装

- 三、hadoop修改配置文件

- 四、下载winutils复制bin

- 五、格式化hdfs文件系统

- 六、启动hadoop

- 七、访问节点

新手布置单机hadoop环境,踩了不少坑,记录一下,给大家参考。

本机环境

win10+64位系统

步骤大纲

我们对Markdown编辑器进行了一些功能拓展与语法支持,除了标准的Markdown编辑器功能,我们增加了如下几点新功能,帮助你用它写博客:

- java jdk ,并配置环境变量;

- hadoop下载安装,并配置环境变量 ;

- hadoop修改配置文件 etc/hadoop下的xml等;

- 下载windows需要的 winutils 复制bin;

- 格式化hdfs文件系统;

- 启动hadoop ;

- 访问节点 ;

一、java jdk安装

官方下载地址:https://www.oracle.com/java/technologies/javase-downloads.html

版本选择:Java jdk8

踩坑1:选择高版本后续会有问题,我之前装过jdk-14版本,后续会遇到resourceManager/node Manager无法启动的问题,参考解法

https://blog.csdn.net/a8131357leo/article/details/81281392

但这种解法对于我来说无效,只能重装jdk 8版本。

安装地址:文件名不要有空格,有空格的话后续会有问题,比如Program Files,有参考说可以用Progra~1代替,但我这里后续还是会报错。还是老老实实装在文件名没有空格的文件夹中。

环境变量配置:点击‘此电脑’→‘属性’→‘环境变量’→‘系统变量’

需添加3条

CLASSPATH:

.;%JAVA_HOME%\lib;%JAVA_HOME%\lib\tool.jar

JAVA_HOME:

自己的安装路径,比如D:\java\jdk8

Path:2条

%CLASSPATH%

%JAVA_HOME%\bin

注意CLASSPATH的开头点和分号。

验证:运行cmd输入java -version查看版本,如果环境变量设置不正确会报错。

二、hadoop下载安装

下载地址:https://hadoop.apache.org/releases.html

版本选择:

下载可以找到对应winutils的版本,如果不对应的话容易报错。

踩坑2:开始下载安装了hadoop 3.2.1的版本,没找到对应的winutils,用其他版本的winutils代替结果报错了,后来改成了3.1.1版本。

配置系统环境变量:

HADOOP_HOME:自己的安装路径,比如D:\hadoop-3.1.1

Path:%HADOOP_HOME\bin

手动创建文件夹workplace和tmp

我的路径参考:D:\hadoop-3.1.1\workplace\tmp

验证:运行cmd输入hadoop version查看版本,验证是否安装正确。

三、hadoop修改配置文件

- core-site.xml文件,用记事本打开在后面添加。

fs.defaultFS

hdfs://localhost:9000

hadoop.tmp.dir

/D:/hadoop-3.1.1/workplace/data/tmp

fs.trash.interval

1440

- mapred-site.xml文件

mapreduce.framework.name

yarn

mapred.job.tracker

hdfs://localhost:9501

- hdfs-site.xml文件

dfs.replication

1

dfs.permissions.enabled

false

dfs.namenode.name.dir

/D:/hadoop-3.1.1/workplace/data/namenode

fs.checkpoint.dir

/D:/hadoop-3.1.1/workplace/data/snn

fs.checkpoint.edits.dir

/D:/hadoop-3.1.1/workplace/data/snn

dfs.datanode.data.dir

/D:/hadoop-3.1.1/workplace/data/datanode

dfs.http.address

localhost:9870

- yarn-site.xml文件

yarn.nodemanager.aux-services

mapreduce_shuffle

yarn.nodemanager.aux-services.mapreduce.shuffle.class org.apache.hadoop.mapred.ShuffleHandler

yarn.nodemanager.resource.cpu-vcores

1

yarn.nodemanager.resource.memory-mb

2048

yarn.nodemanager.log-dirs

/D:/hadoop-3.1.1/logs/yarn

- hadoop-env.cmd文件,注释掉原来的JAVA_HOME,增加自己的用绝对路径的环境变量

@set JAVA_HOME=%JAVA_HOME%

set JAVA_HOME=D:\Java\jdk8

四、下载winutils复制bin

我在github上找的,标星最多的一个对应hadoop3.1.1版本的winutils,链接如下

https://github.com/selfgrowth/apache-hadoop-3.1.1-winutils

注意与Hadoop版本一致。

删除(提前备份)hadoop\bin,将winutils中的bin复制进去。

五、格式化hdfs文件系统

用管理员身份在D:\hadoop-3.1.1\bin路径下运行hdfs.cmd namenode -format

hdfs还有许多其他参数的命令,具体可以去官网查看。踩坑不要多次执行。

六、启动hadoop

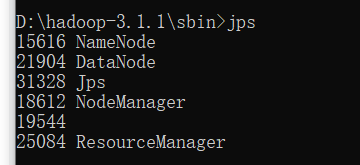

以管理员身份在D:\hadoop-3.1.1\sbin文件夹下运行start-all.cmd。会启动4个窗口,分别为namenode,datenode,resourcemanager,nodemanager。

可以输入jps查看哪些启动了。

如果有启动不成功的,可以查看报错。

七、访问节点

资源管理:http://localhost:9870

节点管理:http://localhost:8088

如果一切正常,则这两个节点都可以访问。