- pigz is needed by docker-ce-18.03.1.ce-1.el7.centos.x86_64 问题

清风的BLOG

问题锦集pigzisneededbydocker-ce-18

出现问题[root@centos74~]#rpm-ivhdocker-ce-18.03.1.ce-1.el7.centos.x86_64.rpm error:Faileddependencies: pigzisneededbydocker-ce-18.03.1.ce-1.el7.centos.x86_64解决问题由上可以看出安装docker需要pigz这个包所以安装这个依赖pigz下载网址:可

- nebula graph传统使用Docker进行项目发版

boy快快长大

解决问题合集NebulaGraph数据库dockerjava容器

nebulagraph传统使用Docker进行项目发版1.nebulagraph服务2.搭建ES集群3.注意事项3.1图数据库的启动顺序3.2模糊查询失效1.nebulagraph服务1.在测试服务器中执行如下命令dockercommit85b6e2b8xxxxxx_nebula_es:1.0.0.2执行dockerimages之后能看到新的镜像xxx_nebula_es:1.0.0.2这里将测试

- Docker配置代理

docker

使用背景最近在国内网络下,pullultralytics镜像一直失败:dockerpullultralytics/ultralytics:latest-conda,尝试使用代理下载镜像配置步骤1.创建或编辑Docker配置文件1.1创建配置文件mkdir-p/etc/systemd/system/docker.service.dvim/etc/systemd/system/docker.servi

- JVM 的类加载机制原理

冰糖心书房

JVM2025Java面试系列java

JVM的类加载机制是指JVM将.class文件(包含Java字节码)加载到内存,并对其进行校验、解析、初始化,最终转换为JVM可以直接使用的Java类型的过程。类加载过程(5个阶段):加载(Loading):查找并加载类的二进制数据:通过类的全限定名(FullyQualifiedName)查找.class文件。类加载器(ClassLoader)负责查找和加载.class文件。类加载器有多种,包括启

- jmeter安装和jmeter历史版本下载

weixin_30432007

java

一、jmete下载:1、最新版本下载地址:http://jmeter.apache.org/download_jmeter.cgi2、历史版本下载地址:https://archive.apache.org/dist/jmeter/binaries/二、软件安装及设置环境变量1、JDK安装目录在D:\ProgramFiles\Java,其环境变量设置为:JAVA_HOME值为:D:\ProgramF

- nginx性能优化及使用方面技巧

智慧源点

nginx性能优化linux

优化Nginx进程数量配置参数如下:代码语言:javascript复制worker_processes1;#指定Nginx要开启的进程数,结尾的数字就是进程的个数,可以为auto这个参数调整的是Nginx服务的worker进程数,Nginx有Master进程和worker进程之分,Master为管理进程、真正接待“顾客”的是worker进程。进程个数的策略:worker进程数可以设置为等于CPU的

- 达梦数据库学习笔记

lwq979991632

数据库

达梦数据库学习资料一、操作系统安装1、配置信息CPU:4核心内存:4G网络:NAT2.安装包选择选择带GUI的服务器,勾选Java平台、KDE二、安装前准备1.数据库远程访问:关闭防火墙systemctlstopfirewalld(禁用)systemctldisablefirewalld(停止,关闭开机自启动)systemctlstatusfirewalld(查看状态)2.安装gcc包rpm-qa

- 轻松帮你搞清楚Python爬虫数据可视化的流程

liuhaoran___

python

Python爬虫数据可视化的流程主要是通过网络爬取所需的数据,并利用相关的库将数据分析结果以图形化的方式展示出来,帮助用户更直观地理解数据背后的信息。Python爬虫+数据可视化步骤1.获取目标网站的数据使用`requests`或者`selenium`库从网页上抓取信息。对于动态加载内容的页面可以考虑结合JavaScript渲染引擎。2.解析HTML内容提取有用信息常见工具如BeautifulSo

- 蓝桥杯——算法训练——粘木棍

大柠丶

蓝桥杯蓝桥杯算法职场和发展

问题描述有N根木棍,需要将其粘贴成M个长木棍,使得最长的和最短的的差距最小。输入格式第一行两个整数N,M。一行N个整数,表示木棍的长度。输出格式一行一个整数,表示最小的差距样例输入32102040样例输出10数据规模和约定N,M<=7packagecom.study.蓝桥杯.算法训练;importjava.util.Arrays;importjava.util.Scanner;/***@autho

- 蓝桥杯——算法训练——共线

大柠丶

蓝桥杯蓝桥杯算法职场和发展

问题描述给定2维平面上n个整点的坐标,一条直线最多能过几个点?输入格式第一行一个整数n表示点的个数以下n行,每行2个整数分别表示每个点的x,y坐标。输出格式输出一个整数表示答案。样例输入50011220323样例输出3数据规模和约定n<=1500,数据保证不会存在2个相同的点。点坐标在int范围内importjava.util.Scanner;/***@authorsjn*@date2022-2-

- 深入解析 Java Stream API:从 List 到 Map 的优雅转换!!!

小丁学Java

#Lambda表达式#方法引用#StreamjavalistStreamLambda表达式方法引用mapCollectors

深入解析JavaStreamAPI:从List到Map的优雅转换大家好!今天我们来聊聊Java8中一个非常常见的操作:使用StreamAPI将List转换为Map。具体来说,我们将深入分析以下代码片段:MapinviteCodeMap=inviteCodes.stream().collect(Collectors.toMap(InviteCode::getId,ic->ic));这段代码看似简单,

- java用来模块化开发和扩展很有用的服务加载器 ServiceLoader类实现SPI机制

爱的叹息

Java基础整理java开发语言

java.util.ServiceLoader是Java中用于实现服务提供者接口(ServiceProviderInterface,SPI)机制的一个工具。SPI允许你在不修改现有代码的情况下,动态地加载和使用第三方实现。这在插件化设计、模块化开发和扩展性需求中非常有用。基本概念服务接口(ServiceInterface):定义了服务的接口。服务提供者(ServiceProvider):实现了服务

- js在html有几种存在方式,JavaScript输出方式有哪些?

王若琳

js在html有几种存在方式

JavaScript输出方式有哪些?下面本篇文章给大家介绍一下JavaScript常见的输出方式。有一定的参考价值,有需要的朋友可以参考一下,希望对大家有所帮助。1.通过弹窗的形式来输出alert(需要输出的内容);alert("helloworld");confirm(需要输出的内容);confirm("你好吗?");prompt(需要输出的内容);prompt("请输入内容:");注意点:如果

- 判断html标签是否存在,jquery怎么判断标签元素是否存在?

BugHunter666

判断html标签是否存在

jquery怎么判断标签元素是否存在?下面本篇文章给大家介绍一下在jquery中判断页面标签元素是否存在的方法。有一定的参考价值,有需要的朋友可以参考一下,希望对大家有所帮助。jquery判断页面标签元素是否存在在传统的Javascript里,当我们对某个页面元素进行某种操作前,最好先判断这个元素是否存在。原因是对一个不存在的元素进行操作是不允许的。例如:document.getElementBy

- python列表操作计算列表长度并输出,Python基础2:列表

想吃草莓干

一、列表列表是按照特定顺序的排列组合,就像数学中的数列,列表中的元素具有⼀定的排列顺序。在Python中,列表用方括号[]来表示列表,比如:>>>a=['Python','C','Java']1、访问列表中的元素索引开始:0如果我们想要打印上述列表中Python,就需要我们访问列表中第一个元素,在Python中,列表的访问从0开始,索引数为元素的位置减去1,访问的元素位置放在方括号里面,如果我们想

- 多阶段构建实现 Docker 加速与体积减小:含文件查看、上传及拷贝功能的 FastAPI 应用镜像构建

九不多

DockerdockerfastapipythonYOLO

本文围绕使用Docker构建FastAPI应用镜像展开,着重介绍了多阶段构建的Dockerfile编写及相关操作。借助多阶段构建,不仅实现了Docker构建的加速,还有效减小了镜像体积。1.Dockerfile内容以下是我们要使用的Dockerfile内容:#第一个阶段-构建应用FROMdocker.1ms.run/python:3.9ASbuilder#设置工作目录WORKDIR/app#复制依

- JavaScript数组-遍历数组

咖啡の猫

javascript开发语言

在JavaScript开发过程中,数组是一种非常常见且强大的数据结构,用于存储一系列有序的数据项。遍历数组是处理这些数据项的基础操作之一,无论是为了显示、转换还是过滤数据。本文将详细介绍几种常见的遍历数组的方法及其应用场景,帮助你选择最适合当前任务的方式。一、为什么需要遍历数组?遍历数组意味着逐一访问数组中的每个元素,以便执行特定的操作,如打印输出、修改值或基于条件筛选数据。不同的场景可能需要不同

- docker学习整理

24k小善

java大数据云计算

一、Docker核心原理:像租房装修一样理解容器1.1容器vs虚拟机:合租vs买别墅虚拟机就像买别墅:每个别墅(虚拟机)自带独立地基(操作系统)、水电系统(系统资源),启动慢(分钟级)、资源占用大(GB级)[1][10]容器就像合租:大家共享小区基础设施(宿主机内核),但每个房间(容器)有自己的家具摆放(应用和依赖)。轻量(MB级)、秒级启动,还能随时搬走(迁移)[9]1.2镜像分层:乐高积木式打

- 摸鱼神器(保持Teams一直处于绿色状态)

PhilipJ0303

java

packageorg.cloud.sonic.controller.tools;importjava.awt.*;importjava.time.DayOfWeek;importjava.time.LocalDateTime;importjava.time.LocalTime;/***@authorPhilipLee*@date2024/1/916:10*/publicclassTest{publ

- `docker commit`和`docker tag`

NLstudy33

dockerjava容器

1.`dockercommit``dockercommit`是一个Docker命令,用于将一个正在运行的容器(Container)的状态提交为一个新的镜像(Image)。这类似于在版本控制系统中提交更改。作用•当你对一个容器进行了修改(例如安装了软件、修改了配置文件等),你可以使用`dockercommit`将这些更改保存为一个新的镜像。•这样,你可以基于这个新镜像创建更多的容器,而不需要重复相同

- 请列举你所了解的测试工具

cfjybgkmf

软件工程课程作业软件工程

测试管理:svn、git白盒测试工具:jtestjava代码扫描工具:findbugs、TscanCode网络测试工具:wireshark、tcapp自动化工具:uiautomator

- JAVA代码实现ElasticSearch搜索(入门-进阶)(一):搜索方法、多字段查询、高亮展示

majunssz

elasticsearchelasticsearch

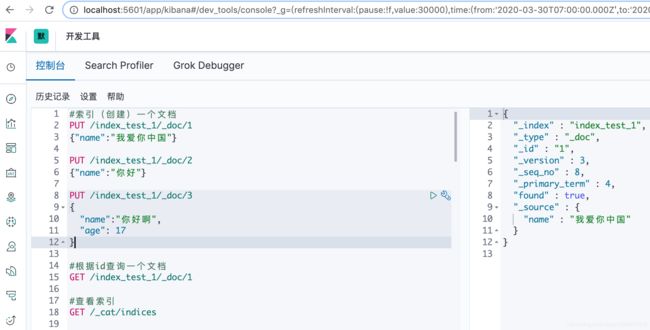

一、搜索方法对比首先存入一条数据count="ilikeeatingandkuing"默认分词器应该将内容分为“i”“like”“eating”“and”“kuing”1.QueryBuilders.matchQuery("count",count);会将搜索词分词,再与目标查询字段进行匹配,若分词中的任意一个词与目标字段匹配上,则可查询到。count="i"可查出count="ili"可查出co

- java毕业设计,网上商城系统

爱编程的小哥

java毕设java课程设计springbootvue

️OnlineMall商城系统全解析|Vue3+SpringBoot全栈实战(附高并发与数据安全方案)一、系统架构全景基于七张效果图分析,该系统是企业级电商综合管理平台,采用SpringBoot3+Vue3+ElementPlus+MyBatisPlus技术栈,覆盖商品管理、订单处理、会员运营等核心场景。通过RBAC权限控制+Elasticsearch搜索+分布式事务三大技术亮点,支持10万级商品

- java将动态图转换成静态图_如何用最简单的方法把静态图变成动图?

PEI Lobster

java将动态图转换成静态图

在今日头条浏览文章时,我们经常会看到有些作者在文章中插入了一些动态图片,不但美化了页面,而且起到了简明扼要的说明作用,让读者对文章内容加深了理解,也提高了文章的阅读量和点击量。这样的动态效果是如何制作的呢?主要有两个步骤:首先要制作出图片动态效果的视频,一般是MP4格式,第二步用格式工厂等文件格式转换软件,把MP4转换为gif动画格式,然后就可以把它插入到网页中。这其中的难点和重点就在于制作图片的

- Angular 编译前的脚本执行

t0_54manong

编程问题解决手册angular.js前端javascript个人开发

在使用Angular开发项目时,有时候我们需要在每次编译之前执行特定的脚本或JavaScript函数。这在开发环境中非常有用,比如运行某些预处理、清理或其他自定义逻辑。今天我们将探讨如何在Angularv17结合esbuild实现这个功能。问题背景假设你正在使用Angularv17进行开发,并且已经配置了esbuild作为构建工具。现在你需要在每次Angular编译之前(特别是使用ngwatch时

- 2023华为OD机试真题-最佳对手(JAVA、Python、C++)

huaweiod123

华为OD机试真题2023javac++算法华为python

题目描述:游戏里面,队伍通过匹配实力相近的对手进行对战。但是如果匹配的队伍实例相差太大,对于双方游戏体验都不会太好。给定n个队伍的实力值,对其进行两两实力匹配,两支队伍实例差距在允许的最大差距d内,则可以匹配。要求在匹配队伍最多的情况下,匹配出的各组实力差距的总和最小。输入描述:第一行,n,d。队伍个数n。允许的最大实力差距d。(2<=n<=50,0<=d<=100)。第二行,n个队伍的实力值,空

- 华为OD机试E卷 - 最佳对手 / 实力差距最小总和(Java & Python& JS & C++ & C )

算法大师

javapythonjavascriptc++

题目描述游戏里面,队伍通过匹配实力相近的对手进行对战。但是如果匹配的队伍实力相差太大,对于双方游戏体验都不会太好。给定n个队伍的实力值,对其进行两两实力匹配,两支队伍实例差距在允许的最大差距d内,则可以匹配。要求在匹配队伍最多的情况下匹配出的各组实力差距的总和最小。输入描述第一行,n,d。队伍个数n。允许的最大实力差距d。2<=n<=500<=d<=100第二行,n个队伍的实力值空格分割。0<=各

- 复习JVM

LMQ6

jvm

JVM的三个主要主题:1.java内存区域划分:a.堆b.栈c.元数据区d.程序计数器2.类加载a.加载:打开.class文件,读取内容b.验证:验证.class文件的格式是否符合要求.c.准备:给类对象分配内存空间d.解析:初始化字符串常量e.初始化:对类对象中的各个部分初始化,比如静态代码块,静态成员的初始化等经典面试题:双亲委派模型他出现在"加载"环节,根据"全限定名称"寻找对应的.clas

- 揭秘Java内存模型:那些让人头疼的可见性问题--JVM基础(15)

guangzhi0633

javajvm开发语言

一、揭秘Java内存模型:那些让人头疼的可见性问题在Java的世界里,多线程编程如同一场精彩的魔术表演,但稍有不慎,就可能陷入“内存可见性”这个魔术黑洞。今天,就让我们一起揭开Java内存模型的神秘面纱,探讨那些让人头疼的可见性问题!可见性问题的本质可见性问题,简单来说,就是当一个线程修改了共享变量的值后,其他线程却无法立即看到这个变化。这就像是你在房间里悄悄换了件衣服,但别人却看不到你的新装。现

- JavaScript基础-API 和 Web API

難釋懷

前端javascript开发语言

在现代Web开发中,API(应用程序接口)是连接不同软件组件或系统之间的桥梁。对于前端开发者来说,JavaScript与WebAPI的结合使用尤为重要,它使得我们可以访问浏览器提供的各种功能和服务,从而构建出交互性更强、用户体验更好的网页应用。本文将介绍API的基本概念,重点探讨WebAPI及其在JavaScript中的应用。一、什么是API?API全称为“ApplicationProgrammi

- LeetCode[位运算] - #137 Single Number II

Cwind

javaAlgorithmLeetCode题解位运算

原题链接:#137 Single Number II

要求:

给定一个整型数组,其中除了一个元素之外,每个元素都出现三次。找出这个元素

注意:算法的时间复杂度应为O(n),最好不使用额外的内存空间

难度:中等

分析:

与#136类似,都是考察位运算。不过出现两次的可以使用异或运算的特性 n XOR n = 0, n XOR 0 = n,即某一

- 《JavaScript语言精粹》笔记

aijuans

JavaScript

0、JavaScript的简单数据类型包括数字、字符创、布尔值(true/false)、null和undefined值,其它值都是对象。

1、JavaScript只有一个数字类型,它在内部被表示为64位的浮点数。没有分离出整数,所以1和1.0的值相同。

2、NaN是一个数值,表示一个不能产生正常结果的运算结果。NaN不等于任何值,包括它本身。可以用函数isNaN(number)检测NaN,但是

- 你应该更新的Java知识之常用程序库

Kai_Ge

java

在很多人眼中,Java 已经是一门垂垂老矣的语言,但并不妨碍 Java 世界依然在前进。如果你曾离开 Java,云游于其它世界,或是每日只在遗留代码中挣扎,或许是时候抬起头,看看老 Java 中的新东西。

Guava

Guava[gwɑ:və],一句话,只要你做Java项目,就应该用Guava(Github)。

guava 是 Google 出品的一套 Java 核心库,在我看来,它甚至应该

- HttpClient

120153216

httpclient

/**

* 可以传对象的请求转发,对象已流形式放入HTTP中

*/

public static Object doPost(Map<String,Object> parmMap,String url)

{

Object object = null;

HttpClient hc = new HttpClient();

String fullURL

- Django model字段类型清单

2002wmj

django

Django 通过 models 实现数据库的创建、修改、删除等操作,本文为模型中一般常用的类型的清单,便于查询和使用: AutoField:一个自动递增的整型字段,添加记录时它会自动增长。你通常不需要直接使用这个字段;如果你不指定主键的话,系统会自动添加一个主键字段到你的model。(参阅自动主键字段) BooleanField:布尔字段,管理工具里会自动将其描述为checkbox。 Cha

- 在SQLSERVER中查找消耗CPU最多的SQL

357029540

SQL Server

返回消耗CPU数目最多的10条语句

SELECT TOP 10

total_worker_time/execution_count AS avg_cpu_cost, plan_handle,

execution_count,

(SELECT SUBSTRING(text, statement_start_of

- Myeclipse项目无法部署,Undefined exploded archive location

7454103

eclipseMyEclipse

做个备忘!

错误信息为:

Undefined exploded archive location

原因:

在工程转移过程中,导致工程的配置文件出错;

解决方法:

- GMT时间格式转换

adminjun

GMT时间转换

普通的时间转换问题我这里就不再罗嗦了,我想大家应该都会那种低级的转换问题吧,现在我向大家总结一下如何转换GMT时间格式,这种格式的转换方法网上还不是很多,所以有必要总结一下,也算给有需要的朋友一个小小的帮助啦。

1、可以使用

SimpleDateFormat SimpleDateFormat

EEE-三位星期

d-天

MMM-月

yyyy-四位年

- Oracle数据库新装连接串问题

aijuans

oracle数据库

割接新装了数据库,客户端登陆无问题,apache/cgi-bin程序有问题,sqlnet.log日志如下:

Fatal NI connect error 12170.

VERSION INFORMATION: TNS for Linux: Version 10.2.0.4.0 - Product

- 回顾java数组复制

ayaoxinchao

java数组

在写这篇文章之前,也看了一些别人写的,基本上都是大同小异。文章是对java数组复制基础知识的回顾,算是作为学习笔记,供以后自己翻阅。首先,简单想一下这个问题:为什么要复制数组?我的个人理解:在我们在利用一个数组时,在每一次使用,我们都希望它的值是初始值。这时我们就要对数组进行复制,以达到原始数组值的安全性。java数组复制大致分为3种方式:①for循环方式 ②clone方式 ③arrayCopy方

- java web会话监听并使用spring注入

bewithme

Java Web

在java web应用中,当你想在建立会话或移除会话时,让系统做某些事情,比如说,统计在线用户,每当有用户登录时,或退出时,那么可以用下面这个监听器来监听。

import java.util.ArrayList;

import java.ut

- NoSQL数据库之Redis数据库管理(Redis的常用命令及高级应用)

bijian1013

redis数据库NoSQL

一 .Redis常用命令

Redis提供了丰富的命令对数据库和各种数据库类型进行操作,这些命令可以在Linux终端使用。

a.键值相关命令

b.服务器相关命令

1.键值相关命令

&

- java枚举序列化问题

bingyingao

java枚举序列化

对象在网络中传输离不开序列化和反序列化。而如果序列化的对象中有枚举值就要特别注意一些发布兼容问题:

1.加一个枚举值

新机器代码读分布式缓存中老对象,没有问题,不会抛异常。

老机器代码读分布式缓存中新对像,反序列化会中断,所以在所有机器发布完成之前要避免出现新对象,或者提前让老机器拥有新增枚举的jar。

2.删一个枚举值

新机器代码读分布式缓存中老对象,反序列

- 【Spark七十八】Spark Kyro序列化

bit1129

spark

当使用SparkContext的saveAsObjectFile方法将对象序列化到文件,以及通过objectFile方法将对象从文件反序列出来的时候,Spark默认使用Java的序列化以及反序列化机制,通常情况下,这种序列化机制是很低效的,Spark支持使用Kyro作为对象的序列化和反序列化机制,序列化的速度比java更快,但是使用Kyro时要注意,Kyro目前还是有些bug。

Spark

- Hybridizing OO and Functional Design

bookjovi

erlanghaskell

推荐博文:

Tell Above, and Ask Below - Hybridizing OO and Functional Design

文章中把OO和FP讲的深入透彻,里面把smalltalk和haskell作为典型的两种编程范式代表语言,此点本人极为同意,smalltalk可以说是最能体现OO设计的面向对象语言,smalltalk的作者Alan kay也是OO的最早先驱,

- Java-Collections Framework学习与总结-HashMap

BrokenDreams

Collections

开发中常常会用到这样一种数据结构,根据一个关键字,找到所需的信息。这个过程有点像查字典,拿到一个key,去字典表中查找对应的value。Java1.0版本提供了这样的类java.util.Dictionary(抽象类),基本上支持字典表的操作。后来引入了Map接口,更好的描述的这种数据结构。

&nb

- 读《研磨设计模式》-代码笔记-职责链模式-Chain Of Responsibility

bylijinnan

java设计模式

声明: 本文只为方便我个人查阅和理解,详细的分析以及源代码请移步 原作者的博客http://chjavach.iteye.com/

/**

* 业务逻辑:项目经理只能处理500以下的费用申请,部门经理是1000,总经理不设限。简单起见,只同意“Tom”的申请

* bylijinnan

*/

abstract class Handler {

/*

- Android中启动外部程序

cherishLC

android

1、启动外部程序

引用自:

http://blog.csdn.net/linxcool/article/details/7692374

//方法一

Intent intent=new Intent();

//包名 包名+类名(全路径)

intent.setClassName("com.linxcool", "com.linxcool.PlaneActi

- summary_keep_rate

coollyj

SUM

BEGIN

/*DECLARE minDate varchar(20) ;

DECLARE maxDate varchar(20) ;*/

DECLARE stkDate varchar(20) ;

DECLARE done int default -1;

/* 游标中 注册服务器地址 */

DE

- hadoop hdfs 添加数据目录出错

daizj

hadoophdfs扩容

由于原来配置的hadoop data目录快要用满了,故准备修改配置文件增加数据目录,以便扩容,但由于疏忽,把core-site.xml, hdfs-site.xml配置文件dfs.datanode.data.dir 配置项增加了配置目录,但未创建实际目录,重启datanode服务时,报如下错误:

2014-11-18 08:51:39,128 WARN org.apache.hadoop.h

- grep 目录级联查找

dongwei_6688

grep

在Mac或者Linux下使用grep进行文件内容查找时,如果给定的目标搜索路径是当前目录,那么它默认只搜索当前目录下的文件,而不会搜索其下面子目录中的文件内容,如果想级联搜索下级目录,需要使用一个“-r”参数:

grep -n -r "GET" .

上面的命令将会找出当前目录“.”及当前目录中所有下级目录

- yii 修改模块使用的布局文件

dcj3sjt126com

yiilayouts

方法一:yii模块默认使用系统当前的主题布局文件,如果在主配置文件中配置了主题比如: 'theme'=>'mythm', 那么yii的模块就使用 protected/themes/mythm/views/layouts 下的布局文件; 如果未配置主题,那么 yii的模块就使用 protected/views/layouts 下的布局文件, 总之默认不是使用自身目录 pr

- 设计模式之单例模式

come_for_dream

设计模式单例模式懒汉式饿汉式双重检验锁失败无序写入

今天该来的面试还没来,这个店估计不会来电话了,安静下来写写博客也不错,没事翻了翻小易哥的博客甚至与大牛们之间的差距,基础知识不扎实建起来的楼再高也只能是危楼罢了,陈下心回归基础把以前学过的东西总结一下。

*********************************

- 8、数组

豆豆咖啡

二维数组数组一维数组

一、概念

数组是同一种类型数据的集合。其实数组就是一个容器。

二、好处

可以自动给数组中的元素从0开始编号,方便操作这些元素

三、格式

//一维数组

1,元素类型[] 变量名 = new 元素类型[元素的个数]

int[] arr =

- Decode Ways

hcx2013

decode

A message containing letters from A-Z is being encoded to numbers using the following mapping:

'A' -> 1

'B' -> 2

...

'Z' -> 26

Given an encoded message containing digits, det

- Spring4.1新特性——异步调度和事件机制的异常处理

jinnianshilongnian

spring 4.1

目录

Spring4.1新特性——综述

Spring4.1新特性——Spring核心部分及其他

Spring4.1新特性——Spring缓存框架增强

Spring4.1新特性——异步调用和事件机制的异常处理

Spring4.1新特性——数据库集成测试脚本初始化

Spring4.1新特性——Spring MVC增强

Spring4.1新特性——页面自动化测试框架Spring MVC T

- squid3(高命中率)缓存服务器配置

liyonghui160com

系统:centos 5.x

需要的软件:squid-3.0.STABLE25.tar.gz

1.下载squid

wget http://www.squid-cache.org/Versions/v3/3.0/squid-3.0.STABLE25.tar.gz

tar zxf squid-3.0.STABLE25.tar.gz &&

- 避免Java应用中NullPointerException的技巧和最佳实践

pda158

java

1) 从已知的String对象中调用equals()和equalsIgnoreCase()方法,而非未知对象。 总是从已知的非空String对象中调用equals()方法。因为equals()方法是对称的,调用a.equals(b)和调用b.equals(a)是完全相同的,这也是为什么程序员对于对象a和b这么不上心。如果调用者是空指针,这种调用可能导致一个空指针异常

Object unk

- 如何在Swift语言中创建http请求

shoothao

httpswift

概述:本文通过实例从同步和异步两种方式上回答了”如何在Swift语言中创建http请求“的问题。

如果你对Objective-C比较了解的话,对于如何创建http请求你一定驾轻就熟了,而新语言Swift与其相比只有语法上的区别。但是,对才接触到这个崭新平台的初学者来说,他们仍然想知道“如何在Swift语言中创建http请求?”。

在这里,我将作出一些建议来回答上述问题。常见的

- Spring事务的传播方式

uule

spring事务

传播方式:

新建事务

required

required_new - 挂起当前

非事务方式运行

supports

&nbs