- PyTorch & TensorFlow速成复习:从基础语法到模型部署实战(附FPGA移植衔接)

阿牛的药铺

算法移植部署pytorchtensorflowfpga开发

PyTorch&TensorFlow速成复习:从基础语法到模型部署实战(附FPGA移植衔接)引言:为什么算法移植工程师必须掌握框架基础?针对光学类产品算法FPGA移植岗位需求(如可见光/红外图像处理),深度学习框架是算法落地的"桥梁"——既要用PyTorch/TensorFlow验证算法可行性,又要将训练好的模型(如CNN、目标检测)转换为FPGA可部署的格式(ONNX、TFLite)。本文采用"

- Python的科学计算库NumPy(一)

linlin_1998

pythonnumpy开发语言

NumPy(NumericalPython)是Python中最基础、最重要的科学计算库之一,提供了高性能的多维数组(ndarray)对象和大量数学函数,是许多数据科学、机器学习库(如Pandas、SciPy、TensorFlow等)的基础依赖。1.创建一个numpy里面的一维数组importnumpyasnp###通过array方法创建一个ndarrayarray1=np.array([1,2,3

- 使用tensorflow的多项式回归的例子(二)

lishaoan77

tensorflowtensorflow回归人工智能多项式回归

例2importtensorflowastfimportnumpyasnpimportmatplotlib.pyplotaspltplt.style.use('default')#importtensorflow.contrib.eagerastfe#fromgoogle.colabimportfiles#tf.enable_eager_execution()x=np.arange(0,5,0.1

- 使用tensorflow的线性回归的例子(七)

lishaoan77

tensorflowtensorflow线性回归人工智能

L1与L2损失这个脚本展示如何用TensorFlow求解线性回归。在算法的收敛性中,理解损失函数的影响是很重要的。这里我们展示L1和L2损失函数是如何影响线性回归的收敛性的。我们使用iris数据集,但是我们将改变损失函数和学习速率来看收敛性的改变。importmatplotlib.pyplotaspltimportnumpyasnpimporttensorflowastffromsklearnim

- 使用tensorflow的线性回归的例子(十二)

lishaoan77

tensorflowtensorflow线性回归人工智能戴明回归

DemingRegression这里展示如何用TensorFlow求解线性戴明回归。=+y=Ax+b我们用iris数据集,特别是:y=SepalLength且x=PetalWidth。戴明回归Demingregression也称为totalleastsquares,其中我们最小化从预测线到实际点(x,y)的最短的距离。最小二乘线性回归最小化与预测线的垂直距离,戴明回归最小化与预测线的总的距离,这种

- 第八周 tensorflow实现猫狗识别

降花绘

365天深度学习tensorflow系列tensorflow深度学习人工智能

本文为365天深度学习训练营内部限免文章(版权归K同学啊所有)**参考文章地址:[TensorFlow入门实战|365天深度学习训练营-第8周:猫狗识别(训练营内部成员可读)]**作者:K同学啊文章目录一、本周学习内容:1、自己搭建VGG16网络2、了解model.train_on_batch()3、了解tqdm,并使用tqdm实现可视化进度条二、前言三、电脑环境四、前期准备1、导入相关依赖项2、

- 深度学习实战-使用TensorFlow与Keras构建智能模型

程序员Gloria

Python超入门TensorFlowpython

深度学习实战-使用TensorFlow与Keras构建智能模型深度学习已经成为现代人工智能的重要组成部分,而Python则是实现深度学习的主要编程语言之一。本文将探讨如何使用TensorFlow和Keras构建深度学习模型,包括必要的代码实例和详细的解析。1.深度学习简介深度学习是机器学习的一个分支,使用多层神经网络来学习和表示数据中的复杂模式。其广泛应用于图像识别、自然语言处理、推荐系统等领域。

- Python结合TensorFlow实现图像风格迁移

Python编程之道

Python人工智能与大数据Python编程之道pythontensorflow开发语言ai

Python结合TensorFlow实现图像风格迁移关键词:Python、TensorFlow、图像风格迁移、神经网络、内容损失、风格损失摘要:本文将带领大家探索如何使用Python结合TensorFlow来实现图像风格迁移。图像风格迁移是一项神奇的技术,它能将一幅图像的风格应用到另一幅图像上。我们会从基础概念讲起,解释图像风格迁移背后的原理,通过Python代码详细展示实现过程,还会探讨实际应用

- 量化价值投资中的深度学习技术:TensorFlow实战

量化价值投资中的深度学习技术:TensorFlow实战关键词:量化价值投资,深度学习,TensorFlow,股票预测,因子模型,LSTM神经网络,量化策略摘要:本文将带你走进"量化价值投资"与"深度学习"的交叉地带,用小学生都能听懂的语言解释复杂概念,再通过手把手的TensorFlow实战案例,教你如何用AI技术挖掘股票市场中的价值宝藏。我们会从传统价值投资的痛点出发,揭示深度学习如何像"超级分析

- AI人工智能遇上TensorFlow:技术融合新趋势

AI大模型应用之禅

人工智能tensorflowpythonai

AI人工智能遇上TensorFlow:技术融合新趋势关键词:人工智能、TensorFlow、深度学习、神经网络、机器学习、技术融合、AI开发摘要:本文深入探讨了人工智能技术与TensorFlow框架的融合发展趋势。我们将从基础概念出发,详细分析TensorFlow在AI领域的核心优势,包括其架构设计、算法实现和实际应用。文章包含丰富的技术细节,如神经网络原理、TensorFlow核心算法实现、数学

- 【零基础学AI】第30讲:生成对抗网络(GAN)实战 - 手写数字生成

1989

0基础学AI人工智能生成对抗网络神经网络python机器学习近邻算法深度学习

本节课你将学到GAN的基本原理和工作机制使用PyTorch构建生成器和判别器DCGAN架构实现技巧训练GAN模型的实用技巧开始之前环境要求Python3.8+需要安装的包:pipinstalltorchtorchvisionmatplotlibnumpyGPU推荐(可大幅加速训练)前置知识第21讲TensorFlow基础第23讲神经网络原理基本PyTorch使用经验核心概念什么是GAN?GAN就像

- 【深度学习-Day 35】实战图像数据增强:用PyTorch和TensorFlow扩充你的数据集

吴师兄大模型

深度学习入门到精通深度学习pytorchtensorflow人工智能python大模型LLM

Langchain系列文章目录01-玩转LangChain:从模型调用到Prompt模板与输出解析的完整指南02-玩转LangChainMemory模块:四种记忆类型详解及应用场景全覆盖03-全面掌握LangChain:从核心链条构建到动态任务分配的实战指南04-玩转LangChain:从文档加载到高效问答系统构建的全程实战05-玩转LangChain:深度评估问答系统的三种高效方法(示例生成、手

- 基于Abp Vnext、FastMCP构建一个企业级的模型即服务(MaaS)平台方案

NetX行者

AbpvnextMaasAbpvnextFastMCP企业级平台解决方案开源python

企业级MaaS平台技术可行性分析报告一、总体技术架构HTTP/WebSocketgRPC/RESTgRPC/RESTgRPCVue3前端ABPvNextAPI网关.NET9业务微服务ABPvNextMCPClientFastMCP模型仓库PyTorch/TensorFlowHuggingFaceHeyGem/ChatGLM自定义模型统一鉴权中心二、核心框架与中间件组件技术选型官方链接作用前端框架V

- 服务器无对应cuda版本安装pytorch-gpu[自用]

片月斜生梦泽南

pytorch

服务器无对应cuda版本安装pytorch-gpu服务器无对应cuda版本安装pytorch-gpu网址下载非root用户安装tmux查看服务器ubuntu版本conda安装tensorflow-gpu安装1.x版本服务器无对应cuda版本安装pytorch-gpu网址GPU版本的pytorch、pytorchvision的下载链接https://download.pytorch.org/whl/

- Ubuntu下安装多版本CUDA及灵活切换全攻略

芯作者

D2:ubuntulinuxubuntu

——释放深度学习潜能,告别版本依赖的烦恼!**为什么需要多版本CUDA?在深度学习、科学计算等领域,不同框架(TensorFlow、PyTorch等)对CUDA版本的要求各异。同时升级框架或维护旧项目时,版本冲突频发。多版本CUDA共存+一键切换是高效开发的刚需!本文将手把手教你实现这一能力,并分享独创的“动态软链接+环境隔离”技巧,让版本管理行云流水!环境准备硬件要求NVIDIA显卡(支持CUD

- ubuntu22.04从新系统到tensorflow GPU支持

澍龑

tensorflow人工智能

ubuntu22.04CUDA从驱动到tensorflow安装0系统常规设置和软件安装0.1挂载第二硬盘默认Home0.2软件安装0.3安装指定版本的python0.4python虚拟环境设置1直接安装1.1配置信息1.2驱动安装1.3集显显示,独显运算(其它debug用)1.4卸载驱动(备用,未试)日常使用ssh后台运行(断联不中断)0系统常规设置和软件安装0.1挂载第二硬盘默认Homesudo

- 【零基础学AI】第27讲:注意力机制(Attention) - 机器翻译实战

1989

0基础学AI人工智能机器翻译自然语言处理pythontensorflow机器学习神经网络

本节课你将学到理解注意力机制的核心思想掌握注意力计算的数学原理实现基于注意力机制的Seq2Seq模型构建英语到法语的神经翻译系统开始之前环境要求Python3.8+需要安装的包:tensorflow==2.8.0numpy==1.21.0matplotlib==3.4.0pandas==1.3.0前置知识RNN/LSTM原理(第26讲)序列数据处理(第26讲)自然语言处理基础(第14讲)核心概念为

- TensorFlow图神经网络(GNN)入门指南

AI天才研究院

AI人工智能与大数据tensorflow神经网络人工智能ai

TensorFlow图神经网络(GNN)入门指南关键词:TensorFlow、图神经网络、GNN、深度学习、图数据、节点嵌入、图卷积网络摘要:本文全面介绍如何使用TensorFlow实现图神经网络(GNN)。我们将从图数据的基本概念开始,深入探讨GNN的核心原理,包括图卷积网络(GCN)、图注意力网络(GAT)等流行架构,并通过TensorFlow代码示例展示如何构建和训练GNN模型。文章还将涵盖

- mediapipe流水线分析 三

江太翁

AndroidNDK人工智能mediapipeandroid

目标检测Graph一流水线上游输入处理1TfLiteConverterCalculator将输入的数据转换成tensorflowapi支持的TensorTfLiteTensor并初始化相关输入输出节点,该类的业务主要通过interpreterstd::unique_ptrtflite::Interpreterinterpreter_=nullptr;实现类完成数据在cpu/gpu上的推理1.1Tf

- JuPyter(IPython) Notebooks中使用pip安装Python的模块

weixin_34218890

开发工具python人工智能

问题描述:没有带GPU的电脑,搞深度学习不是耍流氓嘛,我网上看到有个云平台,免费使用了一下,小姐姐很热情。使用过程如下:他们给的接口是Jupyter编辑平台,我就在上面跑了一个小例子。tensorflow和python环境是他们配置好的,不过我的例子中需要导入matplotlib.pylot模块。可是他们没有提供,怎么办呢?网上查了一下啊解决方法:采用如下方法:importpipdefMyPipi

- TensorFlow武林志 第一卷:入门篇 - 初入江湖 第一章:真气初现

空中湖

tensorflow武林志tensorflow人工智能python

第一卷:入门篇-初入江湖第一章:真气初现林枫揉了揉酸痛的胳膊,将最后一捆柴火堆放在灶房角落。这是他来到青霄剑宗做杂役的第三个月,每日劈柴挑水的生活让他原本白皙的皮肤变得黝黑粗糙。"喂,新来的!掌门要的热水怎么还没送去?"门外传来管事的呵斥声。"马上就好!"林枫急忙提起铜壶,滚烫的热水溅在他手背上,他却浑然不觉疼痛。自从上月在后山偶然吞服了那枚奇异的朱果后,他对冷热疼痛的感知就变得异常迟钝。穿过曲折

- TensorFlow 零基础入门:手把手教你跑通第一个AI模型

蓑笠翁001

人工智能人工智能tensorflowpython机器学习深度学习分类

今天用最直白的语言,带完全零基础的同学走进TensorFlow的世界。不用担心数学公式,先学会"开车",再学"造车"!1.准备工作:安装TensorFlow就像玩游戏需要先安装游戏客户端一样,我们需要先安装TensorFlow。打开你的电脑(Windows/Mac都行),按下Win+R,输入cmd打开命令提示符,然后输入:pipinstalltensorflow看到"Successfullyins

- 「日拱一码」017 深度学习常用库——TensorFlow

目录基础操作张量操作:tf.constant用于创建常量张量tf.Variable用于创建可训练的变量张量tf.reshape可改变张量的形状tf.concat可将多个张量沿指定维度拼接tf.split则可将张量沿指定维度分割数学运算:tf.add张量的加运算tf.subtract张量的减运算tf.multiply张量的乘运算tf.divide张量的除运算tf.pow计算张量的幂tf.sqrt计算

- 强化学习【chapter0】-学习路线图

明朝百晓生

算法人工智能机器学习

前言:主要总结一下西湖大学赵老师的课程【强化学习的数学原理】课程:从零开始到透彻理解(完结)_哔哩哔哩_bilibili1️⃣基础阶段(Ch1-Ch7):掌握表格型算法,理解TD误差与贝尔曼方程2️⃣进阶阶段(Ch8-Ch9):动手实现DQN/策略梯度,熟悉PyTorch/TensorFlow3️⃣前沿阶段(Ch10:阅读论文(OpenAISpinningUp/RLlib文档)Chapter1:基

- 【深度学习pytorch-6】张量与numpy相互转换

超华东算法王

DL-pytorch深度学习pytorchnumpy

张量与Numpy数组之间的互相转换在深度学习中,张量(tensor)和Numpy数组(numpyarray)是两种常见的数据结构。张量通常用于深度学习框架(如PyTorch、TensorFlow等),而Numpy数组在科学计算中被广泛使用。为了便于数据处理和计算,常常需要在它们之间进行转换。下面介绍张量和Numpy数组之间的互相转换。1.PyTorch张量与Numpy数组的互相转换PyTorch提

- NumPy 或 PyTorch/TensorFlow 中的张量理解

栖霖涧

numpypytorchtensorflow

(2,2,3)形状的3D数组(或张量)的结构。个人理解:2个2维数组(张量),2维数组(张量)里面有2个1维向量(张量),1维向量(张量)里面有3个元素。注:由于最后一个维度值3代表的是元素个数,左侧括号后的第1个2代表的是第n-1个[(中括号,即n-1维数组)的数量,左侧括号后的第2个2代表的是第n-2个[(中括号,即n-2维数组)的数量。这段文字中,n代表的是数组的维度,这里是3维。维度解析:

- Tensorflow 回归模型 FLASK + DOCKER 部署 至 Ubuntu 虚拟机

准备工作:安装虚拟机,安装ubuntu,安装python3.x、pip和对应版本的tensorflow和其他库文件,安装docker。注意事项:1.windows系统运行的模型文件不能直接运行到虚拟机上,需在虚拟机上重新运行并生成模型文件2.虚拟机网络状态改为桥接Flask代码如下:fromflaskimportFlask,request,jsonifyimportpickleimportnump

- yolov算法详解_yolo 目标检测算法个人总结(yolov1)

CHAO JIANG

yolov算法详解

yolo目标检测算法个人总结目前yolo目标检测有两个版本,分别为v1和v2。因工作需要用yolo算法检测人物,所以这段时间重点看了这两篇论文,并实现了对应的tensorflow代码。这里记录下在论文阅读过程中的一些细节信息,留给自己,同时也希望各位能指出本人理解错误的地方,谢谢!一:yolov1关于yolov1算法的详解在网上已经非常多了,在这里我大概叙述下算法的流程,以及在开发过程中遇到的一些

- KANN 是一个独立的轻量级 C 语言库,用于构建和训练中小型人工神经网络,例如多层感知器、卷积神经网络和递归神经网络(包括 LSTM 和 GRU)。它实现了基于图的逆模自动微分,并允许构建具有递归等

一、软件介绍文末提供程序和源码下载KANN是一个独立的轻量级C语言库,用于构建和训练中小型人工神经网络,例如多层感知器、卷积神经网络和递归神经网络(包括LSTM和GRU)。它实现了基于图的逆模自动微分,并允许构建具有递归、共享权重和多个输入/输出/成本的拓扑复杂神经网络。与TensorFlow等主流深度学习框架相比,KANN的可扩展性较低,但它的灵活性接近,代码库要小得多,并且仅依赖于标准C库。与

- 在浏览器中使用TensorFlow.js

魏铁锤chui

tensorflowjavascript人工智能

TensorFlow.js简介介绍光学字符识别(OCR)是指能够从图像或文档中捕获文本元素,并将其转换为机器可读的文本格式的技术。如果您想了解更多关于这个主题的内容,本文是一个很好的介绍。TensorFlow.js是一个库,用于使用JavaScript开发和训练机器学习模型,并将其部署在浏览器中或Node.js上。您可以使用现有模型、转换PythonTensorFlow模型、使用迁移学习用您自己的

- java责任链模式

3213213333332132

java责任链模式村民告县长

责任链模式,通常就是一个请求从最低级开始往上层层的请求,当在某一层满足条件时,请求将被处理,当请求到最高层仍未满足时,则请求不会被处理。

就是一个请求在这个链条的责任范围内,会被相应的处理,如果超出链条的责任范围外,请求不会被相应的处理。

下面代码模拟这样的效果:

创建一个政府抽象类,方便所有的具体政府部门继承它。

package 责任链模式;

/**

*

- linux、mysql、nginx、tomcat 性能参数优化

ronin47

一、linux 系统内核参数

/etc/sysctl.conf文件常用参数 net.core.netdev_max_backlog = 32768 #允许送到队列的数据包的最大数目

net.core.rmem_max = 8388608 #SOCKET读缓存区大小

net.core.wmem_max = 8388608 #SOCKET写缓存区大

- php命令行界面

dcj3sjt126com

PHPcli

常用选项

php -v

php -i PHP安装的有关信息

php -h 访问帮助文件

php -m 列出编译到当前PHP安装的所有模块

执行一段代码

php -r 'echo "hello, world!";'

php -r 'echo "Hello, World!\n";'

php -r '$ts = filemtime("

- Filter&Session

171815164

session

Filter

HttpServletRequest requ = (HttpServletRequest) req;

HttpSession session = requ.getSession();

if (session.getAttribute("admin") == null) {

PrintWriter out = res.ge

- 连接池与Spring,Hibernate结合

g21121

Hibernate

前几篇关于Java连接池的介绍都是基于Java应用的,而我们常用的场景是与Spring和ORM框架结合,下面就利用实例学习一下这方面的配置。

1.下载相关内容: &nb

- [简单]mybatis判断数字类型

53873039oycg

mybatis

昨天同事反馈mybatis保存不了int类型的属性,一直报错,错误信息如下:

Caused by: java.lang.NumberFormatException: For input string: "null"

at sun.mis

- 项目启动时或者启动后ava.lang.OutOfMemoryError: PermGen space

程序员是怎么炼成的

eclipsejvmtomcatcatalina.sheclipse.ini

在启动比较大的项目时,因为存在大量的jsp页面,所以在编译的时候会生成很多的.class文件,.class文件是都会被加载到jvm的方法区中,如果要加载的class文件很多,就会出现方法区溢出异常 java.lang.OutOfMemoryError: PermGen space.

解决办法是点击eclipse里的tomcat,在

- 我的crm小结

aijuans

crm

各种原因吧,crm今天才完了。主要是接触了几个新技术:

Struts2、poi、ibatis这几个都是以前的项目中用过的。

Jsf、tapestry是这次新接触的,都是界面层的框架,用起来也不难。思路和struts不太一样,传说比较简单方便。不过个人感觉还是struts用着顺手啊,当然springmvc也很顺手,不知道是因为习惯还是什么。jsf和tapestry应用的时候需要知道他们的标签、主

- spring里配置使用hibernate的二级缓存几步

antonyup_2006

javaspringHibernatexmlcache

.在spring的配置文件中 applicationContent.xml,hibernate部分加入

xml 代码

<prop key="hibernate.cache.provider_class">org.hibernate.cache.EhCacheProvider</prop>

<prop key="hi

- JAVA基础面试题

百合不是茶

抽象实现接口String类接口继承抽象类继承实体类自定义异常

/* * 栈(stack):主要保存基本类型(或者叫内置类型)(char、byte、short、 *int、long、 float、double、boolean)和对象的引用,数据可以共享,速度仅次于 * 寄存器(register),快于堆。堆(heap):用于存储对象。 */ &

- 让sqlmap文件 "继承" 起来

bijian1013

javaibatissqlmap

多个项目中使用ibatis , 和数据库表对应的 sqlmap文件(增删改查等基本语句),dao, pojo 都是由工具自动生成的, 现在将这些自动生成的文件放在一个单独的工程中,其它项目工程中通过jar包来引用 ,并通过"继承"为基础的sqlmap文件,dao,pojo 添加新的方法来满足项

- 精通Oracle10编程SQL(13)开发触发器

bijian1013

oracle数据库plsql

/*

*开发触发器

*/

--得到日期是周几

select to_char(sysdate+4,'DY','nls_date_language=AMERICAN') from dual;

select to_char(sysdate,'DY','nls_date_language=AMERICAN') from dual;

--建立BEFORE语句触发器

CREATE O

- 【EhCache三】EhCache查询

bit1129

ehcache

本文介绍EhCache查询缓存中数据,EhCache提供了类似Hibernate的查询API,可以按照给定的条件进行查询。

要对EhCache进行查询,需要在ehcache.xml中设定要查询的属性

数据准备

@Before

public void setUp() {

//加载EhCache配置文件

Inpu

- CXF框架入门实例

白糖_

springWeb框架webserviceservlet

CXF是apache旗下的开源框架,由Celtix + XFire这两门经典的框架合成,是一套非常流行的web service框架。

它提供了JAX-WS的全面支持,并且可以根据实际项目的需要,采用代码优先(Code First)或者 WSDL 优先(WSDL First)来轻松地实现 Web Services 的发布和使用,同时它能与spring进行完美结合。

在apache cxf官网提供

- angular.equals

boyitech

AngularJSAngularJS APIAnguarJS 中文APIangular.equals

angular.equals

描述:

比较两个值或者两个对象是不是 相等。还支持值的类型,正则表达式和数组的比较。 两个值或对象被认为是 相等的前提条件是以下的情况至少能满足一项:

两个值或者对象能通过=== (恒等) 的比较

两个值或者对象是同样类型,并且他们的属性都能通过angular

- java-腾讯暑期实习生-输入一个数组A[1,2,...n],求输入B,使得数组B中的第i个数字B[i]=A[0]*A[1]*...*A[i-1]*A[i+1]

bylijinnan

java

这道题的具体思路请参看 何海涛的微博:http://weibo.com/zhedahht

import java.math.BigInteger;

import java.util.Arrays;

public class CreateBFromATencent {

/**

* 题目:输入一个数组A[1,2,...n],求输入B,使得数组B中的第i个数字B[i]=A

- FastDFS 的安装和配置 修订版

Chen.H

linuxfastDFS分布式文件系统

FastDFS Home:http://code.google.com/p/fastdfs/

1. 安装

http://code.google.com/p/fastdfs/wiki/Setup http://hi.baidu.com/leolance/blog/item/3c273327978ae55f93580703.html

安装libevent (对libevent的版本要求为1.4.

- [强人工智能]拓扑扫描与自适应构造器

comsci

人工智能

当我们面对一个有限拓扑网络的时候,在对已知的拓扑结构进行分析之后,发现在连通点之后,还存在若干个子网络,且这些网络的结构是未知的,数据库中并未存在这些网络的拓扑结构数据....这个时候,我们该怎么办呢?

那么,现在我们必须设计新的模块和代码包来处理上面的问题

- oracle merge into的用法

daizj

oraclesqlmerget into

Oracle中merge into的使用

http://blog.csdn.net/yuzhic/article/details/1896878

http://blog.csdn.net/macle2010/article/details/5980965

该命令使用一条语句从一个或者多个数据源中完成对表的更新和插入数据. ORACLE 9i 中,使用此命令必须同时指定UPDATE 和INSE

- 不适合使用Hadoop的场景

datamachine

hadoop

转自:http://dev.yesky.com/296/35381296.shtml。

Hadoop通常被认定是能够帮助你解决所有问题的唯一方案。 当人们提到“大数据”或是“数据分析”等相关问题的时候,会听到脱口而出的回答:Hadoop! 实际上Hadoop被设计和建造出来,是用来解决一系列特定问题的。对某些问题来说,Hadoop至多算是一个不好的选择,对另一些问题来说,选择Ha

- YII findAll的用法

dcj3sjt126com

yii

看文档比较糊涂,其实挺简单的:

$predictions=Prediction::model()->findAll("uid=:uid",array(":uid"=>10));

第一个参数是选择条件:”uid=10″。其中:uid是一个占位符,在后面的array(“:uid”=>10)对齐进行了赋值;

更完善的查询需要

- vim 常用 NERDTree 快捷键

dcj3sjt126com

vim

下面给大家整理了一些vim NERDTree的常用快捷键了,这里几乎包括了所有的快捷键了,希望文章对各位会带来帮助。

切换工作台和目录

ctrl + w + h 光标 focus 左侧树形目录ctrl + w + l 光标 focus 右侧文件显示窗口ctrl + w + w 光标自动在左右侧窗口切换ctrl + w + r 移动当前窗口的布局位置

o 在已有窗口中打开文件、目录或书签,并跳

- Java把目录下的文件打印出来

蕃薯耀

列出目录下的文件文件夹下面的文件目录下的文件

Java把目录下的文件打印出来

>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>>

蕃薯耀 2015年7月11日 11:02:

- linux远程桌面----VNCServer与rdesktop

hanqunfeng

Desktop

windows远程桌面到linux,需要在linux上安装vncserver,并开启vnc服务,同时需要在windows下使用vnc-viewer访问Linux。vncserver同时支持linux远程桌面到linux。

linux远程桌面到windows,需要在linux上安装rdesktop,同时开启windows的远程桌面访问。

下面分别介绍,以windo

- guava中的join和split功能

jackyrong

java

guava库中,包含了很好的join和split的功能,例子如下:

1) 将LIST转换为使用字符串连接的字符串

List<String> names = Lists.newArrayList("John", "Jane", "Adam", "Tom");

- Web开发技术十年发展历程

lampcy

androidWeb浏览器html5

回顾web开发技术这十年发展历程:

Ajax

03年的时候我上六年级,那时候网吧刚在小县城的角落萌生。传奇,大话西游第一代网游一时风靡。我抱着试一试的心态给了网吧老板两块钱想申请个号玩玩,然后接下来的一个小时我一直在,注,册,账,号。

彼时网吧用的512k的带宽,注册的时候,填了一堆信息,提交,页面跳转,嘣,”您填写的信息有误,请重填”。然后跳转回注册页面,以此循环。我现在时常想,如果当时a

- 架构师之mima-----------------mina的非NIO控制IOBuffer(说得比较好)

nannan408

buffer

1.前言。

如题。

2.代码。

IoService

IoService是一个接口,有两种实现:IoAcceptor和IoConnector;其中IoAcceptor是针对Server端的实现,IoConnector是针对Client端的实现;IoService的职责包括:

1、监听器管理

2、IoHandler

3、IoSession

- ORA-00054:resource busy and acquire with NOWAIT specified

Everyday都不同

oraclesessionLock

[Oracle]

今天对一个数据量很大的表进行操作时,出现如题所示的异常。此时表明数据库的事务处于“忙”的状态,而且被lock了,所以必须先关闭占用的session。

step1,查看被lock的session:

select t2.username, t2.sid, t2.serial#, t2.logon_time

from v$locked_obj

- javascript学习笔记

tntxia

JavaScript

javascript里面有6种基本类型的值:number、string、boolean、object、function和undefined。number:就是数字值,包括整数、小数、NaN、正负无穷。string:字符串类型、单双引号引起来的内容。boolean:true、false object:表示所有的javascript对象,不用多说function:我们熟悉的方法,也就是

- Java enum的用法详解

xieke90

enum枚举

Java中枚举实现的分析:

示例:

public static enum SEVERITY{

INFO,WARN,ERROR

}

enum很像特殊的class,实际上enum声明定义的类型就是一个类。 而这些类都是类库中Enum类的子类 (java.l

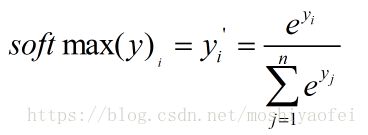

![]() 满足:

满足: ,那么经过Softmax回归处理之后的输出为:

,那么经过Softmax回归处理之后的输出为: ) ,它刻画的是通过概率分布q来表达概率分布p的困难程度。因为正确答案是希望得到的结果,所以当交叉熵作为神经网络的损失函数时,p代表的是正确答案,q代表的是预测值。交叉熵代表的是两个概率分布的距离,也就是说交叉熵值越小,两个概率分布越接近。

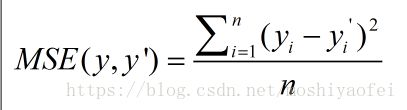

) ,它刻画的是通过概率分布q来表达概率分布p的困难程度。因为正确答案是希望得到的结果,所以当交叉熵作为神经网络的损失函数时,p代表的是正确答案,q代表的是预测值。交叉熵代表的是两个概率分布的距离,也就是说交叉熵值越小,两个概率分布越接近。![]() 为一个batch中第i个数据的正确答案,而

为一个batch中第i个数据的正确答案,而![]() 为神经网络给出的预测值。

为神经网络给出的预测值。