AAAI 2020!七成作者是学生,深度学习三巨头齐聚一堂,圈粉无数

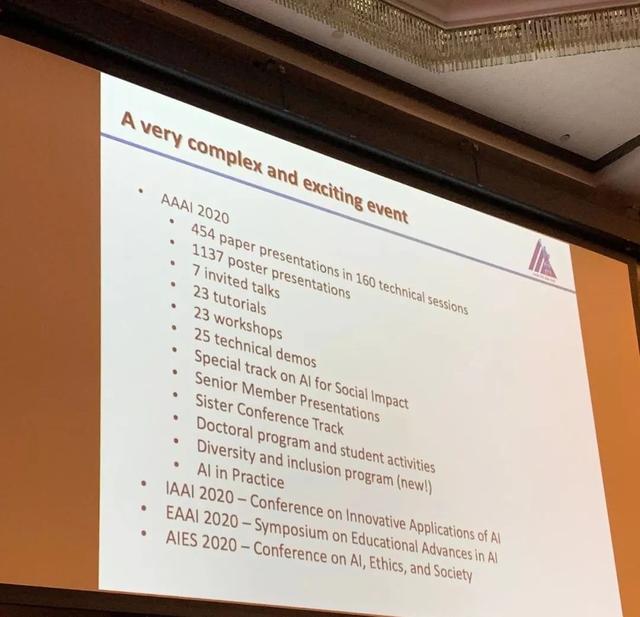

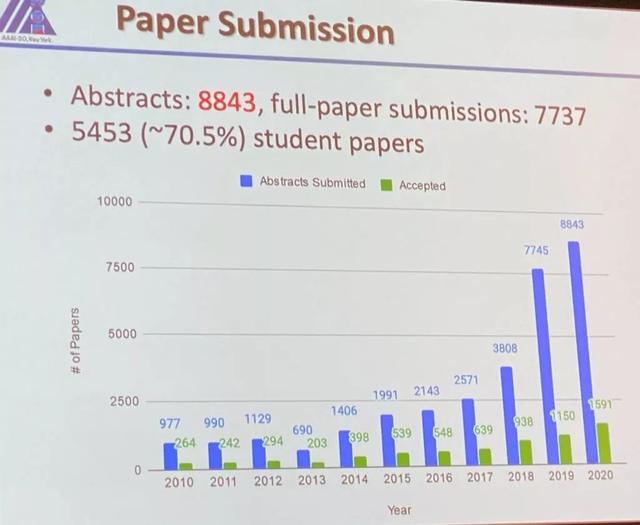

第三十四届AAAI人工智能会议(AAAI 2020)于2020年2月7日至12日在美国纽约州纽约市中心希尔顿酒店举行,会议形式多样,包括学生摘要,海报会议,特邀演讲,教程,讲习班以及展览和竞赛等。AAAI 2020最终收到8800篇提交论文,评审了7737篇,接收了1591篇,接收率20.6%。会议的干货资料小助手正在快马加鞭整理中,记得关注呀!

AAAI 2020论文接收情况

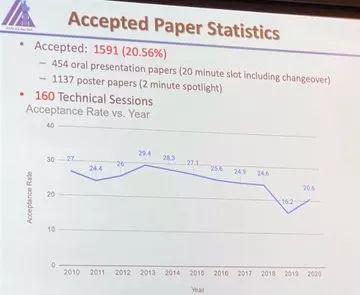

经历了2月7日、8日的23场研讨会和教程的预热,AAAI 2020也迎来了正式会议,接收的1591篇论文(涵盖160个主题)中有454篇论文以演讲方式进行展示,其余1137篇论文以海报的形式进行展示。

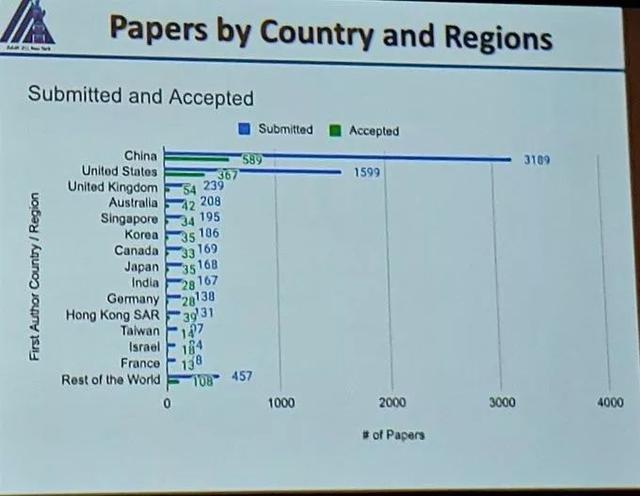

毫不意外的是,中国再次制霸全场,投稿数量多达3189篇,占总投稿数的41%,而第二名的美国投稿数量为2967篇,占总投稿数的37%。

然而从接收率的排名来看,数据似乎不是那么亮眼,来自中国的论文接受率仅为18.4%,不到第一名奥地利(40%)的一半。

从官方显示的数据来看:相较于2019年16.4%(评审数7099,接收数1150)的接收率,本届大会的接收率增长了4.6个百分点,接收文章数目也多了400多篇。

最让小编感到意外的,莫过于投稿的7737篇论文中,有5453(70.5%)篇第一作者来自于学生群体,真是青出于蓝啊!

深度学习三巨头特邀演讲

昨日的重头戏莫过于为时两小时的特别活动:ACM 2018图灵奖获奖者的个人演讲和小组讨论。这可以说是本次组委会送给参会者的超级大福利了!

2019年3月,ACM将Yoshua Bengio (本吉奥),Geoffrey Hinton(辛顿)和Yann LeCun(杨乐昆)三位深度学习之父评为2018年图灵奖获得者。虽然人工神经网络早已作为一种帮助计算机识别模式和模拟人类智能的工具在20世纪80年代被引入,但直到21世纪初,只有杨乐昆、辛顿和本吉奥等一小群人仍然坚持使用这种方法。尽管他们的努力也曾遭到怀疑,但他们的想法最终点燃了人工智能领域对神经网络的兴趣,并最终带来了影响现在和未来的一些重大技术进步。 这也是图灵奖1966年建立以来少有的一年颁奖给三位获奖者的原因,奖金为100万美元。

ACM 表示 Geoffrey E Hinton 主要有三大贡献:反向传播、玻尔兹曼机、对卷积神经网络的修正。

在 1986 年的一篇著名论文《Learning Internal Representations by Error Propagation》中,Hinton 与 David Rumelhart 和 Ronald Williams 提出了反向传播,Hinton 等研究者表示反向传播算法可以帮助神经网络探索数据内部的深层表征,也正是该算法的提出,使得此神经网络能够解决以前被认为无法解决的问题。目前反向传播算法已经成为训练深度神经网络所必需的算法。

1983 年,Hinton 与 Terrence Sejnowski 发明了玻尔兹曼机,这是第一个能够学习不属于输入或输出的神经元内部表征的神经网络。

到了 2012 年,Hinton 与他的学生 Alex Krizhevsky 和 Ilya Sutskever 为卷积神经网络的发展做出了重要贡献。他们利用修正线性神经元(ReLU)和 Dropout 正则化大大提升了深度卷积神经网络的性能。在著名的 ImageNet 竞赛中,Hinton 和他的学生几乎将图像识别的错误率减半,这一次挑战赛的结果直接重塑了计算机视觉领域。

ACM 表示 Yoshua Bengio 主要有三大贡献:序列概率模型、高维词嵌入与注意力模型、生成对抗网络的提出。

在上世纪九十年代,Bengio 提出将神经网络与序列的概率建模相结合,例如隐马尔可夫模型这种序列的概率建模方法。这些观点被 AT&T/NCR用于阅读手写支票的业务上,该系统被认为是九十年代神经网络研究的巅峰之作,目前基于深度学习的语音识别系统都是在这些概念上进行扩展的。

在 2000 年,Bengio 等研究者发表了一篇具有里程碑意义的论文《A Neural Probabilistic Language Model》,该论文引入了高维词嵌入作为词义的表征方法,这对自然语言处理的进展产生了巨大影响,包括机器翻译、知识问答、视觉问答等等。他的研究团队还提出了一种注意力机制,该方法在机器翻译领域取得了重大突破,成为了深度学习序列建模的关键组成部分。

自 2010 年以来,Bengio 非常关注生成深度学习,并与 Ian Goodfellow 等研究者提出了生成对抗网络(GAN),其令人惊奇的地方在于,计算机能生成与原始图像相媲美的图像,这项研究也引起了计算机视觉和计算机图形学的革命。

ACM 表示 Yann LeCun 主要有三大贡献:提出卷积神经网络、改进反向传播算法、拓宽神经网络的视角。

20 世纪 80 年代,LeCun 构建了卷积神经网络,这是该领域的一项重要理论,对于提高深度学习的效率至关重要。在20 世纪 80 年代后期就职于多伦多大学和贝尔实验室的日子里,他利用手写数字图像数据集训练了第一个卷积神经网络系统。如今,卷积神经网络已成为计算机视觉、语音识别、语音合成、图像合成和自然语言处理领域的行业标准。

LeCun 提出了早期版本的反向传播算法(backprop),并基于变分原理给出了清晰的推导,包括两种加速学习时间的简单方法。

LeCun 的贡献还包括拓宽神经网络的研究视角,他将神经网络发展为一种计算模型,并应用到一系列任务中,例如:在图像识别领域,他研究了如何在神经网络中学习分层特征表征,这一概念现在经常用于许多识别任务。他还和 Leon Bottou 一起提出了用在每一个现代深度学习软件中的理念:学习系统可以被构建为复杂的模块网络,在这个网络中,反向传播通过自动微分来执行。

再看看现场慕名而来的粉丝群们!你就能体会到:无敌是多么~多么寂寞!

去不了现场固然可惜,但远程参会看直播录播也不失为一个好选择。隔着屏幕也是可以近距离瞻仰大佬的,只要你的思维能跟上节拍。

直播地址:

https://aaai.org/Conferences/AAAI-20/livestreamed-talks/