Berkeley发布BDD100K:大型的多样化驾驶视频数据集

内容来源:ATYUN AI平台

Berkeley发布了最大,最多样化的驾驶视频数据集,其中包含丰富的BDD100K注释。您现在可以访问bdd-data.berkeley.edu上的数据进行研究。研究者最近发布了arXiv报告。现在仍然有机会参加CVPR 2018挑战。

精彩视频点击链接:Berkeley发布BDD100K:大型的多样化驾驶视频数据集

4个特征:大规模,多样化,驾驶,视频

自动驾驶有望改变每个社区的生活。然而,最近的事件表明,目前还不清楚,当驾驶系统部署在现实世界中时,人造感知系统如何避免看似明显的错误。作为计算机视觉研究人员,我们有兴趣探索自我驾驶的感知算法的前沿,使其更安全。为了设计和测试潜在的算法,研究者希望利用来自真实驾驶平台收集的数据中的所有信息。这些数据具有四个主要特征:大规模,多样化,在街道上捕捉,并具有时间信息。数据多样性对于测试感知算法的鲁棒性特别重要。但是,当前的开放数据集只能覆盖上述属性的一个子集。因此,借助于Nexar,研究者发布BDD100K数据库,这是迄今为止计算机视觉研究中规模最大,最多样化的开放式驾驶视频数据集。该项目由Berkeley DeepDrive Industry Consortium 组织和赞助,该组织负责研究计算机视觉和汽车应用机器学习领域的最新技术。

一个随机视频子集的位置信息

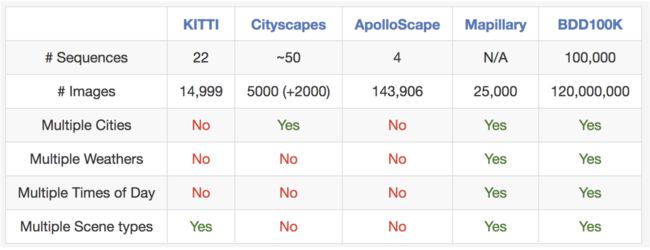

正如名称所示,数据集包含100,000个视频。每个视频长约40秒,720p和30 fps。视频还附带手机记录的GPS / IMU信息,以显示粗糙的驾驶轨迹。视频是从美国不同的地点收集的,如上图所示。数据库涵盖了不同的天气条件,包括晴天,阴天和雨天,包括白天和夜间的不同时间。下表是当前数据集与以前的相比较,这表明我们的数据集更大,更多样化。

与其他街道场景数据集进行比较。很难比较数据集之间的图像,但是把它们列在这里作为一个粗略的参考。

这些视频及其轨迹可用于模仿驾驶政策,正如在CVPR 2017文件中所述的那样。为了便于对大规模数据集进行计算机视觉研究,还提供了关于视频关键帧的基本注释,详见下一节。现在可以在bdd-data.berkeley.edu下载数据和注释。

注释

研究者在每个视频的第10秒采样一个关键帧,并为这些关键帧提供注释。它们被标记在几个层次上:图像标记,道路对象边界框,可驱动区域,车道标记和全帧实例分段。这些注释将帮助我们理解不同类型场景中数据和对象统计的多样性。研究者将在另一篇博文中讨论标签制作流程。有关注释的更多信息可以在arXiv报告中找到。

注释概述

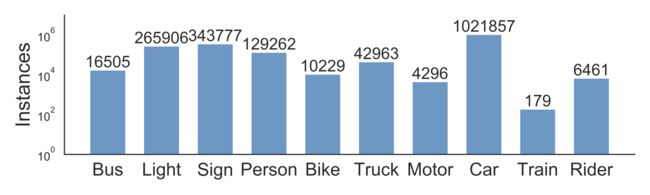

道路物体检测

研究者为所有100,000个关键帧中通常出现在道路上的对象标记对象边界框,以了解对象的分布和位置。下面的条形图显示了对象数量。还有其他方法可以在注释中使用统计信息。例如,我们可以比较不同天气条件或不同类型场景下的物体数量。该图表还显示了数据集中出现的多种对象,以及数据集的规模,即超过100万辆汽车。这些是具有不同外观和情境的独特对象。

不同类型的对象统计

数据集也适用于研究一些特定的领域。例如,如果你对在街道上检测和避开行人感兴趣,也可以来研究我们的数据集,因为它包含比以前的专业数据集更多的行人实例,如下表所示。

与其他关于训练集大小的步行数据集进行比较

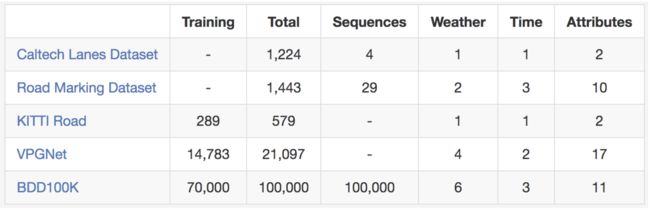

车道标记

车道标记是人类驾驶员重要的道路指示。当GPS或地图没有准确的覆盖时,它们也是自动驾驶系统驾驶方向和本地化的关键线索。根据车道如何指示车辆,我们将车道标记划分为两种类型。垂直车道标记(下图中标记为红色)表示沿车道行驶方向的标记。平行车道标记(下图中以蓝色标记)表示车道中车辆停止的标记。另外还提供了标记的属性,例如实线与虚线、双线与单线。

如果你准备尝试使用自己的车道标记预测算法,就不要再犹豫了。以下是与现有车道标记数据集的比较。

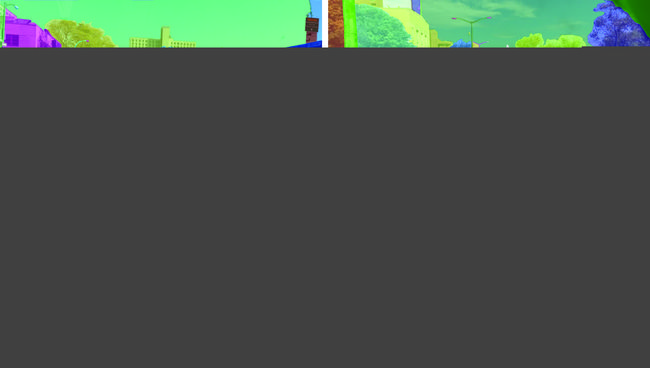

可行驶的区域

我们是否可以在道路上行驶不仅取决于车道标记和交通工具。还取决于与其他共享道路的物体的复杂交互。最后,了解哪个区域可以行驶是很重要的。为了研究这个问题,还提供了可驾驶区域的分段注释,如下所示。根据车辆的轨迹将可驾驶区域分为两类:直接行驶和替代行驶。直接行驶,标记为红色,代表车辆具有道路优先权并且可以继续在该区域驾驶。替代行驶,标记为蓝色,意味着车辆可以在该区域驾驶,但必须谨慎,因为道路优先权可能属于其他车辆。

全帧分割

Cityscapes数据集显示,全帧精细实例分割可以极大促进密集预测和对象检测的研究,这是广泛的计算机视觉应用的支柱。由于我们的视频处于不同的领域,因此我们还提供实例分割注释以便比较不同数据集的域转换。获得完整像素级分割可能是成本高且耗费精力。幸运的是,使用我们自己的标记工具,标记成本可以降低50%。最后,我们用全帧实例分割标记10K图像的一个子集。我们的标记集合与Cityscapes中的训练注释兼容,以便于研究数据集之间的域转换。

驾驶挑战

根据研究者的数据,研究者在CVPR2018自动驾驶研讨会上主持了三项挑战:道路对象检测,可驾驶区域预测和语义分割的域适应。检测任务要求你的算法在研究者的测试图像中查找所有目标对象,而可行驶区域预测需要分割汽车可以驾驶的区域。在域适应中,测试数据是在中国收集。因此要让美国的模型在中国北京拥挤的街道上工作,是极具挑战性的。你可以登录在线提交门户网站后立即提交结果。有兴趣的请查看工具包,开始参与。加入CVPR研讨会挑战有机会得到现金奖励!

未来的工作

自动驾驶汽车的感知系统绝非仅限于单目视频。它还可能包括全景和立体视频以及其他类型的传感器,如LiDAR和雷达。希望在不久的将来能够提供和研究这些多模态传感器数据。

数据集

Berkeley的BDD100K:bdd-data.berkeley.edu/#download-section

Scale和nuTonomy的nuScenes:www.nuscenes.org/download

本文转自ATYUN人工智能媒体平台,原文链接:Berkeley发布BDD100K:大型的多样化驾驶视频数据集

更多推荐

另一种深度学习(下):自我监督学习的生成方法

AI检测学生作业抄袭行为,准确率达90%

深度学习优化颜色以实现伪装或突显主体