最大似然估计及估计量的无偏性

最大似然估计及估计量的无偏性

- 1 数理统计基本概念

-

- 1.1 总体 X X X

- 1.2 简单随机样本

- 1.3 统计量

- 1.4 样本均值与总体均值、样本方差与总体方差

- 2 最大似然估计

-

- 2.1 分布率与概率密度函数

- 2.2 似然函数

- 2.3 最大似然的目的

- 2.4 最大似然求解步骤

- 2.5 最大似然估计的不变性

- 2.6 最大似然估计量的评选标准

-

- 2.6.1 无偏性

- 2.6.2 有效性

- 2.6.3 一致性(相合性)

- 3 一维高斯分布

-

- 3.1 一维高斯分布概率密度函数

- 3.1 一维高斯分布最大似然估计以及检测估计量的无偏性

1 数理统计基本概念

1.1 总体 X X X

总体是指与所研究的问题有关的对象(个体)的全部所构成的集合。在数理统计中,总体就是一个服从某概率分布的随机变量 X X X,其概率分布称为总体分布,其数字特征称之为总体数字特征。

1.2 简单随机样本

样本是按照一定的规则从总体中抽样出来的一部分个体,所谓“按照一定的规则”是指总体中的每一个个体均有同等被抽出的机会。也可以说 N N N个独立且与总体 X X X同分布的随机变量 X 1 , X 2 , ⋯ , X N X_1,X_2,\cdots,X_N X1,X2,⋯,XN为来自总体 X X X的容量为 N N N的简单随机样本,他们的观察值 x 1 , x 2 , ⋯ , x N x_1,x_2,\cdots,x_N x1,x2,⋯,xN称为样本值。也可以将样本看成一个随机变量,写成 ( X 1 , X 2 , ⋯ , X N ) (X_1,X_2,\cdots,X_N) (X1,X2,⋯,XN),此时样本观察值写成 ( x 1 , x 2 , ⋯ , x N ) (x_1,x_2,\cdots,x_N) (x1,x2,⋯,xN)。

【注】样本的性质:

- 样本是独立同分布的;

- 样本 ( X 1 , X 2 , ⋯ , X N ) (X_1,X_2,\cdots,X_N) (X1,X2,⋯,XN)为 N N N维随机变量,在具体的一次观测或实验中,得到样本的一组数值 x 1 , x 2 , ⋯ , x N x_1,x_2,\cdots,x_N x1,x2,⋯,xN,称为样本的观察值或样本值。有时为便于区分,将样本的观察值记为 ( x 1 , x 2 , ⋯ , x N ) (x_1,x_2,\cdots,x_N) (x1,x2,⋯,xN),即可以理解为在抽样之前或理论研究时, ( X 1 , X 2 , ⋯ , X N ) (X_1,X_2,\cdots,X_N) (X1,X2,⋯,XN)为 N N N维随机变量;在抽样之后或实际应用时, ( x 1 , x 2 , ⋯ , x N ) (x_1,x_2,\cdots,x_N) (x1,x2,⋯,xN)为观察值。

1.3 统计量

样本 X 1 , X 2 , ⋯ , X N X_1,X_2,\cdots,X_N X1,X2,⋯,XN的不含总体任何未知参数的函数 g ( X 1 , X 2 , ⋯ , X N ) g(X_1,X_2,\cdots,X_N) g(X1,X2,⋯,XN)称为统计量。

常见的统计量:

样 本 均 值 : X ‾ = 1 N ∑ i = 1 N X i 样本均值:\overline{X}=\frac{1}{N}\sum_{i=1}^{N}X_i 样本均值:X=N1i=1∑NXi 样 本 方 差 : S 2 = 1 N − 1 ∑ i = 1 N ( X i − X ‾ ) 2 = 1 N − 1 ∑ i = 1 N ( X i 2 − N X ‾ ) 样本方差:S^2=\frac{1}{N-1}\sum_{i=1}^{N}(X_i-\overline{X})^2=\frac{1}{N-1}\sum_{i=1}^{N}(X_i^2-N\overline{X}) 样本方差:S2=N−11i=1∑N(Xi−X)2=N−11i=1∑N(Xi2−NX)

1.4 样本均值与总体均值、样本方差与总体方差

在之前的学习中,求均值一般用的都是将所有元素个数相加,然后除以个数,来求平均值。即: X ‾ = 1 N ∑ i = 1 N X i \overline{X}=\frac{1}{N}\sum_{i=1}^{N}X_i X=N1i=1∑NXi 而总体均值,不仅考虑到元素和的平均,还考虑到了该元素值的分布率(即该值出现的概率),更具有统计行。总体均值又被称之为数学期望,记作 E ( X ) = ∑ i = 1 N x i p i E(X)=\sum_{i=1}^{N}x_ip_i E(X)=∑i=1Nxipi。那什么时候样本均值与总体均值相等呢!根据定义我们大概可以等到两种情况下是相等的。

(1)元素值出现的概率都是等可能的,这样考不考虑都一样了。所以在古典概型中,样本均值往往等于总体均值。如:投硬币,置筛子。

(2)在要考虑元素出现概率的情况下,选取样本的个数非常接近以至于等于总体的个数,那么样本均值与总体均值描述的就是一个对象了,这样二者自然就相等了。其实,这一条就是大数定律率的内容(详细请参考概率论与数理统计任何一本即可)。

下面是方差,方差是用来计算变量与均值之间的差异。如果这个均值采用的是总体均值 μ \mu μ(数学期望),则结果为总体方差 σ 2 = 1 N ∑ i = 1 N ( X i − μ ) 2 \sigma^2=\frac{1}{N}\sum_{i=1}^{N}(X_i-\mu)^2 σ2=N1∑i=1N(Xi−μ)2;但是,如果这个均值采用的是样本均值 X ‾ \overline{X} X,样本方差 S 2 = 1 N ∑ i = 1 N ( X i − X ‾ ) 2 S^2=\frac{1}{N}\sum_{i=1}^{N}(X_i-\overline{X})^2 S2=N1∑i=1N(Xi−X)2,样本方差定义成这样是有偏差的,这不是真正的样本方差。为了纠正这个偏量,将样本方差定义为: S 2 = 1 N − 1 ∑ i = 1 N ( X i − X ‾ ) 2 S^2=\frac{1}{N-1}\sum_{i=1}^{N}(X_i-\overline{X})^2 S2=N−11∑i=1N(Xi−X)2,具体为什么样本方差除以 N − 1 N-1 N−1而不是 N N N,下面最大似然求高斯分布估计量的时候会说明。在这里也可以看出,是跟均值有关系,由于样本均值与总体均值的不一致导致的偏差。

2 最大似然估计

极大似然估计方法(Maximum Likelihood Estimate,MLE)也称为最大概似估计或最大似然估计,是求估计的另一种方法,最大概似是1821年首先由德国数学家高斯(C. F. Gauss)提出。

2.1 分布率与概率密度函数

概率分布,是指用于表述随机变量取值的概率规律,即随机变量的可能取值及取得对应值的概率。对于离散性的随机变量的分布率记为 p ( x ) p(x) p(x);连续型随机变量的概率密度函数记为 f ( x ) f(x) f(x),本质上是一个东西,只是一个是离散的一个是连续的。以含有参数的分布率或概率密度为例,形式上表示为: f ( x ; θ ) = p ( x ; θ ) = p ( x , θ ) = p ( x ∣ θ ) f(x;\theta)=p(x;\theta)=p(x,\theta)=p(x|\theta) f(x;θ)=p(x;θ)=p(x,θ)=p(x∣θ),在机器学习中,这些表示都是一个意思,都表示在含有参数 θ \theta θ 的情况下, x x x 的概率。

2.2 似然函数

样本 X 1 , X 2 , … , X N X_1,X_2,\dots,X_N X1,X2,…,XN 取到观察值 x 1 , x 2 , … , x N x_1,x_2,\dots,x_N x1,x2,…,xN 的概率 L ( θ ) L(\theta) L(θ),称为似然函数。

- 若总体 X X X 为离散型,且分布律 P ( X = x ) = p ( x ; θ ) P(X=x)=p(x;\theta) P(X=x)=p(x;θ),则似然函数 L ( θ ) = P ( X 1 = x 1 , X 2 = x 2 , … , X N = x N , ) = ∏ i = 1 N p ( X i = x i ) = ∏ i = 1 N p ( x i ; θ ) L(\theta)=P(X_1=x_1,X_2=x_2,\dots, X_N=x_N,)=\prod_{i=1}^{N}p(X_i=x_i)=\prod_{i=1}^{N}p(x_i;\theta) L(θ)=P(X1=x1,X2=x2,…,XN=xN,)=∏i=1Np(Xi=xi)=∏i=1Np(xi;θ);

- 若总体 X X X 为连续型,且概率密度函数为 f ( x ) = f ( x ; θ ) f(x)=f(x;\theta) f(x)=f(x;θ),由于 P ( x = x i ) = 0 P(x=x_i)=0 P(x=xi)=0,则考虑 X X X 落在点 x i x_i xi 的某一领域 U ( x i ) U(x_i) U(xi) 内的概率, P ( X 1 ∈ U ( x 1 ) , X 2 ∈ U ( x 1 2 ) , … , X N ∈ U ( x N ) ) = f ( x 1 ; θ ) d x 1 f ( x 2 ; θ ) d x 2 … f ( x N ; θ ) d x N = ∏ i = 1 N f ( x i ; θ ) P(X_1 \in U(x_1),X_2 \in U(x_12),\dots,X_N \in U(x_N))=f(x_1;\theta)dx_1 \ f(x_2;\theta)dx_2 \ \dots f(x_N;\theta)dx_N=\prod_{i=1}^{N}f(x_i;\theta) P(X1∈U(x1),X2∈U(x12),…,XN∈U(xN))=f(x1;θ)dx1 f(x2;θ)dx2 …f(xN;θ)dxN=∏i=1Nf(xi;θ),取似然函数 L ( θ ) = ∏ i = 1 N f ( x i ; θ ) L(\theta)=\prod_{i=1}^{N}f(x_i;\theta) L(θ)=∏i=1Nf(xi;θ)

2.3 最大似然的目的

在位置参数 θ \theta θ 的取值范围内求 θ ^ \hat{\theta} θ^,使 L ( θ ^ ) = m a x L ( θ ) L(\hat{\theta})=maxL(\theta) L(θ^)=maxL(θ),即 θ \theta θ 的最大似然估计 θ ^ \hat{\theta} θ^ 为似然估计 L ( θ ) L(\theta) L(θ) 的最大值点。

2.4 最大似然求解步骤

第一步:写出似然函数 L ( θ ) L(\theta) L(θ),并取对数 l o g log log,对数可以以 2 2 2 为底也可以以 e e e为 底;

第二步:令 d l o g L ( θ ) d θ = 0 \frac{dlogL(\theta)}{d\theta}=0 dθdlogL(θ)=0 或 ∂ l o g L ( θ 1 , θ 2 ) ∂ θ i = 0 ( i = 1 , 2 ) \frac{\partial logL(\theta_1,\theta_2)}{\partial \theta_i}=0(i=1,2) ∂θi∂logL(θ1,θ2)=0(i=1,2),建立方程(组)。若从中解的唯一驻点 θ ^ = θ ^ ( X 1 , X 2 , … , X N ) \hat{\theta}=\hat{\theta}(X_1,X_2,\dots,X_N) θ^=θ^(X1,X2,…,XN) 或 θ ^ = ( θ ^ 1 , θ ^ 2 ) = ( θ ^ 1 ( X 1 , X 2 , … , X N ) , θ ^ 2 ( X 1 , X 2 , … , X N ) ) \hat{\theta}=(\hat{\theta}_1,\hat{\theta}_2)=(\hat{\theta}_1(X_1,X_2,\dots,X_N),\hat{\theta}_2(X_1,X_2,\dots,X_N)) θ^=(θ^1,θ^2)=(θ^1(X1,X2,…,XN),θ^2(X1,X2,…,XN)),则 θ ^ \hat{\theta} θ^为 θ \theta θ 的最大似然估计;

第三步:若上述方程无解,则 L ( θ ) L(\theta) L(θ) 为 θ \theta θ 或 θ 1 , θ 2 \theta_1,\theta_2 θ1,θ2 的单调函数, θ ^ \hat{\theta} θ^ 在端点或边界上取得,需要根据具体情况具体分析。

2.5 最大似然估计的不变性

设 θ ^ \hat{\theta} θ^ 是未知参数 θ \theta θ 的最大似然估计量,对于 θ \theta θ 的函数 g ( θ ) g(\theta) g(θ),如果 g ( θ ) g(\theta) g(θ) 具有单值反函数,则 g ( θ ^ ) g(\hat{\theta}) g(θ^) 是 g ( θ ) g(\theta) g(θ) 的最大似然估计量。例如,均值位置的正太总体 N ( μ , σ 2 ) N(\mu,\sigma^2) N(μ,σ2) 的方差 σ 2 \sigma^2 σ2 的最大似然估计量为 σ ^ 2 = 1 N ∑ i = 1 N ( X i − X ‾ ) 2 \hat{\sigma}^2=\frac{1}{N}\sum_{i=1}^{N}(X_i-\overline{X})^2 σ^2=N1∑i=1N(Xi−X)2,则总体标准差 σ \sigma σ 的最大似然估计为 σ = 1 N ∑ i = 1 N ( X i − X ‾ ) 2 \sigma=\sqrt{\frac{1}{N}\sum_{i=1}^{N}(X_i-\overline{X})^2} σ=N1∑i=1N(Xi−X)2。

2.6 最大似然估计量的评选标准

2.6.1 无偏性

设 θ ^ \hat{\theta} θ^ 为 θ \theta θ 的估计量,若 E ( θ ^ ) = θ E(\hat{\theta})=\theta E(θ^)=θ,就称 θ ^ \hat{\theta} θ^为 θ \theta θ的无偏估计,否则称为有偏估计。若 lim N → ∞ E ( θ ^ ) = θ \mathop{\lim}_{N \to \infty }E(\hat{\theta})=\theta limN→∞E(θ^)=θ,就称 θ ^ \hat{\theta} θ^为 θ \theta θ的渐近无偏估计。

常用结论:

- X ‾ \overline{X} X是 E ( X ) = μ E(X)=\mu E(X)=μ的无偏估计,即 E ( X ‾ ) = E ( X ) = μ E(\overline{X})=E(X)=\mu E(X)=E(X)=μ;

- S 2 S^2 S2是 D ( X ) = σ 2 D(X)=\sigma^2 D(X)=σ2的无偏估计,即 E ( S 2 ) = D ( X ) = σ 2 E(S^2)=D(X)=\sigma^2 E(S2)=D(X)=σ2;

- 设估计量 θ ^ 1 , θ ^ 2 , ⋯ , θ ^ N , \hat{\theta}_1,\hat{\theta}_2,\cdots,\hat{\theta}_N, θ^1,θ^2,⋯,θ^N,均为 θ \theta θ的无偏估计量, c 1 , c 2 , ⋯ , c N c_1,c_2,\cdots,c_N c1,c2,⋯,cN为常数,且 ∑ i = 1 N c i = 1 \sum_{i=1}^{N}c_i=1 ∑i=1Nci=1,则 c 1 θ ^ 1 , c 2 θ ^ 2 , ⋯ , c N θ ^ N c_1\hat{\theta}_1,c_2\hat{\theta}_2,\cdots,c_N\hat{\theta}_N c1θ^1,c2θ^2,⋯,cNθ^N仍为 θ \theta θ的无偏估计。

【注】若 θ ^ \hat{\theta} θ^为 θ \theta θ的无偏估计,则 g ( θ ^ ) g(\hat{\theta}) g(θ^)未必是 g ( θ ) g(\theta) g(θ)的无偏估计。

2.6.2 有效性

设 θ ^ 1 , θ ^ 2 \hat{\theta}_1,\hat{\theta}_2 θ^1,θ^2均为 θ \theta θ的无偏估计,若 D ( θ ^ 1 ) < D ( θ ^ 2 ) D(\hat{\theta}_1)

2.6.3 一致性(相合性)

若对 ∀ ε > 0 \forall\varepsilon>0 ∀ε>0,有 lim N → ∞ P { ∣ θ ^ − θ ∣ < ε } = 1 \mathop{\lim}_{N \to \infty }P\left\{|\hat{\theta}-\theta|<\varepsilon \right \}=1 limN→∞P{ ∣θ^−θ∣<ε}=1,就称 θ ^ \hat{\theta} θ^为 θ \theta θ的一致估计量或相合估计量。

3 一维高斯分布

3.1 一维高斯分布概率密度函数

一维高斯分布(正态分布)函数: f ( x ∣ μ , σ ) = 1 2 π σ e − ( x − μ ) 2 2 σ 2 f(x| \ \mu,\sigma)=\frac{1}{\sqrt{2\pi}\sigma}e^{-\frac{(x-\mu)^2}{2\sigma^2}} f(x∣ μ,σ)=2πσ1e−2σ2(x−μ)2 或者这种写法 f ( x ∣ μ , σ ) = 1 2 π σ e x p { − ( x − μ ) 2 2 σ 2 } f(x | \ \mu,\sigma)=\frac{1}{\sqrt{2\pi}\sigma}exp\left\{-\frac{(x-\mu)^2}{2\sigma^2}\right\} f(x∣ μ,σ)=2πσ1exp{ −2σ2(x−μ)2}

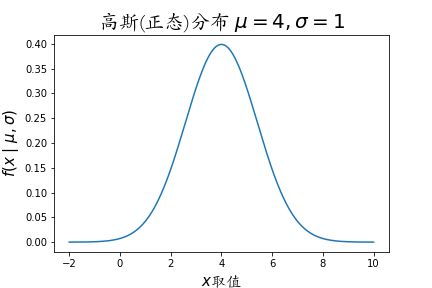

高斯分布图像,以 μ = 4 , σ = 1 \mu=4,\sigma=1 μ=4,σ=1 为例:

3.1 一维高斯分布最大似然估计以及检测估计量的无偏性

题目 :设总体 X ∼ N ( μ , σ 2 ) , ( X 1 , X 2 , ⋯ , X N ) X\sim N(\mu,\sigma^2), \ (X_1,X_2,\cdots,X_N) X∼N(μ,σ2), (X1,X2,⋯,XN)为来自总体 X X X的样本。

(1)如果 σ 2 \sigma^2 σ2已知, μ \mu μ未知,求 μ \mu μ的最大似然估计量 μ ^ \hat{\mu} μ^。

(2)如果 μ \mu μ已知, σ 2 \sigma^2 σ2未知,求 σ 2 \sigma^2 σ2的最大似然估计量 σ ^ 2 \hat{\sigma}^2 σ^2。

(3)如果 μ \mu μ, σ 2 \sigma^2 σ2均未知,求 μ \mu μ, σ 2 \sigma^2 σ2的最f大似然估计量 μ ^ \hat{\mu} μ^, σ ^ 2 \hat{\sigma}^2 σ^2。

分析:

样本数据 D a t a : Data: Data: X = ( x 1 , x 2 , ⋯ , x N ) = ( x 1 p x 2 p ⋮ x N p ) N × p , x i ∈ R p , x i ∼ i i d N ( μ , σ 2 ) X = \begin{pmatrix} x_1,x_2,\cdots,x_N \end{pmatrix} =\begin{pmatrix} x_1^p \\x_2^p \\ \vdots \\ x_N^p \end{pmatrix}_{N\times p}, \ \ \ x_i \in \mathbb{R}^p, \ \ \ x_i \overset{iid}{\sim}N(\mu,\sigma^2) X=(x1,x2,⋯,xN)=⎝⎜⎜⎜⎛x1px2p⋮xNp⎠⎟⎟⎟⎞N×p, xi∈Rp, xi∼iidN(μ,σ2) 目标函数 G o a l : Goal: Goal: 求最大似然估计。为了方便表示函数,用参数 θ \theta θ 表示参数 ( μ , σ ) (\mu,\sigma) (μ,σ) M L E : θ ^ = a r g m a x θ l n L ( X ∣ μ , σ ) MLE:\hat{\theta}=arg \ \underset{\theta}{max} \ lnL(X| \ \mu,\sigma) MLE:θ^=arg θmax lnL(X∣ μ,σ) 【注】因为高斯分布的概率密度中有以 e e e 为底的指数函数,为了方便计算。所以这里的对数似然函数选取以 e e e 为底的 l n ln ln。

解:

(1)设 x 1 , x 2 , ⋯ , x N x_1,x_2,\cdots,x_N x1,x2,⋯,xN为样本的观测值,由于 σ 2 \sigma^2 σ2已知, μ \mu μ未知,似然函数为: L ( X ∣ μ ) = ∏ i = 1 N p ( x i ∣ μ ) = ∏ i = 1 N 1 2 π σ e x p { − ( x i − μ ) 2 2 σ 2 } \begin{aligned} L(X|\mu) &= \prod_{i=1}^{N}p(x_i|\mu) \\ &= \prod_{i=1}^{N}\frac{1}{\sqrt{2\pi}\sigma} exp \left\{ -\frac{(x_i-\mu)^2}{2\sigma^2} \right\} \end{aligned} L(X∣μ)=i=1∏Np(xi∣μ)=i=1∏N2πσ1exp{ −2σ2(xi−μ)2} 似然函数取对数: l n L ( X ∣ μ ) = l n ∏ i = 1 N p ( x i ∣ μ ) = l n ∏ i = 1 N 1 2 π σ e x p { − ( x i − μ ) 2 2 σ 2 } = − N 2 l n ( 2 π ) − N l n σ − 1 2 σ 2 ∑ i = 1 N ( x i − μ ) 2 \begin{aligned} lnL(X|\mu) &= ln\prod_{i=1}^{N}p(x_i|\mu) \\ &= ln\prod_{i=1}^{N}\frac{1}{\sqrt{2\pi}\sigma} exp \left\{ -\frac{(x_i-\mu)^2}{2\sigma^2}\right\} \\&=-\frac{N}{2}ln(2\pi)-Nln\sigma-\frac{1}{2\sigma^2}\sum_{i=1}^{N}(x_i-\mu)^2 \end{aligned} lnL(X∣μ)=lni=1∏Np(xi∣μ)=lni=1∏N2πσ1exp{ −2σ2(xi−μ)2}=−2Nln(2π)−Nlnσ−2σ21i=1∑N(xi−μ)2 对数似然取导数: d l n L ( X ∣ μ ) d μ = ∑ i = 1 N 1 σ 2 ( x i − μ ) = 0 \frac{dlnL(X|\mu)}{d\mu}=\sum_{i=1}^{N}\frac{1}{\sigma^2}(x_i-\mu)=0 dμdlnL(X∣μ)=i=1∑Nσ21(xi−μ)=0 ∑ i = 1 N ( x i − μ ) = 0 \sum_{i=1}^{N}(x_i-\mu)=0 i=1∑N(xi−μ)=0 ∑ i = 1 N x i − N μ = 0 \sum_{i=1}^{N}x_i-N\mu=0 i=1∑Nxi−Nμ=0 μ ^ = 1 N ∑ i = 1 N X i = X ‾ ( 发 现 结 果 为 样 本 均 值 ) \hat{\mu}=\frac{1}{N}\sum_{i=1}^{N}X_i=\overline{X}(发现结果为样本均值) μ^=N1i=1∑NXi=X(发现结果为样本均值) 从结果中可以看出, μ \mu μ的最大似然估计量,只受样本值的影响。从定义的角度证明: E [ μ ^ ] = E [ 1 N ∑ i = 1 N X i ] = 1 N ∑ i = 1 N E [ X i ] = 1 N N μ = μ E[\hat{\mu}]=E[\frac{1}{N}\sum_{i=1}^{N}X_i]=\frac{1}{N}\sum_{i=1}^{N}E[X_i]=\frac{1}{N}N\mu=\mu E[μ^]=E[N1i=1∑NXi]=N1i=1∑NE[Xi]=N1Nμ=μ即, μ ^ \hat{\mu} μ^为 μ \mu μ的无偏估计量。

(2)设 x 1 , x 2 , ⋯ , x N x_1,x_2,\cdots,x_N x1,x2,⋯,xN为样本的观测值,由于 μ \mu μ已知, σ 2 \sigma^2 σ2未知,似然函数为: L ( X ∣ σ 2 ) = ∏ i = 1 N p ( x i ∣ σ 2 ) = ∏ i = 1 N 1 2 π σ e x p { − ( x i − μ ) 2 2 σ 2 } \begin{aligned} L(X|\sigma^2) &= \prod_{i=1}^{N}p(x_i|\sigma^2) \\ &= \prod_{i=1}^{N}\frac{1}{\sqrt{2\pi}\sigma} exp \left\{ -\frac{(x_i-\mu)^2}{2\sigma^2}\right\}\end{aligned} L(X∣σ2)=i=1∏Np(xi∣σ2)=i=1∏N2πσ1exp{ −2σ2(xi−μ)2} 似然函数取对数: l n L ( X ∣ σ 2 ) = l n ∏ i = 1 N p ( x i ∣ σ 2 ) = l n ∏ i = 1 N 1 2 π σ e x p { − ( x i − μ ) 2 2 σ 2 } = − N 2 l n ( 2 π ) − N 2 l n ( σ 2 ) − 1 2 σ 2 ∑ i = 1 N ( x i − μ ) 2 \begin{aligned} lnL(X|\sigma^2) &= ln\prod_{i=1}^{N}p(x_i|\sigma^2) \\ &= ln\prod_{i=1}^{N}\frac{1}{\sqrt{2\pi}\sigma} exp \left\{ -\frac{(x_i-\mu)^2}{2\sigma^2}\right\} \\&=-\frac{N}{2}ln(2\pi)-\frac{N}{2}ln(\sigma^2)-\frac{1}{2\sigma^2}\sum_{i=1}^{N}(x_i-\mu)^2 \end{aligned} lnL(X∣σ2)=lni=1∏Np(xi∣σ2)=lni=1∏N2πσ1exp{ −2σ2(xi−μ)2}=−2Nln(2π)−2Nln(σ2)−2σ21i=1∑N(xi−μ)2 对数似然取导数: d l n L ( X ∣ σ 2 ) d σ 2 = ∑ i = 1 N 1 σ 2 ( x i − μ ) = 0 \frac{dlnL(X|\sigma^2)}{d\sigma^2}= \sum_{i=1}^{N}\frac{1}{\sigma^2}(x_i-\mu)=0 dσ2dlnL(X∣σ2)=i=1∑Nσ21(xi−μ)=0 − N 2 σ 2 + 1 2 σ 4 ∑ i = 1 N ( x i − μ ) 2 = 0 -\frac{N}{2\sigma^2}+\frac{1}{2\sigma^4}\sum_{i=1}^{N}(x_i-\mu)^2 =0 −2σ2N+2σ41i=1∑N(xi−μ)2=0 σ ^ 2 = 1 N ∑ i = 1 N ( X i − μ ) 2 \hat{\sigma}^2=\frac{1}{N}\sum_{i=1}^{N}(X_i-\mu)^2 σ^2=N1i=1∑N(Xi−μ)2 从结果中可以看出, σ ^ 2 \hat{\sigma}^2 σ^2受到样本值以及均值 μ \mu μ的影响,但是题目中已经说明, μ \mu μ是已知条件,所以这里的 μ \mu μ就是已知的总体均值,所以本质上 σ ^ 2 \hat{\sigma}^2 σ^2也仅受样本值的影响。从定义的角度证明: E [ σ ^ 2 ] = E [ 1 N ∑ i = 1 N ( X i − μ ) 2 ] = E [ 1 N ∑ i = 1 N X i 2 − 1 N ∑ i = 1 N 2 X i μ + 1 N ∑ i = 1 N μ 2 ] = E [ 1 N ∑ i = 1 N X i 2 − 2 μ 2 + μ 2 ] = E [ ( 1 N ∑ i = 1 N X i 2 − μ 2 ) ] = 1 N ∑ i = 1 N ( E ( X i 2 ) − E 2 ( X i ) ) = D ( X i ) = σ 2 \begin{aligned} E[\hat{\sigma}^2] &=E[\frac{1}{N}\sum_{i=1}^{N}(X_i-\mu)^2]\\&=E[\frac{1}{N}\sum_{i=1}^{N}X_i^2-\frac{1}{N}\sum_{i=1}^{N}2X_i\mu+\frac{1}{N}\sum_{i=1}^{N}\mu^2]\\&=E[\frac{1}{N}\sum_{i=1}^{N}X_i^2-2\mu^2+\mu^2]\\&=E[(\frac{1}{N}\sum_{i=1}^{N}X_i^2-\mu^2)]\\&=\frac{1}{N}\sum_{i=1}^{N}(E(X_i^2)-E^2(X_i))\\&= D(X_i)\\&=\sigma^2\\ \end{aligned} E[σ^2]=E[N1i=1∑N(Xi−μ)2]=E[N1i=1∑NXi2−N1i=1∑N2Xiμ+N1i=1∑Nμ2]=E[N1i=1∑NXi2−2μ2+μ2]=E[(N1i=1∑NXi2−μ2)]=N1i=1∑N(E(Xi2)−E2(Xi))=D(Xi)=σ2 即 σ ^ 2 \hat{\sigma}^2 σ^2为 σ 2 \sigma^2 σ2的无偏估计。

(3)设 x 1 , x 2 , ⋯ , x N x_1,x_2,\cdots,x_N x1,x2,⋯,xN为样本的观值, μ \mu μ, σ 2 \sigma^2 σ2均未知,似然函数为: L ( X ∣ μ , σ 2 ) = ∏ i = 1 N p ( x i ∣ μ , σ 2 ) = ∏ i = 1 N 1 2 π σ e x p { − ( x i − μ ) 2 2 σ 2 } \begin{aligned} L(X|\mu,\sigma^2) &= \prod_{i=1}^{N}p(x_i| \mu,\sigma^2) \\ &= \prod_{i=1}^{N}\frac{1}{\sqrt{2\pi}\sigma} exp \left\{ -\frac{(x_i-\mu)^2}{2\sigma^2}\right\}\end{aligned} L(X∣μ,σ2)=i=1∏Np(xi∣μ,σ2)=i=1∏N2πσ1exp{ −2σ2(xi−μ)2} 似然函数取对数: l n L ( X ∣ μ , σ 2 ) = l n ∏ i = 1 N p ( x i ∣ σ 2 ) = l n ∏ i = 1 N 1 2 π σ e x p { − ( x i − μ ) 2 2 σ 2 } = − N 2 l n ( 2 π ) − N 2 l n ( σ 2 ) − 1 2 σ 2 ∑ i = 1 N ( x i − μ ) 2 \begin{aligned} lnL(X|\mu,\sigma^2) &= ln\prod_{i=1}^{N}p(x_i|\sigma^2) \\ &= ln\prod_{i=1}^{N}\frac{1}{\sqrt{2\pi}\sigma} exp \left\{ -\frac{(x_i-\mu)^2}{2\sigma^2}\right\} \\&=-\frac{N}{2}ln(2\pi)-\frac{N}{2}ln(\sigma^2)-\frac{1}{2\sigma^2}\sum_{i=1}^{N}(x_i-\mu)^2 \end{aligned} lnL(X∣μ,σ2)=lni=1∏Np(xi∣σ2)=lni=1∏N2πσ1exp{ −2σ2(xi−μ)2}=−2Nln(2π)−2Nln(σ2)−2σ21i=1∑N(xi−μ)2 分别对 μ \mu μ与 σ 2 \sigma^2 σ2取偏导: ∂ l n L ( X ∣ μ , σ 2 ) ∂ μ = ∑ i = 1 N 1 σ 2 ( x i − μ ) = 0 \frac{\partial lnL(X|\mu,\sigma^2)}{\partial \mu}=\sum_{i=1}^{N}\frac{1}{\sigma^2}(x_i-\mu)=0 ∂μ∂lnL(X∣μ,σ2)=i=1∑Nσ21(xi−μ)=0 ∑ i = 1 N ( x i − μ ) = 0 \sum_{i=1}^{N}(x_i-\mu)=0 i=1∑N(xi−μ)=0 μ ^ = 1 N ∑ i = 1 N X i = X ‾ \hat{\mu}=\frac{1}{N}\sum_{i=1}^{N}X_i=\overline{X} μ^=N1i=1∑NXi=X ∂ l n L ( X ∣ μ , σ 2 ) ∂ σ 2 = − N 2 σ 2 + 1 2 σ 4 ∑ i = 1 N ( x i − μ ) 2 = 0 \frac{\partial lnL(X|\mu,\sigma^2)}{\partial \sigma^2}=-\frac{N}{2\sigma^2}+\frac{1}{2\sigma^4}\sum_{i=1}^{N}(x_i-\mu)^2 =0 ∂σ2∂lnL(X∣μ,σ2)=−2σ2N+2σ41i=1∑N(xi−μ)2=0 − N + 1 σ 2 ∑ i = 1 N ( x i − μ ) 2 = 0 -N+\frac{1}{\sigma^2}\sum_{i=1}^{N}(x_i-\mu)^2 =0 −N+σ21i=1∑N(xi−μ)2=0 σ ^ 2 = 1 N ∑ i = 1 N ( X i − μ ^ ) 2 = 1 N ∑ i = 1 N ( X i − X ‾ ) 2 \hat{\sigma}^2=\frac{1}{N}\sum_{i=1}^{N}(X_i-\hat{\mu})^2=\frac{1}{N}\sum_{i=1}^{N}(X_i-\overline{X})^2 σ^2=N1i=1∑N(Xi−μ^)2=N1i=1∑N(Xi−X)2

在下面的无偏性检验中,可以发现 μ ^ \hat{\mu} μ^为无偏性估计,而 σ ^ 2 \hat{\sigma}^2 σ^2为有偏性估计。因为求高斯分布时,参数 μ , σ 2 \mu,\sigma^2 μ,σ2都是未知的,而求 μ ^ \hat{\mu} μ^时,不需要依赖未知参数 σ 2 \sigma^2 σ2(计算时被约去了);而计算 σ ^ 2 \hat{\sigma}^2 σ^2时,需要依赖 μ \mu μ,但是 μ \mu μ也未知,所以只能用已计算出来的 μ ^ \hat{\mu} μ^代替,而不是真正的总体均值 μ \mu μ,这就是有偏的原因。根据定义证明:

(a)检测估计量 μ ^ \hat{\mu} μ^的无偏性 E [ μ ^ ] = E [ X ‾ ] = E [ 1 N ∑ i = 1 N X i ] = 1 N ∑ i = 1 N E [ X i ] = 1 N N μ = μ E[\hat{\mu}]=E[\overline{X}]=E[\frac{1}{N}\sum_{i=1}^{N}X_i]=\frac{1}{N}\sum_{i=1}^{N}E[X_i]=\frac{1}{N}N\mu=\mu E[μ^]=E[X]=E[N1i=1∑NXi]=N1i=1∑NE[Xi]=N1Nμ=μ 即 μ ^ \hat{\mu} μ^为 μ \mu μ的无偏估计。

(b)检测估计量 σ 2 ^ \hat{\sigma^2} σ2^的无偏估计,且需要明确一些条件: 估 计 量 μ ^ 的 方 差 : D ( μ ^ ) = D ( X ‾ ) = D ( 1 N ∑ i = 1 N X i ) = 1 N 2 ∑ i = 1 N D ( X i ) = 1 N 2 N σ 2 = σ 2 N 估计量\hat{\mu}的方差: D(\hat{\mu})=D(\overline{X})=D(\frac{1}{N}\sum_{i=1}^{N}X_i)=\frac{1}{N^2}\sum_{i=1}^{N}D(X_i)=\frac{1}{N^2}N\sigma^2=\frac{\sigma^2}{N} 估计量μ^的方差:D(μ^)=D(X)=D(N1i=1∑NXi)=N21i=1∑ND(Xi)=N21Nσ2=Nσ2 总 体 方 差 : D ( X i ) = σ 2 = 1 N ∑ i = 1 N ( X i − μ ) 2 总体方差:D(X_i)=\sigma^2=\frac{1}{N}\sum_{i=1}^{N}(X_i-\mu)^2 总体方差:D(Xi)=σ2=N1i=1∑N(Xi−μ)2 E [ σ ^ 2 ] = E [ 1 N ∑ i = 1 N ( X i − X ‾ ) 2 ] = E [ 1 N ∑ i = 1 N X i 2 − 1 N ∑ i = 1 N 2 X i X ‾ + 1 N ∑ i = 1 N X ‾ 2 ] = E [ 1 N ∑ i = 1 N X i 2 − 2 X ‾ 2 + X ‾ 2 ] = E [ ( 1 N ∑ i = 1 N X i 2 − μ 2 ) − ( X ‾ 2 − μ 2 ) ] = E [ 1 N ∑ i = 1 N ( X i 2 − μ 2 ) ] − E ( X ‾ 2 − μ 2 ) = 1 N ∑ i = 1 N ( E ( X i 2 ) − E 2 ( X i ) ) − ( E ( X ‾ 2 ) − E 2 ( X ‾ ) ) = D ( X i ) − D ( X ‾ ) = σ 2 − σ 2 N = N − 1 N σ 2 \begin{aligned} E[\hat{\sigma}^2] &=E[\frac{1}{N}\sum_{i=1}^{N}(X_i-\overline{X})^2]\\&=E[\frac{1}{N}\sum_{i=1}^{N}X_i^2-\frac{1}{N}\sum_{i=1}^{N}2X_i\overline{X}+\frac{1}{N}\sum_{i=1}^{N}\overline{X}^2]\\&=E[\frac{1}{N}\sum_{i=1}^{N}X_i^2-2\overline{X}^2+\overline{X}^2]\\&=E[(\frac{1}{N}\sum_{i=1}^{N}X_i^2-\mu^2)-(\overline{X}^2-\mu^2)]\\&=E[\frac{1}{N}\sum_{i=1}^{N}(X_i^2-\mu^2)] -E(\overline{X}^2-\mu^2)\\&=\frac{1}{N}\sum_{i=1}^{N}(E(X_i^2)-E^2(X_i))-(E(\overline{X}^2)-E^2(\overline{X}))\\&= D(X_i)-D(\overline{X}) \\&=\sigma^2-\frac{\sigma^2}{N}\\&=\frac{N-1}{N}\sigma^2 \end{aligned} E[σ^2]=E[N1i=1∑N(Xi−X)2]=E[N1i=1∑NXi2−N1i=1∑N2XiX+N1i=1∑NX2]=E[N1i=1∑NXi2−2X2+X2]=E[(N1i=1∑NXi2−μ2)−(X2−μ2)]=E[N1i=1∑N(Xi2−μ2)]−E(X2−μ2)=N1i=1∑N(E(Xi2)−E2(Xi))−(E(X2)−E2(X))=D(Xi)−D(X)=σ2−Nσ2=NN−1σ2 显然,所求结果 E ( σ ^ 2 ) E(\hat{\sigma}^2) E(σ^2)不等于 σ 2 \sigma^2 σ2, σ ^ 2 \hat{\sigma}^2 σ^2为有偏估计,既然有偏就需要纠偏,样本的方差该如何表示呢?根据结果,看出偏移的部分是系数 N − 1 N \frac{N-1}{N} NN−1,那就在原方程的基础上乘以系数的倒数 N N − 1 \frac{N}{N-1} N−1N,将系数部分抵消掉,这样结果就只剩 σ 2 \sigma^2 σ2了,就是无偏估计了。则无偏的样本方差 S 2 S^2 S2定义为: S 2 = N N − 1 1 N ∑ i = 1 N ( X i − X ‾ ) 2 = 1 N − 1 ∑ i = 1 N ( X i − X ‾ ) 2 = 1 N − 1 ∑ i = 1 N ( X i 2 − N X ‾ ) S^2=\frac{N}{N-1}\frac{1}{N}\sum_{i=1}^{N}(X_i-\overline{X})^2=\frac{1}{N-1}\sum_{i=1}^{N}(X_i-\overline{X})^2=\frac{1}{N-1}\sum_{i=1}^{N}(X_i^2-N\overline{X}) S2=N−1NN1i=1∑N(Xi−X)2=N−11i=1∑N(Xi−X)2=N−11i=1∑N(Xi2−NX)

参考:浙大版概率论与数理统计