Hive安装

一、简介

hive是用类SQL语句(HiveQL)来实现对hadoop下的数据管理。hive属于数据仓库的范畴,那么,数据库和数据仓库到底有什么区别了,这里简单说明一下:数据库侧重于OLTP(在线事务处理),数据仓库侧重OLAP(在线分析处理);也就是说,例如mysql类的数据库更侧重于短时间内的数据处理,反之。

无hive:使用者…->mapreduce…->hadoop数据(可能需要会mapreduce)

有hive:使用者…->HQL(SQL)->hive…->mapreduce…->hadoop数据(只需要会SQL语句)

二、安装

Centos7基于Hadoop2.7.5安装hive2.3.4

1.解压,重命名

tar -zxvf apache-hive-2.3.4-bin.tar.gz -C /usr/local/

mv apache-hive-2.1.1-bin hive

2.添加环境变量

export HIVE_HOME=/usr/local/hive

export PATH=$PATH:$HIVE_HOME/bin

hive --version

有hive的版本显现,安装成功!

三、配置

1.修改hive-site.xml:

这里没有,从模板里复制一个

cd /usr/local/hive/conf/

cp hive-default.xml.template hive-site.xml

vim hive-site.xml

在10行左右的位置添加如下内容(注意删掉后面的汉字部分,同时注意mysql的用户名和密码填写正确)

javax.jdo.option.ConnectionUserName 用户名(这4是新添加的,记住删除配置文件原有的哦!)

root

javax.jdo.option.ConnectionPassword 密码

root

javax.jdo.option.ConnectionURL mysql

jdbc:mysql://192.168.1.68:3306/hive

javax.jdo.option.ConnectionDriverName mysql驱动程序

com.mysql.jdbc.Driver

javax.jdo.option.ConnectionURL

jdbc:mysql://10.4.20.136:3306/hive?createDatabaseIfNotExist=true

javax.jdo.option.ConnectionDriverName

com.mysql.jdbc.Driver

javax.jdo.option.ConnectionUserName

root

javax.jdo.option.ConnectionPassword

root

hive.metastore.schema.verification

false

datanucleus.schema.autoCreateAll

true

2.在hive 配置文件hive-site.xml 中找到${system:java.io.tmpdir},并把此都替换成具体目录,如/home/spark/app/hive 不然会在启动hive时出现如下错误

3.修改hive-env.sh,同样没有,需要从模板里复制

cp hive-env.sh.template hive-env.sh

vi hive-env.sh

添加如下内容

HADOOP_HOME=/home/spark/app/hadoop

export HIVE_CONF_DIR=/home/spark/app/hive/conf

4.复制mysql的java驱动程序到hive/lib下面

四、配置mysql允许hive连接

默认情况下,Hive元数据保存在内嵌的Derby数据库中,只能允许一个会话连接,只适合简单的测试。实际生产环境中不使用,为了支持多用户会话,则需要一个独立的元数据库,使用MySQL作为元数据库,Hive内部对MySQL提供了很好的支持。

新建hive数据库,用来保存hive的元数据。

mysql -u user -p

passward

mysql> create database hive;

将hive数据库下的所有表的所有权限赋给某个新建用户(Mysqltohive),并配密码(Mysql@123)为hive-site.xml中的连接密码,然后刷新系统权限关系表

mysql> CREATE USER 'Mysqltohive'@'%' IDENTIFIED BY 'Mysql@123';

mysql> GRANT ALL PRIVILEGES ON *.* TO 'Mysqltohive'@'%' WITH GRANT OPTION;

mysql> flush privileges;

五、启动并测试

运行hive之前首先要确保meta store服务已经启动,

nohup hive --service metastore > metastore.log 2>&1 &

如果需要用到远程客户端(比如 Tableau)连接到hive数据库,还需要启动hive service

nohup hive --service hiveserver2 > hiveserver2.log 2>&1 &

远程连接的端口号为10000

netstat -antpl|grep 10000

(Not all processes could be identified, non-owned process info

will not be shown, you would have to be root to see it all.)

tcp 0 0 0.0.0.0:10000 0.0.0.0:* LISTEN 25467/java

在/hive/conf/目录下初始化元数据

schematool -dbType mysql -initSchema

进入hive并创建测试库和测试表

hive

hive> create database hive_01;

OK

Time taken: 1.432 seconds

hive> use hive_01;

hive> create table hive_010 (id int,name string);

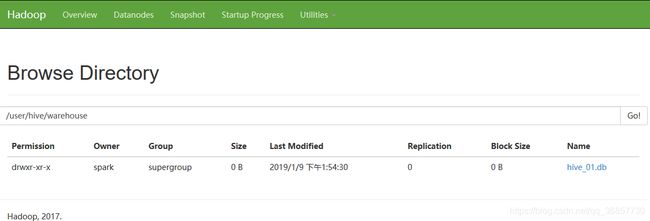

hdfs下出现刚建的hive测试表

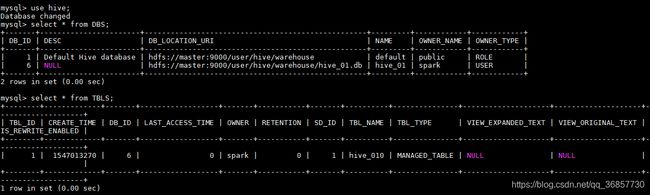

同时可以从mysql中看到新建的表

同时可以从mysql中看到新建的表

通过navicat连接mysql数据库,内部有个数据库名字叫hive,hive内有很多默认的表,其中DBS表列出了目前hive有的数据库,TBLS表列出了hive中所有的表信息。

通过navicat连接mysql数据库,内部有个数据库名字叫hive,hive内有很多默认的表,其中DBS表列出了目前hive有的数据库,TBLS表列出了hive中所有的表信息。