《因果科学周刊》第5期:OOD 泛化

为了帮助大家更好地了解因果科学的最新科研进展和资讯,我们因果科学社区团队本周整理了第5期《因果科学周刊》,推送近期因果科学值得关注的论文和资讯信息。本期的主题是”OOD 泛化“,另外在“近期社区活动”专栏,我们将介绍清华副教授崔鹏在 NeurIPS 2020中国预讲会上,所作主题报告「稳定学习:发掘因果推理和机器学习的共同基础」中的精彩观点。

本期作者:闫和东 许雄锐 陈天豪 杨二茶 龚鹤扬 张天健 方文毅 郭若城

1. OOD 泛化简介

Out-of-distribution(OOD) 泛化是一种 Systemactic 泛化,很多人对 OOD 问题的关注是从 Bengio 开始的,传统上一些做法是认为OOD=Novelty Detection=Outlier Detection,但是本文完全不讨论 OOD detection 相关内容.

图1:Bengio 目前第一的研究兴趣

Bengio 表示传统机器学习一半是基于独立同分布(IID)的数据分布假设,但实际现状是很多真实场景下我们感兴趣的数据往往是出现次数非常少的数据,也就是我们在处理时需要关注更多的是 OOD,也就是在数据中出现较少的分布,这需要我们在机器学习算法中有新的数据假设。尤其是从 Agent 的角度来考虑,考虑哪些是影响数据分布变化的因素,以及不同分布的可组合性等很重要。

图2:从 IID 到 OOD (Bengio)

元学习(学习学习的模型)是可能实现机器学习到 OOD 和模型快速迁移的一个办法。说到 OOD,究其原因是有行为的变化,或者是用户行为对于数据的干预。元学习的知识表示,e.g. 变量之间的因果结构, 可以有效帮助 OOD 泛化,这里的挑战是如何学习到未知干预变量的因果知识。

作为因果结合机器学习的一个具体方向,下面是我们邀请亚利桑那州立大学在读博士郭若城推荐的6 篇 Causal + OOD 论文:

Peters, Jonas, Peter Bühlmann, and Nicolai Meinshausen. "Causal inference using invariant prediction: identification and confidence intervals." arXiv preprint arXiv:1501.01332 (2015).

Rothenhäusler, Dominik, Nicolai Meinshausen, Peter Bühlmann, and Jonas Peters. "Anchor regression: heterogeneous data meets causality." arXiv preprint arXiv:1801.06229 (2018).

Rojas-Carulla, Mateo, Bernhard Schölkopf, Richard Turner, and Jonas Peters. "Invariant models for causal transfer learning." The Journal of Machine Learning Research 19, no. 1 (2018): 1309-1342.

Arjovsky, Martin, Léon Bottou, Ishaan Gulrajani, and David Lopez-Paz. "Invariant risk minimization." arXiv preprint arXiv:1907.02893 (2019).

Krueger, David, Ethan Caballero, Joern-Henrik Jacobsen, Amy Zhang, Jonathan Binas, Remi Le Priol, and Aaron Courville. "Out-of-distribution generalization via risk extrapolation (rex)." arXiv preprint arXiv:2003.00688 (2020).

Ahuja, Kartik, Karthikeyan Shanmugam, Kush Varshney, and Amit Dhurandhar. "Invariant risk minimization games." ICML 2020.

2. 崔鹏谈 OOD

崔鹏是清华大学计算机科学与技术系副教授,主要研究方向是 Stable learning, OOD generalization, fairness, counterfactual prediction. 我们在研读和翻译了如上所述的论文之后,特别邀请崔鹏老师谈了他的观感,具体如下:

1)Bengio 选择尝试用因果来解决 OOD 问题,获得 Systematic 泛化能力,崔鹏老师团队的 Stable learning/prediction 就是 Causal + OOD 的一系列具体工作。

2)崔鹏老师强调了 OOD 问题不应该假定 Testing distribution,所以严格意义上上面的文章3可能不是 OOD 范畴。

3)前两篇文章是融入了因果图的信息来解决 OOD 问题,而后三篇是纯基于 representation learning 的。Stable learning是兼顾 Causal implication 和 Learning 框架,是这两种思路的融合。

4) 支持 OOD 研究的数据集对初学者很重要,崔鹏老师其实是在推荐他们近期的工作 NICO 数据集给关注 OOD 问题的研究者,该数据集合已经在上一期内容中介绍。

关于 Stable Larning 的论文,请查看我们的周刊:《因果科学周刊》第三期:因果助力 Stable Learning

接下来,是我们对 6 篇 Causal + OOD 论文的摘要翻译,包括因果社区龚鹤扬所进行的评论解读。

3. 论文翻译和解读

3.1 Methods with causal graphs

这部分的论文在某种意义上假定因果结构已知。

Peters, Jonas, Peter Bühlmann, and Nicolai Meinshausen. "Causal inference using invariant prediction: identification and confidence intervals." arXiv preprint arXiv:1501.01332 (2015).

摘要翻译:就预测来说,因果模型和非因果模型有什么区别呢?假设我们干预预测变量或更改整个环境。因果模型的预测将在一般情况下以及在观测数据的干预下起作用。相反,如果我们积极干预变量,则非因果模型的预测可能会非常错误。在这里,我们提出利用在因果模型下预测的这种不变性进行因果推断:在不同的实验设置(例如各种干预措施)下,我们汇集所有在设置和干预措施中确实显示出预测准确度不变性的模型。因果模型将以较高的概率成为这些模型的一个。这种方法在相当普遍的情况下为因果关系产生有效的置信区间。我们将更详细地研究结构方程模型的例子,并提供充分的假设,在这些假设下可以使因果预测变量集可识别。我们将进一步研究模型误定情况下我们方法的鲁棒性,并讨论可能的扩展。我们研究了各种数据集的经验性质,包括大规模的基因扰动实验。

译者:闫和东

龚鹤扬解读:

如果我们干预一些变量或者改变整个环境,因果模型的预测效果将会依然很好,而非因果模型则不一定。

本文探索的是模型 prediction invariance 性质,而因果模型则很可能就是拥有 prediction invariance 性质。

主要贡献是新方法,新概念,新理论。

Rothenhäusler, Dominik, Nicolai Meinshausen, Peter Bühlmann, and Jonas Peters. "Anchor regression: heterogeneous data meets causality." arXiv preprint arXiv:1801.06229 (2018).

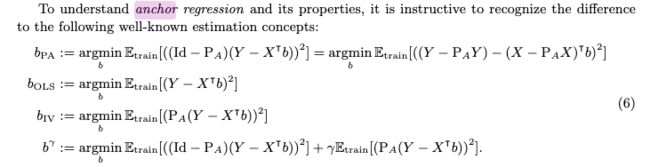

翻译摘要:我们考虑了在一个与训练集分布不同的数据集中,如何从一组协变量预测一个因变量的问题。当在新的分布中有大量变量被干预所影响,或者虽然只有一部分变量被影响、但干扰非常强烈时,因果变量在预测准确率上是最优的。如果训练集和测试集的分布存在一个偏移,因果参数可能由于太保守而在上述任务中表现欠佳。这激发了锚回归(anchor regression)方法的提出,这个方法通过一个对最小二乘损失的修正,利用外生变量来解决因果最小最大问题的一个松弛。我们证明了估计量(estimator)的预测性能有保障,具体来说是分布线性偏移下的预测具备分布鲁棒性,甚至工具变量假设不再满足的时候依然有效。我们发现如果锚回归与最小二乘法提供的答案相同(锚稳定性),则在特定的分布变化下普通最小二乘法参数是稳定不变的。实证表明锚回归能够提高可重复性并避免分布变化的影响。

译者:许雄锐

龚鹤扬解读:

The anchor variable can either be used to encode heterogeneity “within” a data set or heterogeneity “between” data sets.

Rojas-Carulla, Mateo, Bernhard Schölkopf, Richard Turner, and Jonas Peters. "Invariant models for causal transfer learning." The Journal of Machine Learning Research 19, no. 1 (2018): 1309-1342.

摘要翻译:迁移学习方法尝试结合来自几个相关任务或领域的知识以提高测试集的性能。受因果方法的启发,我们放宽通常的协变量偏移假设,并假设它适用于预测变量的子集:给定该预测变量子集下,目标变量的条件分布在所有任务中都是不变的。我们展示了这个假设是如何从因果关系领域的观点中得到启发的。我们聚焦于领域泛化问题(Domain Generalization),在这个问题中没有观察到来自测试任务的示例。我们证明了在对抗性环境下,使用该子集进行预测在域泛化中是最优的;我们进一步提供例子,其中任务充分多样化,因此即使在平均水平上,估计器也优于池化的数据。我们还介绍了一种实用的方法,该方法允许对上述子集进行自动推理,并给出了相应的代码。我们给出这种方法在合成数据集和基因缺失数据集的结果。

译者:陈天豪

龚鹤扬解读:

主要内容包括

问题的假定是给定某部分变量下结果的条件分布不变←covariate shift assump

我们用对抗学习能够选择出来正确的变量 with proof

3.2 Methods without causal graphs

这部分内容是基于表示学习的。

Arjovsky, Martin, Léon Bottou, Ishaan Gulrajani, and David Lopez-Paz. "Invariant risk minimization." arXiv preprint arXiv:1907.02893 (2019).

摘要翻译:我们介绍了一种在多种训练数据分布下学习不变相关关系的学习范式,称为不变风险最小化(IRM)。为了实现这个目标,IRM可以学到一种数据表示,使得基于这种数据表示的最优分类器在不同的训练数据分布下都有较好的表现。通过理论和实验,我们展现了IRM学到的不变性是如何与数据生成机制的因果结构相联系的,并且提高了OOD情况下的泛化能力。

译者张天健注:

这里多种训练数据分布是指,在每种环境下![]() 联合分布会有不同。对于实验者,每个数据点采自的相应环境是已知的。

联合分布会有不同。对于实验者,每个数据点采自的相应环境是已知的。

龚鹤扬解读:

基本思想 spurious correlations do not appear to be stable properties

文章的主要贡献是: OOD 新范式 for multiple training envs.

-

图像像素点不会是因果变量,所以我们自动学习出来。

提出 IRM 原则:To learn invariances ..., find a representation such that .....。

IRM 的数学原理如下:

Krueger, David, Ethan Caballero, Joern-Henrik Jacobsen, Amy Zhang, Jonathan Binas, Remi Le Priol, and Aaron Courville. "Out-of-distribution generalization via risk extrapolation (rex)." arXiv preprint arXiv:2003.00688 (2020).

摘要翻译:训练分布之外数据集的泛化是当前机器学习面临的挑战。一个弱形式的分布外(OoD)泛化能力是指能成功地在多个观测分部之间进行内插(Interpolate)。实现这一目标的方法之一是通过鲁棒性优化,这意味着最小化在训练分布的凸组合中最差的情况。然而,OoD 泛化的一种更强的形式是指在训练时对观察到的分布外进行外推的能力。为了追求强大的 Ood 泛化,我们引入风险外推(REx)。REx能被看做通过促进训练风险之间的严格平等从而促进训练风险线性组合的鲁棒性。我们从概念上展示了这一原则如何允许外推,并且展示了REx在不同的 OoD 泛化任务上的有效性和实例扩展性。

译者:方文毅

龚鹤扬解读:

我们提出一个类似 IRM 的新原则 REx,用于解决 “Spurious” features are predictive in training, but not in a test time,例如手写数字的颜色。

基本数学原理如下:

不同领域上的风险进行线性组合,并且允许组合系数为负值,通过这个实现了外推, 并且优化这个组合中最差的情况。对于 Variance REx(V-REx),使用方差进行正则化,从结果来说比 MM-REx 稳定一些。

Ahuja, Kartik, Karthikeyan Shanmugam, Kush Varshney, and Amit Dhurandhar. "Invariant risk minimization games." ICML 2020.

摘要翻译:当环境中的测试分布和训练分布的差异是由虚假相关导致的,机器学习的标准风险最小化的范式就变得岌岌可危了。通过多环境的数据集训练,同时寻找不变的那些预测指标,将模型专注于对结果有因果关系的特征,可达到减少虚假特征影响的目的。本研究提出不变风险最小化的概念,寻找纳什均衡中差异环境下的组合博弈。研究者提出一种采用最优反映动态的简单训练算法,实验产出比Arjovsky et al. (2019)双层优化问题中,更小的方差,近似甚至更好的实证准确性。本研究的关键理论贡献表明在任意有限数量的环境中,包括非线性分类及变换的环境,研究提出策略的纳什均衡集合与不变预测指标的集合是等价的。综上所述,本研究方法同Arjovsky et al. (2019),需保留大量的环境集合,才具有泛化保证。本文提出算法在现有的成功博弈-理论的机器学习算法如生成对抗网络(GAN)等研究的基础上进行了补充。

译者:杨二茶

龚鹤扬解读:

IRM 的变体 + Nash 均衡

4. 近期社区活动

在11月27日由智源社区举办的 NeurIPS 2020中国预讲会上,智源青年科学家、清华大学计算机科学与技术系副教授崔鹏发表了主题为「稳定学习:发掘因果推理和机器学习的共同基础」的演讲,崔鹏表示,「我们将站在机器学习的角度,探讨如何看待因果推理。」

在本次演讲中,崔鹏结合其研究组近年来的相关研究工作,针对如何「将因果与机器学习相结合」这一问题进行了分享。

自 2016 年起,崔鹏团队开始深入研究如何将因果推理与机器学习相结合,并最终形成了「稳定学习」(stable learning)的研究方向。从宏观的角度来看,稳定学习旨在寻找因果推理与机器学习之间的共同基础,从而应对一系列有待解决的问题。

在演讲中,崔鹏首先介绍了当下人工智能存在的风险,即不可解释性和不稳定性,并指出,关联统计是导致这些风险的重要原因。而结合因果推断的机器学习可以克服这两个缺陷,实现稳定学习。值得一提的是,从因果角度出发,可解释性和稳定性之间存在一定的内在关系,即通过优化模型的稳定性亦可提升其可解释性。

然后,崔鹏介绍了如何通过「混淆变量平衡」的思想实现稳定学习,并指出其具有理论保障。实验结果也表明:「训练和测试时环境差异越大,采用因果方法相对于关联方法取得的性能提升也就越大」,从而展现了因果推断对于降低机器学习风险、克服关联统计缺陷的优势,以及引领机器学习下一个发展方向的潜力。

因果科学社区简介:它是由智源社区、集智俱乐部共同推动,面向因果科学领域的垂直型学术讨论社区,目的是促进因果科学专业人士和兴趣爱好者们的交流和合作,推进因果科学学术、产业生态的建设和落地,孕育新一代因果科学领域的学术专家和产业创新者。

因果科学社区欢迎您加入!

因果科学社区愿景:回答因果问题是各个领域迫切的需求,当前许多不同领域(例如 AI 和统计学)都在使用因果推理,但是他们所使用的语言和模型各不相同,导致这些领域科学家之间沟通交流困难。因此我们希望构建一个社区,通过组织大量学术活动,使得科研人员能够掌握统计学的核心思想,熟练使用当前 AI 各种技术(例如 Pytorch/Pyro 搭建深度概率模型),促进各个领域的研究者交流和思维碰撞,从而让各个领域的因果推理有着共同的范式,甚至是共同的工程实践标准,推动刚刚成型的因果科学快速向前发展。具备因果推理能力的人类紧密协作创造了强大的文明,我们希望在未来社会中,因果推理融入到每个学科,尤其是紧密结合和提升 AI ,期待无数具备攀登因果之梯能力的 Agents (Causal AI) 和人类一起协作,共建下一代的人类文明!

如果您有适当的数学基础和人工智能研究经验,既有科学家的好奇心也有工程师思维,希望参与到”因果革命“中,教会机器因果思维,为因果科学作出贡献,请加入我们微信群:扫描下面社区小助手二维码加入(请备注“因果科学”)????

阅读往期《因果科学周刊》,请点击下面链接:

《因果科学周刊》第一期:因果社区诚邀加入,打造因果推理共同范式

《因果科学周刊》第二期:如何解决混淆偏差?

《因果科学周刊》第三期:因果助力 Stable Learning

《因果科学周刊》第四期:因果赋能推荐系统