ELK日志分析系统

ELK日志分析系统

- ELK日志分析系统概述

-

- ELK日志分析系统简介

- 日志处理步骤

- Elasticsearch介绍

-

- Elasticsearch的概述

- Elasticsearch核心概念

- Logstash介绍

-

- Logstash的概述

- Logstash主要组件

- Kibana介绍

-

- Kibana的概述

- Kibana主要功能

- 部署ELK日志分析系统

- 一句话让你记住ELK日志

ELK日志分析系统概述

ELK日志分析系统简介

E:Elasticsearch——索引数据库

L:Logstash——收集、输出(日志)

K:Kibana——展示工具

日志处理步骤

1、将日志进行集中化管理

2、将日志格式化并输出到Elasticsearch(Logstash)

3、对格式化后的数据进行索引和存储(Elasticsearch)

4、前端数据的展示(Kibana)

Elasticsearch介绍

Elasticsearch的概述

提供了一个分布式多用户能力的全文搜索引擎

Elasticsearch核心概念

接近实时:索引文档时有轻微的延迟

集群:es具有集群机制,节点通过集群名称加入集群中,节点具有唯一标识

节点:存储数据并参与集群的索引和搜索功能

索引:相当于关系型数据库的库,是相似文档的集合

分片和副本:

(1)分片机制:提升索引效率,提高存储量

(2)副本:高可用性(解决单点故障),增大吞吐量

Logstash介绍

Logstash的概述

1、一款强大的数据处理工具

2、可实现数据传输、格式处理、格式化输出

3、数据输入、数据加工(过滤、改写等)以及数据输出

Logstash主要组件

Shipper:日志收集者。负责监控本地日志文件的变化

Indexer:日志存储着。负责接收日志并写入到本地文件

Broker:日志Hub。负责连接多个Shipper和多个Indexer

Search and Storage:允许对事件进行搜索和存储

Web Interface:基于Web的展示界面

Kibana介绍

Kibana的概述

1、一个针对Elasticsearch的开源分析及可视化平台

2、搜索、查看存储在Elasticsearch索引中的数据

3、通过各种图标进行高级数据分析及展示

Kibana主要功能

1、Elasticsearch无缝之集成

2、整合数据,复杂数据分析

3、让更多团队成员受益

4、接口灵活,分享更容易

5、配置简单,可视化多数据源

6、简单数据导出

部署ELK日志分析系统

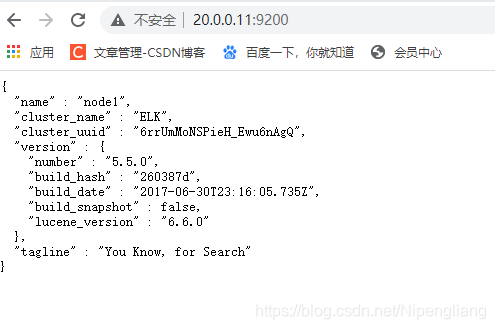

环境

20.0.0.11 :node1

20.0.0.12 :node2

20.0.0.13 :apache

1、构建es群集

(1)三台主机,关防火墙,查看是否有java环境

[root@node1 ~]# systemctl stop firewalld

[root@node1 ~]# setenforce 0

[root@node1 ~]# java -version

openjdk version "1.8.0_181"

OpenJDK Runtime Environment (build 1.8.0_181-b13)

OpenJDK 64-Bit Server VM (build 25.181-b13, mixed mode)

(2)节点1、节点2 设置本地解析

[root@node1 ~]# vim /etc/hosts

20.0.0.11 node1

20.0.0.12 node2

(3)节点1、节点2安装部署es(在opt目录下导入es相关软件包)

[root@node1 opt]# ls

elasticsearch-5.5.0.rpm logstash-5.5.1.rpm

elasticsearch-head.tar.gz node-v8.2.1.tar.gz

kibana-5.5.1-x86_64.rpm phantomjs-2.1.1-linux-x86_64.tar.bz2

[root@node1 opt]# rpm -ivh elasticsearch-5.5.0.rpm

[root@node1 opt]# cp -p /etc/elasticsearch/elasticsearch.yml /etc/elasticsearch/elasticsearch.yml.bak ##备份原配置文件

[root@node1 opt]# vim /etc/elasticsearch/elasticsearch.yml ##修改主配置文件

17 cluster.name: elkjd ##els群集名称

23 node.name: node1 ##节点名

33 path.data: /data/elk_data ##数据存放路径

37 path.logs: /var/log/elasticsearch ##自身日志存放位置

43 bootstrap.memory_lock: false ##启动时不锁定内存

55 network.host: 0.0.0.0 ##监听全部IP

59 http.port: 9200 ##端口

68 discovery.zen.ping.unicast.hosts: ["node1", "node2"] ##单播节点名

(4)创建数据存放路径并更改属组属主

[root@node1 opt]# mkdir -p /data/elk_data

[root@node1 opt]# chown elasticsearch:elasticsearch /data/elk_data/

(5)启动 ES

[root@node1 opt]# systemctl daemon-reload ##加载系统服务

[root@node1 opt]# systemctl enable elasticsearch.service

Created symlink from /etc/systemd/system/multi-user.target.wants/elasticsearch.service to /usr/lib/systemd/system/elasticsearch.service.

[root@node1 opt]# systemctl start elasticsearch.service

[root@node1 ~]# netstat -anpt | grep 9200 ##这个端口需要多启动几次,有延时

tcp6 0 0 :::9200 :::* LISTEN 6677/java

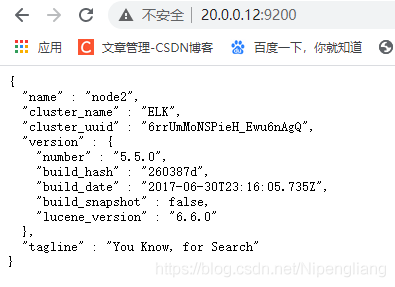

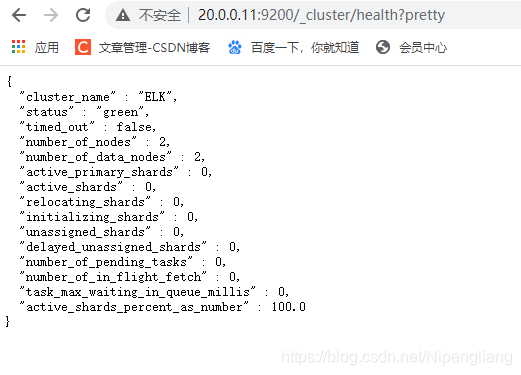

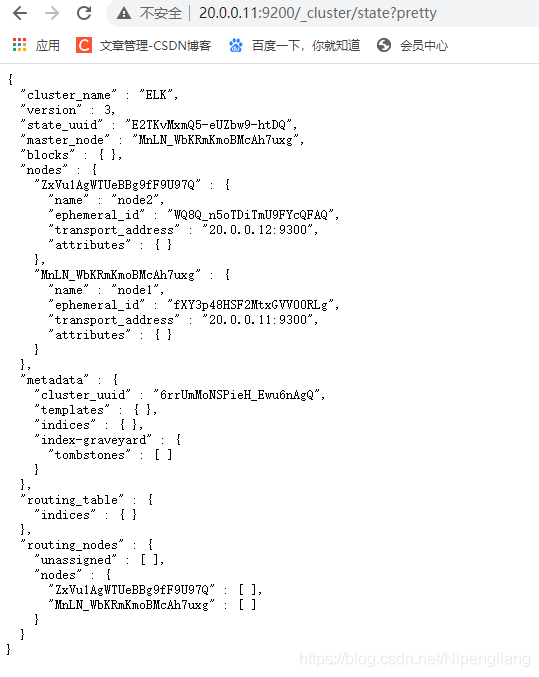

(6)检验效果:访问网页

检查集群健康:地址后方加入/_cluster/health?pretty

检查集群状态:地址后方加入/_cluster/state?pretty

(7)两台节点安装 elasticsearch-head 插件

[root@node1 opt]# tar zxvf node-v8.2.1.tar.gz

[root@node1 opt]# cd node-v8.2.1/

[root@node1 node-v8.2.1]# ./configure

[root@node1 node-v8.2.1]# make -j4 ##用四线程编译,要等十几分钟

[root@node1 node-v8.2.1]# make install

(8)安装phantomjs(前端框架)

[root@node1 opt]# tar jxvf phantomjs-2.1.1-linux-x86_64.tar.bz2

[root@node1 opt]# cd phantomjs-2.1.1-linux-x86_64/

[root@node1 phantomjs-2.1.1-linux-x86_64]# cd bin/

[root@node1 bin]# ls

phantomjs

[root@node1 bin]# cp phantomjs /usr/local/bin/

(9)安装elasticsearch-head(数据可视化工具)

[root@node1 opt]# tar zxvf elasticsearch-head.tar.gz

[root@node1 opt]# cd elasticsearch-head/

[root@node1 elasticsearch-head]# npm install

(10)重新修改主配置文件 并 重启服务

[root@node1 elasticsearch-head]# cd /

[root@node1 /]# vim /etc/elasticsearch/elasticsearch.yml

##末行插入

http.cors.enabled: true ##开启跨域访问支持,默认为false

http.cors.allow-origin: "*" ##跨域访问允许的域名地址,支持使用正则

[root@node1 elasticsearch-head]# systemctl restart elasticsearch.service

(11)启动elasticsearch-head 并 检测端口是否开启

[root@node1 elasticsearch-head]# npm run start & 启动

[1] 13823

[root@node1 elasticsearch-head]#

> elasticsearch-head@0.0.0 start /opt/elasticsearch-head

> grunt server

Running "connect:server" (connect) task

Waiting forever...

Started connect web server on http://localhost:9100

^C

[root@node1 elasticsearch-head]# netstat -anpt | grep 9100

tcp 0 0 0.0.0.0:9100 0.0.0.0:* LISTEN 13833/grunt

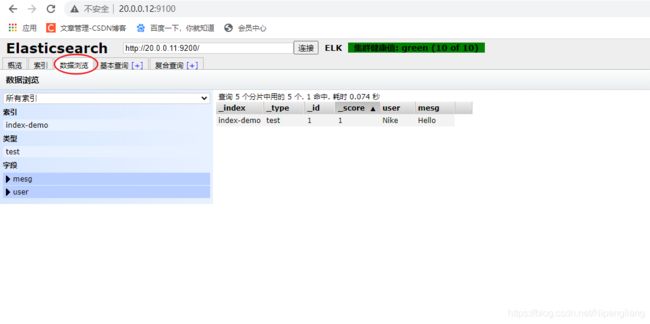

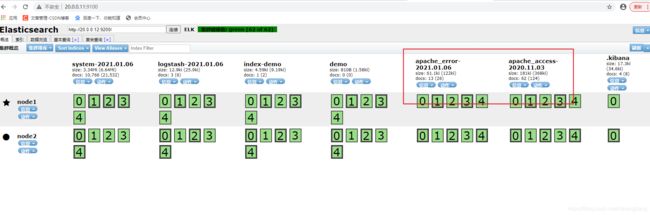

创建索引,进行验证

[root@node1 ~]# curl -XPUT 'localhost:9200/index-demo/test/1?pretty&pretty' -H 'content-Type: application/json' -d '{"user":"Nike","mesg":"Hello"}'

{

"_index" : "index-demo",

"_type" : "test",

"_id" : "1",

"_version" : 1,

"result" : "created",

"_shards" : {

"total" : 2,

"successful" : 2,

"failed" : 0

},

"created" : true

}

(1)在apache上安装httpd服务,并且部署安装 logstash

[root@apache ~]# yum -y install httpd

[root@apache ~]# systemctl start httpd

#导入logstash

[root@apache ~]# rpm -ivh logstash-5.5.1.rpm

[root@apache ~]# systemctl start logstash.service

[root@apache ~]# systemctl enable logstash.service

Created symlink from /etc/systemd/system/multi-user.target.wants/logstash.service to /etc/systemd/system/logstash.service.

[root@apache ~]# ln -s /usr/share/logstash/bin/logstash /usr/local/bin/

(2)与ES 节点进行对接测试

Logstash这个命令测试

字段描述解释:

-f 通过这个选项可以指定logstash的配置文件,根据配置文件配置logstash

-e 后面跟着字符串 该字符串可以被当做logstash的配置(如果是” ”,则默认使用stdin做为输入、stdout作为输出)

-t 测试配置文件是否正确,然后退出

[root@apache ~]# logstash -e 'input { stdin{} } output { stdout{} }' #标准输入和输出

##省略部分…………

The stdin plugin is now waiting for input:

09:46:35.448 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {

:port=>9600}

hello #输入内容,回车结束

2021-01-06T01:47:39.955Z apache hello #解析

www.baidu.com #输入内容,回车结束

2021-01-06T01:48:10.286Z apache www.baidu.com #解析

#测试完,退出

(3)ruby 测试

codec为一种编解码器

[root@apache ~]# logstash -e 'input { stdin{} } output { stdout{ codec=>rubydebug } }' #标准输入,通过codec解码器以rubydebug的格式输出

The stdin plugin is now waiting for input:

09:49:40.523 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {

:port=>9600}

www.baidu.com #输入内容,回车结束

{

#解析

"@timestamp" => 2021-01-06T01:49:59.559Z,

"@version" => "1",

"host" => "apache",

"message" => "www.baidu.com"

}

hello #输入内容,回车结束

{

#解析

"@timestamp" => 2021-01-06T01:50:06.163Z,

"@version" => "1",

"host" => "apache",

"message" => "hello"

}

#测试完,退出

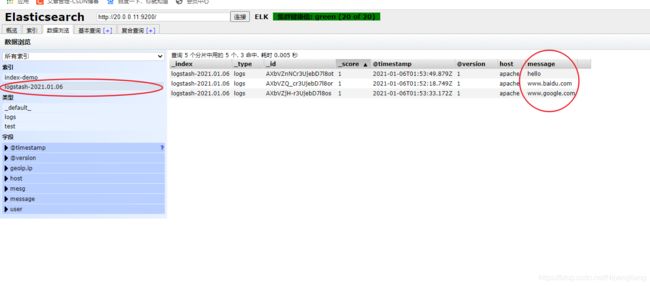

(4)使用 logstash 将信息写入 ES 中

[root@apache ~]# logstash -e 'input { stdin{} } output { elasticsearch { hosts=>["20.0.0.12:9200"] } }'

The stdin plugin is now waiting for input:

09:52:06.282 [Api Webserver] INFO logstash.agent - Successfully started Logstash API endpoint {

:port=>9600}

www.baidu.com #输入内容

www.google.com

hello

#输完内容,退出

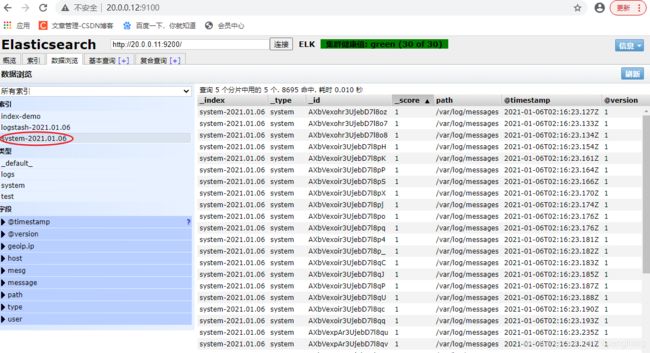

[root@apache ~]# ll /var/log/messages

-rw-------. 1 root root 768098 1月 6 10:14 /var/log/messages

[root@apache ~]# chmod o+r /var/log/messages #给其它用户读的权限

[root@apache ~]# cd /etc/logstash/conf.d/

[root@apache conf.d]# ls

[root@apache conf.d]# vim system.conf

input {

file{

path => "/var/log/messages"

type => "system"

start_position => "beginning"

}

}

output {

elasticsearch {

hosts => ["20.0.0.12:9200"]

index => "system-%{+YYYY.MM.dd}" ##索引名

}

}

[root@apache conf.d]# systemctl restart logstash.service

#kibana可以装任意主机上检测,我装在 node1上

[root@node1 opt]# rpm -ivh kibana-5.5.1-x86_64.rpm

[root@node1 opt]# cd /etc/kibana/

[root@node1 kibana]# ls

kibana.yml

[root@node1 kibana]# cp kibana.yml kibana.yml.bak

[root@node1 kibana]# vim kibana.yml

2 server.port: 5601 ##kibana端口

7 server.host: "0.0.0.0" ##监听全部IP

21 elasticsearch.url: "http://20.0.0.12:9200" ##与ES建立联系

30 kibana.index: ".kibana" ##在ES中添加 .kibana 索引

[root@node1 kibana]# systemctl start kibana.service

[root@node1 kibana]# systemctl enable kibana.service

Created symlink from /etc/systemd/system/multi-user.target.wants/kibana.service to /etc/systemd/system/kibana.service.

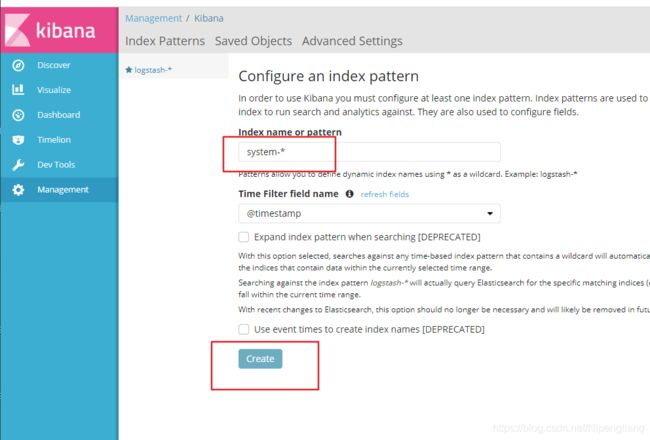

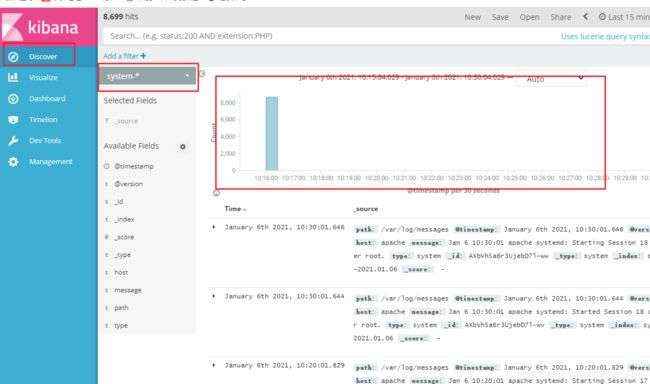

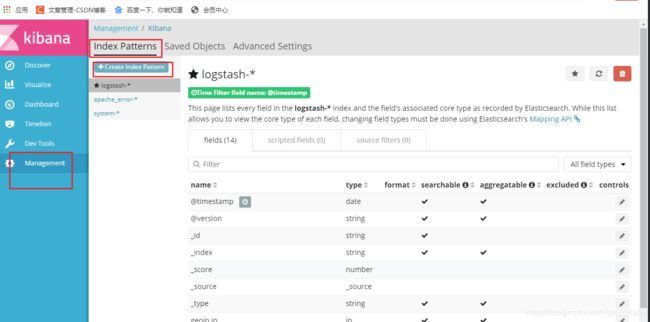

验证:访问20.0.0.11:5601(首次登录提示创建一个索引名字:

填入system-*,即对接系统日志文件名)

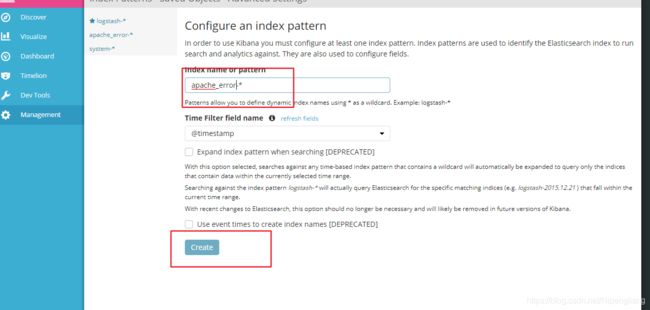

对接apache主机

[root@apache conf.d]# vim web_log.conf

input {

file{

path => "/etc/httpd/logs/access_log"

type => "access"

start_position => "beginning"

}

file{

path => "/etc/httpd/logs/error_log"

type => "error"

start_position => "beginning"

}

}

output {

if [type] == "access" {

elasticsearch {

hosts => ["20.0.0.12:9200"]

index => "apache_access-%{+YYYY.MM.dd}"

}

}

if [type] == "error" {

elasticsearch {

hosts => ["20.0.0.12:9200"]

index => "apache_error-%{+YYYY.MM.dd}"

}

}

}

[root@apache conf.d]# logstash -f web_log.conf #指定配置文件做测试

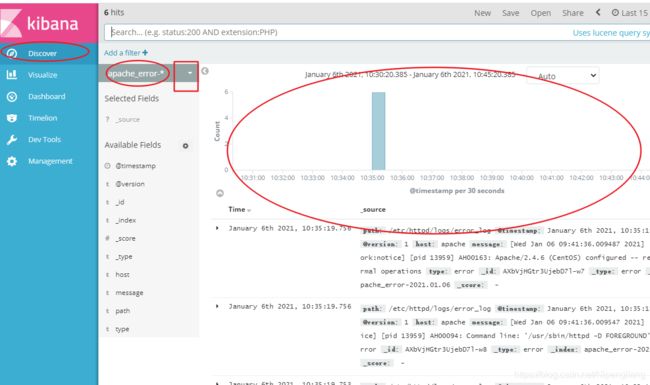

检测:

#访问日志一开始没出来,记得要先访问下apache网址,才会产生访问日志

进入 kibana 创建对应 索引,就可以使用图形界面查看日志分析了

一句话让你记住ELK日志

场景:双十一,各大电商平台访问量暴增,对应的访问日志暴增,系统维护人员需要对日志进行处理分析,但苦于数量之巨…

一句话:为了解决大量日志分析困难的问题,所以可以配置ELK进行集中化管理;其中logstash负责收集和格式化数据,再将数据存储到es数据库中,es可通过创建分片和副本的形式,用来抗压和避免单点故障,最后通过kibana,可视化的简便的展示出数据效果。