通俗易懂ElasticSearch7.6学习笔记

通俗易懂ElasticSearch7.6学习笔记

- ElasticSearch

-

- ElasticSearch概述

- ES和solr的差别

-

- Elasticsearch简介

- Solr简介

- Lucene简介

- Elasticsearch和Solr比较

- ElasticSearch vs Solr 总结

- 了解 ELK

- ES核心概念

-

- 文档

- 类型

- 索引

- 倒排索引

- IK分词器

- Rest风格说明

- 关于索引的基本操作

-

- 创建一个索引

- 索引的类型

- 通过PUT创建规则(字段类型)

- 通过GET获取具体的信息

- 查看默认的信息

- 使用Cat命令查看信息

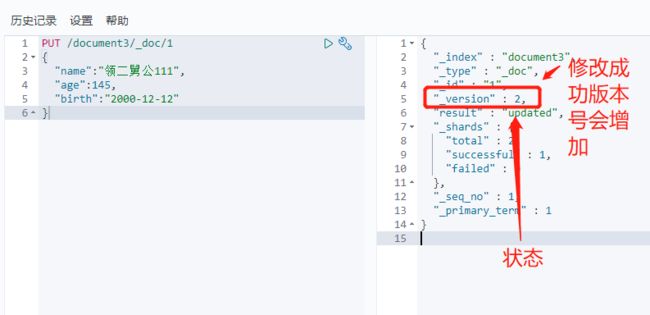

- 使用PUT命令修改文档

- 使用POST命令修改文档

- 关于文档的基本操作

-

- 添加数据

- 获取数据

- 更新数据

- 简单条件查询

- 复杂条件查询

- 排序

- 分页查询

- 布尔值查询

- 过滤器filter

- 多条件匹配查询

- 精确查询

- 多值匹配精确查询

- 高亮查询

ElasticSearch

ElasticSearch概述

Elaticsearch,简称为es,es是一个开源的高扩展的分布式全文检索引擎,它可以近乎实时的存储、检索数据;本身扩展性很好,可以扩展到上百台服务器,处理PB级别(大数据时代)的数据。es也使用 Java开发并使用Lucene作为其核心来实现所有索引和搜索的功能,但是它的目的是通过简单的RESTful API来隐藏Lucene的复杂性,从而让全文搜索变得简单。

据国际权威的数据库产品评测机构DB Engines的统计,在2016年1月,ElasticSearch已超过Solr等,成为排名第一的搜索引擎类应用。

历史

多年前,一个叫做Shay Banon的刚结婚不久的失业开发者,由于妻子要去伦敦学习厨师,他便跟着也去 了。在他找工作的过程中,为了给妻子构建一个食谱的搜索引擎,他开始构建一个早期版本的Lucene。

直接基于Lucene工作会比较困难,所以Shay开始抽象Lucene代码以便Java程序员可以在应用中添加搜 索功能。他发布了他的第一个开源项目,叫做“Compass”。

后来Shay找到一份工作,这份工作处在高性能和内存数据网格的分布式环境中,因此高性能的、实时 的、分布式的搜索引擎也是理所当然需要的。然后他决定重写Compass库使其成为一个独立的服务叫做 Elasticsearch。

第一个公开版本出现在2010年2月,在那之后Elasticsearch已经成为Github上最受欢迎的项目之一,代 码贡献者超过300人。一家主营Elasticsearch的公司就此成立,他们一边提供商业支持一边开发新功 能,不过Elasticsearch将永远开源且对所有人可用。

Shay的妻子依旧等待着她的食谱搜索……

谁在使用:

- 维基百科,类似百度百科,全文检索,高亮,搜索推荐/2 (权重,百度!)

- The Guardian(国外新闻网站),类似搜狐新闻,用户行为日志(点击,浏览,收藏,评论)+社交 网络数据(对某某新闻的相关看法),数据分析,给到每篇新闻文章的作者,让他知道他的文章的公众反馈(好,坏,热门,垃圾,鄙视,崇拜)

- Stack Overflow(国外的程序异常讨论论坛),IT问题,程序的报错,提交上去,有人会跟你讨论和 回答,全文检索,搜索相关问题和答案,程序报错了,就会将报错信息粘贴到里面去,搜索有没有对应 的答案

- GitHub(开源代码管理),搜索上千亿行代码

- 电商网站,检索商品

- 日志数据分析,logstash采集日志,ES进行复杂的数据分析,ELK技术, elasticsearch+logstash+kibana

- 商品价格监控网站,用户设定某商品的价格阈值,当低于该阈值的时候,发送通知消息给用户,比如说订阅牙膏的监控,如果高露洁牙膏的家庭套装低于50块钱,就通知我,我就去买。

- BI系统,商业智能,Business Intelligence。比如说有个大型商场集团,BI,分析一下某某区域最近 3年的用户消费金额的趋势以及用户群体的组成构成,产出相关的数张报表,**区,最近3年,每年消费 金额呈现100%的增长,而且用户群体85%是高级白领,开一个新商场。ES执行数据分析和挖掘, Kibana进行数据可视化

- 国内:站内搜索(电商,招聘,门户,等等),IT系统搜索(OA,CRM,ERP,等等),数据分析 (ES热门 的一个使用场景)

ES和solr的差别

Elasticsearch简介

Elasticsearch是一个实时分布式搜索和分析引擎。它让你以前所未有的速度处理大数据成为可能。 它用于全文搜索、结构化搜索、分析以及将这三者混合使用:

- 维基百科使用Elasticsearch提供全文搜索并高亮关键字,以及输入实时搜索(search-asyou-type)和搜索 纠错(did-you-mean)等搜索建议功能。

- 英国卫报使用Elasticsearch结合用户日志和社交网络数据提供给他们的编辑以实时的反馈,以便及时了 解公众对新发表的文章的回应。

- StackOverflow结合全文搜索与地理位置查询,以及more-like-this功能来找到相关的问题和答案。

- Github使用Elasticsearch检索1300亿行的代码。

但是Elasticsearch不仅用于大型企业,它还让像DataDog以及Klout这样的创业公司将最初的想法变成可 扩展的解决方案。

Elasticsearch可以在你的笔记本上运行,也可以在数以百计的服务器上处理PB级别的数据 。 Elasticsearch是一个基于Apache Lucene™的开源搜索引擎。无论在开源还是专有领域,Lucene可以 被认为是迄今为止最先进、性能最好的、功能最全的搜索引擎库。

但是,Lucene只是一个库。想要使用它,你必须使用Java来作为开发语言并将其直接集成到你的应用 中,更糟糕的是,Lucene非常复杂,你需要深入了解检索的相关知识来理解它是如何工作的。

Elasticsearch也使用Java开发并使用Lucene作为其核心来实现所有索引和搜索的功能,但是它的目的是 通过简单的RESTful API来隐藏Lucene的复杂性,从而让全文搜索变得简单。

Solr简介

Solr 是Apache下的一个顶级开源项目,采用Java开发,它是基于Lucene的全文搜索服务器。Solr提供了比Lucene更为丰富的查询语言,同时实现了可配置、可扩展,并对索引、搜索性能进行了优化 。

Solr可以独立运行,运行在Jetty、Tomcat等这些Servlet容器中,Solr 索引的实现方法很简单,用 POST 方法向 Solr 服务器发送一个描述 Field 及其内容的 XML 文档,Solr根据xml文档添加、删除、更新索引 。Solr 搜索只需要发送 HTTP GET 请求,然后对 Solr 返回Xml、json等格式的查询结果进行解析,组织页面布局。Solr不提供构建UI的功能,Solr提供了一个管理界面,通过管理界面可以查询Solr的配置和运行情况。

solr是基于lucene开发企业级搜索服务器,实际上就是封装了lucene。

Solr是一个独立的企业级搜索应用服务器,它对外提供类似于Web-service的API接口。用户可以通过 http请求,向搜索引擎服务器提交一定格式的文件,生成索引;也可以通过提出查找请求,并得到返回 结果。

Lucene简介

Lucene是apache软件基金会4 jakarta项目组的一个子项目,是一个开放源代码的全文检索引擎工具包,但它不是一个完整的全文检索引擎,而是一个全文检索引擎的架构,提供了完整的查询引擎和索引引擎,部分文本分析引擎(英文与德文两种西方语言)。Lucene的目的是为软件开发人员提供一个简单易用的工具包,以方便的在目标系统中实现全文检索的功能,或者是以此为基础建立起完整的全文检索引擎。Lucene是一套用于全文检索和搜寻的开源程式库,由Apache软件基金会支持和提供。Lucene提供了一个简单却强大的应用程式接口,能够做全文索引和搜寻。在Java开发环境里Lucene是一个成熟的 免费开源工具。就其本身而言,Lucene是当前以及最近几年最受欢迎的免费Java信息检索程序库。人们经常提到信息检索程序库,虽然与搜索引擎有关,但不应该将信息检索程序库与搜索引擎相混淆。

Lucene是一个全文检索引擎的架构。那什么是全文搜索引擎?

全文搜索引擎是名副其实的搜索引擎,国外具代表性的有Google、Fast/AllTheWeb、AltaVista、 Inktomi、Teoma、WiseNut等,国内著名的有百度(Baidu)。它们都是通过从互联网上提取的各个网站的信息(以网页文字为主)而建立的数据库中,检索与用户查询条件匹配的相关记录,然后按一定的排列顺序将结果返回给用户,因此他们是真正的搜索引擎。

从搜索结果来源的角度,全文搜索引擎又可细分为两种,一种是拥有自己的检索程序(Indexer),俗称 “蜘蛛”(Spider)程序或“机器人”(Robot)程序,并自建网页数据库,搜索结果直接从自身的数据库中 调用,如上面提到的7家引擎;另一种则是租用其他引擎的数据库,并按自定的格式排列搜索结果,如 Lycos引擎。

Elasticsearch和Solr比较

ElasticSearch vs Solr 总结

- es基本是开箱即用(解压就可以用 ! ),非常简单。Solr安装略微复杂一点

- Solr 利用 Zookeeper 进行分布式管理,而 Elasticsearch 自身带有分布式协调管理功能。

- Solr 支持更多格式的数据,比如JSON、XML、CSV,而 Elasticsearch 仅支持json文件格式。

- Solr 官方提供的功能更多,而 Elasticsearch 本身更注重于核心功能,高级功能多有第三方插件提供,例如图形化界面需要kibana友好支撑

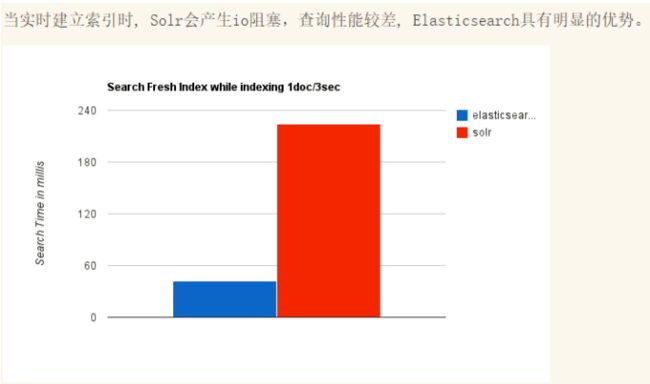

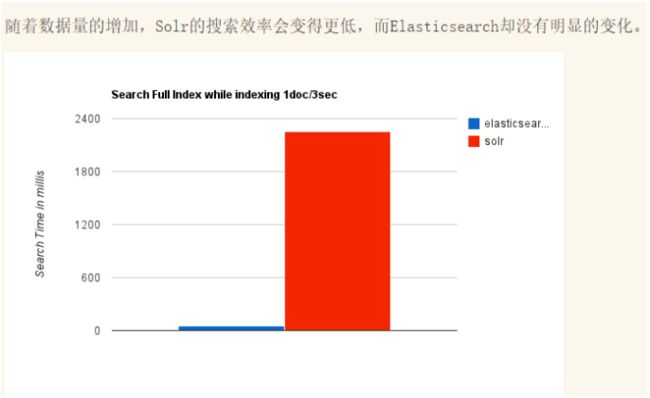

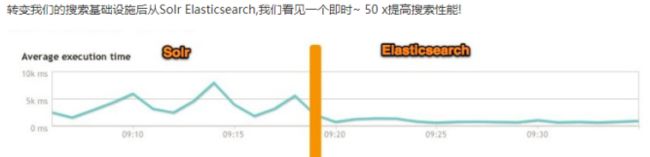

- Solr 查询快,但更新索引时慢(即插入删除慢),用于电商等查询多的应用; ES建立索引快(即查询慢),即实时性查询快,用于facebook新浪等搜索。 Solr 是传统搜索应用的有力解决方案,但 Elasticsearch 更适用于新兴的实时搜索应用。

- Solr比较成熟,有一个更大,更成熟的用户、开发和贡献者社区,而 Elasticsearch相对开发维护者较少,更新太快,学习使用成本较高。(趋势!)

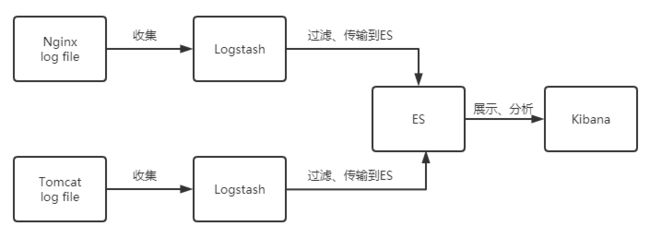

了解 ELK

ELK是Elasticsearch、Logstash、Kibana三大开源框架首字母大写简称。市面上也被成为Elastic Stack。其中Elasticsearch是一个基于Lucene、分布式、通过Restful方式进行交互的近实时搜索平台框架。像类似百度、谷歌这种大数据全文搜索引擎的场景都可以使用Elasticsearch作为底层支持框架,可见Elasticsearch提供的搜索能力确实强大,市面上很多时候我们简称Elasticsearch为es。Logstash是ELK 的中央数据流引擎,用于从不同目标(文件/数据存储/MQ)收集的不同格式数据,经过过滤后支持输出 到不同目的地(文件/MQ/redis/elasticsearch/kafka等)。Kibana可以将elasticsearch的数据通过友好 的页面展示出来,提供实时分析的功能。

市面上很多开发只要提到ELK能够一致说出它是一个日志分析架构技术栈总称,但实际上ELK不仅仅适用于日志分析,它还可以支持其它任何数据分析和收集的场景,日志分析和收集只是更具有代表性。并非唯一性。

Kibana Kibana是一个针对Elasticsearch的开源分析及可视化平台,用来搜索、查看交互存储在Elasticsearch索引中的数据。使用Kibana,可以通过各种图表进行高级数据分析及展示。Kibana让海量数据更容易理解。它操作简单,基于浏览器的用户界面可以快速创建仪表板(dashboard)实时显示Elasticsearch查询动态。设置Kibana非常简单。无需编码或者额外的基础架构,几分钟内就可以完成Kibana安装并启动 Elasticsearch索引监测。

官网:https://www.elastic.co/cn/kibana

Kibana 版本要和 Es 一致

ES核心概念

集群,节点,索引,类型,文档,分片,映射

elasticsearch是面向文档,关系行数据库和elasticsearch 客观的对比,一切都是JSON

elasticsearch(集群)中可以包含多个索引(数据库),每个索引中可以包含多个类型(表),每个类型下又包 含多 个文档(行),每个文档中又包含多个字段(列)。

物理设计:

elasticsearch 在后台把每个索引划分成多个分片,每分分片可以在集群中的不同服务器间迁移 一个人就是一个集群!默认的集群名称就是 elaticsearh

逻辑设计:

一个索引类型中,包含多个文档,比如说文档1,文档2。 当索引一篇文档时,可以通过这样的一个顺序找到 它: 索引—>类型—>文档ID ,通过这个组合我们就能索引到某个具体的文档。 注意:ID不必是整 数,实际上它是个字符串。

文档

就是一条条数据,比如

user

1 zhangsan 18

2 kuangshen 3

之前说elasticsearch是面向文档的,那么就意味着索引和搜索数据的最小单位是文档,elasticsearch 中,文档有几个重要属性 :

-

自我包含,一篇文档同时包含字段和对应的值,也就是同时包含 key:value

-

可以是层次型的,一个文档中包含自文档,复杂的逻辑实体就是这么来的{就是一个json对象,Java中使用fastjson进行自动转换}

-

灵活的结构,文档不依赖预先定义的模式,在关系型数据库中,要提前定义字段才能使用, 在elasticsearch中,对于字段是非常灵活的,有时候,可以忽略该字段,或者动态的添加一个新的字段。

尽管可以随意的新增或者忽略某个字段,但是,每个字段的类型非常重要,比如一个年龄字段类型,可以是字符串也可以是整形。因为elasticsearch会保存字段和类型之间的映射及其他的设置。这种映射具体到每个映射的每种类型,这也是为什么在elasticsearch中,类型有时候也称为映射类型。

类型

类型是文档的逻辑容器,就像关系型数据库一样,表格是行的容器。 类型中对于字段的定义称为映射, 比如 name 映射为字符串类型。 文档是无模式的,它们不需要拥有映射中所定义的所有字段, 比如新增一个字段,那么elasticsearch是怎么做的呢?elasticsearch会自动的将新字段加入映射,但是这个字段的不确定它是什么类型,elasticsearch就开始猜,如果这个值是18,那么elasticsearch会认为它 是整形。 但是elasticsearch也可能猜不对, 所以最安全的方式就是提前定义好所需要的映射,这点跟关系型数据库殊途同归了,先定义好字段,然后再使用,别出现了错误。

索引

可以理解为数据库。

索引是映射类型的容器,elasticsearch中的索引是一个非常大的文档集合。索引存储了映射类型的字段 和其他设置。 然后它们被存储到了各个分片上了。 我们来研究下分片是如何工作的。 物理设计 :节点和分片如何工作

一个集群至少有一个节点,而一个节点就是一个elasricsearch进程,节点可以有多个索引默认的,如果创建索引,那么索引将会有个5个分片 ( primary shard ,又称主分片 ) 构成的,每一个主分片会有一个副本 ( replica shard ,又称复制分片 )

上图是一个有3个节点的集群,可以看到主分片和对应的复制分片都不会在同一个节点内,这样有利于某 个节点挂掉 了,数据也不至于丢失。 实际上,一个分片是一个Lucene索引,一个包含倒排索引的文件目录,倒排索引的结构使得elasticsearch在不扫描全部文档的情况下,就能告诉你哪些文档包含特定的关键字。

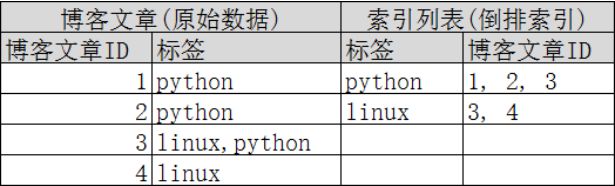

倒排索引

elasticsearch使用的是一种称为倒排索引的结构,采用Lucene倒排索作为底层。这种结构适用于快速的 全文搜索, 一个索引由文档中所有不重复的列表构成,对于每一个词,都有一个包含它的文档列表。 例 如,现在有两个文档, 每个文档包含如下内容:

Study every day, good good up to forever # 文档1包含的内容

To forever, study every day, good good up # 文档2包含的内容

为了创建倒排索引,我们首先要将每个文档拆分成独立的词(或称为词条或者tokens),然后创建一个包 含所有不重 复的词条的排序列表,然后列出每个词条出现在哪个文档 :

现在,我们试图搜索 to forever,只需要查看包含每个词条的文档 score

两个文档都匹配,但是第一个文档比第二个匹配程度更高。如果没有别的条件,现在,这两个包含关键 字的文档都将返回。

再来看一个示例,比如我们通过博客标签来搜索博客文章。那么倒排索引列表就是这样的一个结构 :

如果要搜索含有 python 标签的文章,那相对于查找所有原始数据而言,查找倒排索引后的数据将会快 的多。只需要 查看标签这一栏,然后获取相关的文章ID即可。完全过滤掉无关的所有数据,提高效率!

elasticsearch的索引和Lucene的索引对比 在elasticsearch中, 索引 (库)这个词被频繁使用,这就是术语的使用。 在elasticsearch中,索引被 分为多个分片,每份 分片是一个Lucene的索引。所以一个elasticsearch索引是由多个Lucene索引组成 的。别问为什么,谁让elasticsearch使用Lucene作为底层呢! 如无特指,说起索引都是指elasticsearch 的索引。

接下来的一切操作都在kibana中Dev Tools下的Console里完成。基础操作!

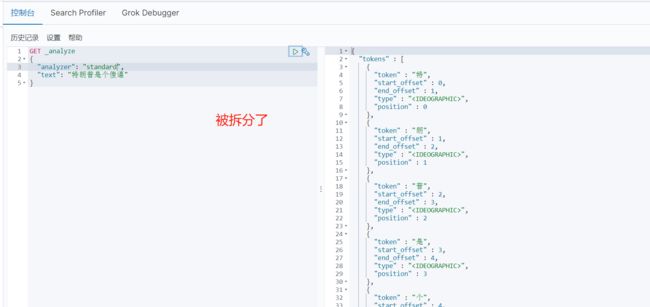

IK分词器

分词:即把一段中文或者别的划分成一个个的关键字,在搜索时候会把自己的信息进行分词,会把数据库中或者索引库中的数据进行分词,然后进行一个匹配操作,默认的中文分词是将每个字看成一个词,比如 “我是刘德华” 会被分为"我",“是”,“刘”,“德”,“华”,这显然是不符合要求的,所以需要安装中文分词器ik来解决这个问题。

如果要使用中文,建议使用ik分词器

IK提供了两个分词算法:ik_smart 和 ik_max_word,其中 ik_smart 为最少切分,ik_max_word为最细粒度划分

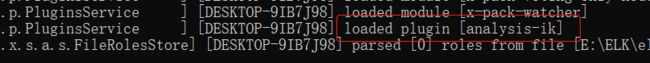

安装

- https://github.com/medcl/elasticsearch-analysis-ik

- 下载完毕后,放入到elasticsearch中的插件目录即可

- 重启ES,在控制台可以看到ik分词器被加载

- 使用命令

elasticsearch-plugin list可以查看加载进来的插件

- 使用kibana测试

ik_smart为最少切分

GET _analyze

{

"analyzer": "ik_smart",

"text": "美国政府"

}

ik_max_word为最细粒度划分,穷尽词库的可能

GET _analyze

{

"analyzer": "ik_max_word",

"text": "美国政府"

}

输入超级球星清姐

GET _analyze

{

"analyzer": "ik_smart",

"text": "超级球星清姐"

}

可以发现“清姐”被拆开了,这不是一个词语,需要自己加到分词器的字典中。

在IK分词器目录的config文件夹下新建young.dic文件

重启ES

重启后发现“清姐”被当作一个词语了,以后需要自己配置分词就在自己定义的dic文件中进行配置即可。

Rest风格说明

Rest风格是一种软件架构风格,而不是标准,只是提供了一组设计原则和约束条件。它主要用于客户端和服务器交互类的软件。基于这个风格设计的软件可以更简洁,更有层次,更易于实现缓存等机制。

基本Rest命令:

| method | url地址 | 描述 |

|---|---|---|

| PUT | localhost:9200/索引名称/类型名称/文档ID | 创建文档(指定文档ID) |

| POST | localhost:9200/索引名称/类型名称 | 创建文档(随机文档ID) |

| POST | localhost:9200/索引名称/类型名称/文档ID/_update | 修改文档 |

| DELETE | localhost:9200/索引名称/类型名称/文档ID | 删除文档 |

| GET | localhost:9200/索引名称/类型名称/文档ID | 通过文档ID查询文档 |

| POST | localhost:9200/索引名称/类型名称_search | 查询所有数据 |

关于索引的基本操作

创建一个索引

PUT /索引名称/~类型名称~/文档id

{

请求体}

索引的类型

- 字符串类型:text、keyword

- 数值类型:long、integer、short、byte、double、float、half_float、scaled_float

- 日期类型:date

- 布尔值类型:boolean

- 二进制类型:binary

- 等等…

通过PUT创建规则(字段类型)

通过GET获取具体的信息

查看默认的信息

如果自己的文档字段没有指定,那么es就会给索引默认配置字段类型

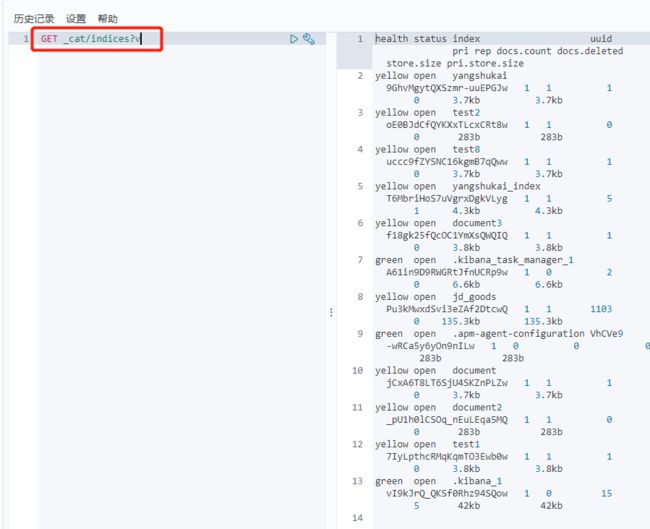

使用Cat命令查看信息

使用PUT命令修改文档

此命令会覆盖掉原来的数据

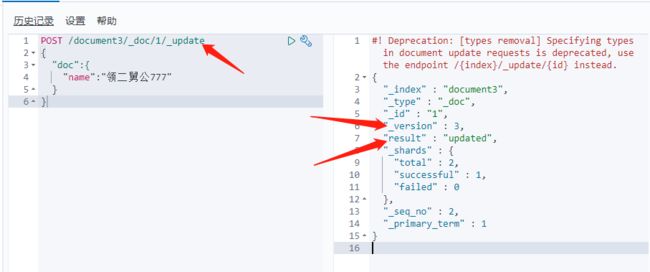

使用POST命令修改文档

使用_update后缀来修改可以指定修改文档,推荐使用此方法

关于文档的基本操作

添加数据

PUT /document1/user/1

{

"name":"runningyoung",

"age":342,

"desc":"学习elasticsearch",

"tags":["努力","细心","坚持"]

}

获取数据

GET /document1/user/1

更新数据

PUT

PUT /document1/user/1

{

"name":"runningyoung",

"age":342,

"desc":"学习elasticsearch的修改",

"tags":["努力","细心","坚持","修改"]

}

Post _update , 推荐使用这种更新方式

POST /document1/user/1/_update

{

"doc":{

"tags":["努力","细心","坚持","修改","AAA"]

}

}

简单条件查询

GET /document1/user/_search?q=name:runningyoung

复杂条件查询

GET /document1/user/_search

{

"query": {

"match": {

"name": "runningyoung"

}

}

}

GET /document1/user/_search

{

"query": {

"match": {

"name": "runningyoung"

}

}

, "_source": ["name","desc"]

}

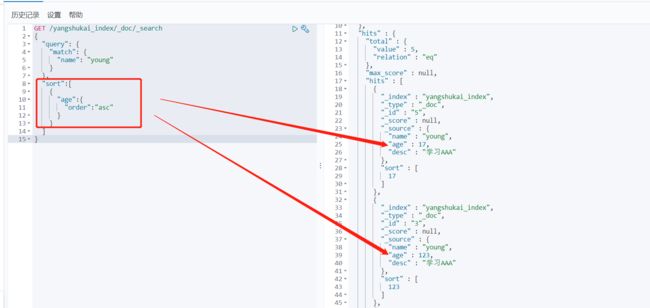

排序

GET /yangshukai_index/_doc/_search

{

"query": {

"match": {

"name": "young"

}

},

"sort":[

{

"age":{

"order":"asc"

}

}

]

}

分页查询

数据下标还是从0开始的,和学的所有数据结构是一样的 /search/{current}/{pagesize}

GET /yangshukai_index/_doc/_search

{

"query": {

"match": {

"name": "young"

}

},

"sort":[

{

"age":{

"order":"asc"

}

}

],

"from":0,

"size":1

}

布尔值查询

must相当于SQL语句的and,所有的条件都要符合(where id = 1 and name=XXX)

GET /yangshukai_index/_doc/_search

{

"query": {

"bool": {

"must":[

{

"match":{

"name":"young"

}

},

{

"match":{

"age":17

}

}

]

}

}

}

should相当于SQL语句的or,所有的条件都要符合(where id = 1 or name=XXX)

GET /yangshukai_index/_doc/_search

{

"query": {

"bool": {

"should":[

{

"match":{

"name":"young"

}

},

{

"match":{

"age":17

}

}

]

}

}

}

must_not相当于SQL语句的not

GET /yangshukai_index/_doc/_search

{

"query": {

"bool": {

"must_not":[

{

"match":{

"age":17

}

}

]

}

}

}

过滤器filter

- gt 大于

- gte 大于等于

- lt 小于

- lte 小于等于

GET /yangshukai_index/_doc/_search

{

"query": {

"bool": {

"must":[

{

"match":{

"name":"young"

}

}

],

"filter":{

"range":{

"age":{

"gte":1,

"lte":25

}

}

}

}

}

}

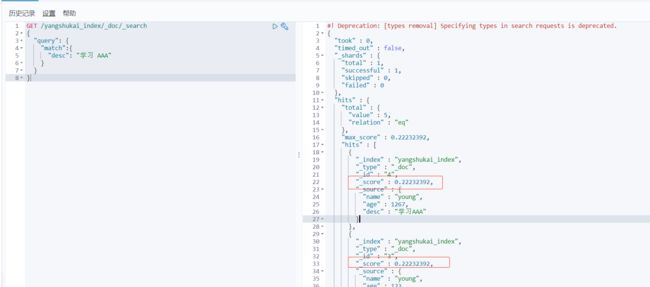

多条件匹配查询

多条件使用空格隔开,只要满足其中一个结果既可以被查出,这个时候可以通过分值基本的判断

GET /yangshukai_index/_doc/_search

{

"query": {

"match":{

"desc": "学习 AAA"

}

}

}

精确查询

term 查询是直接通过倒排索引指定的词条进程精确查找的

关于分词:

- term ,直接查询精确

- match,会使用分词器解析(先分析文档,然后在通过分析的文档进行查询)

两个类型:text、keyword(keyword字段类型不会被分词器解析)

GET _analyze

{

"analyzer": "keyword",

"text": "特朗普是个傻逼"

}

GET _analyze

{

"analyzer": "standard",

"text": "特朗普是个傻逼"

}

多值匹配精确查询

GET yangshukai_index/_search

{

"query": {

"bool": {

"should": [

{

"term": {

"age":17

}

},

{

"term": {

"age":123

}

}

]

}

}

}

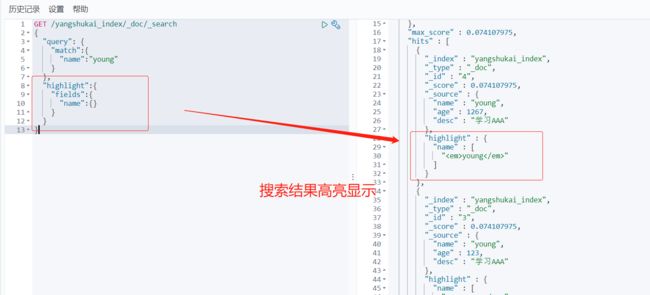

高亮查询

GET /yangshukai_index/_doc/_search

{

"query": {

"match":{

"name":"young"

}

},

"highlight":{

"fields":{

"name":{

}

}

}

}

自定义搜索高亮条件

GET /yangshukai_index/_doc/_search

{

"query": {

"match":{

"name":"young"

}

},

"highlight":{

"pre_tags":"",

"post_tags":"

",

"fields":{

"name":{}

}

}

}