XR技术词汇速查表

根据二八原则,认真搞明白一个新领域里的最核心的专业术语能够快速了解这个行业,并为之后的技术学习打下基础。本文提供XR行业相关的68个入口,供从业者参考。(编译资料来源:Unity XR Glossary)

-

360 Video:360视频。360 视频通常称之为全景视频,可同时展示当前位置全部视角的内容,这类视频的制作方式一般是通过专业全景相机或摄像机阵列进行拍摄,后期通过软件进行剪辑,处理画面拼接产生的接缝。360视频形式可以是通过摄像机捕捉到的现实世界的视频,也可以是通过CG技术制作的动画(比如在Unity中使用Timeline技术制作的动画),甚至是通过后期处理加入特效的视频。用户需要佩戴VR头显对360视频进行观看。

-

Ambisonic Audio:环绕立体声音频。这种音频技术能够呈现垂直于体验者方向上的声音,“全球面”技术还能够呈现水平方向上的不同位置的声音。环绕立体声音频以多通道格式存储,同时,声场能够根据XR中体验者的头部朝向而进行旋转。

-

Anti-Aliasing:抗锯齿。是一种平滑3D物体边缘锯齿状线条的技术,通过各种算法使边缘的颜色平均。抗锯齿技术在VR中尤为重要,明显的锯齿边缘会破坏体验的沉浸感。

-

API :英文全称Application Programming Interface,即应用程序编程接口,是软件开发中的一个常见概念。同时也贯穿整个AR和VR应用程序开发,开发者通过XR厂商提供的API,调用能够使用的资源,从而制作出能够运行在相应平台上的应用程序。

-

ARCore:Google的AR体验解决方案,适用于所有运行Android Nougat (Android 7.0)及以上系统的智能手机,能够实现与ARKit类似的AR体验。同时,ARCore 的SDK与ARKit也具有类似的功能。

-

ARCore SDK for Unity:使用Unity进行ARCore应用程序开发的工具包。

-

ARKit:一套能够为iPhone和iPad制作和发布AR应用程序的软件技术框架。

-

ARKit plugin:一个使用Unity进行ARKit应用程序开发的插件。

-

AR Light Estimation:AR 光源感知。在AR会话中,根据摄像头捕获的图像,对AR场景中光源信息的近似估算。

-

Audio Spatializer:音频空间化。一项能够改变音频在三维空间中传播方式的功能,根据AudioListener和AudioSource之间的距离和角度来调节声音在左右耳的不同增益,从而为体验者提供声音的方向指示。更具说服力的沉浸式声音,与VR内容的3D特性相得益彰。

-

Audio Spatializer SDK:音频空间化SDK。

-

Augmented Reality (AR):增强现实。增强现实是数字内容在现实世界之上的叠加,能够使用户同时与现实世界和数字元素进行交互。

-

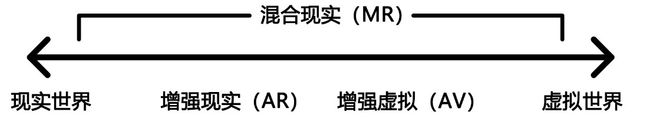

Augmented Virtuality:增强虚拟化,也就是将现实世界的对象带入可以与之交互的虚拟世界中。在混合现实体验中,增强虚拟化介于AR 和VR之间,如下图所示。

混合现实中现实与虚拟的连续性

-

Cinematic VR:VR电影。VR技术为电影制作人和观众提供了一种新的叙事模式,利用VR的沉浸式体验,能够显著提高观众的临场感。

-

Cyber Sickness:晕动症。类似于晕车体验,当人在物理空间移动而大脑感知却是静止时,通常会引起这种感受。在VR中,当体验者静止,而体验到非静止的图像画面时,也会引起晕动症的发生。

-

Direct3D Transformation Pipeline:Direct3D 转换管线。一种面向Windows Direct3D图形API的图形转换管线。

-

Eye Tracking:眼动追踪。通过头显内部的摄像头跟踪人眼的注视方向。 眼动追踪提供了一种新的输入交互方式,能够使体验者以更加舒适自然的方式与VR内容进行交互,例如,用于在游戏中瞄准目标。

-

Face Tracking:面部追踪。在检测到人脸的前提下,在后续帧中继续捕获人脸的位置及其大小等信息,包括人脸的识别和人脸的跟踪技术。

-

Field-of-View :缩写FOV ,视场。视场是在任一瞬间经由视觉可以看见的世界,也称为视野。

-

Foveated Rendering:注视点渲染。是一种新型图形计算技术,凭借降低注视点周围图像的分辨率来大幅降低计算复杂度,主要应用在集成了眼动追踪技术的VR头盔中。

-

Frames-Per-Second :缩写FPS,帧率。是用于测量显示帧数的量度,单位是每秒显示帧数。帧率是VR中的重要性能指标,因为帧数过低或掉帧,容易引起晕动症的发生。

-

Frustum Culling:视椎体剔除。场景中的摄像机通常具有近平面(near clip plane)和远平面(far clip plane)两个属性,决定了视点的起始位置,两个平面均垂直于摄像机方向,近平面决定摄像机能够渲染的最近位置, 远平面决定了摄像机所能渲染的最远位置。两个平面与视场(FOV)共同决定了一个摄像机所能看到的椎体空间。视椎体剔除技术使不在视椎体以内的对象不被渲染,从而提升了VR应用程序的性能。

-

Gaze Tracking:凝视追踪,同眼动追踪。跟追用户眼睛的方向和运动,有时将追逐数据用于输入。

-

Graphics Transformation Pipeline:图形转换管线。一种将使用Unity等引擎创建的对象现在用户视图中的方法,通常由OpenGL、Direct3D这样的应用程序接口完成。

-

Haptics :触觉反馈。通过向用户施加力、振动或运动来模拟虚拟场景中的触觉,能够增强VR体验中的沉浸感。

-

Headset:XR语境下,也常称之为Head-Mounted Display,缩写HMD,头戴式显示器,简称头显。通常采用类似护目镜的设备形式,用户佩戴于头部,覆盖或包围眼睛。 VR头显通常包含用于观看虚拟环境的屏幕和镜头,增强现实头显则包含用于观看虚拟内容的半透明屏幕。

-

Head Tracking:头部追踪。通过头显传感器得到用户头部的位置和朝向信息,从而进行XR中基本的输入和交互。例如,如果用户的 头部向一侧倾斜,头部追踪技术会将数据传递给计算机,使体验者在头显中能够看到对应倾斜以后的场景内容。

-

Immersion/ Immersive Experiences:沉浸/沉浸式体验。在XR语境下,沉浸是指体验者在感官上完全忘记现实世界中的感受而参与到虚拟世界中的交互中。沉浸式体验则是VR体验的关键特征,在VR中,体验者的眼镜、耳朵,甚至是手和身体都会参与其中,从而阻挡了任何来自现实世界的感觉或暗示。

-

Immersive Entertainment/Hyper-Reality:沉浸式娱乐/超现实体验。XR技术结合现实世界物理特性的娱乐、营销和体验内容。如The Void VR主题公园。

-

Inertial Measurement Unit:缩写IMU,惯性测量单元。是测量物体三轴姿态角(或角速率)以及加速度的装置。一个IMU内会装有三轴陀螺仪和三个方向的加速度计,来测量物体在三维空间中的角速度和加速度,并以此解算出物体的姿态。在VR情境下,IMU可用于头部追踪,以确定头显呈现的视图方向。与任何运动追踪系统一样,延迟和准确性是IMU的关键因素。三星的GearVR包括一个专用的IMU,而Google Cardboard和Daydream,则是依靠智能手机内置的IMU。

-

Input:输入。输入提供了人与机器、计算机或其他设备进行交互的方式。在VR/AR情境下,输入是指通过各种途径与虚拟物体交互的方法,包括使用控制器、游戏手柄、手势识别、语音控制等。

-

Inside-Out/Outside-In Tracking:由内而外的运动追踪/由外而内的运动追踪。详见本书第6.7节相关介绍。

-

Interpupillary Distance :缩写IPD,瞳距,即人两眼瞳孔之间的距离。体验者通过头显内部的两个透镜观看虚拟现实内容,为了能够匹配不同用户的瞳距,一些头显能够手动调节两个透镜之间的水平距离,以达到良好的观看效果。

-

Latency:延迟。延迟是虚拟世界对用户的运动做出反应的速度,是影响XR整体体验质量的重要因素。越低的延迟,体验会越舒适流畅。经验上来说,延迟低于20毫秒通常能够带来比较良好的体验。

-

Light Field Technology:光场技术。光场描述的是空间中某一点沿着一定方向的光线辐射度值,该空间所有的有向光线集就构成光场数据库。光场技术将各种计算机图形显示技术、硬件和图像处理解决方案组合在一起,可以先拍摄图像或视频,光圈和焦点可以在后期进行调整。该技术由Lytro公司首创,光场相机的工作方式与现代数码相机基本类似,但是需要使用由大约200,000个微小镜头构成的“微透镜阵列”,用于捕捉无数不同的视角。

-

Light Field Video:光场视频。利用光场技术,结合传统的数码单反相机和Lytro Illum相机进行拍摄的视频,在视频处理后期中对画面进行重新聚焦、改变视图、改变光圈等。

-

Low-Persistence Display:低余晖显示技术。受限于早期VR技术,在用户快速移动的过程中,屏幕容易导致视觉模糊出现拖影,即余晖现象。低余晖显示技术能够是解决此问题的方法。在Google Daydream提供的规范中,低余晖显示便是其中一项重要指标;而在三星GearVR 方案中,当手机插入头显时便启用该技术,在头显外部看来,屏幕呈现快速闪烁的状态。

-

Mixed Reality:缩写MR,混合现实。混合现实体验将用户的真实环境和使用数字技术创建的CG内容无缝融合,两种环境可以共存并相互交互。MR可被认为是一种VR和AR结合的连续统一形态。

-

Mixed Reality Capture:混合现实捕捉。混合现实捕捉功能可将现实世界的对象放入 VR 环境中,将 来自现实世界的图像与虚拟世界的图像混合。该技术使用外部摄像头针对绿屏捕捉现实世界的图像,然后将这些图像与 VR 应用程序生成的场景组合, 用于创建单一混合场景。用户随后可与该 VR 场景互动,并可创建 展示用户在现实世界中的互动与 VR 体验叠加 的视频。

通过混合现实捕捉技术生成的视频内容

-

Motion-to-Photon Latency:运动到光子延迟。是在现实世界中发生实际运动与眼睛从头显屏幕接收到反映此变化的光子之间的时间。

-

Motion Tracking:运动追踪。跟踪和记录用户和物体在现实世界的运动,将追踪信息作为输入并在虚拟世界中复现这些运动。

-

Multi-Pass Stereo Rendering:多通道立体渲染。在VR头显中,为了能够给体验者提供立体3D图像,需要为每只眼睛渲染场景画面,然后呈现到对应的左右眼屏幕上,多通道立体渲染性能要低于单通道立体渲染(Single-Pass Stereo Rendering)。

-

Non-Gaming Virtual Reality/Augmented Reality:除游戏以外的VR体验内容,如使用VR技术开发的教育应用程序、医疗培训软件、建筑可视化、军事模拟、营销体验,零售应用、创意工具等。这些类型的体验是目前VR内容的重要部分。随着越来越多的行业逐渐开始使用VR技术,VR行业生态也在逐渐完善。

-

OpenGL Transformation Pipeline:OpenGL图形转换管线,OpenGL是用于渲染2D、3D矢量图形的跨语言、跨平台的应用程序接口(API)。OpenGL 转换发生在OpenGL 管线中,具有与一般图形转换管线相同的过程(可参见Graphics Transformation Pipeline词条) 。

-

OpenVR SDK/API:由Valve发布的SDK和API,用于为基于SteamVR 运行的VR设备开发应用程序。相比之下,OpenXR是一个更广泛的工作组,旨在建立一套通用标准,以支持与VR/AR相关的内容、工具、硬件的创建和分发。

-

OpenXR: OpenXR是由Khronos Group管理的一个工作组,旨在设计一个面向虚拟现实(VR)和增强现实(AR)的统一标准,解决行业标准碎片化的问题。Khronos Group于2017年2月27日在GDC 2017期间宣布了OpenXR。

-

Panoramic 2D/3D Video:全景2D/3D 视频,同360视频词条。

-

Positional Tracking:位置追踪。位置跟踪是实时记录用户移动和对象移动的技术,可检测空间中的头显、控制器以及其他对象的精确位置,然后将数据再现为虚拟世界中的交互。

-

Post FX for VR:用于VR中的后处理特效,或也成为后处理堆栈(Post Processing Stack),提供在VR场景创建后应用的各种视觉效果。后处理堆栈将一整套图像效果组合到一个后处理流水线中,能够产生高品质的画面效果。

-

Presence (or 'Sense of Presence'):临场感。类似于沉浸感,使用户在虚拟世界中获得与现实世界无异的体验。

-

Render Loop/Render Pipeline:渲染管线。一套决定如何将一帧画面渲染呈现的逻辑架构。典型的渲染管线可按照如下顺序进行:剔除>阴影>不透明>透明>后处理>呈现。图形转换管线(见词条Graphic Transformation Pipeline)负责将对象的空间坐标转换为屏幕坐标,渲染管线则负责将对象呈现在屏幕上。

-

Render Target :渲染目标。被指定绘制的场景中的一部分,引擎会将其存储在内存缓冲区或渲染纹理(Render Texture)中,然后叠加呈现在用户的头显或屏幕上。

-

Render Texture:渲染纹理。渲染纹理是唯一一种在运行时创建和更新的纹理。在Unity中,可以创建一个Render Texture,用于在程序运行时呈现指定摄像机的渲染内容。

-

Scene Graph:场景图。是一种组织和管理三维虚拟场景的数据结构。

-

Screen Resolution:屏幕分辨率。屏幕分辨率是指屏幕上显示的像素数量。就像电脑显示器或电视一样,存在的像素越多,图像质量就越清晰,越逼真。对于VR头显的屏幕分辨率,因为图像距离人眼距离较近,所以需要更高的屏幕分辨率,使用户不会察觉到各个像素之间的间隙。分辨率较低的头显屏幕,容易产生纱窗效应。

-

Single-Pass Stereo Rendering:单通道立体渲染。是一种将两只眼睛的图像同时渲染到一个渲染纹理(Render Texture)中的技术,也就是说整个场景只渲染一次。

-

Six Degrees of Freedom: 六自由度,缩写为6DOF,是指物体在三维空间中的运动自由度,包括三个位置轴与三个旋转轴,即位置和旋转。相对应的,三自由度(3DOF)只包括旋转自由度。

-

SLAM:是Simultaneous Localization and Mapping的缩写,即同步定位与地图构建,指搭载特定传感器的主体,在空间运动过程中建立环境的模型,是自动驾驶汽车、家用机器人和AR应用的关键计算机视觉技术。

-

Spatial Audio / 3D Audio:空间音频。是一套可以操控立体声扬声器、环绕声扬声器、扬声器阵列或者耳机所产生声音的音频技术。空间音频使体验者能够在VR虚拟环境中判定声源的位置,对VR体验的临场感和沉浸感具有重要意义。

-

Stereoscopy:立体成像。是一种通过双目视觉立体视觉创建或增强图像深度错觉的技术。该技术提供同一场景的两个不同图像,一个用于体验者的左眼,另一个用于右眼,体验者的大脑将两个图像组合起来构建具有深度和透视的3D场景,VR头显中的左右眼成像便是基于这一原理。

-

Stereo Instancing:立体实例化。是单通道立体渲染技术的演变形式,能够进一步优化VR应用程序性能。

-

Tracked Pose Driver:跟踪姿态驱动。Unity内置的跨平台驱动程序组件,通过将真实设备或对象的位置和旋转与其姿势(相应虚拟对象的位置)相匹配,简化了对玩家移动和外围设备的跟踪设置。

-

Uncanny Valley:恐怖谷理论。是一个关于人类对机器人和非人类物体的感觉的假设。

-

Vestibular System:前庭系统。是内耳中主管头部平衡运动的一组装置,使人类能够平衡和理解自己的运动,视觉和前庭系统感觉的不匹配是产生晕车和VR中晕动症的原因。

-

Volumetric Video:体积视频。一种新兴的视频形态,包含空间数据信息并且允许用户在其内部移动。

-

WebAR:一种AR开放标准,使用户可以在浏览器中体验AR而不必下载安装应用程序。WebAR对移动设备尤为重要,网站可以通过智能手机浏览器提供AR体验。

-

WebVR:一种VR开放标准,提供通过浏览器体验VR的方式,而不必首先下载安装指定的应用程序。用户仅使用头显和网页浏览器即可获得更易于访问的VR内容,而不需要引入高端计算硬件的成本,这为内容创作者提供更大的潜在受众群体。

-

XR:XR中的X可以看做是V(R)、A(R)、M(R)的占位符,也可以看做是以上三种技术形态的统称。

欢迎关注我的微信号:XR技术研习社