全面回顾2020年图机器学习进展,12位大神论道、寄望2021年大爆发

2021-01-10 18:22:01

作者 |Michael Bronstein

编译 | Mr.Bear

编辑 | 陈大鑫

图机器学习在 2020 年大放异彩,各种新理论和新应用精彩纷呈。

就在近日,伦敦帝国理工学院教授、推特图学习研究负责人Michael Bronstein与图机器学习领域的多位资深研究者进行了深入交流,对该领域在过去的一年中的进展进行了较为全面的盘点,并预测了未来发展的方向。

1 消息传递机制

Will Hamilton,麦吉尔大学助理教授,Mila 的 CIFAR 主席,GraphSage作者。

「2020 年,图机器学习领域开始受限于消息传递范式的本质缺陷。」

上述缺陷包含人们常说的「瓶颈」、「过平滑」[2]等问题,以及表征能力的理论限制[3,4]。展望未来,我们希望研究人员在 2021 年开始寻找图机器学习的下一种核心范式。目前,我们还不确定下一代图机器学习算法应该是怎样的,但是我们相信该领域的进步有赖于大家摆脱在 2020 年及以前占据主导地位的消息传递机制。

在 2021 年,我们希望图机器学习技术能够走进更具影响力和挑战性的应用领域。近年来,有太多研究工作都着眼于简单、同质化的节点分类任务。此外,我们还希望能看到该领域能够在需要更复杂的算法推理的任务上取得方法论上的研究进展(例如,涉及知识图谱、强化学习,以及组合优化等问题的任务)。

2 算法推理

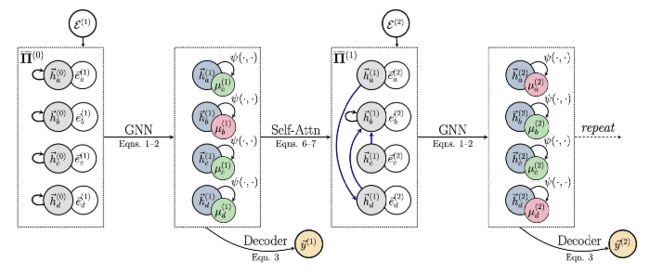

图 1:指针图网络(Pointer Graph Networks)融合了来自经典计算机科学的结构化归纳偏置。

Petar Veličković,DeepMind 高级研究员,图注意力网络(GAT)作者。

显然,图表征学习在 2020 年已经不可逆转地成为了机器学习领域最受瞩目的课题之一。

在 2020 年,图机器学习领域取得了不胜枚举的研究进展,神经算法推理是最令人振奋的课题之一。传统意义上,神经网络在插值方面十分强大,但是众所周知,神经网络是一种较差的外推器(extrapolator)。

由于推理的主要特征之一就是能够在训练数据分布之外发挥作用,因此神经网络的推理能力不足。推理任务可能是进一步发展图神经网络(GNN) 的理想场景,这不仅因为我们认为 GNN 非常适用于推理任务,还因为许多真实世界中的图任务具有同质性,这意味着更加简单的 GNN 往往是最有效且可扩展的[6,7]。

基于历史上的神经图灵机[8]、可微神经计算机[9]等神经执行器(neural executors)的成功,受益于现在广为使用的各种图机器学习工具包,2020 年发表的一些研究工作从理论上探究了神经执行器的缺陷[5,10,11],提出了一些基于 GNN 的强大的新推理架构[12-15],并且在神经推理任务上具有完美的泛化性能[16]。在 2021 年,这样的架构可以自然而然地促进组合优化研究领域[17]的发展,我们也非常希望看到预训练的算法执行器可以帮助我们将经典算法应用到未经处理的、甚至不适合这些算法的输入上。

例如,XLVIN 智能体[18]正是使用了上述概念。它使 GNN 在即使不知道底层具体的马尔科夫决策过程(MDP)的情况下,也可以在强化学习工作流程中执行「值迭代」式的算法。我们相信在 2021 年,将 GNN 广泛应用于强化学习的时机将会成熟。

3关系结构发现

图 2:GNN 使我们可以学习用于解释多粒子系统(左图)的状态转移图(右图)。

Thomas Kipf,谷歌大脑研究科学家,图卷积网络(GCN)作者。

自从最近基于 GNN 的模型被广泛采用以来,图机器学习社区中一个值得注意的趋势是:将计算结构与数据结构分离开来。

在 ICML 2020 的研讨会演讲「关系结构发现」中,我介绍了这一趋势。通常而言,我们设计的图神经网络会在一个由数据集给出的固定(或者按时序演进)的结构上传递消息,即数据集的节点和边会被作为计算结构或我们模型的消息传递结构的金标准。在 2020 年,我们已经看到人们对能够适应计算结构(也就是使用哪些部件作为节点,在哪些节点对之间进行消息传递)的模型越来越感兴趣,而不仅仅是基于注意力的模型。

2020 年发表的「Amortised Causal Discovery」是该领域的一个颇有影响力的例子[19,20],它使用了神经关系推理技术根据时间序列数据来推理因果图。该领域的其它重要工作还包括:具有可学习指针的 GNN[21,15]、具有关系机制的GNN[22,23]、通过自适应的计算图学习基于网格的物理仿真器[24]、学习推理执行计算的抽象节点的模型[25]。

这些研究进展具有广泛的启发意义,使我们可以有效地在其它的领域(例如文本或视频处理)利用 GNN 架构提供的对称性(例如,节点排列等变性)和归纳偏置(例如,对成对的交互函数建模)。

展望未来,我们希望可以看到在给定数据和任务的情况下,如何通过不依赖于显式的监督学习最优的计算图结构(同时考虑节点和关系)。通过仔细分析这些学习到的结构,我们可能获得更好的对于模型为了解决任务而执行的计算的解释,并且可能使我们进一步类比因果推理。

4表达能力

Haggai Maron,英伟达研究科学家,「provably expressive high-dimensional graph neural networks」作者。

图神经网络的表达能力是 2020 年图机器学习领域的核心问题之一。

2020 年,有许多优秀的论文讨论了各种 GNN 架构的表达能力[27],指出了由于深度和宽度的限制,导致 GNN 存在根本上的表达能力局限性[28]。此外,也有一些工作描述了 GNN 可以检测出怎样的结构并对其进行计数[28],说明使用固定数量的 GNN 对于许多图任务并没有意义。在论文「Towards scale-invariant graph-related problem solving by iterative homogeneous graph neural networks」中,作者则提出了一种迭代式的 GNN,可以学会自适应地终止消息传递过程[14]。

在 2021 年,我们希望看到研究社区在「条理化的图生成模型方法」,「基于 GNN 的图匹配与 GNN 的表达能力之间的联系」,「学习图像、音频等结构化数据的图」等方面取得进展。此外,我们还期待 GNN 研究社区和计算机视觉研究社区在场景图领域有更深入的合作。

5可扩展性

Matthias Fey,多特蒙德工业大学博士生,PyTorch Geometric和 Open Graph Benchmark的作者。

2020 年,解决 GNN 的可扩展性问题是图机器学习研究领域最热门的话题之一。

近年来,一些方法依赖于通过将预测与传播的过程解耦来简化底层的计算。有大量的论文直接将不可训练的传播方案作为预处理[30,7]或后处理[6]步骤与「图无关」的模块结合起来。这会使得运行时间得到显著的优化,尤其是在同质图上的性能并没有下降。

随着使用越来越大的数据集,我们希望看到图学习的可扩展性有更大的进展,以及如何以一种可扩展的方式使用可训练的、表达能力强的消息传播。

6 动态图图 3:动态图示例

Emanuele Rossi,Twitter 机器学习研究员、帝国理工博士生,Temporal Graph Networks作者。

许多有趣的图机器学习应用本质上是动态的,其中图的拓扑结构和属性都会随着时间演化。

在社交网络、金融交易网络或「用户-物料」交互网络中,我们往往面对的就是动态图场景。直到最近,绝大多数图机器学习的研究重点关注的仍然是静态图。现有的少量尝试研究动态图的工作主要考虑的是「离散时间动态图」,即一系列在规则的时间间隔上对图进行快照。在 2020 年,我们看到一些关于更普适化的「连续时间动态图」的工作涌现了出来[31-34],我们可以将这种动态图视为时序时间的异步流。此外,第一批动态图模型的有趣的成功应用也诞生了:虚假账户检测[35]、欺诈检测[36]、流行病传播控制[37]等。

目前,我们仍然只是触及了这个令人振奋的研究方向的皮毛,许多有趣的问题还有待解决。其中,重要的开放性问题包括可扩展性、对于动态模型更好的理论解释、在同一个框架中结合信息在时间和空间上的传播。我们还需要更加可靠和更具挑战性的对比基准,从而保证研究进展可以被更好地评估和跟踪。最后,我们希望看到动态图神经网络更成功的应用,特别是在工业领域。

7 新的硬件

图 4:Graphcore 是一家为图模型开发新型硬件的半导体公司。

Mark Sarougim,Graphcore机器学习工程师。

在我所共事过的人中,我想不出还有谁没有在生产中部署过图神经网络,或者正考虑这么做。

以往,自然语言处理、蛋白质设计、分子特性预测等应用中的自然的图结构往往会被忽视,而这些数据会被作为适用于现有的机器学习模型(例如 Transformer)的序列输入。然而,Transforemer 只不过是将注意力作为邻居节点之间聚合函数的 GNN(https://thegradient.pub/transformers-are-graph-neural-networks/)。在计算过程中,有些算法之所以取得很好的效果并不是因为它们适用于某种任务,而是因为它们在现有的硬件上运行良好,我们将这种现象称为「硬件彩票」[38],而 Transformer 在 GPU 上运行取得的效果就属于这种情况。

在 Graphcore,研究人员已经构建了一种新的多指令流多数据流(MIMD)架构,它具有 1,216 个可以并行运行 7,296 个程序的核心,我们将其称为智能处理单元(IPU)。这种架构非常适用于对 GNN 的加速。Graphcore 的 Polar 软件栈利用稀疏性将计算图的不同节点分配给不同的核。对于能够装载入 IPU 的 900MB 片上内存的模型,这种新的架构大大提高了 GPU 的吞吐量,只需几行代码就可以将模型分布到数千个 IPU 上。

目前,Graphcore 的用户利用这些优势构建了大量的研究工作,例如:SLAM 的光束法平差、使用局部更新训练深度网络、加速一系列粒子物理学中的问题。

8 在工业界的应用

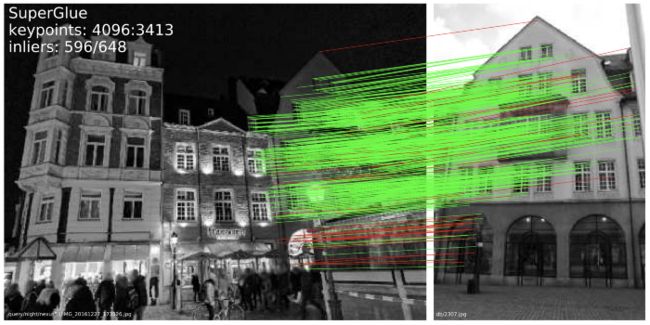

图 5:MagicLeap 的 SuperGlue 将 GNN 用于解决经典的计算机视觉问题——特征匹配。

Sergey Ivanov,Criteo 研究科学家,《Graph Machine Learning newsletter」》编辑。

对于图机器学习研究领域来说,2020 年是令人震惊的一年。所有的机器学习会议都包含 10-20% 有关该领域的投稿。因此,每个人都可以找到自己感兴趣的有关图的课题。

谷歌Graph Mining团队在 NeurIPS 上表现十分抢眼。从这份 312 页的演示文稿(https://gm-neurips-2020.github.io/master-deck.pdf)中,我们可以看出谷歌在生产环节中对图的使用已经超越了竞争对手们。谷歌对图机器学习技术的应用包括:使用时空 GNN 对 COVID-19 进行建模、欺诈检测、隐私保护等。此外,DeepMind 还在谷歌地图上推出了用于全球旅行时间预测的 GNN。该方法的一个有趣的技术细节是:他们将强化学习模型融合到了单个 batch 中,用于选择相似的采样得到的子图,从而训练 GNN 的参数。该方法和先进的超参数调优策略使实时到达时间的估计准确率提升了 50% 以上。

Magic Leap 是另一个值得注意的 GNN 应用,它被专门用于 3D 计算机生成图形。它们的 SuperGlue 架构将 GNN 用于图像中的特征匹配[39],这是三维重建、位置识别、定位和制图领域的重要课题。这种端到端的特征表征与最优传输优化相结合,在实时的室内和室外姿态估计任务中取得了优异成绩。而上述成果只是研究者们在 2020 年取得成果的冰山一角。

在 2021 年,我们相信可以看到图机器学习在工业环境下的进一步应用。相关的进展包括生产流程和框架、新型开源图数据集、GNN 在电子商务、工程设计,以及制药工业方面的大规模部署。

9 在物理学的应用

图 6:通过图表示的粒子射流。GNN 被用于检测粒子物理学中的现象。

Kyle Cranmer,纽约大学物理教授,希格斯玻色子的发现者之一。

我们惊讶地发现,图机器学习在过去的两年中已经在物理学研究领域盛行。

早期在粒子物理学中使用深度学习的工作常常迫使将数据表示成图像的形式以用 CNN 处理。由于粒子物理学领域的数据不是网格状的,并且图像表征十分稀疏,所以这种工作机制并不自然,而图可以更自然地表征粒子物理学数据[40,41]。

大型强子对撞机的研究人员现在正致力于将图机器学习集成到每秒处理数十亿次碰撞的实时数据处理系统中。通过部署推理服务器将图机器学习与实时数据采集系统集成[42],并且在可编程门阵列(FPGA)和其他特殊硬件[43]上实现这些算法,可以实现这一目标。

在 2020 年,图机器学习的一大亮点是它的归纳偏置可以与符号方法配合使用。例如,我们可以使用 GNN 学习如何预测各种动力系统,然后对沿着边上传输的消息进行符号回归[44]。我们不仅能够恢复出真实的力学定律,还可以在没有真实标注的情况下提取方程。令人惊讶的是,提取到的符号方程可以被重新引入到 GNN 中,替换原来学习到的部分,因此我们可以更好地泛化到训练数据分布之外的情况。

10 在医疗领域的应用

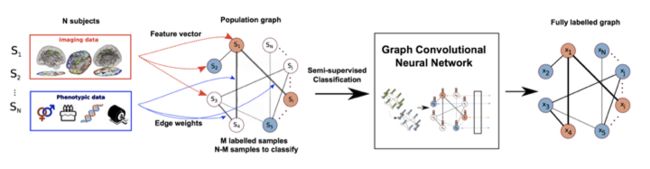

图 7:GNN 可以将患者关系图用于疾病诊断。

Anees Kazi,慕尼黑工业大学博士生,发表过多篇将图机器学习用于医学影像的论文。

在医学领域中,图机器学习转变了我们分析多模态数据的方式,这种方式与医学专家在临床中根据所有可知的维度观察病人情况的方式非常相近。

近年来,医学影像与医疗保健应用领域[45]中与图机器学习相关的研究纷纷涌现了出来,包括脑图像分割[46]、使用 MRI/fMRI 数据的旨在预测疾病的脑部结构分析[47],以及药物作用分析[48]。

2020 年,一些图机器学习领域的课题在医学领域中十分突出:

(1)潜在图学习[22,49,50],由于根据经验为给定的数据定义一个图一直是获得最优输出的瓶颈,研究人员通过自动学习潜在的图结构解决了这一问题。

(2)数据填充[51],由于缺失数据是许多医学数据集长期存在的问题,基于图的方法可以利用图邻域的关系帮助我们对数据进行填充。

(3)图机器学习模型的可解释性[52],由于对于临床医生和技术专家来说,为了将图机器学习模型可靠地整合到计算机辅助系统中,他们非常关注对图机器学习模型的输出进行推理。当然,新冠病毒的大流行是 2020 年医学领域的研究热点,而图机器学习方法也被用于 COVID-19 的检测[53]。

2021 年,图机器学习模型可以被进一步用于提升机器学习模型的可解释性,从而做出更好的决策。此外,我们发现图机器学习方法对于图结构仍然十分敏感,因此对于图扰动和对抗攻击的鲁棒性也是一个重要的课题。最后,将自监督学习引入被用于医学领域的图机器学习也是十分有趣的研究课题。

11在生物信息学的应用

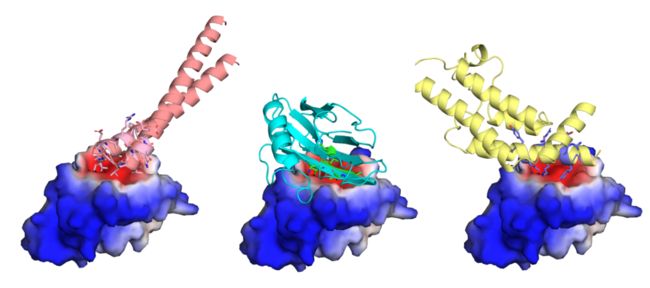

图 8:使用集合机器学习架构 MaSIP 设计的不同肿瘤靶蛋白结合物。

Bruno Correia,洛桑联邦理工学院助理教授,蛋白质设计与免疫工程实验室主任,MaSIF的开发者之一。

2020 年,作为生物信息学领域中的一个关键问题,蛋白质结构预测取得了激动人心的进展,分子表面的化学和几何模式对蛋白质功能至关重要。

基于表面的分子表征已经被研究人员使用了几十年,但它们对机器学习方法提出了挑战。几何深度学习领域的方法为蛋白质建模领域带来了令人印象深刻的能力,因为它们能够处理不规则数据,尤其适合于蛋白质表示。在 MaSIF[1] 中,作者将几何深度学习用于基于网格的分子表面表征,从而学习使我们能够预测蛋白质与其它分子交互(蛋白质与代谢物)的模式,并将对接计算的速度提高了几个数量级。反过来,这可以促进规模大得多的蛋白质-蛋白质交互网络预测。

在对 MaSIF 框架[2]接下来的开发中,作者成功地生成了表面和化学的特征,避免了所有的预先计算。作者认为这些进展将会对蛋白质和小分子设计产生革命性的影响,从长远来看,这些成果可能有助于加快生物药物的研发。

12 在生命科学的应用

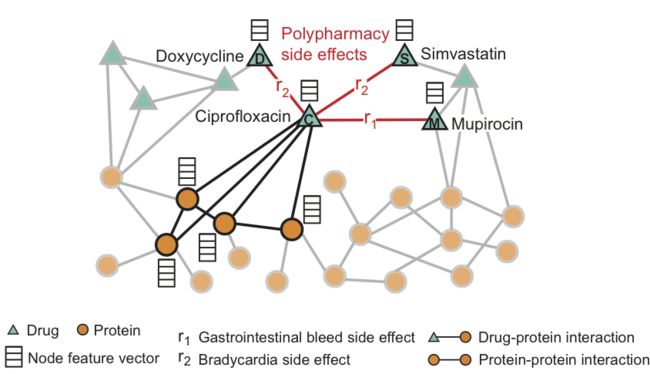

图 9:被用于复方药物副作用预测十边形的 GNN。

Marinka Zitnik,哈佛大学医学院生物医学信息学助理教授,Decagon的作者。

看到图机器学习在 2020 年进军生命科学领域令人十分振奋。

我们已经看到,图神经网络不仅在精心设计的对比基准数据集上性能优于之前的方法,还为研发新药开辟了新的途径,这对人们有很大的帮助。图神经网络还可以帮助人们在从根本上理解自然。相关的重要研究工作包括:单细胞生物学[56]、蛋白质和结构生物学[54,57]、重定位等方面的研究进展[59]。

几个世纪以来,科学方法(科学家们用来系统地、逻辑化地解释自然世界的科学的基本实践)在很大程度上保持不变,我们希望在 2021 年,科学家们可以使用图机器学习为其带来实质性的进展。为了实现这一目标,我们需要设计一些方法来优化并操纵网络化的系统并预测它们的行为。例如,从疾病的角度来看,基因组学如何影响人类的特征。这些方法需要能够应对受干扰和人为干预的数据(而不仅仅是处理现实世界中观测到的数据)。

同时,我们还希望研究者们能够开发出更多的方法来学习可操作的表征,它们可以很容易地成为科学上可执行的假设。这些方法使我们可以在高风险的环境下做出决策(例如,化学测试、粒子物理学、人类临床试验),在这种情况下我们需要精确、鲁棒、可解释的预测结果。

原文链接:

https://towardsdatascience.com/predictions-and-hopes-for-graph-ml-in-2021-6af2121c3e3d

参考文献

[1] U. Alon and E. Yahav, On the bottleneck of graph neural networks and its practical implications (2020) arXiv:2006.05205.

[2] Q. Li, Z. Han, X.-M. Wu, Deeper insights into graph convolutional networks for semi-supervised learning (2019) Proc. AAAI.

[3] K. Xu et al. How powerful are graph neural networks? (2019) Proc. ICLR.

[4] C. Morris et al. Weisfeiler and Leman go neural: Higher-order graph neural networks (2019) Proc. AAAI.

[5] K. Xu et al. What can neural networks reason about? (2019) arXiv:1905.13211.

[6] Q. Huang et al. Combining label propagation and simple models out-performs graph neural networks (2020) arXiv:2010.13993.

[7] F. Frasca et al. SIGN: Scalable Inception Graph Neural Networks (2020) arXiv:2004.11198.

[8] A. Graves, G. Wayne, and I. Danihelka, Neural Turing Machines (2014) arXiv:1410.5401.

[9] A. Graves et al. Hybrid computing using a neural network with dynamic external memory (2016). Nature 538:471–476.

[10] G. Yehuda, M. Gabel, and A. Schuster. It’s not what machines can learn, it’s what we cannot teach (2020) arXiv:2002.09398.

[11] K. Xu et al. How neural networks extrapolate: From feedforward to graph neural networks (2020) arXiv:2009.11848.

[12] P. Veličković et al., Neural execution of graph algorithms (2019) arXiv:1910.10593.

[13] O. Richter and R. Wattenhofer, Normalized attention without probability cage (2020) arXiv:2005.09561.

[14] H. Tang et al., Towards scale-invariant graph-related problem solving by iterative homogeneous graph neural networks (2020) arXiv:2010.13547.

[15] P. Veličković et al. Pointer Graph Networks (2020) Proc. NeurIPS.

[16] Y. Yan et al. Neural execution engines: Learning to execute subroutines (2020) Proc. ICLR.

[17] C. K. Joshi et al. Learning TSP requires rethinking generalization (2020) arXiv:2006.07054.

[18] A. Deac et al. XLVIN: eXecuted Latent Value Iteration Nets (2020) arXiv:2010.13146.

[19] S. Löwe et al., Amortized Causal Discovery: Learning to infer causal graphs from time-series data (2020) arXiv:2006.10833.

[20] Y. Li et al., Causal discovery in physical systems from videos (2020) Proc. NeurIPS.

[21] D. Bieber et al., Learning to execute programs with instruction pointer attention graph neural networks (2020) Proc. NeurIPS.

[22] A. Kazi et al., Differentiable Graph Module (DGM) for graph convolutional networks (2020) arXiv:2002.04999

[23] D. D. Johnson, H. Larochelle, and D. Tarlow., Learning graph structure with a finite-state automaton layer (2020). arXiv:2007.04929.

[24] T. Pfaff et al., Learning mesh-based simulation with graph networks (2020) arXiv:2010.03409.

[25] T. Kipf et al., Contrastive learning of structured world models (2020) Proc. ICLR

[26] F. Locatello et al., Object-centric learning with slot attention (2020) Proc. NeurIPS.

[27] W. Azizian and M. Lelarge, Characterizing the expressive power of invariant and equivariant graph neural networks (2020) arXiv:2006.15646.

[28] A. Loukas, What graph neural networks cannot learn: depth vs width (2020) Proc. ICLR.

[29] Z. Chen et al., Can graph neural networks count substructures? (2020) Proc. NeurIPS.

[30] A. Bojchevski et al., Scaling graph neural networks with approximate PageRank (2020) Proc. KDD.

[31] E. Rossi et al., Temporal Graph Networks for deep learning on dynamic graphs (2020) arXiv:2006.10637.

[32] S. Kumar, X. Zhang, and J. Leskovec, Predicting dynamic embedding trajectory in temporal interaction networks (2019) Proc. KDD.

[33] R. Trivedi et al., DyRep: Learning representations over dynamic graphs (2019) Proc. ICLR.

[34] D. Xu et al., Inductive representation learning on temporal graphs (2019) Proc. ICLR.

[35] M. Noorshams, S. Verma, and A. Hofleitner, TIES: Temporal Interaction Embeddings for enhancing social media integrity at Facebook (2020) arXiv:2002.07917.

[36] X. Wang et al., APAN: Asynchronous Propagation Attention Network for real-time temporal graph embedding (2020) arXiv:2011.11545.

[37] E. A. Meirom et al., How to stop epidemics: Controlling graph dynamics with reinforcement learning and graph neural networks (2020) arXiv:2010.05313.

[38] S. Hooker, Hardware lottery (2020), arXiv:2009.06489.

[39] P. E. Sarlin et al., SuperGlue: Learning feature matching with graph neural networks (2020). Proc. CVPR.

[40] S. Ruhk et al., Learning representations of irregular particle-detector geometry with distance-weighted graph networks (2019) arXiv:1902.07987.

[41] J. Shlomi, P. Battaglia, J.-R. Vlimant, Graph Neural Networks in particle physics (2020) arXiv:2007.13681.

[42] J. Krupa et al., GPU coprocessors as a service for deep learning inference in high energy physics (2020) arXiv:2007.10359.

[43] A. Heintz et al., Accelerated charged particle tracking with graph neural networks on FPGAs (2020) arXiv:2012.01563.

[44] M. Cranmer et al., Discovering symbolic models from deep learning with inductive biases (2020) arXiv:2006.11287. Miles Cranmer is unrelated to Kyle Cranmer, though both are co-authors of the paper. See also the video presentation of the paper.

[45] Q. Cai et al., A survey on multimodal data-driven smart healthcare systems: Approaches and applications (2020) IEEE Access 7:133583–133599

[46] K. Gopinath, C. Desrosiers, and H. Lombaert, Graph domain adaptation for alignment-invariant brain surface segmentation (2020) arXiv:2004.00074

[47] J. Liu et al., Identification of early mild cognitive impairment using multi-modal data and graph convolutional networks (2020) BMC Bioinformatics 21(6):1–12

[48] H. E. Manoochehri and M. Nourani, Drug-target interaction prediction using semi-bipartite graph model and deep learning (2020). BMC Bioinformatics 21(4):1–16

[49] Y. Huang and A. C. Chung, Edge-variational graph convolutional networks for uncertainty-aware disease prediction (2020) Proc. MICCAI

[50] L. Cosmo et al., Latent-graph learning for disease prediction (2020) Proc. MICCAI

[51] G. Vivar et al., Simultaneous imputation and disease classification in incomplete medical datasets using Multigraph Geometric Matrix Completion (2020) arXiv:2005.06935.

[52] X. Li and J. Duncan, BrainGNN: Interpretable brain graph neural network for fMRI analysis (2020) bioRxiv:2020.05.16.100057

[53] X. Yu et al., ResGNet-C: A graph convolutional neural network for detection of COVID-19 (2020) Neurocomputing.

[54] P. Gainza et al., Deciphering interaction fingerprints from protein molecular surfaces using geometric deep learning (2020) Nature Methods 17(2):184–192.

[55] F. Sverrisson et al., Fast end-to-end learning on protein surfaces (2020) bioRxiv:2020.12.28.424589.

[56] A. Klimovskaia et al., Poincaré maps for analyzing complex hierarchies in single-cell data (2020) Nature Communications 11.

[57] J. Jumper et al., High accuracy protein structure prediction using deep learning (2020) a.k.a. AlphaFold 2.0 (paper not yet available).

[58] J. M. Stokes et al., A deep learning approach to antibiotic discovery (2020) Cell 180(4):688–702.

[59] D. Morselli Gysi et al., Network medicine framework for identifying drug repurposing opportunities for COVID-19 (2020) arXiv:2004.07229.