大数据学习总结(2021版)---Hadoop(入门)

这里写目录标题

- 第 1 章 Hadoop 概述

-

- 1.1 大数据部门业务流程分析、部门组织结构(重点)

- 1.2 Hadoop 组成(面试重点)

-

- 1.2.1 HDFS 架构:分布式文件系统

- 1.2.2 YARN:Hadoop 的资源管理器

- 1.2.3 MapReduce 架构:Map(并行处理数据) 和 Reduce(数据结果汇总)

- 1.3 大数据技术生态体系

- 1.4 推荐系统框架图

- 1.5 HDFS、YARN、MapReduce 三者关系

- 第 2 章 Hadoop 运行环境搭建(开发重点)

-

- 2.1 虚拟机环境准备

- 2.2 克隆虚拟机(以下以 hadoop102 举例说明)

- 2.3 在 hadoop102 安装 JDK

- 2.4 在 hadoop102 安装 Hadoop

- 2.5 Hadoop 目录结构

- 第 3 章 Hadoop 运行模式(完全分布式模式:开发重点)

-

- 3.1编写集群分发脚本 xsync

- 3.2 SSH 无密登录配置(配置好后,可直接“ssh 用户” 切换用户)

- 3.3 集群配置

-

- 3.3.1 集群部署规划

- 3.3.2 配置文件(core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml)

- 3.3.3 群起集群配置(一次启动多个节点)

- 3.4 集群基本测试

- 3.5 配置历史服务器

- 3.6 配置日志的聚集

- 第 4 章 集群启动/停止方式总结

-

- 4.1 各个模块分开启动/停止(配置 ssh 是前提)常用

- 4.2 各个服务组件逐一启动/停止

- 第 5 章 编写 Hadoop 集群常用脚本

-

- 5.1 Hadoop 集群启停脚本(包含 HDFS,Yarn,Historyserver):myhadoop.sh

- 5.2 查看三台服务器 Java 进程脚本:jpsall

- 5.3 集群时间同步

第 1 章 Hadoop 概述

- 是一个分布式系统基础架构

- 主要解决,海量数据的存储和海量数据的分析计算问题

- Hadoop 特点:大量、高速、多样、低价值密度

- Hadoop 优势(4 高):高可靠性、高扩展性、高效性、高容错性

1.1 大数据部门业务流程分析、部门组织结构(重点)

平台组:主要做的就是数据的采集。保证每一个框架的稳定运行,偏技术

数据仓库组(需求量大):

- 数据清洗:实习生常做

- HIVE工程师-数据分析、数据仓库建模:偏业务

数据挖掘组(发展好):尽量往这个方向发展

1.2 Hadoop 组成(面试重点)

1.2.1 HDFS 架构:分布式文件系统

NameNode(nn)、DataNode(dn)、SecondaryNameNode

1.2.2 YARN:Hadoop 的资源管理器

- ResourceManager(RM):整个集群资源(内存、CPU等)的老大

- NodeManager(NM):单个节点服务器资源老大(故每个节点都要部署)

- ApplicationMaster(AM):单个任务运行的老大

- Container:容器,相当一台独立的服务器,里面封装了任务运行所需要的资源,如内存、CPU、磁盘、网络等

1.2.3 MapReduce 架构:Map(并行处理数据) 和 Reduce(数据结果汇总)

MapReduce 将计算过程分为两个阶段:Map 和 Reduce

- Map 阶段并行处理输入数据

- Reduce 阶段对 Map 结果进行汇总

1.3 大数据技术生态体系

1.4 推荐系统框架图

1.5 HDFS、YARN、MapReduce 三者关系

第 2 章 Hadoop 运行环境搭建(开发重点)

2.1 虚拟机环境准备

1. 克隆虚拟机

2. 修改克隆虚拟机的静态IP

3. 修改主机名

4. 关闭防火墙

- 关闭:systemctl stop firewalld

- 开启:systemctl disable firewalld.service

5. 创建atguigu用户

6. 配置atguigu用户具有root权限,方便后期加 sudo 执行 root 权限的命令

[root@hadoop100 ~]# vim /etc/sudoers

修改/etc/sudoers 文件,在%wheel 这行下面添加一行,如下所示:

atguigu ALL=(ALL) NOPASSWD:ALL

7.在/opt目录下创建module、software文件夹,并修改所属用户和所属组

修改 module、software 文件夹的所有者和所属组均为 atguigu 用户

[root@hadoop100 ~]# chown atguigu:atguigu /opt/module

[root@hadoop100 ~]# chown atguigu:atguigu /opt/software

8.卸载虚拟机自带的 JDK

[root@hadoop100 ~]# rpm -qa | grep -i java | xargs -n1 rpm -e

--nodeps

9.重启虚拟机

2.2 克隆虚拟机(以下以 hadoop102 举例说明)

1.利用模板机 hadoop100,克隆三台虚拟机:hadoop102 hadoop103 hadoop104

2.修改克隆虚拟机的静态 IP

[root@hadoop100 ~]# vim /etc/sysconfig/network-scripts/ifcfg-ens33

注意:保证 Linux 系统 ifcfg-ens33 文件中 IP 地址、虚拟网络编辑器地址和 Windows 系 统 VM8 网络 IP 地址相同

3.修改克隆机主机名

[root@hadoop100 ~]# vim /etc/hostname

hadoop102

4.配置 Linux 克隆机主机名称映射 hosts 文件,打开/etc/hosts

[root@hadoop100 ~]# vim /etc/hosts

添加如下内容

192.168.10.100 hadoop100

192.168.10.101 hadoop101

192.168.10.102 hadoop102

192.168.10.103 hadoop103

192.168.10.104 hadoop104

5.重启克隆机 hadoop102

6.修改 windows 的主机映射文件(hosts 文件)

2.3 在 hadoop102 安装 JDK

1.卸载现有 JDK

注意:安装 JDK 前,一定确保提前删除了虚拟机自带的 JDK。

2.JDK 导入到 opt 目录下面的 software 文件夹下面

3.解压 JDK 到/opt/module 目录下

[atguigu@hadoop102 software]$ tar -zxvf jdk-8u212-linuxx64.tar.gz -C /opt/module/

4.配置 JDK 环境变量

新建/etc/profile.d/my_env.sh 文件

[atguigu@hadoop102 ~]$ sudo vim /etc/profile.d/my_env.sh

添加如下内容

#JAVA_HOME

export JAVA_HOME=/opt/module/jdk1.8.0_212

export PATH=$PATH:$JAVA_HOME/bin

注意:source 一下/etc/profile 文件,让新的环境变量 PATH 生效

[atguigu@hadoop102 ~]$ source /etc/profile

5.测试 JDK 是否安装成功,然后重启

2.4 在 hadoop102 安装 Hadoop

步骤:基本与安装jdk相同,配置环境变量时,在 my_env.sh 文件末尾添加如下内容

#HADOOP_HOME

export HADOOP_HOME=/opt/module/hadoop-3.1.3

export PATH=$PATH:$HADOOP_HOME/bin

export PATH=$PATH:$HADOOP_HOME/sbin

2.5 Hadoop 目录结构

[atguigu@hadoop102 hadoop-3.1.3]$ ll

总用量 52

drwxr-xr-x. 2 atguigu atguigu 4096 5 月 22 2017 bin

drwxr-xr-x. 3 atguigu atguigu 4096 5 月 22 2017 etc

drwxr-xr-x. 2 atguigu atguigu 4096 5 月 22 2017 include

drwxr-xr-x. 3 atguigu atguigu 4096 5 月 22 2017 lib

drwxr-xr-x. 2 atguigu atguigu 4096 5 月 22 2017 libexec

-rw-r--r--. 1 atguigu atguigu 15429 5 月 22 2017 LICENSE.txt

-rw-r--r--. 1 atguigu atguigu 101 5 月 22 2017 NOTICE.txt

-rw-r--r--. 1 atguigu atguigu 1366 5 月 22 2017 README.txt

drwxr-xr-x. 2 atguigu atguigu 4096 5 月 22 2017 sbin

drwxr-xr-x. 4 atguigu atguigu 4096 5 月 22 2017 share

第 3 章 Hadoop 运行模式(完全分布式模式:开发重点)

分析:

1)准备 3 台客户机(关闭防火墙、静态 IP、主机名称) 2)安装 JDK

3)配置环境变量

4)安装 Hadoop

5)配置环境变量

6)配置集群

7)单点启动

8)配置 ssh

9)群起并测试集群

3.1编写集群分发脚本 xsync

1.在/home/atguigu/bin 目录下创建 xsync 文件

[atguigu@hadoop102 opt]$ cd /home/atguigu

[atguigu@hadoop102 ~]$ mkdir bin

[atguigu@hadoop102 ~]$ cd bin

[atguigu@hadoop102 bin]$ vim xsync

#!/bin/bash

#1. 判断参数个数

if [ $# -lt 1 ]

then

echo Not Enough Arguement!

exit;

fi

#2. 遍历集群所有机器

for host in hadoop102 hadoop103 hadoop104

do

echo ==================== $host ====================

#3. 遍历所有目录,挨个发送

for file in $@

do

#4. 判断文件是否存在

if [ -e $file ]

then

#5. 获取父目录

pdir=$(cd -P $(dirname $file); pwd)

#6. 获取当前文件的名称

fname=$(basename $file)

ssh $host "mkdir -p $pdir"

rsync -av $pdir/$fname $host:$pdir

else

echo $file does not exists!

fi

done

done

2.修改脚本 xsync 具有执行权限

[atguigu@hadoop102 bin]$ chmod +x xsync

3.将脚本复制到/bin 中,以便全局调用

[atguigu@hadoop102 bin]$ sudo cp xsync /bin/

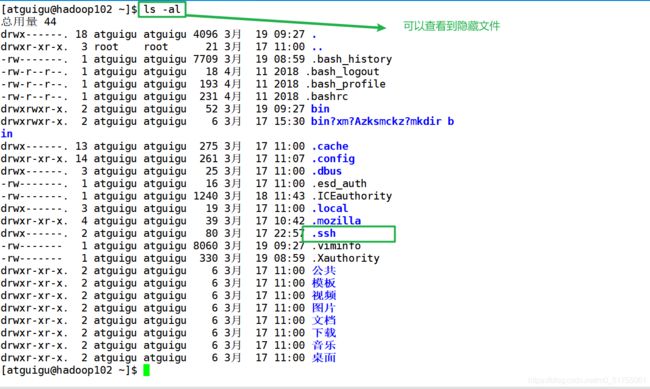

3.2 SSH 无密登录配置(配置好后,可直接“ssh 用户” 切换用户)

2.生成公钥和私钥

.ssh 文件夹下(~/.ssh)的文件功能解释

3.将公钥拷贝到要免密登录的目标机器上

[atguigu@hadoop102 .ssh]$ ssh-copy-id hadoop102

[atguigu@hadoop102 .ssh]$ ssh-copy-id hadoop103

[atguigu@hadoop102 .ssh]$ ssh-copy-id hadoop104

注意:每个节点都要这样操作!!!,并且用户之间不同,如需其他用户也要配置,采用相同的方法即可

3.3 集群配置

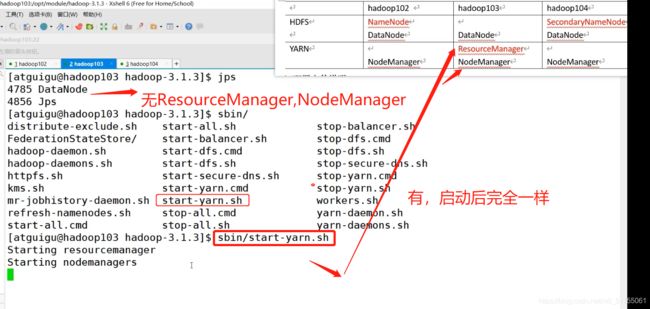

3.3.1 集群部署规划

3.3.2 配置文件(core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml)

- Hadoop 配置文件分两类:默认配置文件和自定义配置文件,只有用户想修改某一默认配置值时,才需要修改自定义配置文件,更改相应属性值

- 默认配置文件:文件存放在 Hadoop 的 jar 包中的位置

- 自定义配置文件:core-site.xml、hdfs-site.xml、yarn-site.xml、mapred-site.xml

- 四个配置文件存放在$HADOOP_HOME/etc/hadoop这个路径上,用户可以根据项目需求重新进行修改配置

在集群上分发配置好的 Hadoop 配置文件

3.3.3 群起集群配置(一次启动多个节点)

1.配置 workers

[atguigu@hadoop102 hadoop]$ vim /opt/module/hadoop-

3.1.3/etc/hadoop/workers

在该文件中增加如下内容:

hadoop102

hadoop103

hadoop104

记得同步所有节点!!

2.启动集群

- 集群是第一次启动,需在 hadoop102 节点格式化 NameNode

[atguigu@hadoop102 hadoop-3.1.3]$ hdfs namenode -format

- 启动 HDFS

[atguigu@hadoop102 hadoop-3.1.3]$ sbin/start-dfs.sh

- 在配置了 ResourceManager 的节点(hadoop103)启动 YARN

[atguigu@hadoop103 hadoop-3.1.3]$ sbin/start-yarn.sh

BUG1:在配置了 ResourceManager 的节点(hadoop103)启动 YARN,当Linux jdk版本大于或等于9时,会启动不了

BUG2:jdk版本问题,导致hdfsweb界面,Failed to retrieve data from /webhdfs/v1/?op=LISTSTATUS: Server Error

3: 集群基本测试

- 执行 wordcount 程序:

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /input /output/word1.txt

BUG1:出现bug Error: Could not find or load main class org.apache.hadoop.mapreduce.v2.app

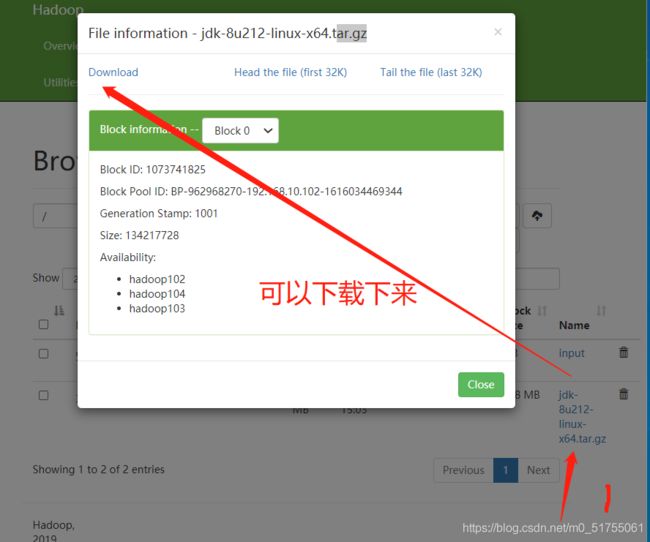

3.4 集群基本测试

执行 wordcount计算 程序:

hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-3.1.3.jar wordcount /input /output/word1.txt

BUG1:出现bug Error: Could not find or load main class org.apache.hadoop.mapreduce.v2.app.

查看 HDFS 文件存储路径:

[atguigu@hadoop102 subdir0]$ pwd

/opt/module/hadoop-3.1.3/data/dfs/data/current/BP-962968270-

192.168.10.102-1616034469344/current/finalized/subdir0/subdir0

3.5 配置历史服务器

1.配置yarn-site.xml

<!-- 历史服务器端地址 -->

<property>

<name>mapreduce.jobhistory.address</name>

<value>hadoop102:10020</value>

</property>

<!-- 历史服务器 web 端地址 -->

<property>

<name>mapreduce.jobhistory.webapp.address</name>

<value>hadoop102:19888</value>

</property>

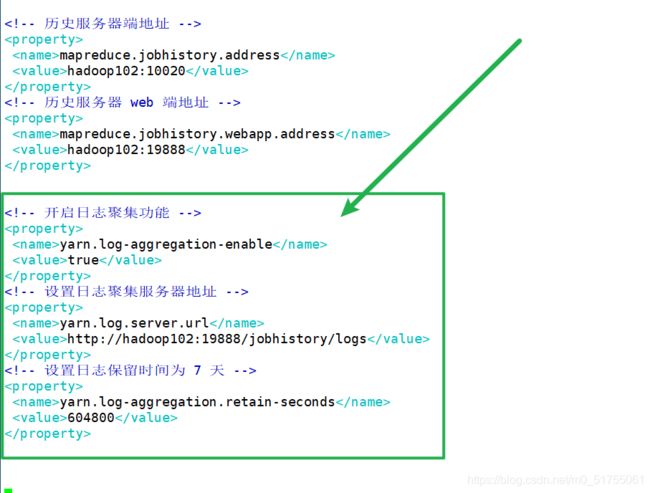

3.6 配置日志的聚集

注意:开启日志聚集功能,需要重新启动 NodeManager 、ResourceManager 和HistoryServer。

1.配置 yarn-site.xml

<!-- 开启日志聚集功能 -->

<property>

<name>yarn.log-aggregation-enable</name>

<value>true</value>

</property>

<!-- 设置日志聚集服务器地址 -->

<property>

<name>yarn.log.server.url</name>

<value>http://hadoop102:19888/jobhistory/logs</value>

</property>

<!-- 设置日志保留时间为 7 天 -->

<property>

<name>yarn.log-aggregation.retain-seconds</name>

<value>604800</value>

</property>

2.分发配置

3.关闭 NodeManager 、ResourceManager 和 HistoryServer

[atguigu@hadoop103 hadoop-3.1.3]$ sbin/stop-yarn.sh

[atguigu@hadoop103 hadoop-3.1.3]$ mapred --daemon stop historyserver

4.启动 NodeManager 、ResourceManage 和 HistoryServer

[atguigu@hadoop103 ~]$ sbin/start-yarn.sh

[atguigu@hadoop102 ~]$ mapred --daemon start historyserver

5.查看日志

第 4 章 集群启动/停止方式总结

4.1 各个模块分开启动/停止(配置 ssh 是前提)常用

(1)整体启动/停止 HDFS

start-dfs.sh/stop-dfs.sh

(2)整体启动/停止 YARN

start-yarn.sh/stop-yarn.sh

4.2 各个服务组件逐一启动/停止

(1)分别启动/停止 HDFS 组件

hdfs --daemon start/stop namenode/datanode/secondarynamenode

(2)启动/停止 YARN

yarn --daemon start/stop resourcemanager/nodemanager

第 5 章 编写 Hadoop 集群常用脚本

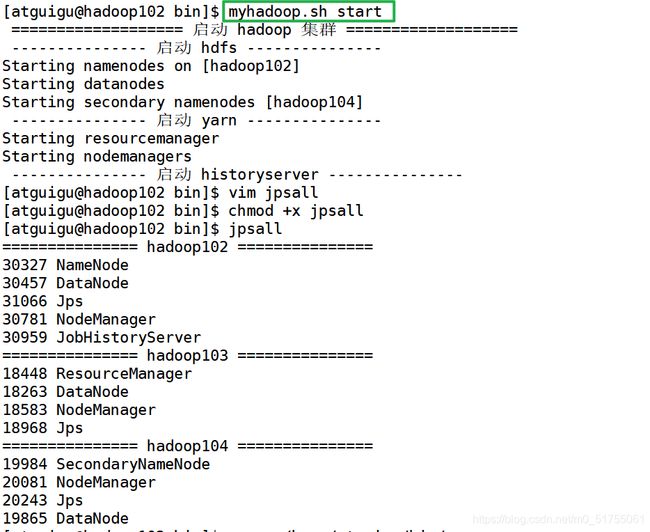

5.1 Hadoop 集群启停脚本(包含 HDFS,Yarn,Historyserver):myhadoop.sh

[atguigu@hadoop102 ~]$ cd /home/atguigu/bin

[atguigu@hadoop102 bin]$ vim myhadoop.sh

输入如下内容

#!/bin/bash

if [ $# -lt 1 ]

then

echo "No Args Input..."

exit ;

fi

case $1 in

"start")

echo " =================== 启动 hadoop 集群 ==================="

echo " --------------- 启动 hdfs ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/sbin/start-dfs.sh"

echo " --------------- 启动 yarn ---------------"

ssh hadoop103 "/opt/module/hadoop-3.1.3/sbin/start-yarn.sh"

echo " --------------- 启动 historyserver ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/bin/mapred --daemon start historyserver"

;;

"stop")

echo " =================== 关闭 hadoop 集群 ==================="

echo " --------------- 关闭 historyserver ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/bin/mapred --daemon stop historyserver"

echo " --------------- 关闭 yarn ---------------"

ssh hadoop103 "/opt/module/hadoop-3.1.3/sbin/stop-yarn.sh"

echo " --------------- 关闭 hdfs ---------------"

ssh hadoop102 "/opt/module/hadoop-3.1.3/sbin/stop-dfs.sh"

;;

*)

echo "Input Args Error..."

;;

esac

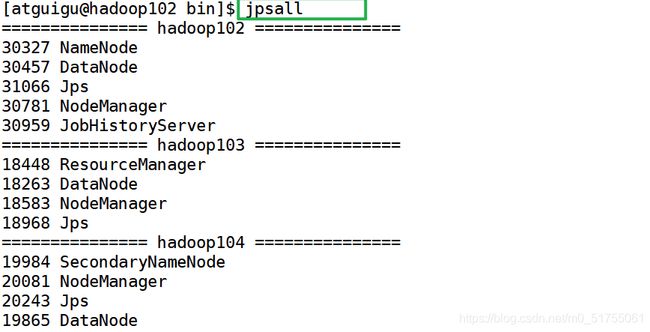

5.2 查看三台服务器 Java 进程脚本:jpsall

5.3 集群时间同步

- 如果服务器在公网环境(能连接外网),可以不采用集群时间同步,因为服务器会定期和公网时间进行校准;

- 如果服务器在内网环境,必须要配置集群时间同步,否则时间久了,会产生时间偏差,导致集群执行任务时间不同步。